本文从OSI模型中的每一层缓存介绍、常见开源中间件缓存举例、TCP/IP协议栈中的缓存机制、操作系统中的缓存、访问缓存数据的时间范围统计等方面对计算机中的缓存进行详细介绍。希望对您有所帮助!

一、OSI模型中的每一层缓存

1. 物理层(Physical Layer)

物理层主要涉及硬件传输介质和设备,所以缓存主要在硬件设备中实现。

- 硬盘缓存(Disk Cache):

- 硬盘驱动器内的缓存,用于加速读写操作。

- 例子:现代硬盘和SSD都有内部缓存(几百MB到几GB),用来存储最近访问的数据块。

- 开源项目:没有直接的开源项目,因为硬盘缓存是硬件内置的,但操作系统的磁盘I/O优化项目(如Linux内核中的I/O调度器)会涉及。

2. 数据链路层(Data Link Layer)

数据链路层负责数据帧的传输,缓存通常用于网络接口和交换机。

-

网卡缓存(NIC Buffer):

- 网卡上的缓存,用于临时存储传入和传出的数据帧。

- 例子:网卡上的缓冲区可以存储数据包,减少丢包率,提高网络传输效率。

- 开源项目:DPDK(Data Plane Development Kit)是一个用于高性能数据包处理的开源库,优化了网络I/O。

-

交换机缓存(Switch Buffer):

- 交换机内的缓存,用于暂时存储数据帧以防止拥塞。

- 例子:交换机使用缓冲区来存储数据帧,确保高流量时数据不丢失。

- 开源项目:Open vSwitch 是一个高性能、多层的虚拟交换机,支持多个虚拟机和容器的网络连接。

3. 网络层(Network Layer)

网络层处理数据包的传输和路由,缓存常用于路由器和防火墙。

-

路由器缓存(Router Cache):

- 路由器中的缓存,用于存储路由信息和数据包。

- 例子:路由器缓存常用的路由表项和最近转发的数据包,提高路由速度。

- 开源项目:BIRD 是一个开源的互联网路由守护进程,可以高效地管理路由表缓存。

-

NAT缓存(NAT Table Cache):

- 存储网络地址转换(NAT)表项,加速NAT处理。

- 例子:防火墙和路由器中用于存储NAT映射表项的缓存。

- 开源项目:pfSense 是一个基于FreeBSD的开源防火墙和路由器软件,包含NAT缓存机制。

4. 传输层(Transport Layer)

传输层负责数据段的传输,缓存主要用于TCP/UDP的传输。

-

TCP缓存(TCP Buffer):

- 用于存储传输中的TCP数据段。

- 例子:操作系统内核中的TCP缓冲区,用于存储传输中的数据段,确保数据的可靠传输。

- 开源项目:Linux内核的TCP/IP栈,管理和优化TCP缓冲区。

-

UDP缓存(UDP Buffer):

- 用于存储传输中的UDP数据段。

- 例子:操作系统内核中的UDP缓冲区,用于存储传输中的数据段。

- 开源项目:Netfilter 是Linux内核中的包过滤框架,管理和优化UDP缓冲区。

5. 会话层(Session Layer)

会话层负责会话的建立、管理和终止,缓存主要用于会话数据。

-

SSL/TLS会话缓存(SSL/TLS Session Cache):

- 用于缓存加密会话的信息。

- 例子:Web服务器缓存SSL/TLS会话,避免每次连接都重新进行完整的握手过程,提高安全连接的建立速度。

- 开源项目:OpenSSL 是一个开源的SSL/TLS协议库,提供会话缓存机制。

-

RPC缓存(RPC Cache):

- 缓存远程过程调用(RPC)的会话信息。

- 例子:分布式系统中缓存RPC会话信息以提高性能。

- 开源项目:gRPC 是一个高性能、通用的开源RPC框架,支持会话缓存。

6. 表示层(Presentation Layer)

表示层负责数据的编码、加密和压缩,缓存主要用于转换数据格式。

-

数据格式转换缓存(Data Format Conversion Cache):

- 用于缓存数据的编码和解码结果。

- 例子:视频流应用中缓存解码后的视频帧,以减少重复解码的开销。

- 开源项目:FFmpeg 是一个开源的多媒体框架,缓存和优化音视频编解码。

-

加密缓存(Encryption Cache):

- 缓存加密和解密操作的中间结果。

- 例子:加密服务缓存密钥和中间加密结果,提高加密速度。

- 开源项目:libsodium 是一个加密库,优化和缓存加密操作。

7. 应用层(Application Layer)

应用层涉及用户直接使用的应用程序,缓存种类丰富,包括网页缓存、数据库缓存等。

-

浏览器缓存(Browser Cache):

- 用于存储最近访问的网页内容。

- 例子:浏览器缓存HTML、CSS、JavaScript文件和图片,加速网页加载。

- 开源项目:Mozilla Firefox 和 Google Chrome 都是开源的浏览器项目,包含复杂的缓存机制。

-

数据库缓存(Database Cache):

- 用于缓存数据库查询结果和表数据。

- 例子:Redis用于缓存数据库查询结果,减少对主数据库的访问。

- 开源项目:Redis 是一个开源的内存数据结构存储,用于缓存和持久化数据。

-

Web服务器缓存(Web Server Cache):

- 用于缓存动态内容生成的结果。

- 例子:使用Varnish缓存Web服务器生成的动态页面,提高响应速度。

- 开源项目:Varnish 是一个开源的HTTP加速器,用于缓存和加速Web应用。

-

内容分发网络(CDN)缓存:

- 缓存静态和动态内容,加速全球访问。

- 开源项目:Apache Traffic Server 是一个开源的CDN和缓存代理服务器。

这些示例和开源项目展示了在OSI模型的不同层次中,缓存技术的应用及其重要性。每一层的缓存都有助于提高整体系统的性能和效率。

二、常见开源中间件缓存举例

常见的开源中间件中,缓存机制广泛应用于各种场景,以提高系统性能和效率。以下是一些常见的开源中间件及其缓存机制的举例说明:

1. Web服务器和反向代理

-

Nginx:

- 缓存机制:Nginx可以作为反向代理缓存,通过

proxy_cache指令缓存后端服务器的响应,以减少后端服务器负载并加快用户访问速度。 - 示例:配置Nginx缓存静态资源(如CSS、JS、图片)以及动态生成的内容(如API响应)。

- 开源项目:Nginx

- 缓存机制:Nginx可以作为反向代理缓存,通过

-

Apache HTTP Server:

- 缓存机制:Apache提供

mod_cache模块,用于缓存HTTP响应内容。 - 示例:使用

mod_cache缓存常访问的网页和API响应,减少后端负载。 - 开源项目:Apache HTTP Server

- 缓存机制:Apache提供

2. 应用服务器

-

Tomcat:

- 缓存机制:Tomcat的

Manager和PersistentManager组件提供会话缓存,可以将会话信息缓存到内存中,或者持久化到磁盘中。 - 示例:配置Tomcat使用内存会话管理器,以提高会话访问速度。

- 开源项目:Apache Tomcat

- 缓存机制:Tomcat的

-

Jetty:

- 缓存机制:Jetty提供了

SessionCache机制,用于缓存会话数据。 - 示例:使用Jetty的内存会话缓存,提高高并发应用的会话处理性能。

- 开源项目:Eclipse Jetty

- 缓存机制:Jetty提供了

3. 消息队列

-

RabbitMQ:

- 缓存机制:RabbitMQ内部使用内存缓存来暂存消息队列中的消息,以提高消息的传输和处理速度。

- 示例:配置RabbitMQ的内存参数以优化消息传输性能。

- 开源项目:RabbitMQ

-

Apache Kafka:

- 缓存机制:Kafka通过内存和磁盘缓存消息日志,以提供高吞吐量的消息处理能力。

- 示例:配置Kafka的内存和磁盘使用策略,以优化消息生产和消费性能。

- 开源项目:Apache Kafka

4. 数据库

-

MySQL:

- 缓存机制:MySQL提供查询缓存和InnoDB缓冲池,用于缓存查询结果和表数据。

- 示例:启用MySQL查询缓存以加速重复查询,配置InnoDB缓冲池以优化表数据访问。

- 开源项目:MySQL

-

PostgreSQL:

- 缓存机制:PostgreSQL使用共享缓冲区缓存表数据和索引,还可以通过

pg_prewarm扩展预加载数据到缓存中。 - 示例:调整PostgreSQL的共享缓冲区大小,以优化数据库性能。

- 开源项目:PostgreSQL

- 缓存机制:PostgreSQL使用共享缓冲区缓存表数据和索引,还可以通过

5. 分布式缓存

-

Redis:

- 缓存机制:Redis是一个高性能的内存数据结构存储,用于缓存和持久化数据。

- 示例:使用Redis缓存数据库查询结果、会话信息、配置数据等。

- 开源项目:Redis

-

Memcached:

- 缓存机制:Memcached是一个高性能的分布式内存对象缓存系统,用于缓存数据库查询结果等。

- 示例:使用Memcached缓存频繁访问的数据,减少数据库负载。

- 开源项目:Memcached

6. API网关

-

Kong:

- 缓存机制:Kong API网关提供

proxy-cache插件,用于缓存上游服务的响应。 - 示例:配置Kong缓存API响应数据,减少上游服务的压力。

- 开源项目:Kong

- 缓存机制:Kong API网关提供

-

Tyk:

- 缓存机制:Tyk API网关提供响应缓存功能,可以缓存上游服务的API响应。

- 示例:使用Tyk缓存静态和动态API响应数据,提升API性能。

- 开源项目:Tyk

7. CDN和内容加速

-

Varnish:

- 缓存机制:Varnish是一款高性能的HTTP加速器,专门用于缓存Web内容。

- 示例:配置Varnish缓存动态和静态Web内容,加速网站访问。

- 开源项目:Varnish Cache

-

Squid:

- 缓存机制:Squid是一个开源的代理服务器,提供强大的Web缓存功能。

- 示例:使用Squid缓存Web请求和响应,减少带宽使用并加快访问速度。

- 开源项目:Squid

这些开源中间件通过不同的缓存机制,显著提高了系统的性能和响应速度。每种中间件都有其特定的缓存实现方式,可以根据业务需求进行配置和优化。

三、TCP/IP协议栈中的缓存机制

TCP/IP协议栈中的缓存机制主要用于提高网络传输效率、减少延迟、优化资源利用。以下是TCP/IP协议栈中缓存的主要实现方式:

1. TCP缓存(TCP Buffer)

TCP协议使用发送和接收缓冲区来处理数据的传输。这些缓冲区用于临时存储数据,确保可靠传输。

-

发送缓冲区(Send Buffer):

- 作用:发送缓冲区用于存储应用程序写入但尚未发送到网络的数据。

- 实现:当应用程序调用

send()或write()时,数据首先被放入发送缓冲区,TCP协议栈会根据拥塞控制和流量控制机制将数据分段发送到网络。 - 优化:通过调整发送缓冲区的大小,可以优化高带宽延迟产品(BDP)场景下的性能。

-

接收缓冲区(Receive Buffer):

- 作用:接收缓冲区用于存储从网络接收到的数据,直到应用程序读取它。

- 实现:当数据包从网络到达时,TCP协议栈将其放入接收缓冲区,应用程序通过

recv()或read()读取数据。 - 优化:通过调整接收缓冲区的大小,可以减少因网络抖动引起的数据包丢失和重传。

2. TCP滑动窗口(Sliding Window)

TCP协议使用滑动窗口机制进行流量控制和拥塞控制,窗口的大小动态变化,决定了发送方在等待确认之前可以发送的数据量。

- 作用:滑动窗口机制确保发送方不会超过接收方的处理能力,防止网络拥塞。

- 实现:发送方根据接收方的窗口大小(由ACK包中的窗口字段确定)调整发送数据的数量。

- 优化:滑动窗口大小动态变化,通过算法(如拥塞避免和快速恢复)优化网络传输性能。

3. TCP重传缓存(Retransmission Buffer)

TCP协议提供可靠的数据传输,使用重传缓存来存储已经发送但未确认的数据,以便在需要时重传。

- 作用:重传缓存确保丢失的数据包可以重新发送,保证数据的可靠传输。

- 实现:当发送的数据包未在预定时间内收到确认(ACK),数据包会从重传缓存中取出并重传。

- 优化:重传缓存大小和重传超时机制通过TCP的拥塞控制算法(如Reno、Cubic等)进行优化。

4. 网络层缓存(Network Layer Caches)

在网络层,缓存机制用于加速数据包的转发和路由选择。

-

路由缓存(Routing Cache):

- 作用:存储最近使用的路由信息,加快路由查找过程。

- 实现:当数据包到达路由器时,路由器首先查找路由缓存,如果找到匹配条目,则快速转发数据包,否则进行路由查找。

- 优化:路由缓存的大小和替换策略通过算法(如LRU)优化。

-

ARP缓存(ARP Cache):

- 作用:存储IP地址到MAC地址的映射,加快局域网内的数据包传输。

- 实现:当主机需要发送数据包时,首先查找ARP缓存,如果找到目标IP地址的MAC地址映射,则直接发送,否则进行ARP请求。

- 优化:ARP缓存的条目老化时间和大小可以根据网络需求调整。

实现示例

在Linux中的TCP缓存实现

在Linux操作系统中,TCP缓存机制可以通过调整内核参数进行优化。这些参数可以在/proc/sys/net/ipv4目录下找到。

-

调整发送和接收缓冲区大小:

# 调整发送缓冲区大小 sysctl -w net.ipv4.tcp_wmem="4096 16384 4194304" # 调整接收缓冲区大小 sysctl -w net.ipv4.tcp_rmem="4096 87380 4194304" -

查看和设置TCP滑动窗口大小:

# 查看当前滑动窗口大小 sysctl net.ipv4.tcp_window_scaling # 启用或禁用滑动窗口 sysctl -w net.ipv4.tcp_window_scaling=1

这些调整有助于在不同的网络环境和应用场景中优化TCP/IP性能,提高数据传输效率和稳定性。

四、从操作系统的角度看缓存

以下是一些操作系统中缓存机制的具体实现示例,展示了如何在内存中实现这些缓存来提高性能。

1. 文件系统缓存

页面缓存(Page Cache)

-

实现示例:

-

Linux:在Linux系统中,文件的页面缓存由内核的

Page Cache机制实现。通过/proc文件系统,你可以查看和调节缓存相关的参数,例如:# 查看当前缓存使用情况 cat /proc/meminfo | grep -i cache # 查看文件系统的缓存大小 du -sh /var/cache -

代码示例(Linux内核代码中的

fs/buffer.c文件):Linux内核通过buffer_head结构体管理页面缓存。以下是一个简化的代码片段,展示如何缓存文件数据:struct buffer_head *bh; bh = sb_bread(inode->i_sb, block); if (bh) { // 数据已经在缓存中 memcpy(data, bh->b_data, size); brelse(bh); }

-

目录项缓存(Dentry Cache)

-

实现示例:

-

Linux:在Linux中,目录项缓存由

dentry结构体管理。可以通过/proc文件系统来查看目录项缓存:# 查看目录项缓存的统计信息 cat /proc/sys/fs/dentry-state -

代码示例(Linux内核中的

fs/dcache.c文件):以下是一个简化的代码片段,展示如何缓存目录项:struct dentry *dentry = d_lookup(parent, name); if (dentry) { // 目录项已经在缓存中 return dentry; }

-

文件属性缓存(Inode Cache)

-

实现示例:

-

Linux:在Linux中,inode缓存由

inode结构体管理。可以通过/proc文件系统来查看inode缓存:# 查看inode缓存的统计信息 cat /proc/sys/fs/inode-state -

代码示例(Linux内核中的

fs/inode.c文件):以下是一个简化的代码片段,展示如何缓存inode信息:struct inode *inode = iget(sb, ino); if (inode) { // Inode已经在缓存中 return inode; }

-

2. 虚拟内存管理

页表缓存(TLB)

-

实现示例:

-

Intel/AMD CPUs:现代CPU中有内置的TLB(Translation Lookaside Buffer)来缓存虚拟地址到物理地址的映射。操作系统和硬件共同管理TLB。

-

代码示例(操作系统代码中通常不直接操作TLB,但可以调整页表管理策略):

// 在Linux中,使用`mprotect`系统调用调整页表 mprotect(addr, len, PROT_READ | PROT_WRITE);

-

交换缓存(Swap Cache)

-

实现示例:

-

Linux:在Linux中,交换缓存机制用于缓存交换空间中的数据。可以通过

/proc文件系统查看交换空间的使用情况:# 查看交换空间的使用情况 cat /proc/swaps -

代码示例(Linux内核中的

mm/swap.c文件):以下是一个简化的代码片段,展示如何管理交换缓存:// 将页面从交换空间加载到内存 swapin(page);

-

3. 网络缓存

TCP缓存

-

实现示例:

-

Linux:在Linux中,TCP缓存由内核的网络栈管理。可以通过

/proc文件系统查看TCP缓存的设置:# 查看TCP缓冲区的大小 sysctl net.ipv4.tcp_rmem sysctl net.ipv4.tcp_wmem -

代码示例(Linux内核中的

net/ipv4/tcp.c文件):以下是一个简化的代码片段,展示如何处理TCP缓存:// 处理TCP发送缓冲区 skb_queue_tail(&sk->sk_send_queue, skb);

-

ARP缓存(Address Resolution Protocol Cache)

-

实现示例:

-

Linux:在Linux中,ARP缓存由内核的ARP表管理。可以通过

/proc文件系统查看ARP缓存:# 查看ARP缓存 cat /proc/net/arp -

代码示例(Linux内核中的

net/ipv4/arp.c文件):以下是一个简化的代码片段,展示如何管理ARP缓存:// 更新ARP缓存 arp_update(ip_addr, mac_addr);

-

4. 设备缓存

硬盘缓存(Disk Cache)

-

实现示例:

-

硬盘/SSD:硬盘和SSD通常有内置的缓存。设备的控制器管理这些缓存,操作系统通常无法直接控制硬盘缓存,但可以通过I/O调度器优化性能。

-

代码示例(通常在操作系统层面,使用I/O调度器来管理缓存):

# 调整I/O调度器的策略 echo 'deadline' > /sys/block/sda/queue/scheduler

-

5. 应用层缓存

内存缓存(Memory Cache)

-

实现示例:

-

Linux:可以使用

mmap系统调用在内存中映射文件,从而创建应用层缓存:// 在Linux中,使用mmap创建内存映射 void *addr = mmap(NULL, length, PROT_READ | PROT_WRITE, MAP_SHARED, fd, offset); -

代码示例:

// 示例代码:创建内存映射并读取数据 if (addr != MAP_FAILED) { char *data = (char *)addr; // 使用缓存数据 printf("Data: %s\n", data); munmap(addr, length); }

-

总结

以上示例展示了如何在操作系统中利用内存进行缓存,以提升性能。这些缓存机制涵盖了文件系统、虚拟内存、网络、设备以及应用层等多个方面,每种机制都有其特定的实现方式和优化策略。通过这些缓存,操作系统能够有效减少对慢速存储和设备的访问,提供更快的响应速度和更高的系统效率。

五、CPU中的缓存

CPU缓存属于物理层的一个重要组成部分。CPU缓存是为了提升CPU和内存之间的数据访问速度而设计的,它属于计算机体系结构层面的硬件缓存。在计算机系统中,CPU缓存通常分为多个层次,包括L1、L2和L3缓存,每一层缓存的设计目的是为了减少访问延迟并提高处理效率。

CPU缓存的层次结构

-

L1缓存(Level 1 Cache)

- 功能:L1缓存是最接近CPU核心的缓存,主要分为指令缓存(L1 I-cache)和数据缓存(L1 D-cache)。

- 特点:容量小(通常几KB到几十KB),访问速度最快,延迟最低。

- 实现:L1缓存集成在CPU核心中,直接连接到处理器执行单元。

-

L2缓存(Level 2 Cache)

- 功能:L2缓存用于缓存从L1缓存中未命中的数据,支持更大的缓存容量。

- 特点:容量大于L1缓存(通常几百KB到几MB),访问速度比L1缓存稍慢,但仍然比主内存快得多。

- 实现:L2缓存可以是每个CPU核心独立的,也可以是多个核心共享的,位于核心之外但仍在处理器芯片上。

-

L3缓存(Level 3 Cache)

- 功能:L3缓存用于缓存从L2缓存中未命中的数据,通常是多个CPU核心共享的。

- 特点:容量更大(通常几MB到几十MB),访问速度比L2缓存慢,但比主内存快。

- 实现:L3缓存通常位于CPU芯片上,所有核心共享一个L3缓存,减小核心之间的数据访问延迟。

CPU缓存的工作机制

-

缓存一致性:CPU缓存需要维护一致性,确保缓存中的数据与主内存中的数据一致。缓存一致性协议(如MESI协议)用于解决多个缓存和核心之间的数据一致性问题。

-

缓存替换策略:当缓存满了,缓存替换策略决定哪些缓存行需要被替换以存储新的数据。常见的策略包括最少使用(LRU)、最不常使用(LFU)等。

-

缓存预取:为了减少缓存未命中的情况,现代CPU使用缓存预取技术预测未来的数据需求,并预先将数据加载到缓存中。

物理层与CPU缓存的关系

-

物理层:物理层通常指的是计算机体系结构中的硬件层面,包括CPU、内存、存储设备和其他硬件组件。CPU缓存作为物理层的一部分,直接涉及硬件设计和实现,用于加速数据访问和提升系统性能。

-

缓存管理:虽然操作系统和软件可以影响缓存的管理策略(如缓存大小、替换策略等),但CPU缓存的实际存取和管理是由硬件(CPU和缓存控制器)在物理层面处理的。

总结

CPU缓存属于物理层的硬件缓存机制,是提高数据访问速度和系统性能的关键组件。它通过层次化设计(L1、L2、L3)和缓存一致性协议,在处理器和主内存之间提供了快速的数据通道。CPU缓存的设计和实现涉及到硬件层面的技术和策略,旨在减少数据访问延迟和提高处理效率。

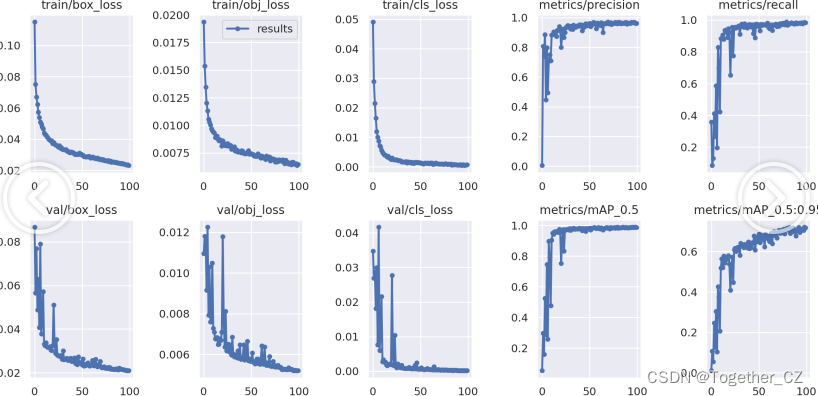

六、访问缓存数据的时间范围

缓存能显著提高数据访问速度,其提高的具体时间取决于多个因素,包括缓存的类型、设计、数据访问模式、硬件和软件环境等。以下是一些常见类型的缓存及其在相同条件下可能提高的数据访问时间的范围:

1. CPU缓存

L1缓存

- 访问时间:通常在1到3纳秒(ns)之间。

- 主内存访问时间:约100到200纳秒(ns)。

- 提升倍数:L1缓存能将访问速度提高约50到100倍。

示例:

- 如果从主内存读取数据需要150纳秒(ns),那么通过L1缓存读取数据的时间可能只需3纳秒(ns),从而提升速度约50倍。

L2缓存

- 访问时间:通常在3到10纳秒(ns)之间。

- 主内存访问时间:约100到200纳秒(ns)。

- 提升倍数:L2缓存能将访问速度提高约10到30倍。

示例:

- 如果从主内存读取数据需要150纳秒(ns),通过L2缓存读取数据的时间可能在10纳秒(ns)左右,提升速度约15倍。

L3缓存

- 访问时间:通常在10到30纳秒(ns)之间。

- 主内存访问时间:约100到200纳秒(ns)。

- 提升倍数:L3缓存能将访问速度提高约3到10倍。

示例:

- 如果从主内存读取数据需要150纳秒(ns),通过L3缓存读取数据的时间可能在20纳秒(ns)左右,提升速度约7倍。

2. 硬盘缓存

硬盘缓存

- 访问时间:通常在几微秒(µs)到几十微秒(µs)之间。

- 硬盘访问时间:约5到15毫秒(ms)。

- 提升倍数:硬盘缓存能将访问速度提高约1000到3000倍。

示例:

- 如果硬盘读取数据需要10毫秒(ms),通过硬盘缓存读取数据的时间可能在10微秒(µs)左右,提升速度约1000倍。

SSD缓存

- 访问时间:SSD内存缓存的访问时间通常在几十微秒(µs)之间。

- SSD主存储访问时间:约100到200微秒(µs)。

- 提升倍数:SSD缓存能将访问速度提高约2到5倍。

示例:

- 如果SSD主存储读取数据需要150微秒(µs),通过SSD缓存读取数据的时间可能在30微秒(µs)左右,提升速度约5倍。

3. 文件系统缓存

页面缓存

- 访问时间:通常在几纳秒(ns)到几微秒(µs)之间。

- 磁盘访问时间:约5到15毫秒(ms)。

- 提升倍数:页面缓存能将访问速度提高约1000到10000倍。

示例:

- 如果从磁盘读取数据需要10毫秒(ms),通过页面缓存读取数据的时间可能在10微秒(µs)左右,提升速度约1000倍。

4. 网络缓存

CDN(内容分发网络)缓存

- 访问时间:通常在几毫秒(ms)之间。

- 源服务器访问时间:约几十到几百毫秒(ms)。

- 提升倍数:CDN缓存能将访问速度提高约10到100倍。

示例:

- 如果从源服务器获取数据需要300毫秒(ms),通过CDN缓存获取数据的时间可能在10毫秒(ms)左右,提升速度约30倍。

5. 应用层缓存

内存缓存(如Redis、Memcached)

- 访问时间:通常在几微秒(µs)到几十微秒(µs)之间。

- 数据库访问时间:通常在几毫秒(ms)到几十毫秒(ms)之间。

- 提升倍数:内存缓存能将访问速度提高约10到100倍。

示例:

- 如果从数据库获取数据需要50毫秒(ms),通过内存缓存获取数据的时间可能在1毫秒(ms)左右,提升速度约50倍。

总结

缓存技术在不同场景下能显著提升数据访问速度。具体提升倍数取决于缓存类型和系统设计:

- CPU缓存:提升3-100倍,根据缓存级别不同。

- 硬盘缓存:提升1000-3000倍,相比于传统硬盘。

- SSD缓存:提升2-5倍,相比于SSD的主存储。

- 文件系统缓存:提升1000-10000倍,相比于磁盘访问。

- 网络缓存:提升10-100倍,相比于源服务器。

- 应用层缓存:提升10-100倍,相比于数据库或远程服务。

这些提升反映了缓存通过将数据存储在更快的介质中,减少了访问延迟并提升了系统的整体性能。

完。

希望对您有所帮助!关注锅总,及时获得更多花里胡哨的运维实用操作!

七、一个秘密

锅总个人博客

https://gentlewok.blog.csdn.net/

锅总微信公众号

![[激光原理与应用-98]:南京科耐激光-激光焊接-焊中检测-智能制程监测系统IPM介绍 - 2 - 什么是激光器焊接](https://img-blog.csdnimg.cn/direct/cb6a02565e544d97a705d3a6dd7ddcc9.png)

![[C++][CMake][CMake基础]详细讲解](https://img-blog.csdnimg.cn/direct/8beb5fc35be346f5ae7b25a4c4eb4165.png)