引言

2022年底以来,以ChatGPT为代表的大模型飞速发展,正在成为#驱动新质生产力发展#的新动能、人类探索未知的新工具. 在显著提升人工智能(artificial intelligence, AI)模型通用理解和生成能力的同时,也带来了前所未有的安全风险.

大模型的能力与风险

生成式大模型因其强大的智能能力和巨大的应用潜力吸引了众多研究者和企业的关注. 从智能能力的角度来看,研究人员观测到:当训练数据和参数规模持续增长,超过某个阈值的时候,模型能力会突然跃升,出现“智能涌现”的拐点. OpenAI的技术报告显示, GPT-4在众多专业和学术考试中均展现出了人类级别的表现. 2024年Sora的发布,更将AI的多媒体生成能力推向了新的高度. 《自然》(Nature)的一则News Feature文章援引AI21 Lab设计的150万人的对抗性图灵测试结果,证明用户已无法区分与之对话的是人类还是AI,并因此主张大模型在形式上已通过了图灵测试. 尽管当前的大模型还没有实现通用人工智能(artificial general intelligence, AGI),且关于图灵测试是否合理以及AGI的最终实现方案和具体时间点尚有许多争议,各界却基本认同,人类正在沿着正确的方向推进AGI的发展.

从应用角度看,大模型正在快速成为类似于数字化时代“数据库”这样的智能化时代的通用底座. 一方面,各类定制化的GPTs蓬勃发展,新一代智能应用(AI APP)方兴未艾,大模型赋能的智能体(agent) 的应用范围不断扩大,多智能体协同的研究百花齐放,对数字网络空间的应用形态及其演变都将产生极为深远的影响;另一方面,大模型的应用边界也在快速从数字空间向物理空间扩展,具备了智能化的外部工具使用、自动控制能力,并通过与机器人的结合,展现了物理世界的具身智能潜力.

大模型面对的安全风险前所未有,模型的通用性、潜在的主体地位以及应用的深度与广度,也都将进一步放大其危害程度. 包括两位图灵奖得主Geoffrey Hinton、Yoshua Bengio和DeepMind的CEO Demis Hassabis、OpenAI的CEO Sam Altman在内的产学两界领军人物联名发出的AI风险声明中,更将AI可能带来的“毁灭性”的风险,上升到了与流行病以及核战争相提并论的高度. 与之相呼应的是,生物安全专家警告说:聊天机器人可能会使恐怖分子更容易发动像1918年爆发的流感那样致命的流行病. 在2023年底《自然》杂志预测的2024年的重大科学事件中,GPT-5的发布以及联合国人工智能高级别咨询机构将发布的AI监管相关报告位列其中,反映了全球对协调AI发展与安全的重大关切. 毫无疑问,促使大模型遵循人类价值观、服从人类意图、规避各类风险,并保障数字和物理空间的应用安全,实现有用性(helpful) 、 无害性(harmless) 和诚实性(honest) ,即3H多目标的平衡,已经成为亟待解决的世界难题之一.

3H目标#:有用性(helpful)、无害性(harmless)、诚实性(honest)

安全风险成因

大模型特有的预训练、微调、上下文、提示、思维链(chain of thought, CoT)等新的学习范式,使其安全具有了与传统AI安全不同的许多新特点,面临诸多新挑战. 大模型安全风险的成因存在很多的共性,既可以是来自各类训练数据的缺陷或技术的局限性等模型内因,也可以是利用新型学习范式的恶意使用或蓄意攻击等外因. 从大模型的生命周期着眼,其成因可以被大体分解为数据、预训练、人类价值观对齐及推理4个阶段.

大模型四个阶段:数据准备、预训练、人类价值观对齐(微调)、推理

- 数据准备阶段成因

生成式模型需要大规模的训练数据,数据的规模同模型能力息息相关. 新的大模型如GPT 4、LLaMA 3等训练数据规模动辄十几万亿词元(token),内容包括维基百科、电子书籍、网络数据等. 多源数据中常常会包含与人类价值观不一致或彼此冲突的内容,侦探小说、法律文件等电子书籍中也会存在无法合理去除的有害内容,或去除后反而会严重影响模型“辨别善恶”的能力. 网络数据还会存在明显的数据偏执、事实偏颇等问题,也会有大量难以检测辨别的AI生成的、未经核实的内容,导致模型学习到的知识本身产生了错误,容易生成价值观扭曲、事实歪曲或未经核实的内容. 这一由数据质量带来的问题在各类需要数据的微调、强化学习等环节普遍存在,也可能进一步加剧错误的传播,误导模型的发展方向.

- 预训练模型阶段成因

当前大语言模型主要基于Google提出的Transformer模型,采用自监督的方式进行训练. 训练时根据已有前文,预测下一个词,本质上仍然遵循马尔可夫假设. 这使得大模型学习到的知识具有显著的概率特性,生成内容具有不确定性、不可控性等特征,且缺乏可解释性. 研究人员发现,在部分情况下模型学习到的不是语料中事实知识,而是一种语言模型目的导向的、根据标签类别的差异和样本的分布顺序得到的语言生成能力,增加了大模型出现幻觉现象的风险. 类似地,从原理上也就无法避免产生各类有害、不实信息. 训练过程的目标与后续对齐过程目标的冲突,也容易导致模型过于强调遵循有用性而讨好奉承(sycophancy)用户,忽略了输出内容的安全性和真实性.

- 模型指令遵循和价值观对齐阶段成因

人类价值观对齐方法(如InstructGPT),致力于引导大模型与人类价值观保持一致. 现有方法面临高质量对齐标注数据稀缺,强化学习等方法存在目标错误泛化(goal misgeneralization)和奖励错误规范(reward misspecification)问题,以及3H多目标冲突带来的“对齐税”等挑战性难题,且不具备在动态环境中的持续化对齐能力. 加州伯克利分校的研究认为,现有对齐安全方法容易失效的原因可以归结为,训练与对齐的竞争目标(competing objective)和泛化能力失配(mismatched generalization). 前者易导致模型在多个目标选择之间“错误百出”;而后者则会由于对齐的泛化能力远低于训练,留出巨大的“攻击空间”. 回到数据方面,尽管红队测试方法(red teaming)可以为对齐提供高质量的潜在漏洞或者问题数据,但它仍存在着自动化水平较低、风险覆盖面窄等局限性,无法满足不断出现、内容与形式不断变化的有害不实信息的常态化治理要求.

- 大模型推理阶段成因

大模型在推理时依赖注意力机制计算概率以逐词生成,虽然可通过控制温度等参数提高生成的确定性,但在没有外部干预的情况下,仍难以依赖自身价值观对齐的力量,完全做到“趋利避害”. 由于大模型学习到的知识在参数中的存储和调用形式未知,在推理阶段也可能存在无法有效划定知识边界和综合不同来源的知识的风险,也增加了发生有害、不实信息和幻觉的概率. 在模型外部,一方面,模型推理阶段常用的外设护栏技术依赖于有害、不实信息的自动化识别,而现有的分类模型会面临少样本、零样本问题,泛化性和鲁棒性弱,且在形式多样的有害不实信息多分类任务上的迁移能力差,发现力严重不足,漏检和错误拒答频发;另一方面,与传统AI模型相比,大模型在推理阶段具有强大的上下文学习、提示学习、思维链学习等高级学习能力,同时也带来了一系列新的安全风险. 恶意用户可以利用具有欺骗性的上下文、攻击性提示或者恶意CoT,利用任务微调、提示微调、指令微调等手段提高攻击能力,乃至蓄意利用大模型对多模态或加密内容的高级理解能力伪装非法查询,探测模型防御“漏洞”,诱导模型产生误判.

安全研究进展

当前大模型安全研究尚处于早期发展阶段,涵盖众多的研究方向,且主要聚焦于其特有的安全挑战,而对后门攻击等传统AI安全问题则关注较少. 这些研究领域包括但不限于生成内容检测、模型水印、红队测试、对齐、越狱攻击、有害识别、隐私保护以及安全理论探析等,且目前尚未形成一个得到广泛认可的分类体系. 需要强调的是,受篇幅所限,本节的目的在于提供一个相关方向的宏观分类简介,而不是详尽的综述. 为了简化问题、便于理解和实践,我们从安全领域的角度将之分为安全测评、安全攻击、风险识别、安全防护4个部分.

- 安全测评

大模型安全测评的目标主要包括测评大模型预防不良输出、确保数据隐私、消除偏见和保障公平性、防范对抗性攻击等方面的能力.

研究者们围绕不同的测试重点开展了众多的安全测评基准工作,如以综合测评为主,但关注有毒和虚假信息等的HELM、 综合评估攻击冒犯(offensiveness)、偏见歧视(unfairness and bias)等7个安全维度的SafetyBench等测评工作.

- 安全攻击

大模型的安全攻击主要可以被划分为“善意”的红队测试和恶意攻击两种常见的形态.

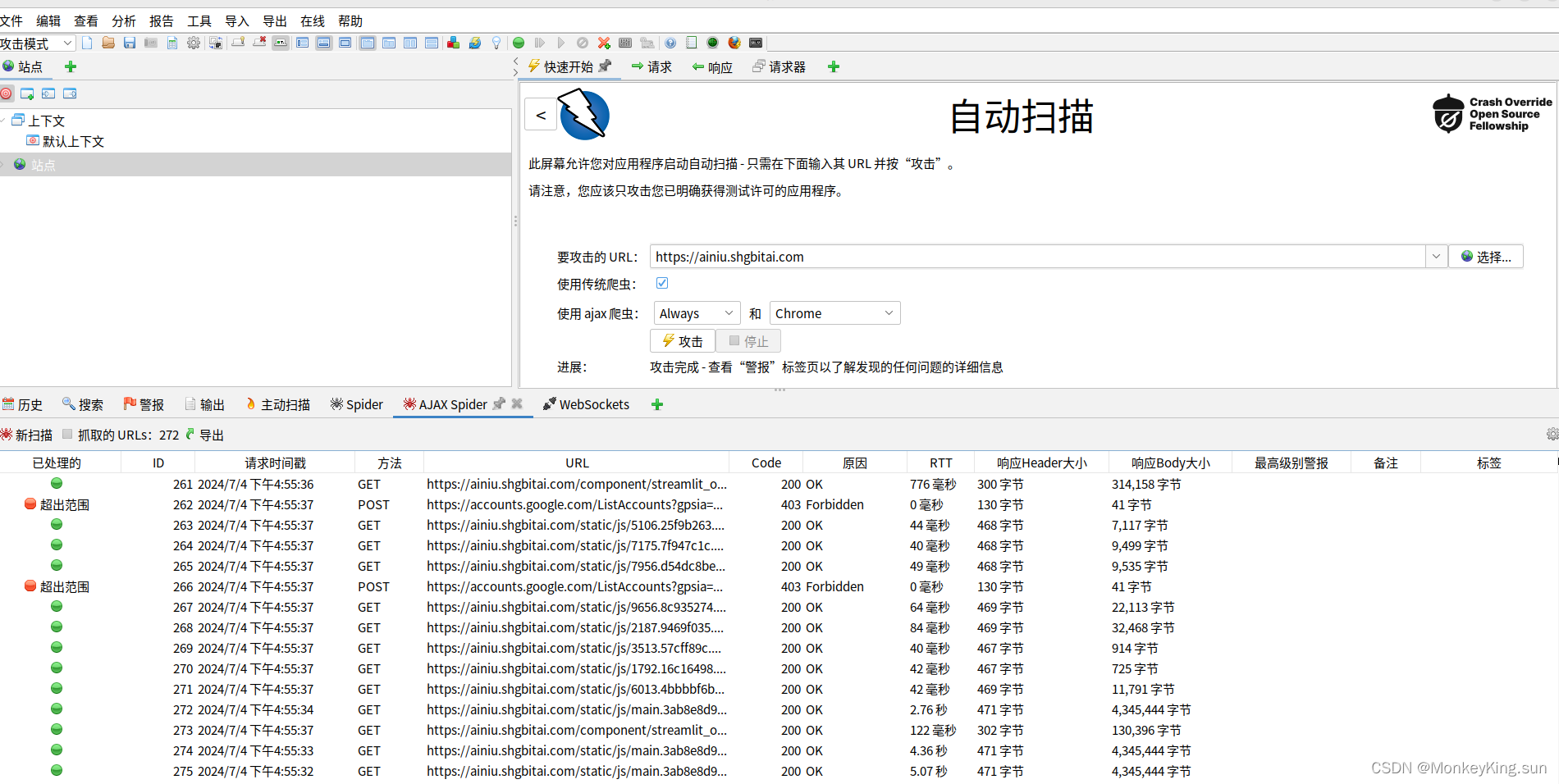

红队测试更多服务于模型风险的主动测试和潜在漏洞发现,常常被应用于风险的主动测评和安全对齐. 其中,手工红队主要通过组建专门的红队小组与待测试的大模型进行对抗性交互的方式来发现模型的安全风险,需要大量的人力进行长周期的测试以保证测试的全面性和充分性. 现有的自动化红队测试方法则是利用红队语言模型替代人工红队小组对语言模型进行测试. 测试者编写指令要求红队语言模型产生测试问题,然后将测试问题输入给待测模型并收集其回复,再使用训练好的分类器对待测模型的回复进行风险评估. 此类方法通过反复地自举攻击成功的样例作为提示或训练样本,很容易使测试样例的类别趋于单一化,且分类器的局限性也会导致相当比例的假阳性和假阴性样本,这也引出了对自动化风险识别能力的需求. 另外,现有的自动化红队测试方法通常仅进行单轮的测试,而对于需要多轮交互才能成功诱导的场景,则可能存在测试不充分的问题.

恶意攻击主要包括越狱攻击和提示注入攻击. 越狱攻击利用大模型漏洞,误导模型输出有害或不实内容;提示注入攻击则操纵模型输入,诱导模型接受攻击者控制的指令,以产生欺骗性输出. 尽管二者之间有一定交集,提示也是越狱攻击的一种重要手段,但相比之下,越狱攻击更强调对大模型安全机制本身的攻击,而提示注入攻击则主要攻击大模型的提示环节.

- 风险识别

大模型需要对AI生成内容的安全风险自动化识别,其自身也可以被用于提高模型和用户生成内容的有害内容发现水平. 它能够服务于数据准备阶段的有害信息过滤、推理阶段的用户问题和模型生成回复的有害性判别,也是安全测评、红队测试中自动化有害判别的主要依据.

- 安全防护

常见的安全防护方法,包括关注模型内生的安全对齐方法、关注外部安全的护栏方法等.

安全对齐的方法:监督微调(SFT)、基于人类反馈的强化学习(RLHF)

安全对齐主要是在模型微调训练过程中引导其向无害性发展,去除模型本身有害性和幻觉的方法. 安全对齐是近期的热点研究方向,所使用的方法除了监督微调(supervised fine-tuning, SFT) 和基于人类反馈的强化学习(reinforcement learning from human feedback, RLHF) 外,还包括AI宪法、面向过程的细粒度对齐、直接偏好优化(direct preference optimization, DPO)、即插即用对齐等.

关注外部安全的护栏方法则主要是通过分类判别模型对大模型的输入(用户请求)和输出进行不良和不实内容的识别和过滤,使得模型免受来自恶意用户的提示攻击,并对不良或不实内容进行矫正.

总的来看,安全测评、安全攻击、风险识别、安全防护这4个部分在技术上既存在交叉关系却又各有侧重.

- 安全测评常需要采用红队测试和越狱攻击的方法来探测模型的安全漏洞,也需要风险识别技术作为自动化的判别器;

- 红队测试也常会将越狱攻击作为攻击向量,以提升漏洞的发现能力,并作为安全对齐的前序步骤,为安全对齐提供关键数据样本;

- 即插即用方式的对齐也算是推理时干预的一种方法. 在实践中安全对齐、检索增强、知识编辑和推理时干预也常在不同阶段混合使用,以从不同侧面更好地为大模型安全提供保障.

总结

大模型安全重要性不言而喻,大模型能力愈强,风险愈大. 大模型安全不再如传统安全一般,只是计算机应用的伴生物,而是需要优先构筑的核心底座. 没有这个安全底座,应用就容易变成在风险中飘摇的无本之木,变成极易坍塌的空中楼阁,大模型自身就难以实现可持续的发展.

图灵奖得主、深度学习之父Hinton认为,低智力物种很难真正控制更高级的智慧物种. 这一“Hinton之问”算是对大模型安全的灵魂诘问,亟待人类的应答. 一方面,大模型安全技术研究日新月异、成果显著,头部企业如OpenAI等也组建Superalignment ,宣布投入20%的算力,以控制、引导超级智能对齐;另一方面,我们对大模型“智能涌现”的原理还所知甚少,对上下文学习、提示学习、思维链等能力的内在机理仍严重缺乏认知. 一些研究工作也证明AI的安全性无法完全保障、对任意一个对齐模型总存在一定长度的提示可以将之攻破等,这些都极大地制约了我们从原理上认识和防御大模型的安全风险. 在追求“安全大模型”的道路上,我们不仅要突破众多的技术瓶颈,还必须优先扫除一系列的理论障碍,挑战殊为艰巨.

放眼未来,在AI“主体化”进程持续加速的背景下,我们可能将面临一个“人机共生”的信息物理社会,这一社会的和谐发展,将不仅需要人类共同体内部达成一致,还将可能需要在人与AI之间、AI与AI之间实现双向的价值观对齐,与之对应的社会伦理、法律体系等也都将面对翻天覆地的革命性变化. 在这样的背景下,更需要群策群力,将“亦正亦邪”的大模型关到人类价值观的“笼子”里. 唯盼此专题能抛砖引玉,引发产学两界更多专家学者的共鸣,共同促进该领域的研究发展,助力构筑人类安全、可持续的智能未来.

大模型广告2

6/100

保存草稿

发布文章

AAI666666

未选择任何文件

如何系统的去学习大模型LLM ?

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的 AI大模型资料 包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

所有资料 ⚡️ ,朋友们如果有需要全套 《LLM大模型入门+进阶学习资源包》,扫码获取~

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

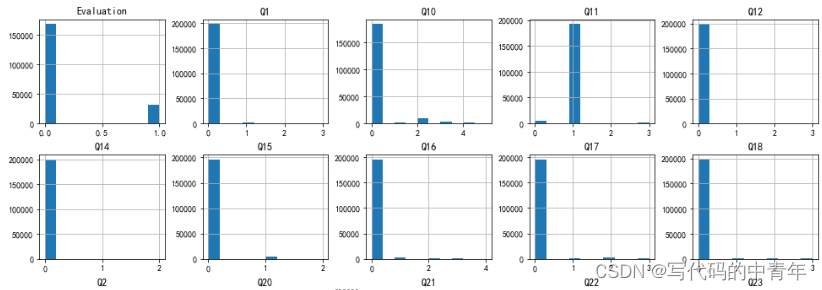

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

阶段1:AI大模型时代的基础理解

- 目标:了解AI大模型的基本概念、发展历程和核心原理。

- 内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践 - L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

- 目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

- 内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例 - L2.2 Prompt框架

- L2.2.1 什么是Prompt

- L2.2.2 Prompt框架应用现状

- L2.2.3 基于GPTAS的Prompt框架

- L2.2.4 Prompt框架与Thought

- L2.2.5 Prompt框架与提示词 - L2.3 流水线工程

- L2.3.1 流水线工程的概念

- L2.3.2 流水线工程的优点

- L2.3.3 流水线工程的应用 - L2.4 总结与展望

- L2.1 API接口

阶段3:AI大模型应用架构实践

- 目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

- 内容:

- L3.1 Agent模型框架

- L3.1.1 Agent模型框架的设计理念

- L3.1.2 Agent模型框架的核心组件

- L3.1.3 Agent模型框架的实现细节 - L3.2 MetaGPT

- L3.2.1 MetaGPT的基本概念

- L3.2.2 MetaGPT的工作原理

- L3.2.3 MetaGPT的应用场景 - L3.3 ChatGLM

- L3.3.1 ChatGLM的特点

- L3.3.2 ChatGLM的开发环境

- L3.3.3 ChatGLM的使用示例 - L3.4 LLAMA

- L3.4.1 LLAMA的特点

- L3.4.2 LLAMA的开发环境

- L3.4.3 LLAMA的使用示例 - L3.5 其他大模型介绍

- L3.1 Agent模型框架

阶段4:AI大模型私有化部署

- 目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

- 内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

学习计划:

- 阶段1:1-2个月,建立AI大模型的基础知识体系。

- 阶段2:2-3个月,专注于API应用开发能力的提升。

- 阶段3:3-4个月,深入实践AI大模型的应用架构和私有化部署。

- 阶段4:4-5个月,专注于高级模型的应用和部署。

这份完整版的所有 ⚡️ 大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

全套 《LLM大模型入门+进阶学习资源包》↓↓↓ 获取~

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

如何系统的去学习大模型LLM ?

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的 AI大模型资料 包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

所有资料 ⚡️ ,朋友们如果有需要全套 《LLM大模型入门+进阶学习资源包》,扫码获取~

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

img

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

img

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

img

在这里插入图片描述

四、AI大模型商业化落地方案

img

阶段1:AI大模型时代的基础理解

目标:了解AI大模型的基本概念、发展历程和核心原理。

内容:

L1.1 人工智能简述与大模型起源

L1.2 大模型与通用人工智能

L1.3 GPT模型的发展历程

L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

内容:

L2.1 API接口 - L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

L2.2 Prompt框架 - L2.2.1 什么是Prompt

- L2.2.2 Prompt框架应用现状

- L2.2.3 基于GPTAS的Prompt框架

- L2.2.4 Prompt框架与Thought

- L2.2.5 Prompt框架与提示词

L2.3 流水线工程 - L2.3.1 流水线工程的概念

- L2.3.2 流水线工程的优点

- L2.3.3 流水线工程的应用

L2.4 总结与展望

阶段3:AI大模型应用架构实践

目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

内容:

L3.1 Agent模型框架 - L3.1.1 Agent模型框架的设计理念

- L3.1.2 Agent模型框架的核心组件

- L3.1.3 Agent模型框架的实现细节

L3.2 MetaGPT - L3.2.1 MetaGPT的基本概念

- L3.2.2 MetaGPT的工作原理

- L3.2.3 MetaGPT的应用场景

L3.3 ChatGLM - L3.3.1 ChatGLM的特点

- L3.3.2 ChatGLM的开发环境

- L3.3.3 ChatGLM的使用示例

L3.4 LLAMA - L3.4.1 LLAMA的特点

- L3.4.2 LLAMA的开发环境

- L3.4.3 LLAMA的使用示例

L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

内容:

L4.1 模型私有化部署概述

L4.2 模型私有化部署的关键技术

L4.3 模型私有化部署的实施步骤

L4.4 模型私有化部署的应用场景

学习计划:

阶段1:1-2个月,建立AI大模型的基础知识体系。

阶段2:2-3个月,专注于API应用开发能力的提升。

阶段3:3-4个月,深入实践AI大模型的应用架构和私有化部署。

阶段4:4-5个月,专注于高级模型的应用和部署。

这份完整版的所有 ⚡️ 大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

全套 《LLM大模型入门+进阶学习资源包》↓↓↓ 获取~

👉CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)👈

Markdown 已选中 9 字数 1 行数 当前行 33, 当前列 11HTML 1745 字数 80 段落

发布博文获得大额流量券

已成功保存至草稿箱

![plugin:vite:import-analysis]No known conditions for“./lib/locale/lang/zh-cn“](https://img-blog.csdnimg.cn/direct/f8bc1bdd95d04863b21097178a021ece.png)

![软考-系统架构设计师[九年]上岸感想](https://img-blog.csdnimg.cn/direct/84565ecf4e304c3cb0784a22607890f1.png)