在数字化时代,数据提取作为连接原始数据与知识发现的桥梁,其重要性不言而喻。它不仅是数据分析和数据治理的基石,更是企业决策和业务优化的关键。以下是数据提取奥秘的详细解析:

一、数据提取的定义与意义

定义:数据提取,又称数据抓取或数据收集,是指从各种数据源中自动或半自动地收集、整合和转换数据的过程。它是现代数据分析的第一步,旨在从海量数据中捕获、转换和加载所需信息。

意义:通过数据提取,企业可以迅速定位关键信息,为决策提供有力支持。同时,它也是数据治理的重要组成部分,有助于确保数据的准确性、完整性和一致性。

二、数据提取的流程

-

数据定位:

-

确定目标数据源:这可以是数据库、API、网页、社交媒体等多种类型的数据源。

-

了解数据源的结构和特点,以确定数据提取的方式和策略。

-

-

数据解析:

-

使用相应的解析技术来提取数据,如HTML解析、XML解析、JSON解析等,具体取决于数据源的格式和结构。

-

-

数据清洗:

-

提取出来的数据往往包含噪声、重复或无关信息,需要进行清洗和整理。

-

清洗过程包括去除空值、重复值、无效值等,以及将数据进行格式化、标准化等处理。

-

-

数据存储:

-

将清洗后的数据存储到目标位置,以便后续的分析和应用。存储位置可以是本地数据库、云存储或其他数据存储系统。

-

三、数据提取的技术与工具

-

网络爬虫:

-

网络爬虫是一种用于从互联网上自动抓取数据的程序。

-

它可以根据用户设定的规则,自动访问网页、提取数据并保存到本地。

-

常用的网络爬虫工具有Scrapy、BeautifulSoup等。

-

-

API接口:

-

API(应用程序接口)是一种允许不同软件应用程序相互通信的接口。

-

通过调用API接口,可以直接从数据源获取数据,无需解析网页或文件。

-

许多网站和平台都提供了API接口供开发者使用。

-

-

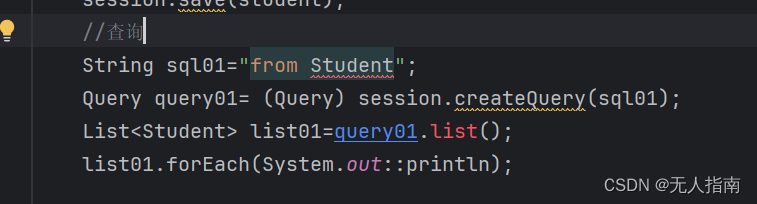

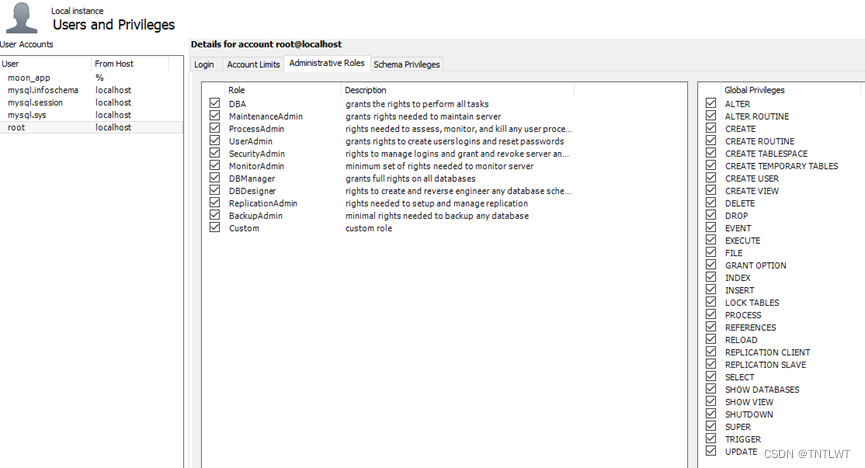

数据库管理工具:

-

对于存储在数据库中的数据,可以使用数据库管理工具进行提取。

-

这些工具通常提供了图形化界面和SQL查询功能,方便用户快速定位和提取数据。

-

-

数据集成平台:

-

数据集成平台是一种将多个数据源整合到一起的工具。

-

它可以将来自不同数据源的数据进行清洗、转换和整合,并提供统一的接口供用户查询和分析。

-

常用的数据集成平台有Talend、Informatica等。

-

四、数据提取的最佳实践

-

明确目标:

-

在开始数据提取之前,首先要明确提取的目标和目的。

-

这有助于确定需要提取哪些数据以及如何提取数据。

-

-

选择合适的工具:

-

根据数据源的特点和需求选择合适的工具。

-

不同的工具有不同的优势和适用场景,选择合适的工具可以提高提取效率和准确性。

-

-

遵守法律法规:

-

在提取数据时,要遵守相关的法律法规和隐私政策。

-

确保数据提取活动的合法性和合规性。

-

-

定期更新和维护:

-

由于数据源可能会发生变化或更新,因此需要定期更新和维护数据提取程序。

-

这可以确保数据的准确性和完整性,并及时发现和处理潜在的问题。

-

-

测试和优化:

-

在正式使用之前,要对数据提取程序进行测试和优化。

-

通过测试可以发现潜在的问题和错误,并进行相应的修复和优化。

-

这可以提高程序的稳定性和性能,确保数据的准确性和可靠性。

-

综上所述,数据提取是一门复杂而精细的技术活动。通过遵循上述流程、运用适当的技术与工具,并遵循最佳实践原则,企业可以高效地提取出有价值的数据信息,为业务发展和决策制定提供有力支持。