在互联网高速发展的今天,数据已经成为了各行各业的重要资源。而爬虫作为一种特殊的程序,可以帮助我们快速地获取到大量的数据。本文将从零开始,带领大家了解爬虫的基本概念、原理以及实践操作,帮助新手轻松掌握网络数据采集技术。

一、爬虫简介

- 什么是爬虫?

爬虫,即网络爬虫(Web Crawler),是一种按照一定的规则自动抓取互联网信息的程序。它可以根据预设的规则,自动访问网页并提取其中的数据,然后将这些数据保存到本地或者数据库中,以便于后续的分析和应用。

- 爬虫的分类

根据爬虫的行为特征,我们可以将爬虫分为以下几类:

(1)通用爬虫:又称为全网爬虫,它可以爬取整个互联网上的所有网页。这类爬虫通常用于搜索引擎、新闻聚合等领域。

(2)聚焦爬虫:又称为主题爬虫,它只关注某一特定领域的网页。这类爬虫通常用于垂直领域的数据采集和分析。

(3)增量式爬虫:它只会爬取新增的或者发生变化的网页,而不是重新爬取所有的网页。这类爬虫通常用于实时更新数据的场合。

二、爬虫原理

- HTTP协议

在了解爬虫之前,我们需要了解HTTP协议。HTTP(HyperText Transfer Protocol,超文本传输协议)是互联网上应用最为广泛的一种网络协议。所有的网页都是通过HTTP协议进行传输的,所以我们要学习爬虫,首先需要了解HTTP协议。

- URL

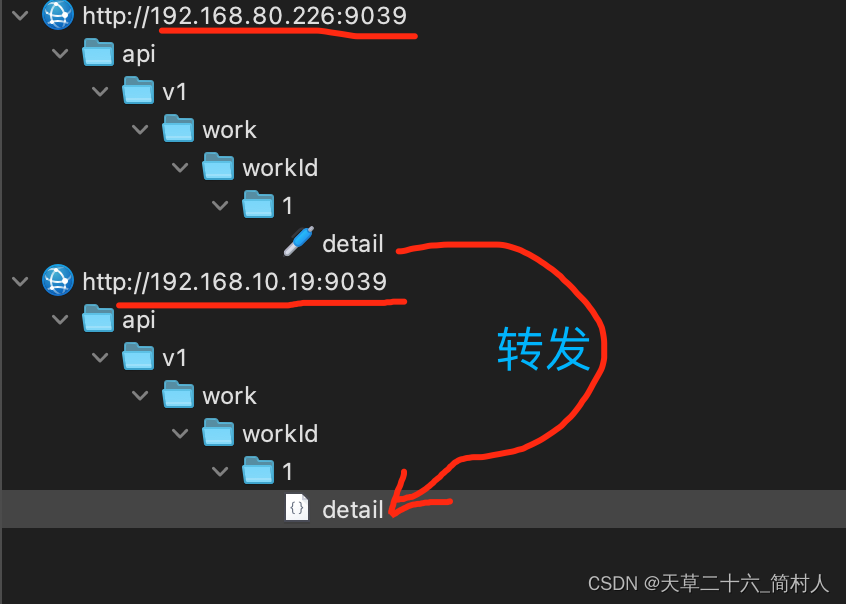

URL(Uniform Resource Locator,统一资源定位符)是互联网上用来标识资源的地址。一个URL包含了以下几个部分:协议名、主机名、端口号、路径和查询字符串。例如:https://www.example.com/path/to/resource?query=string。

- HTML文档结构

HTML(HyperText Markup Language,超文本标记语言)是用于描述网页结构的标记语言。一个HTML文档通常由以下几个部分组成:DOCTYPE声明、html标签、head标签和body标签。其中,body标签内包含了网页的主要内容,如文字、图片、链接等。

- DOM树

DOM(Document Object Model,文档对象模型)树是一种用于表示HTML文档结构的树形结构。它将HTML文档的各个元素抽象成对象,并通过对象之间的嵌套关系来表示它们之间的层次关系。通过操作DOM树,我们可以方便地对网页内容进行增删改查。

- CSS选择器

CSS(Cascading Style Sheets,层叠样式表)选择器是一种用于定位HTML元素的方法。通过CSS选择器,我们可以根据元素的标签名、类名、ID、属性等特征来精确地定位到目标元素。常用的CSS选择器有:元素选择器、类选择器、ID选择器、属性选择器等。

- XPath表达式

XPath(XML Path Language,XML路径语言)是一种用于在XML文档中查找信息的语言。与CSS选择器类似,XPath表达式也可以用于定位HTML元素。XPath表达式更加灵活,可以支持更复杂的查找需求。但是XPath语法相对复杂,不太适合初学者使用。

- 爬虫流程

爬虫的工作流程大致可以分为以下几个步骤:发起请求、解析响应、提取数据、存储数据。具体流程如下:

(1)发起请求:向目标网址发送HTTP请求,获取网页内容; (2)解析响应:对获取到的网页内容进行解析,生成DOM树; (3)提取数据:通过CSS选择器或XPath表达式定位到目标元素,提取其中的文本、属性等信息; (4)存储数据:将提取到的数据保存到本地或数据库中; (5)处理异常:处理可能出现的网络错误、编码问题等异常情况; (6)循环执行:根据需求设置循环条件,实现批量爬取功能; (7)反爬策略:针对网站设置反爬机制,如设置User-Agent、Cookie等。

三、实践操作

- Python爬虫库介绍

Python是一门非常适合编写爬虫程序的语言,有很多成熟的爬虫库可以帮助我们快速实现功能。常见的Python爬虫库有:requests、BeautifulSoup、lxml、Scrapy等。下面我们简单介绍一下这些库的功能:

(1)requests:用于发送HTTP请求,获取网页内容; (2)BeautifulSoup:用于解析HTML文档,生成DOM树; (3)lxml:同样用于解析HTML文档,性能优于BeautifulSoup; (4)Scrapy:一款强大的爬虫框架,支持多线程、分布式等功能。

- 实战案例——爬取豆瓣读书网站(利用css选择器和request)

import requests

import json

import re

import parsel

import pandas as pd

url="https://book.douban.com/top250?icn=index-book250-all"

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get(url,headers=headers)

data = response.content.decode(response.apparent_encoding, errors='replace')

selector=parsel.Selector(data)

lis=selector.css('.indent table td:nth-child(2) ')

data=[]

for li in lis:

title=li.css('a::text').get()

title=title.replace(" ", "")

img=li.css('img::attr(src)').get()

zuozhe=li.css('p::text').get()

data.append({"书名":title,"作者":zuozhe,"图片":img})

print(title)

print(zuozhe)

print(img)

df=pd.DataFrame(data)