在自然语言处理(NLP)的领域中,Transformer模型无疑是近年来最具革命性的方法之一。它的出现不仅大大提高了机器翻译、文本生成等任务的精度,还推动了整个深度学习研究的进步。本文将详细介绍Transformer模型中的序列到序列模型(Seq2Seq),包括其基本原理、应用场景以及具体实现方法。希望通过这篇教程,能够让你更好地理解和应用这一强大的模型。

一、什么是序列到序列模型(Seq2Seq)

序列到序列模型(Seq2Seq)是用于处理序列数据的一种深度学习架构。它的主要特点是能够将一个输入序列转换为一个输出序列,广泛应用于机器翻译、文本摘要、问答系统等领域。

1.1 基本结构

Seq2Seq模型通常由两个主要部分组成:编码器(Encoder)和解码器(Decoder)。编码器负责将输入序列转换为一个固定长度的上下文向量,而解码器则利用这个上下文向量生成目标序列。

-

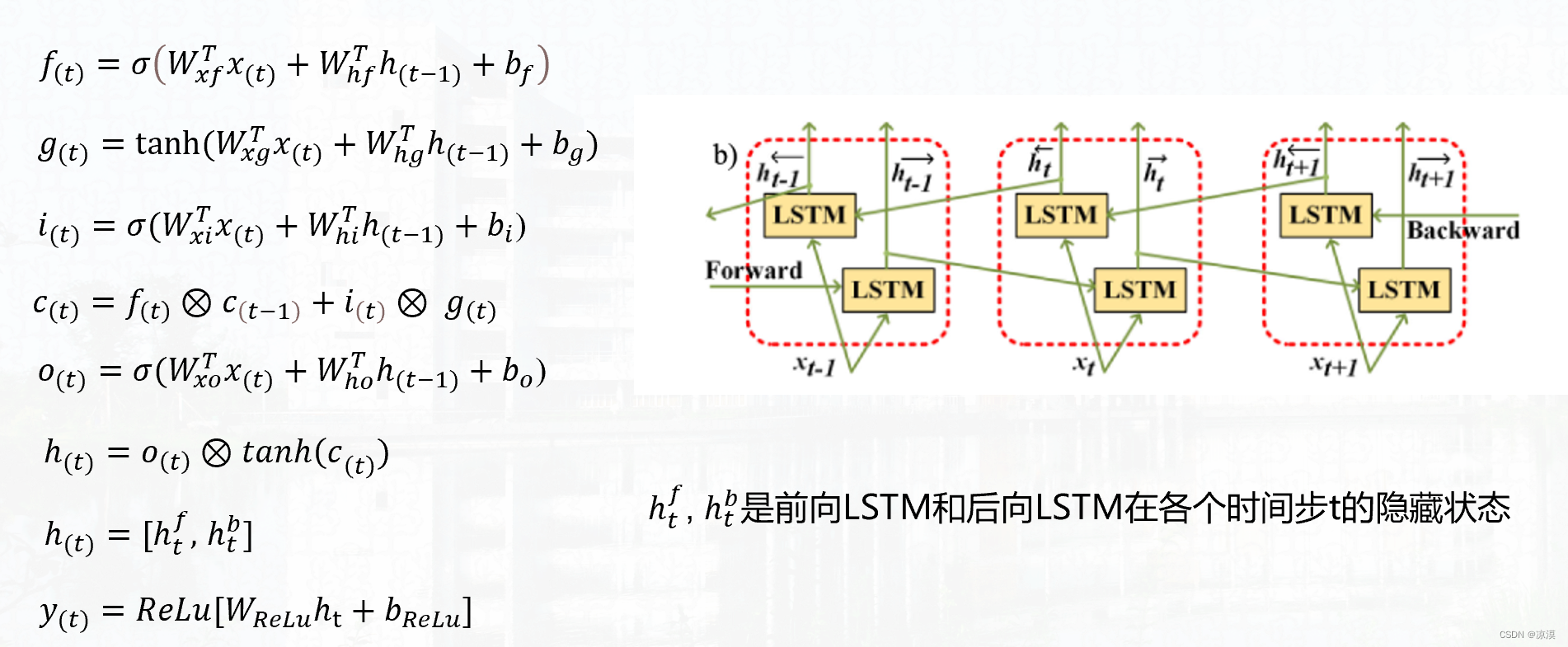

编码器:编码器通常由一系列RNN、LSTM或GRU单元组成,它逐步处理输入序列的每个元素,并将其转换为隐藏状态。最终的隐藏状态作为输入传递给解码器。

-

解码器:解码器也由类似的RNN、LSTM或GRU单元组成,它利用编码器传递的隐藏状态逐步生成输出序列。

1.2 注意力机制

传统的Seq2Seq模型存在一个主要问题:编码器需要将整个输入序列的信息压缩到一个固定大小的向量中,这对于长序列来说效果较差。为了解决这个问题,研究人员引入了注意力机制(Attention Mechanism),它允许解码器在生成每个输出元素时,都能动态地访问输入序列的不同部分。

二、Transformer模型的引入

虽然RNN和LSTM在处理序列数据时表现出色,但它们在并行计算和长依赖关系捕捉方面存在一定的限制。为了解决这些问题,Vaswani等人在2017年提出了Transformer模型。

2.1 Transformer的基本构成

Transformer模型彻底摆脱了RNN结构,完全基于注意力机制进行计算。它由多个编码器和解码器层堆叠而成,每一层都包含多头注意力机制和前馈神经网络。

-

多头注意力机制:允许模型从不同的表示空间中捕捉输入序列的不同特征。

-

前馈神经网络:用于进一步处理注意力机制输出的特征。

2.2 位置编码

由于Transformer模型不具备处理序列数据的天然顺序感,因此引入了位置编码(Positional Encoding)。位置编码通过给输入序列中的每个位置添加一个独特的向量,使得模型能够识别不同位置的顺序信息。

三、Transformer在Seq2Seq中的应用

Transformer模型的一个重要应用就是序列到序列任务。下面,我们将通过一个具体的示例,详细讲解Transformer在机器翻译中的应用。

3.1 数据准备

首先,我们需要准备训练数据。以英语到法语的机器翻译任务为例,我们需要一对一的英语-法语句子对作为训练数据。

Python

import torch

from torchtext.data import Field, TabularDataset, BucketIterator

SRC = Field(tokenize=str.split, lower=True, init_token='<sos>', eos_token='<eos>')

TRG = Field(tokenize=str.split, lower=True, init_token='<sos>', eos_token='<eos>')

data_fields = [('src', SRC), ('trg', TRG)]

train_data, valid_data, test_data = TabularDataset.splits(

path='data/',

train='train.csv', validation='valid.csv', test='test.csv',

format='csv',

fields=data_fields)

SRC.build_vocab(train_data, max_size=10000)

TRG.build_vocab(train_data, max_size=10000)

train_iterator, valid_iterator, test_iterator = BucketIterator.splits(

(train_data, valid_data, test_data),

batch_size=32,

device=device)3.2 模型构建

接下来,我们构建Transformer模型。这里,我们将使用PyTorch框架进行实现。

Python

import torch.nn as nn

import torch.nn.functional as F

class TransformerModel(nn.Module):

def __init__(self, src_vocab_size, trg_vocab_size, d_model, nhead, num_encoder_layers, num_decoder_layers, dim_feedforward=512, dropout=0.1):

super(TransformerModel, self).__init__()

self.src_embedding = nn.Embedding(src_vocab_size, d_model)

self.trg_embedding = nn.Embedding(trg_vocab_size, d_model)

self.transformer = nn.Transformer(d_model, nhead, num_encoder_layers, num_decoder_layers, dim_feedforward, dropout)

self.fc_out = nn.Linear(d_model, trg_vocab_size)

self.dropout = nn.Dropout(dropout)

self.d_model = d_model

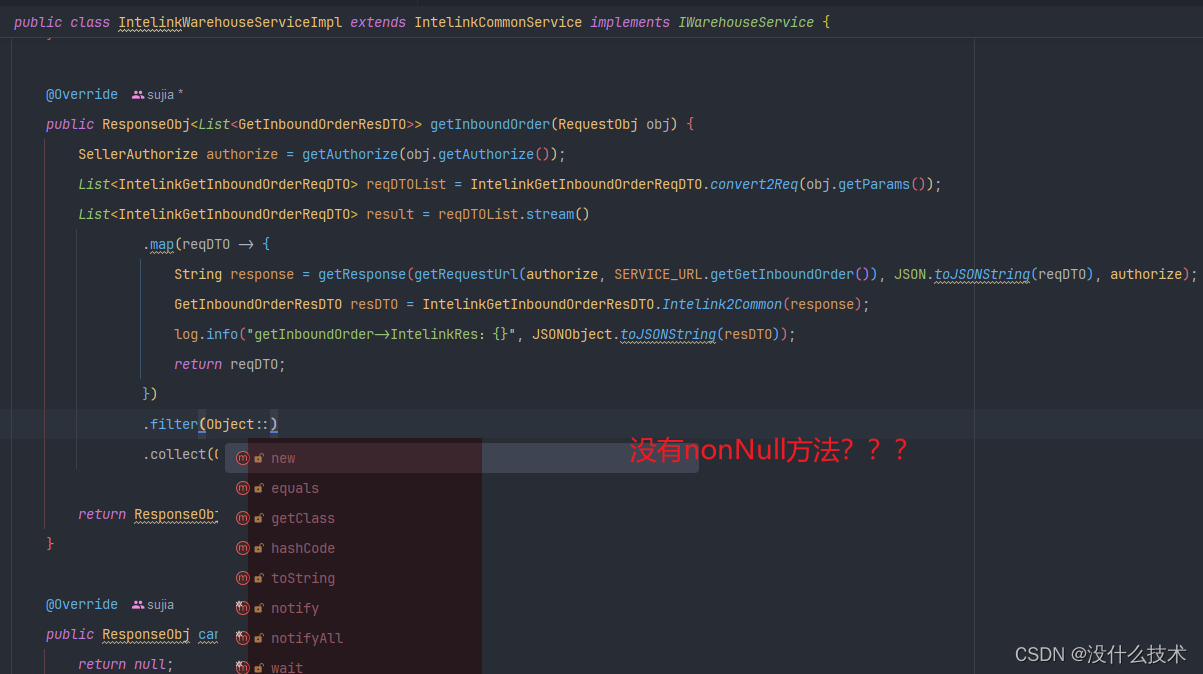

def forward(self, src, trg):

src = self.src_embedding(src) * math.sqrt(self.d_model)

trg = self.trg_embedding(trg) * math.sqrt(self.d_model)

src = self.dropout(src)

trg = self.dropout(trg)

src = self.positional_encoding(src)

trg = self.positional_encoding(trg)

output = self.transformer(src, trg)

output = self.fc_out(output)

return output

def positional_encoding(self, x):

pe = torch.zeros(x.size(0), x.size(1), self.d_model).to(x.device)

for pos in range(x.size(1)):

for i in range(0, self.d_model, 2):

pe[:, pos, i] = math.sin(pos / (10000 ** ((2 * i)/self.d_model)))

pe[:, pos, i + 1] = math.cos(pos / (10000 ** ((2 * i)/self.d_model)))

return x + pe3.3 模型训练

定义好模型后,我们需要进行训练。

Python

import torch.optim as optim

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = TransformerModel(len(SRC.vocab), len(TRG.vocab), 512, 8, 6, 6).to(device)

optimizer = optim.Adam(model.parameters(), lr=0.0005)

criterion = nn.CrossEntropyLoss(ignore_index=TRG.vocab.stoi['<pad>'])

for epoch in range(20):

model.train()

epoch_loss = 0

for i, batch in enumerate(train_iterator):

src = batch.src.to(device)

trg = batch.trg.to(device)

optimizer.zero_grad()

output = model(src, trg[:, :-1])

output_dim = output.shape[-1]

output = output.contiguous().view(-1, output_dim)

trg = trg[:, 1:].contiguous().view(-1)

loss = criterion(output, trg)

loss.backward()

optimizer.step()

epoch_loss += loss.item()

print(f'Epoch {epoch+1} Loss: {epoch_loss/len(train_iterator)}')四、Transformer模型的优势与挑战

4.1 优势

-

并行计算:与RNN不同,Transformer能够并行处理整个输入序列,提高了训练速度。

-

长依赖关系处理:注意力机制能够更好地捕捉长序列中的依赖关系,提升模型的性能。

4.2 挑战

-

计算资源需求高:Transformer模型需要大量的计算资源,尤其在处理大规模数据时,对硬件要求较高。

-

调参复杂:Transformer模型有很多超参数需要调节,如层数、注意力头数、隐藏单元维度等,调参过程复杂且耗时。

五、总结

Transformer模型作为序列到序列任务中的一项重大突破,其卓越的性能和灵活的结构为NLP领域带来了诸多可能性。通过本文的介绍,希望你能够更好地理解Transformer模型的基本原理和实现方法,并在实际项目中充分利用这一强大的工具。无论是机器翻译、文本生成还是其他NLP任务,Transformer都将是你不可或缺的助手。

Transformer教程之序列到序列模型(Seq2Seq) (chatgptzh.com)![]() https://www.chatgptzh.com/post/515.html

https://www.chatgptzh.com/post/515.html