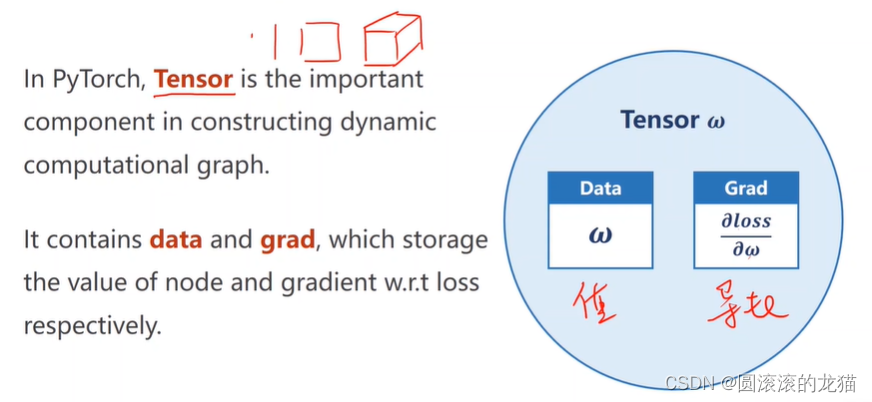

tensor在pytorch中是一个非常重要的类型

假如需要计算梯度,就将tensor中 requires_grad设为true

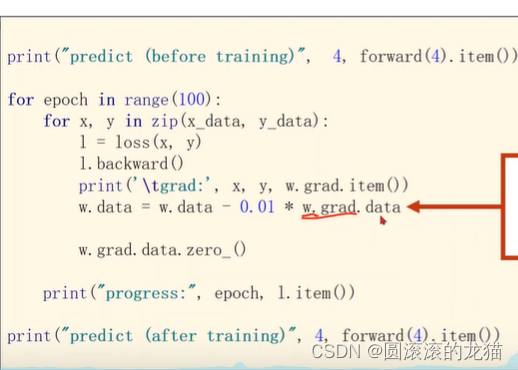

loss是一个张量,在做运算时构建运算图,因此不要直接进行,会将将梯度存入w,当反向传播完成 后,该计算图会被释放

这里注意一下grad即梯度也是一个tensor类型,要取到data才能做运算

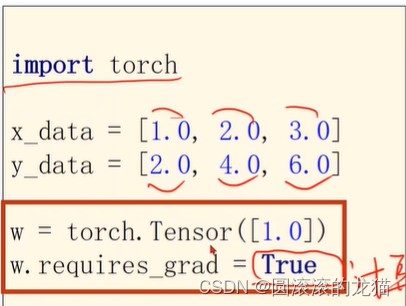

import torch

x_data=[1.0,2.0,3.0]#x

y_data=[2.0,4.0,6.0]#y

w=torch.Tensor([1.0])

w.requires_grad=True

def forward(x):

return x*w#w是一个tensor,就是梯度

def loss(x,y):

y_pred=forward(x)

return (y_pred-y)**2#损失值

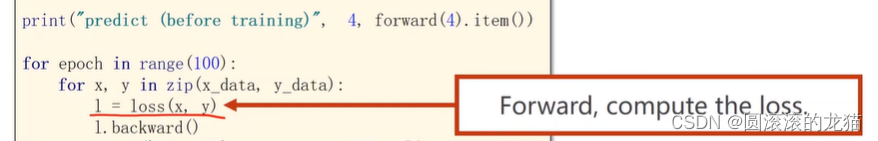

print('predict (before training)',4,forward(4).item())

for epoch in range(100):

for x,y in zip(x_data,y_data):

l=loss(x,y)

l.backward()#自动调用偏导

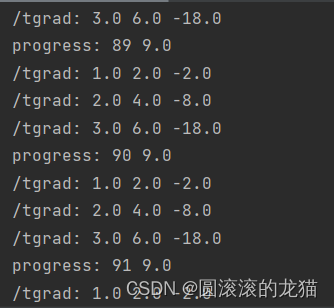

print('/tgrad:',x,y,w.grad.item())

w.grad.data.zero_()

print('progress:',epoch,l.item())

print('predict(after training)',4,forward(4).item())

线性回归就是一个最简单的只有一个神经元的神经网络

![[数据集][目标检测]电缆钢丝绳线缆缺陷检测数据集VOC+YOLO格式1800张3类别](https://i-blog.csdnimg.cn/direct/f5f72bef0299435bb2464edba6e213be.png)