域适应和域泛化一直以来都是各大顶会的热门研究方向。

域适应指:当我们在源域上训练的模型需要在目标域应用时,如果两域数据分布差异太大,模型性能就有可能降低。这时可以利用目标域的无标签数据,通过设计特定方法减小域间差异,来提升模型在目标域的性能。

而域泛化与域适应不同,域泛化让模型学会泛化到多个新测试域,而不仅仅是适应一个特定的目标域。这种方法的核心在于利用多源域信息增强模型泛化能力。

本文盘点了 CVPR 2024 有关域适应、域泛化的研究成果 32 篇,帮助大家了解并掌握最新的进展。

论文原文以及开源代码需要的同学看文末

域适应

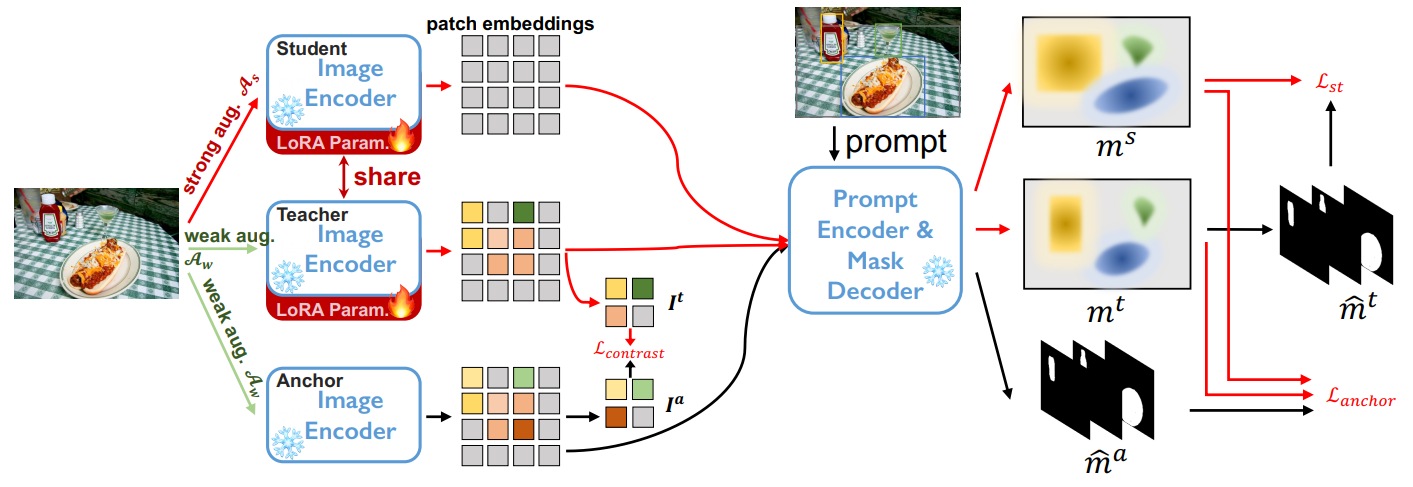

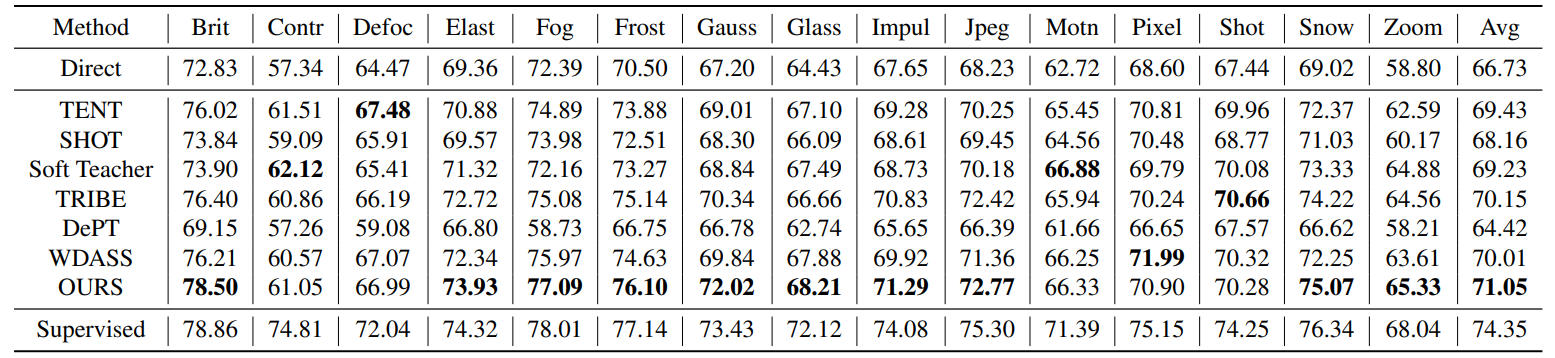

Improving the Generalization of Segmentation Foundation Model under Distribution Shift via Weakly Supervised Adaptation

第一个针对「Segment Anything」大模型的域适应策略

方法:本文研究了Segment-Anything模型在多个图像分割任务中的泛化能力,并提出了一种适应性方法,该方法不需要访问源数据集且内存开销低,能够通过弱监督有效改善模型的适应性,通过对10个数据集的广泛评估,表明了该方法的有效性。

创新点:

-

引入自我训练的自适应框架:作者提出了一种基于自我训练的自适应框架,通过弱监督来建立伪预测之间的对应关系,实现对下游数据的自适应。这种方法能够在没有源领域数据的情况下适应下游任务,从而避免了高计算开销和潜在的隐私问题。

-

低内存占用的模型权重更新方法:作者介绍了一种低内存占用的模型权重更新方法,通过对编码器网络进行LoRA微调,实现了最佳性能。这种方法能够在大型基础模型上进行适应或微调,而无需重新训练整个模型,从而节省了计算资源。

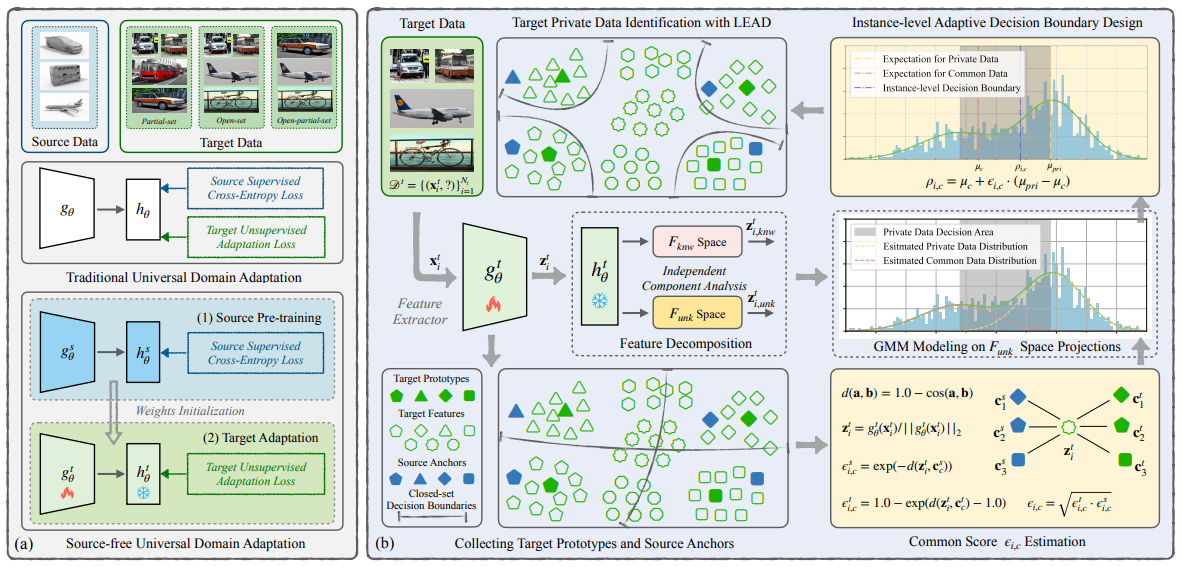

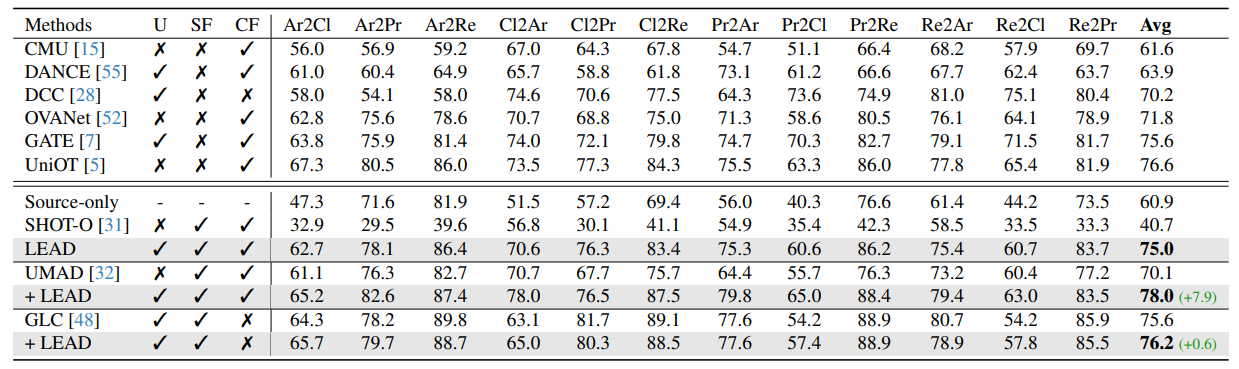

LEAD: Learning Decomposition for Source-free Universal Domain Adaptation

方法:本文介绍了源无关通用领域自适应(SF-UniDA)问题,并提出了一种LEArning Decomposition(LEAD)框架来解决该问题。LEAD框架通过特征分解将特征分为源已知和源未知两部分,并根据与目标原型和源锚点的距离建立实例级别的决策边界,以识别目标私有未知数据。

创新点:

-

提出了一种新的方法来处理源自由通用领域适应(SF-UniDA)问题。通过特征分解的方法,LEAD能够识别目标私有数据,减少了对手工调整阈值或依赖不稳定聚类的依赖。LEAD还可以作为现有方法的补充,进一步提高性能。

-

LEAD提出了一种实例级伪标签策略,通过与目标原型和源锚点的距离来建立决策边界。实例级决策边界策略在OPDA场景中能够显著提高性能,它考虑了不同类别之间的协变量漂移的不一致性和相同类别中样本的变异性。

域泛化

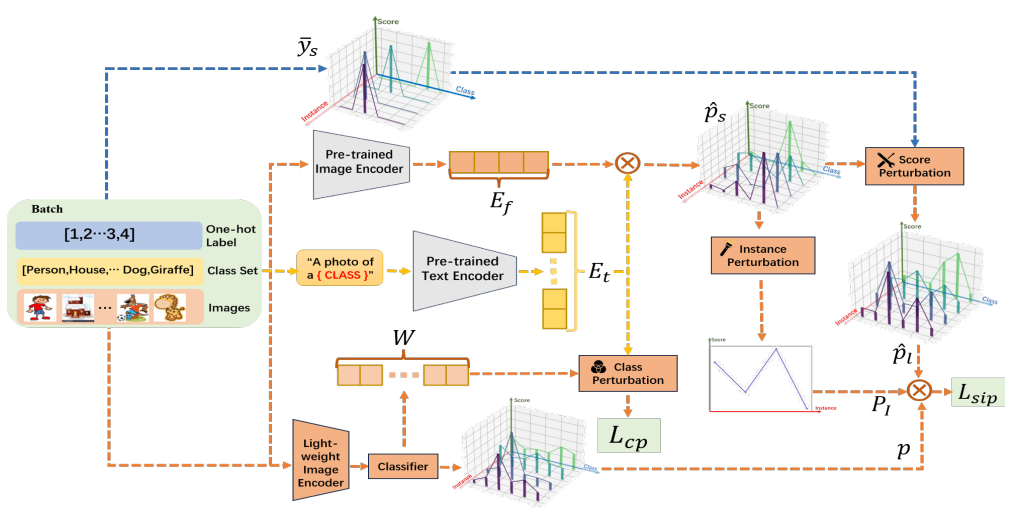

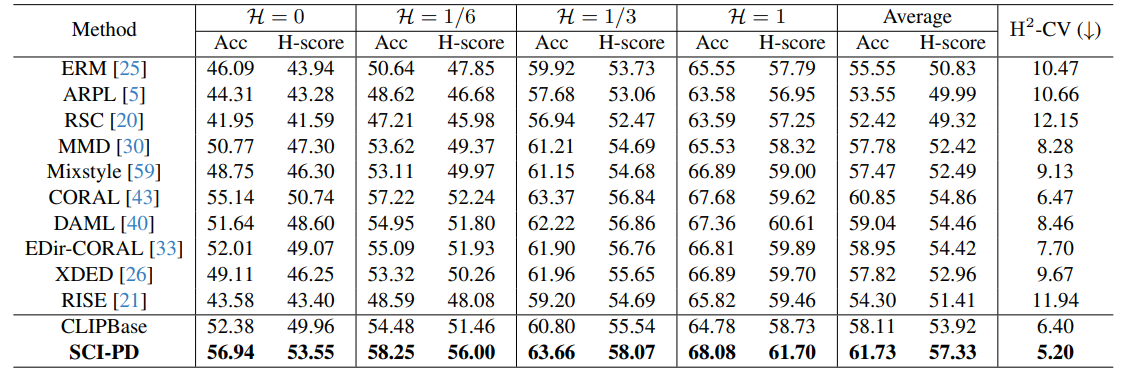

PracticalDG: Perturbation Distillation on Vision-Language Models for Hybrid Domain Generalization

方法:从算法、基准和指标的角度提高领域泛化的实用性,首先开发了一种新颖的扰动蒸馏(PD)算法,将视觉-语言模型的零样本能力转移到轻量级视觉模型,从而避免了传统微调范式下的大量计算成本;作者引入了从得分、类别和实例(SCI)中挖掘视觉-语言模型知识的扰动;此外,还提出了一个混合领域泛化(HDG)基准和一种新颖的度量H2 -CV来全面评估模型的鲁棒性

创新点:

-

提出了一种名为SCI-PD的方法,通过从得分、类别和实例三个角度对轻量级视觉模型进行扰动,从而将知识从视觉-语言模型转移给轻量级视觉模型,解决了开放集域泛化问题。

-

提出了一种名为HDG的基准和一种新的度量指标H2-CV,用于全面评估模型的鲁棒性。

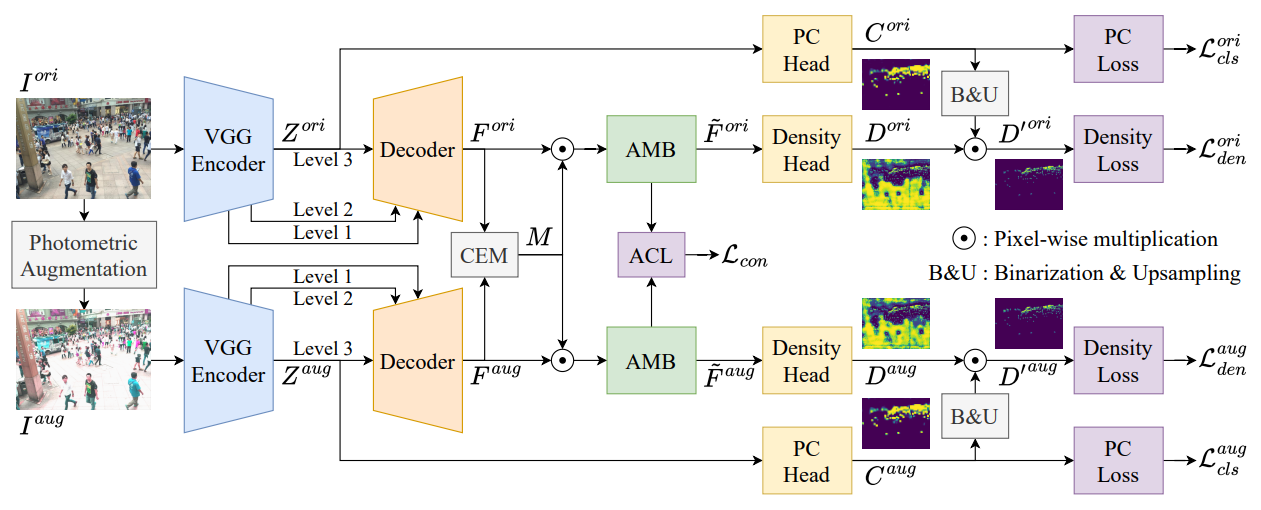

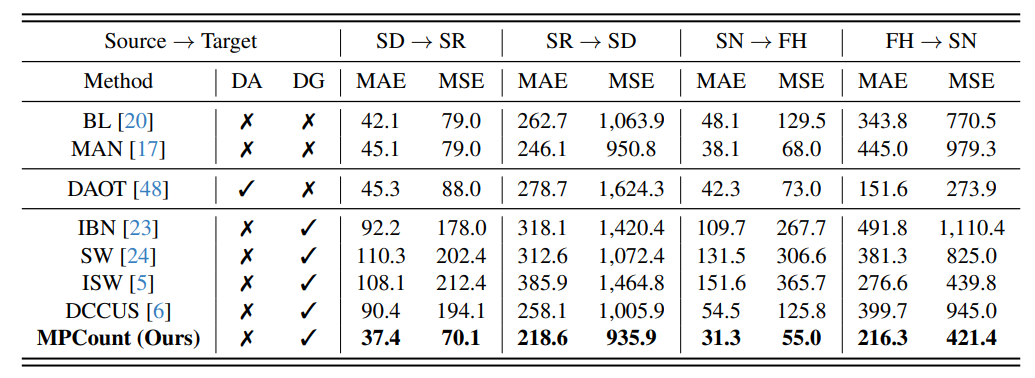

Single Domain Generalization for Crowd Counting

方法:本文研究了单域泛化(SDG)在人群计数中的应用。作者提出了MPCount方案,该方案包括基于密度回归的注意力记忆库、内容错误掩码和注意一致性损失等。此外,为了应对标签模糊的挑战,还提出了基于补丁分类的方法。研究还引入了单域泛化的概念,该方法可以在只有一个源域可用的情况下进行训练。

创新点:

-

MPCount引入了一个注意力内存库(AMB),用于处理密度回归问题。与以往的方法不同,它只使用一个注意力内存库,而不是多个子域分别对应不同的类别。这种设计使得MPCount在狭窄的源分布下仍然有效,并能够对密度回归进行建模。

-

MPCount通过将图像划分为网格来实现基于块的分类作为辅助任务,以减轻标签的歧义性。这种方法可以解决标签模糊的问题,提供可靠的众数信息,从而提高模型对领域变化的鲁棒性。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“CVPR域”获取全部论文+代码

码字不易,欢迎大家点赞评论收藏

![【代码随想录】【算法训练营】【第51天】 [115]不同的子序列 [583]两个字符串的删除操作 [72]编辑距离](https://img-blog.csdnimg.cn/direct/3e3b7dfda93643709079ca59b4ab8b83.png)