摘要

- 以往的方法忽略了任务的显著特异性:对于不变和变化的图像对,RSICC难度是不同的,以一种耦合的方式处理未变化和变化的图像对,这通常会导致变化字幕的混淆。

- 论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10271701

- 代码链接:GitHub - Chen-Yang-Liu/PromptCC: PyTorch implementation of 'A Decoupling Paradigm With Prompt Learning for Remote Sensing Image Change Captioning'

动机

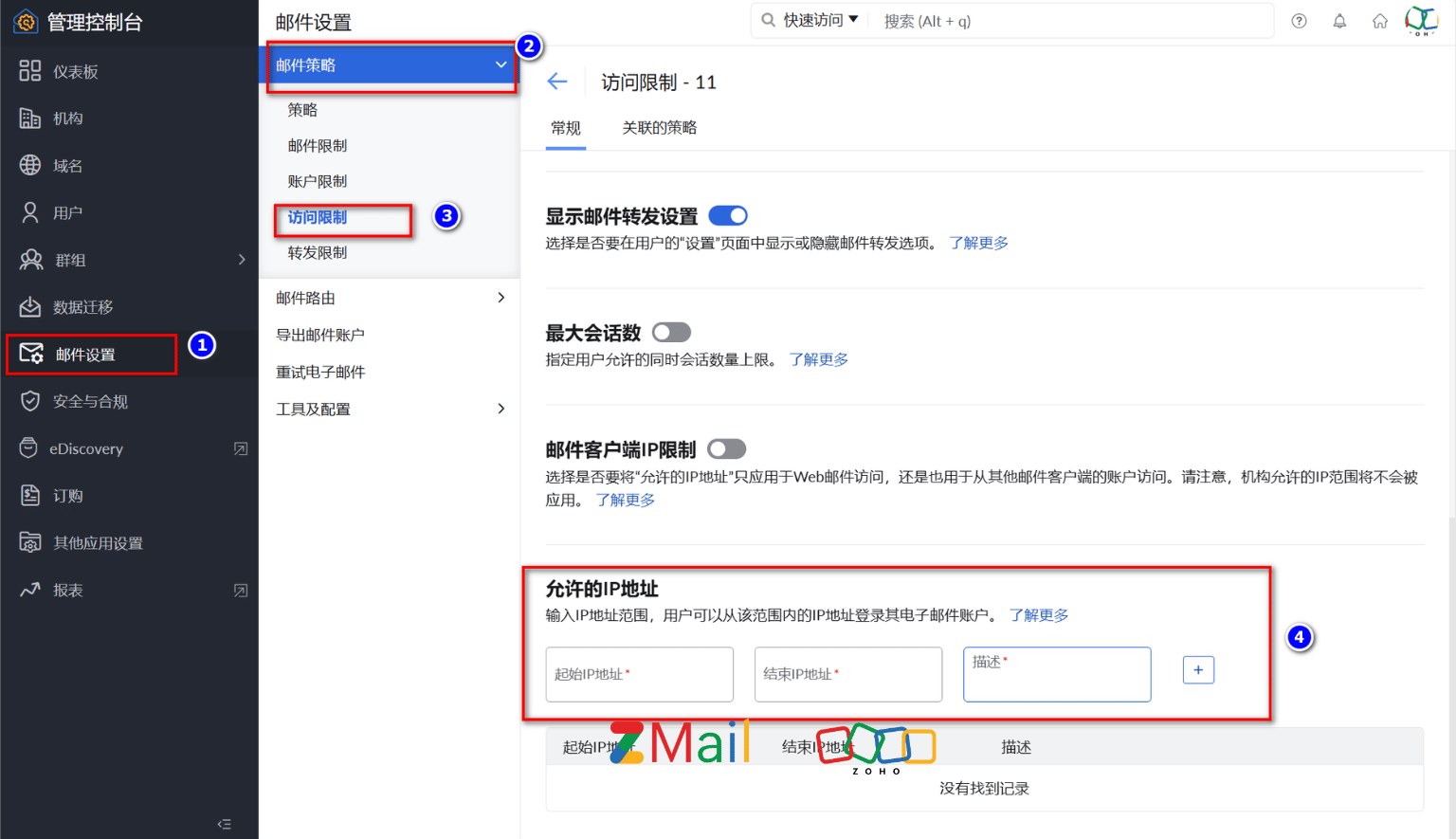

- 图1 (a)所示方法对两种图像对进行耦合处理,用一个编码器来同时突出变化图像的变化特征和捕获变化图像的无变化语义很困难,且目前的方法更关注变化区域的特征提取,不适合描述不变的图像对。

- 图1 (b)所示方法参考人脑在变化描述时的思维模式,视觉上确定是否存在变化后,根据粗略的分类结果,大脑进一步识别图像对的内容。受此启发,本文提出一个解耦范式,将RSICC任务解耦为两个问题:是否发生了变化、发生了什么变化。

方法

PromptCC结构如下:

- 预训练后的CLIP模型的Vision Transformer从双时间图像中提取视觉特征;

- 用图像级分类器和特征级编码器(均使用Transformer编码器)进一步处理提取的视觉特征,实现任务的解耦,前者执行二值分类,确定双时态图像中是否存在变化,后者有助于提取鉴别特征,确定发生了什么变化。

- Image-level Classifier:二值分类任务,区分是否变化

- Feature-level Encoder:解决区分发生了什么变化

- Image-level Classifier:二值分类任务,区分是否变化

- 对于描述生成,引入Prompt Learning使用LLM作为描述生成器。具体地说,多提示学习策略生成多个可学习的提示,由一组统一的提示和一个特定类提示组成,这依赖分类器结果。最后,将生成的多个提示和提取的视觉特征连接起来,并发送到冻结的预先训练的LLM中进行标题生成。

- Multi-prompt Learning Strategy

- 结合RSICC任务的解耦情况,提出多提示学习策略生成多个可学习的提示,由一组统一的提示和一个特定于类的提示组成,前者可看作全局任务依赖提示

(其中K为可学习嵌入的数量),训练阶段结束后,在推理过程中对每个样本使用学习到的提示。后者依赖图像级分类器的结果,可以使LLM知道图像中是否存在变化,通过两个可学习的提示嵌入生成:

表示没有变化,

表示变化。其中,

是文本嵌入的维度,本文用两种方式将它们结合起来去生成特定于类的提示:

-

1) Soft class-specific prompt:通过加权

、

和图像级分类器的预测概率生成:

-

2) Hard class-specific prompt:根据图像级分类器的分类结果,选择

、

中的一个生成:

,

-

最后,生成的多提示

可以表述为:

- 结合RSICC任务的解耦情况,提出多提示学习策略生成多个可学习的提示,由一组统一的提示和一个特定于类的提示组成,前者可看作全局任务依赖提示

- Pre-trained Large Language Model

-

预训练后的LLM具有强大的特征表示能力,受GPT家族(如GPT-2、GPT-3和ChatGP)在语言生成任务上的巨大成功的启发,本文使用GPT-2作为标题生成器

-

GPT-2是一种基于trasformer的自回归LLM算法,是在一个大规模的互联网文本数据集上进行训练的,训练的目标是预测下一个单词。可以利用它强大的文本生成能力来生成标题。

-

将特征级编码器的上下文丰富表示

和多提示

输入冻结的GPT-2,以自回归的方式生成句子。详细过程见算法1。

-

-

- Multi-prompt Learning Strategy

实验

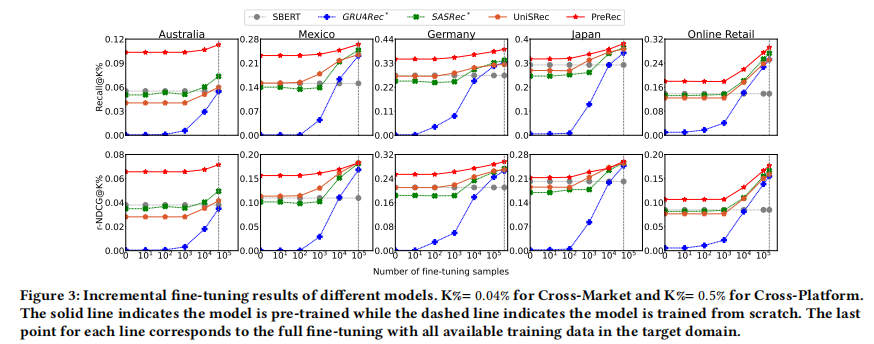

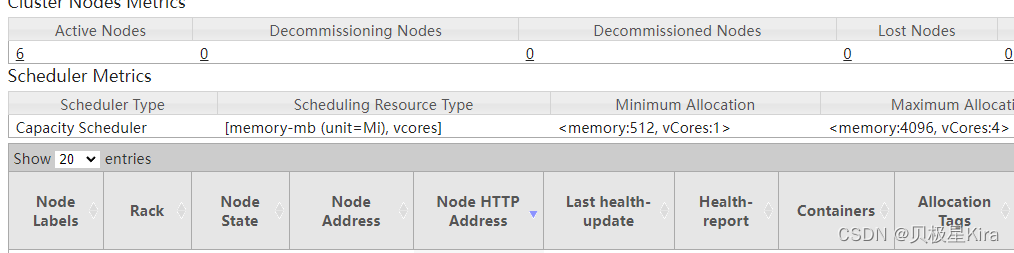

Comparison to State-of-the-Art

Ablation Studies

Qualitative Results and Analysis

Advantage of the decoupling paradigm

Parametric Experiments and Analysis