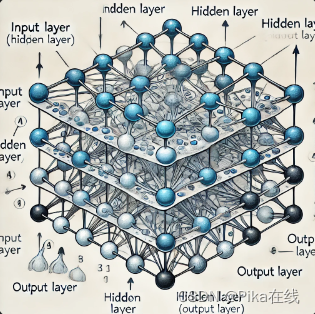

在深度学习领域,归一化技术被广泛用于加速神经网络的训练速度并提高其稳定性。本文将介绍两种常见的归一化方法:批归一化(Batch Normalization, BN)和层归一化(Layer Normalization, LN),并通过实例说明它们的作用。

什么是批归一化(Batch Normalization)

批归一化是由Sergey Ioffe和Christian Szegedy在2015年提出的一种归一化方法。它的主要思想是在每一层的前向传播中,对每一批(batch)数据进行归一化处理,使得每一层的输入分布更加稳定。

批归一化的公式

批归一化的过程可以分为以下几个步骤:

-

计算批数据的均值和方差:

对于一个批次的输入数据 ( X = [x_1, x_2, …, x_m] ),首先计算均值和方差:

μ B = 1 m ∑ i = 1 m x i \mu_B = \frac{1}{m} \sum_{i=1}^{m} x_i μB=m1i=1∑mxi

σ B 2 = 1 m ∑ i = 1 m ( x i − μ B ) 2 \sigma_B^2 = \frac{1}{m} \sum_{i=1}^{m} (x_i - \mu_B)^2 σB2=m1i=1∑m(xi−μB)2 -

归一化:

利用计算得到的均值和方差,对输入数据进行归一化:

x ^ i = x i − μ B σ B 2 + ϵ \hat{x}_i = \frac{x_i - \mu_B}{\sqrt{\sigma_B^2 + \epsilon}} x^i=σB2+ϵxi−μB

其中, ϵ \epsilon ϵ 是一个很小的常数,用于防止分母为零。 -

缩放和平移:

归一化后的数据再进行缩放和平移:

y i = γ x ^ i + β y_i = \gamma \hat{x}_i + \beta yi=γx^i+β

其中, γ \gamma γ 和 β \beta β 是可以学习的参数。

批归一化的优点

- 加速训练速度:批归一化可以使得每一层的输入分布更加稳定,从而使得梯度下降过程更加平稳,加速了模型的训练速度。

- 减少对初始权重的依赖:批归一化减小了对权重初始化的敏感性,使得模型在不同初始权重下的表现更加稳定。

- 防止过拟合:批归一化在一定程度上具有正则化效果,能够减少模型的过拟合。

批归一化的缺点

- 对小批量数据不友好:批归一化依赖于批次数据的统计特性,当批次大小很小时,统计量的估计可能不准确。

- 在某些情况下表现不佳:例如在循环神经网络(RNN)中,由于每个时间步的数据依赖于前一步的状态,批归一化可能会破坏这种依赖关系。

什么是层归一化(Layer Normalization)

层归一化是由Jimmy Lei Ba、Jamie Ryan Kiros和Geoffrey Hinton在2016年提出的一种归一化方法。它的主要思想是在每一层的前向传播中,对每一个样本的所有神经元进行归一化处理。

层归一化的公式

层归一化的过程可以分为以下几个步骤:

-

计算样本的均值和方差:

对于一个样本的输入数据 ( X = [x_1, x_2, …, x_n] ),首先计算均值和方差:

μ L = 1 n ∑ i = 1 n x i \mu_L = \frac{1}{n} \sum_{i=1}^{n} x_i μL=n1i=1∑nxi

σ L 2 = 1 n ∑ i = 1 n ( x i − μ L ) 2 \sigma_L^2 = \frac{1}{n} \sum_{i=1}^{n} (x_i - \mu_L)^2 σL2=n1i=1∑n(xi−μL)2 -

归一化:

利用计算得到的均值和方差,对输入数据进行归一化:

x ^ i = x i − μ L σ L 2 + ϵ \hat{x}_i = \frac{x_i - \mu_L}{\sqrt{\sigma_L^2 + \epsilon}} x^i=σL2+ϵxi−μL

其中, ϵ \epsilon ϵ 是一个很小的常数,用于防止分母为零。 -

缩放和平移:

归一化后的数据再进行缩放和平移:

y i = γ x ^ i + β y_i = \gamma \hat{x}_i + \beta yi=γx^i+β

其中, γ \gamma γ 和 β \beta β 是可以学习的参数。

层归一化的优点

- 对小批量数据友好:层归一化对每个样本单独进行归一化,因此对小批量数据也能够很好地工作。

- 适用于循环神经网络:层归一化在RNN中表现良好,因为它不会破坏时间步之间的依赖关系。

- 稳定训练过程:层归一化能够稳定训练过程,使得模型更容易收敛。

层归一化的缺点

- 计算开销较大:相比于批归一化,层归一化的计算开销较大,因为需要对每个样本的所有神经元进行归一化。

- 在某些情况下不如批归一化:在一些特定的任务中,层归一化的效果可能不如批归一化,例如在一些卷积神经网络中。

实例说明

为了更好地理解批归一化和层归一化的作用,下面通过一个简单的实例来说明。

数据准备

假设我们有一个简单的二分类任务,输入数据为二维向量,标签为0或1。我们生成一些随机数据来模拟这个任务:

import numpy as np

# 生成随机数据

np.random.seed(0)

X = np.random.randn(1000, 2)

y = (X[:, 0] + X[:, 1] > 0).astype(int)

构建模型

我们构建一个简单的全连接神经网络模型,分别使用批归一化和层归一化进行训练。

import torch

import torch.nn as nn

import torch.optim as optim

# 定义全连接神经网络模型

class SimpleNN(nn.Module):

def __init__(self, normalization=None):

super(SimpleNN, self).__init__()

self.fc1 = nn.Linear(2, 10)

self.fc2 = nn.Linear(10, 1)

self.normalization = normalization

if self.normalization == 'batch':

self.bn1 = nn.BatchNorm1d(10)

elif self.normalization == 'layer':

self.ln1 = nn.LayerNorm(10)

def forward(self, x):

x = self.fc1(x)

if self.normalization == 'batch':

x = self.bn1(x)

elif self.normalization == 'layer':

x = self.ln1(x)

x = torch.relu(x)

x = self.fc2(x)

return torch.sigmoid(x)

# 创建模型实例

model_bn = SimpleNN(normalization='batch')

model_ln = SimpleNN(normalization='layer')

model_no_norm = SimpleNN(normalization=None)

训练模型

我们分别训练使用批归一化、层归一化和不使用归一化的模型,并比较它们的训练效果。

# 定义损失函数和优化器

criterion = nn.BCELoss()

optimizer_bn = optim.Adam(model_bn.parameters(), lr=0.01)

optimizer_ln = optim.Adam(model_ln.parameters(), lr=0.01)

optimizer_no_norm = optim.Adam(model_no_norm.parameters(), lr=0.01)

# 转换数据为Tensor

X_tensor = torch.from_numpy(X).float()

y_tensor = torch.from_numpy(y).float().view(-1, 1)

# 训练模型

def train(model, optimizer, epochs=100):

for epoch in range(epochs):

optimizer.zero_grad()

outputs = model(X_tensor)

loss = criterion(outputs, y_tensor)

loss.backward()

optimizer.step()

if (epoch + 1) % 10 == 0:

print(f'Epoch [{epoch+1}/{epochs}], Loss: {loss.item():.4f}')

print("Training model with Batch Normalization")

train(model_bn, optimizer_bn)

print("Training model with Layer Normalization")

train(model_ln, optimizer_ln)

print("Training model without Normalization")

train(model_no_norm, optimizer_no_norm)

结果分析

在实际训练中,我们通常可以观察到使用批归一化和层归一化的模型相较于不使用归一化的模型,能够更快地收敛到较低的损失值,并且在训练过程中损失值的波动更小。这表明归一化技术能够有效地加速训练过程并提高模型的稳定性。

结论

批归一化和层归一化作为两种重要的归一化技术,各有优缺点。批归一化

适用于大批量数据训练,能够显著加速训练速度并防止过拟合;层归一化适用于小批量数据和循环神经网络,能够稳定训练过程。根据具体的任务需求,选择合适的归一化方法能够有效提升模型的性能。