本期为TechBeat人工智能社区第602期线上Talk。

北京时间6月20日(周四)20:00,北京大学博士生—张嘉曌的Talk已经准时在TechBeat人工智能社区开播!

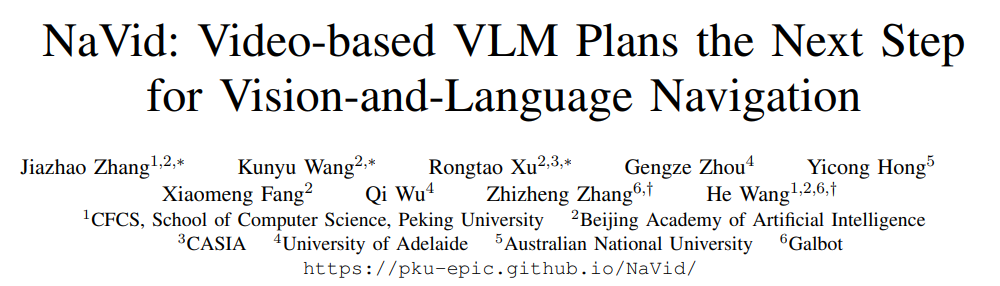

他与大家分享的主题是: “NaVid - 视觉语言导航大模型”,NaVid是首个专为视觉语言导航(VLN)任务设计的基于视频的具身大模型。NaVid使用导航过程中的视频观测和自然语言指令作为输入,直接输出机器人的导航动作。与大部分已有的机器人导航技术不同,NaVid不依赖于深度信息、里程计和地图,完全依靠RGB视觉感知实现端到端的导航控制。它仅利用模拟器的数据进行导航策略学习,就能在真实世界的场景中实现泛化的导航表现。该工作已入选RSS'24。

Talk·信息

▼

主题:NaVid - 视觉语言导航大模型

嘉宾:北京大学博士生 张嘉曌

时间:北京时间 6月20日(周四)20:00

地点:TechBeat人工智能社区

点击下方链接,即可观看视频!

TechBeatTechBeat是荟聚全球华人AI精英的成长社区,每周上新来自顶尖大厂、明星创业公司、国际顶级高校相关专业在读博士的最新研究工作。我们希望为AI人才打造更专业的服务和体验,加速并陪伴其成长。![]() https://www.techbeat.net/talk-info?id=881

https://www.techbeat.net/talk-info?id=881

Talk·介绍

▼

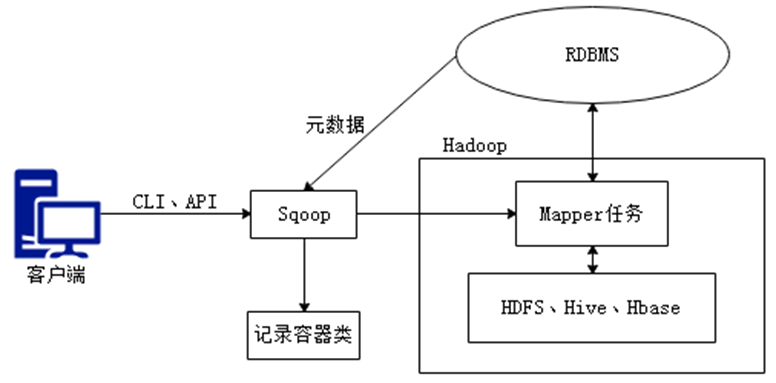

近年来,视觉语言大模型在理解文本和视觉信号方面展现出了令人瞩目的能力。本文旨在进一步探索这些模型在具身智能领域的潜力。我们实现了基于视觉语言的导航大模型NaVid。NaVid将指令和导航视频作为输入,可以直接输出底层动作命令(如前进、转向和停止)。这种方法摒弃了对地图、坐标等信息的依赖。我们还设计了在模拟器中收集和训练VLN数据的策略,并展示了NaVid在真实场景中实现视觉语言导航任务的泛化表现。

Talk大纲

1. 背景 - VLN任务介绍和相关工作

2.动机 – 为什么要使用视觉语言大模型去实现VLN

3. 问题 - 构建VLN大模型的难点

4. 解决方案 - 构建适合VLN模态的大模型结构,收集510k的VLN数据

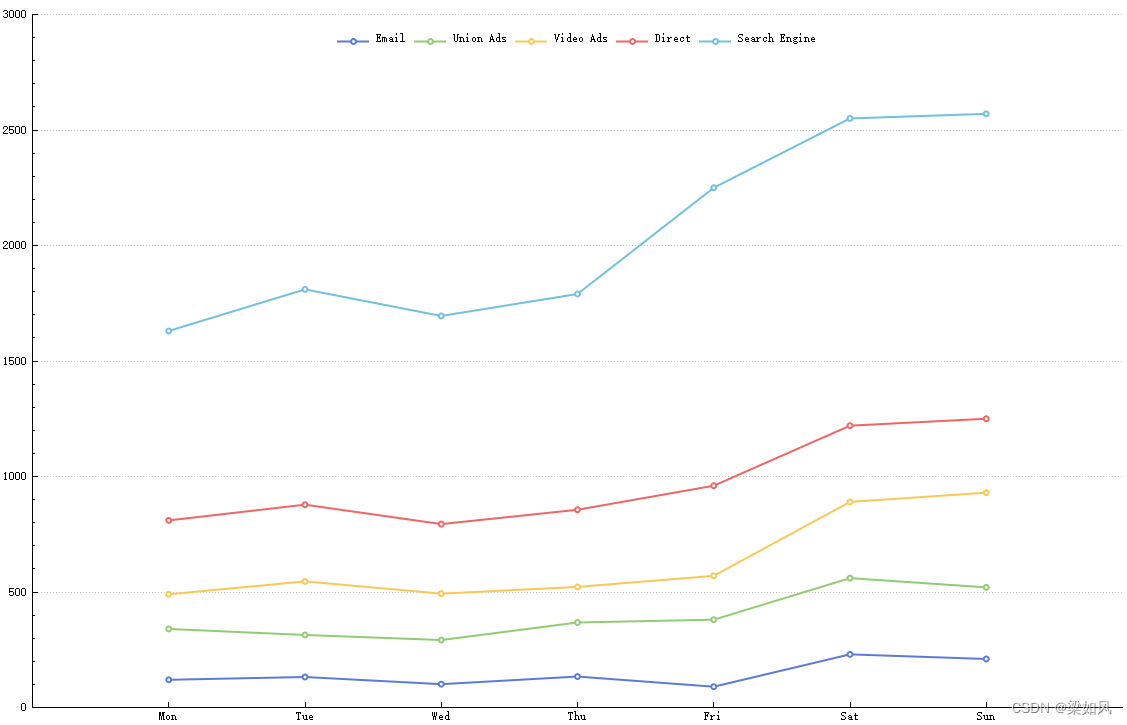

5. 实验结果 - 在R2R和RxR的表现,数据量对NaVid的影响,真机实验结果,视频指令推理结果

6.总结 - NaVid的意义和重要性

Talk·预习资料

▼

论文链接:

https://arxiv.org/abs/2402.15812

论文链接:

https://arxiv.org/abs/2311.17043

论文题目:

Vision and Language Navigation in Continuous Environments

项目链接:

https://jacobkrantz.github.io/vlnce/

论文链接:

https://arxiv.org/abs/2305.16986

Talk·提问交流

▼

在Talk界面下的【交流区】参与互动!留下你的打call🤟和问题🙋,和更多小伙伴们共同讨论,被讲者直接翻牌解答!

你的每一次贡献,我们都会给予你相应的i豆积分,还会有惊喜奖励哦!

Talk·嘉宾介绍

▼

张嘉曌

北京大学· 博士生

张嘉曌是北京大学前沿计算研究中心的博士研究生,师从王鹤助理教授。在此之前,他在国防科技大学师从徐凯教授获得硕士学位,并在山东大学获得工学学士学位。

张嘉曌的研究领域涵盖了Embodied AI和3D视觉。他已经以第一作者或共同第一作者的身份,在T-RO/RSS/SIGGRAPH/CVPR等国际顶级会议和期刊上发表了7篇论文

个人主页:

https://www.techbeat.net/grzytrkj?id=38010

关于TechBeat人工智能社区

▼

TechBeat(www.techbeat.net)隶属于将门创投,是一个荟聚全球华人AI精英的成长社区。

我们希望为AI人才打造更专业的服务和体验,加速并陪伴其学习成长。

期待这里可以成为你学习AI前沿知识的高地,分享自己最新工作的沃土,在AI进阶之路上的升级打怪的根据地!

更多详细介绍>>TechBeat,一个荟聚全球华人AI精英的学习成长社区