目录

一 决策树算法原理

特征选择

信息增益

信息增益比

基尼指数

树的构建

树的剪枝

预剪枝

后剪枝

二 决策树算法实现

一 使用决策树进行分类

数据预处理

构建决策树模型

二 使用决策树进行回归

数据预处理

构建决策树回归模型

三 决策树算法的优缺点

优点

缺点

四 决策树的改进与扩展

随机森林

梯度提升树

剪枝算法

特征选择策略

五 结论

在数据科学和机器学习领域,决策树是一种广泛应用的监督学习算法。它以树状结构直观地表示决策过程,通过一系列的简单判断逐步分类或回归数据。由于其易于理解和解释,决策树被广泛应用于各种实际问题,如金融风险评估、医疗诊断和市场营销策略等。本文将深入探讨决策树算法的原理,展示其在分类和回归任务中的应用,并通过具体案例实现,帮助读者全面掌握这一重要的机器学习算法。

一 决策树算法原理

决策树是一种基于树结构的模型,分为分类树和回归树两种。分类树用于离散型目标变量的分类任务,而回归树则用于连续型目标变量的回归任务。决策树的构建过程涉及特征选择、树的构建和剪枝等关键步骤。

特征选择

在决策树的构建过程中,特征选择是关键步骤之一。特征选择的目的是在每个节点选择一个最佳特征,将数据集划分为纯度最高的子集。常用的特征选择准则包括信息增益、信息增益比和基尼指数。

信息增益

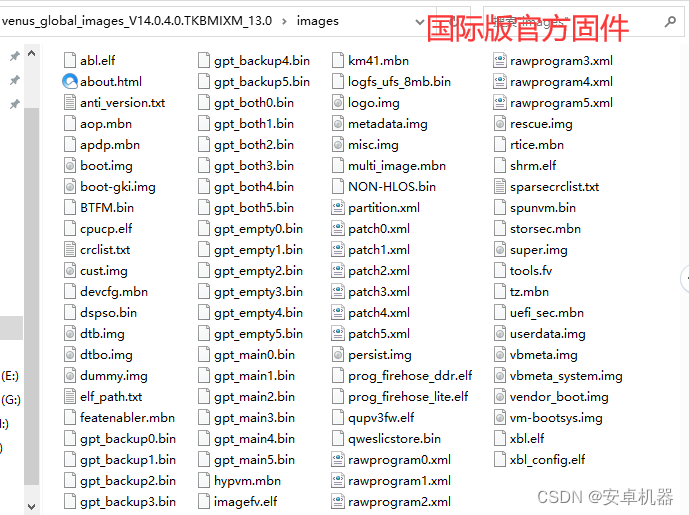

信息增益是基于熵(Entropy)的概念来衡量特征对数据集分类的不确定性减少的程度。信息增益越大,特征越好。信息增益的计算公式为:

![]()

其中,D表示数据集,A表示特征,Dv表示特征A取值为v的数据子集。

信息增益比

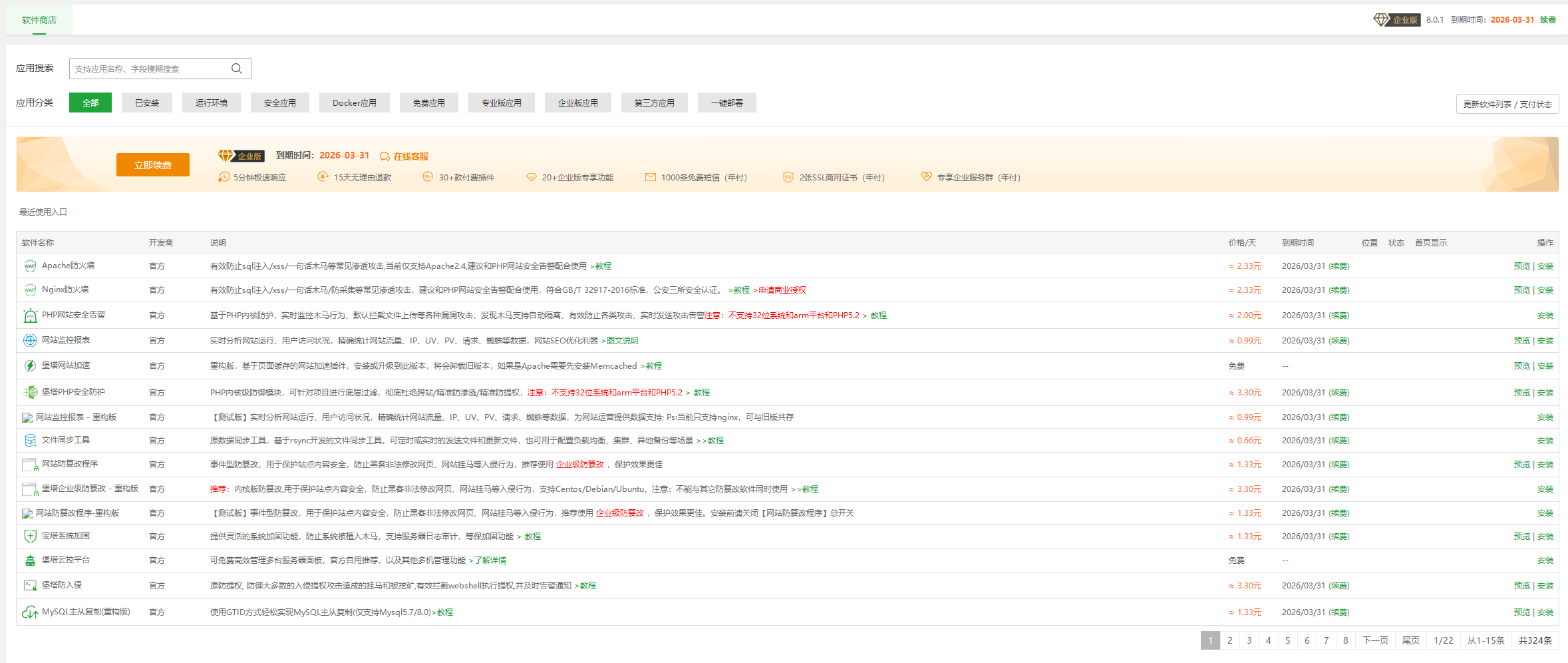

信息增益比是对信息增益的改进,考虑了特征取值的数量差异。信息增益比的计算公式为:

![]()

其中,熵A(D)是特征A的熵。

基尼指数

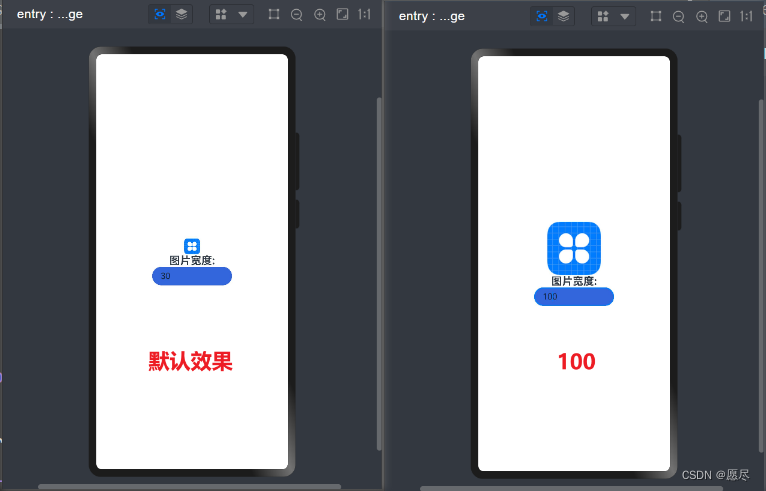

基尼指数是一种衡量数据集纯度的指标,基尼指数越小,数据集的纯度越高。基尼指数的计算公式为:

![]()

其中,pi表示第i类的概率。

树的构建

决策树的构建过程是一个递归划分数据集的过程,直到满足停止条件。具体步骤如下:

- 选择最佳特征:根据特征选择准则选择一个最佳特征。

- 划分数据集:根据最佳特征的取值将数据集划分为若干子集。

- 递归构建子树:对每个子集递归地重复上述步骤,构建子树,直到满足停止条件。

停止条件通常包括以下几种情况:

- 所有样本属于同一类别。

- 没有可分裂的特征。

- 树的深度达到预设的最大深度。

- 子集中的样本数量小于预设的最小样本数。

树的剪枝

决策树容易过拟合,因此需要进行剪枝来简化模型,提高泛化能力。剪枝分为预剪枝和后剪枝。

预剪枝

预剪枝在构建决策树的过程中进行,通过设置一些条件提前停止树的生长,如限制树的最大深度、最小样本数等。预剪枝的优点是简单易行,但可能导致欠拟合。

后剪枝

后剪枝是在构建完整决策树之后进行,通过剪去一些子树,合并节点来简化模型。常用的后剪枝方法包括代价复杂度剪枝(Cost Complexity Pruning)和错误率剪枝(Error Rate Pruning)。后剪枝通常能取得更好的效果,但计算开销较大。