自Stable Diffusion发布以来,AI写真一直是AIGC界的热门话题。

AI写真为摄影师和艺术家提供了全新的创作工具。通过AI技术,艺术家可以轻松实现复杂的图像效果,如风格迁移、图像合成等,AI写真能够在短时间内完成传统摄影师和设计师需要耗费大量时间和精力才能实现的效果。

从这篇文章开始,我将陆续介绍使用Stable Diffusion进行AI写真的方式方法,用到的工具包括 Stable Diffusion WebUI 和 ComfyUI,感兴趣的同学请及时关注,以免错过重要信息。

本文介绍使用 IP-Adapter-FaceId(文末可领取!)

进行AI写真创作的方法。这种方法使用来自面部识别模型的面孔ID嵌入,而不是CLIP图像嵌入;另外,这种方法还使用LoRA来提高ID一致性。IP-Adapter-FaceID仅凭文本提示就可以根据一张面孔生成各种风格的图像。

效果演示

像不像先不说,我们先来看看好不好看(大家猜猜她是谁?):

实现原理

AI写真是利用人工智能技术生成或增强的照片。这种技术结合了计算机视觉、深度学习和图像处理等先进的算法,使得机器能够自动生成、修复、增强或编辑照片。

具体来说,目前AI写真的实现方式大概有如下几种:

- 使用ControlNet:ControlNet为Stable Diffusion提供了一些精细控制能力,它可以从参考图片中提取一些特征信息,比如人脸、姿势、色彩、线稿等等,然后在生成的图片中应用这些信息,从而在AI写真中达到精细的人物形象控制效果。

- 结合换脸技术:先使用SD、Midjourney等AI绘画工具生成若干符合场景或风格要求的人物图片,然后再使用AI换脸技术更换图片中的人物面部形象,从而实现AI写真的目的。

- 训练LoRA模型:LoRA本身一种模型微调技术,可以让模型在某方面的生成能力得到大幅增强。对于AI写真,我们先准备若干张目标人物或者风格的图片,然后使用工具训练出特定人物的LoRA模型,最后使用这个LoRA模型即可生成目标人物在各种场景、各种风格下的逼真图像。

为了更好的艺术效果,我们还可以使用专用的摄影模型、风格模型,搭配精细的提示词,实现特定的艺术效果。

使用 IP-Adapter-FaceId

这里以 Stable Diffusion WebUI 为例,ComfyUI 的使用示例见下文。

因为 IP-Adapter-FaceId 在 SDXL算法中的效果不太好,所以本文将使用 SD 1.5 模型进行演示。

打开“文生图”页面,首先我们需要选择SD基础模型、设置提示词和负向提示。模型下载方式见文末资源下载。

这几个参数我介绍下注意事项:

- SD基础模型:建议选择真实风格、摄影风格的模型,以更加贴近现实;

- 正向提示词:你想要的画面内容,我们可以使用 IP-Adapter-FaceId 的LoRA模型 ,加强图像生成对人物面部特征的识别。

- 反向提示词:不想要的画面内容,因为AI绘画中的人手经常画不好,所以我在这里写一个 hands,让生成的图片中尽量不要出现人手。

然后我们需要设置一些采样参数,采样器大家选择自己常用的即可,这里我使用的是 DPM++ 2M,调度器选择的是 Karras,采样步数 27,这个搭配比较适合细节优化。

其它参数也介绍下:

- 图片的宽度和高度根据自己的需要设置,不要设置的太大,图片越大,生成的越慢。如果特别需要大图,可以在生成完毕之后,再到高清化中进行放大。

- 生成次数:使用当前的参数生成几次。

- 每次数量:每次生成时,同时生成几张图片。显存小不要修改,显存大的同学可以设置的大点。

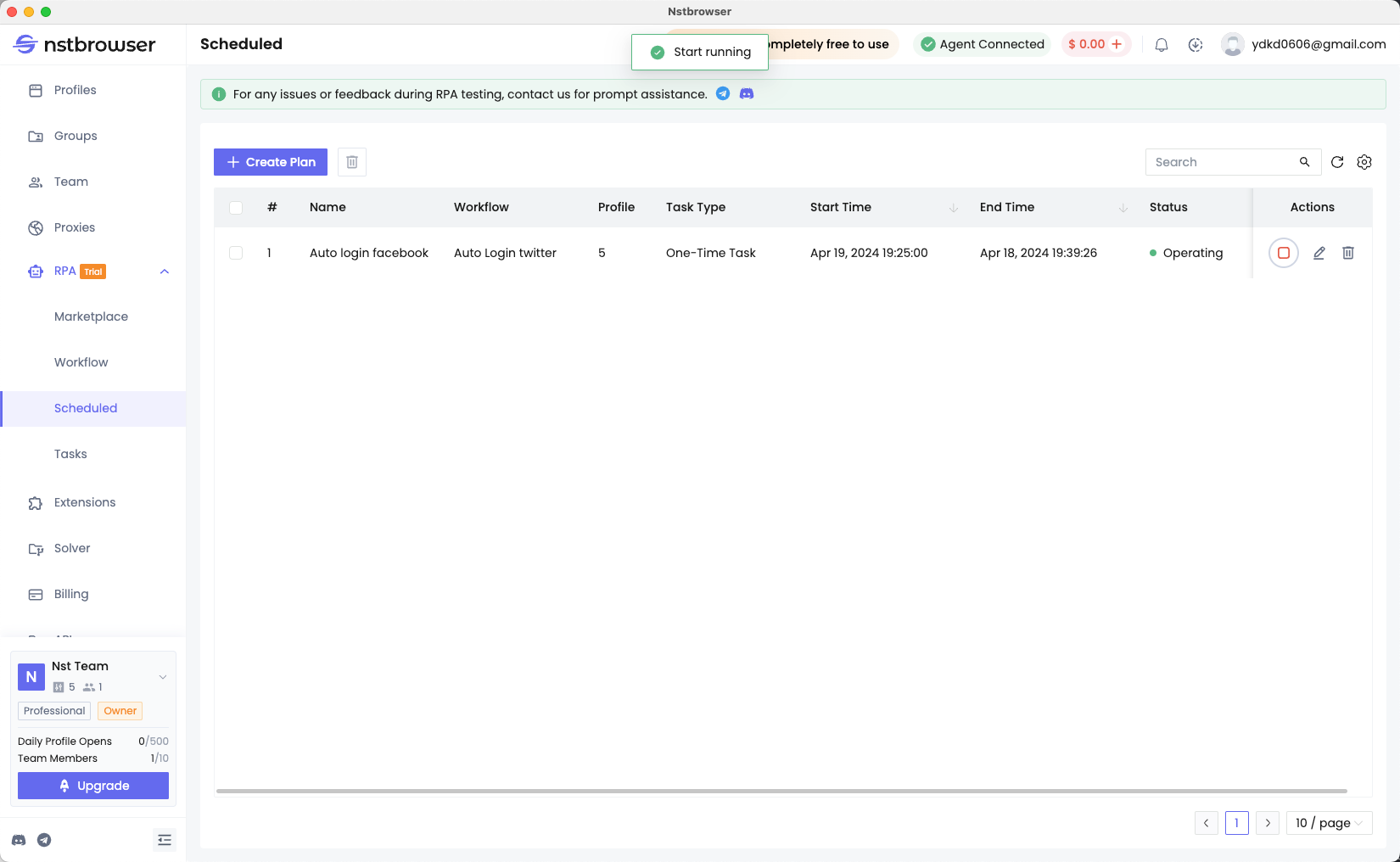

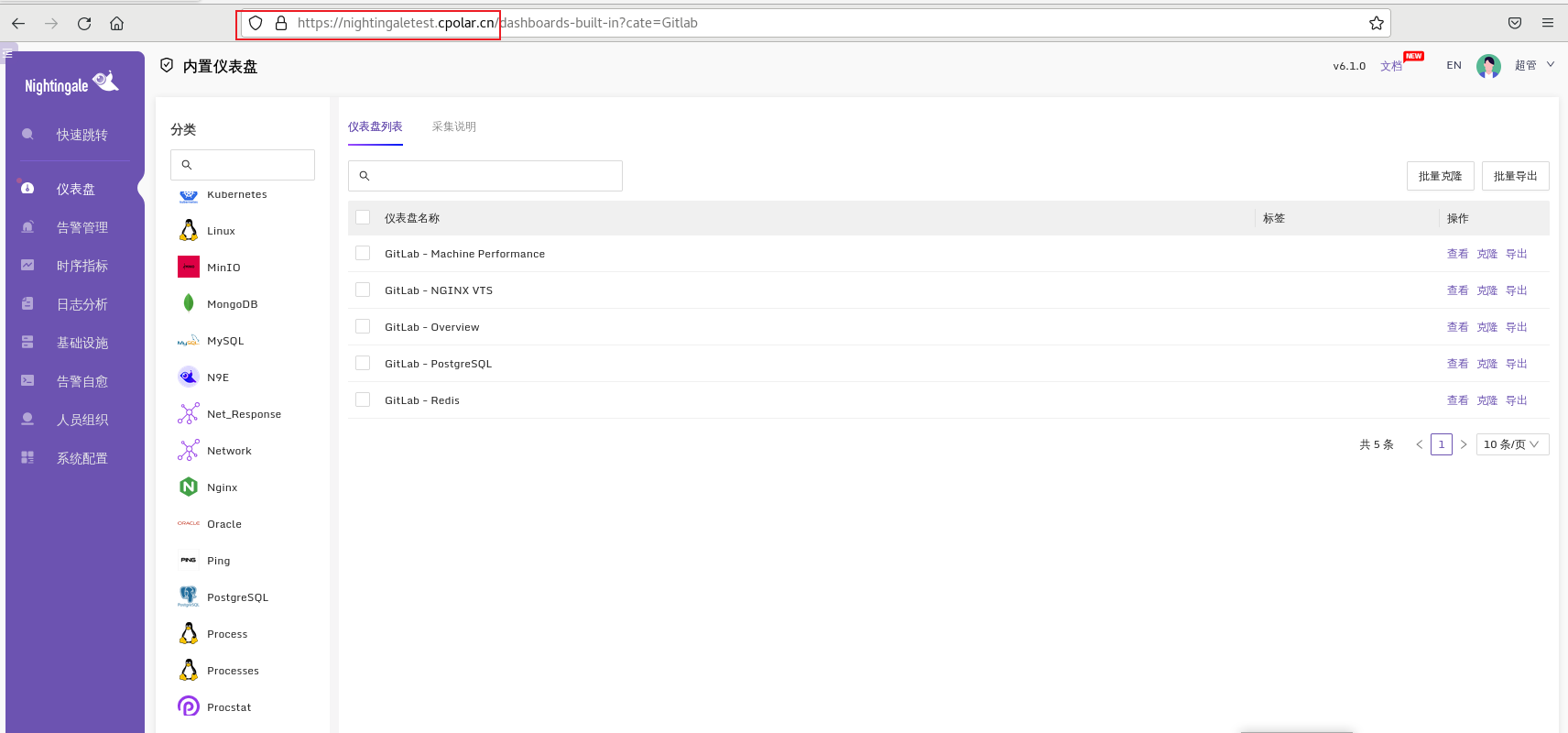

上边已经把 Stable Diffusion 的基础参数设置完了,下边开始设置 IP-Adapter-FaceId 的参数。在 Stable Diffusion WebUI 中,IP-Adapter-FaceId 基于 ControlNet 提供面部特征提取和生成控制。

在“文生图”页面下方,启用一个 ControlNet单元,上传一张参考图片(现在你应该知道效果图中是谁了),如下图所示:

建议每次都勾选“完美匹配像素”,这样可以让ControlNet提取的图片特征更符合生成参数中设置的图片宽度和高度。

接着我们设置 IP-Adapter 的更多参数,如下图所示:

- 控制网络类型:勾选“IP-Adapter”

- 预处理器:选择“ip-adapter_face_id_plus”,如果没有这个预处理器,请更新ControlNet插件到最新版本。预处理器模型需要下载,下载方式见文末。

- 模型:选择“ip-adapter-faceid-plusv2_sd15”,模型需要下载,下载方式见文末。

- 控制权重:ControlNet对生成图片的影响力,值越大生成图片越遵从ControlNet的控制,用于精细控制,一般默认即可。

- 控制步数:在生成图片的第几步介入和退出ControlNet控制,用于精细控制,一般默认即可。

- Weight Type:高级权重参数,可以控制图片的风格和构图迁移效果,比如只迁移构图,或者只迁移风格。因为我们主要参考面部特征,所以这里使用默认的 normal 即可。

最后,我们只要点击“生成”,静待写真图生成就好了。

使用 ComfyUI 工作流

在 ComfyUI 中使用 IP-Adapter-FaceId 时,需要安装一些插件,主要就是这个:github.com/cubiq/Comfy…,不方便访问外网的同学可以到文末下载我整理的资源。

文章编写不易,AI写真的 ComfyUI 工作流目前仅发布在我的AI绘画小册,有兴趣的同学可以点击链接进入:xiaobot.net/post/033402…

后续优质内容、错误修正、重要资源,也会优先发布在这个小册,快人一步,及早加入。

修脸修手

AI绘画生成人物图片有个常见的问题,那就是经常处理不好手部信息,有时候面部也会轻微变形。这里给大家推荐一个插件:ADetailer,可以对面部和手部进行一定的修复,虽然结果也不能做到完美,但是还是有一定的效果。

插件地址:github.com/Bing-su/ade…,可以在 Stable Diffusion WebUI 的插件管理中直接安装,也可以下载后放到插件目录手动安装。不方便访问Github的同学可以到文末下载。

安装后可以在“文生图”和“图生图”页面找到 ADetailer,点击右侧按钮展开设置,我们可以同时设置两个模型,一个用来修脸,一个用来修手,如下图所示:

资源下载

AI写真用到的大模型、LoRA模型、修脸修手模型、ControlNet插件和模型,以及生成的图片(可提取提示词等生成参数),我都已经整理到了网盘中,需要的同学,请发消息“AI写真”到公/众\号“萤火遛AI”,即可领取。

另外希望加入AI写真交流群的同学,请加微信:yinghuojun007,后续会不定期发放一些福利。

云环境体验

我在 AutoDL 的 Stable Diffusion WebUI 镜像已经内置了本文介绍的插件和模型,不用买显卡、不用安装、不用下载,可以直接开启AI写真创作之旅,有兴趣的可以试试。

AutoDL 是我常用的一个AIGC计算平台,GPU型号十分丰富,最重要的还是质优价廉。

镜像地址:www.codewithgpu.com/i/AUTOMATIC…

在镜像地址页面,点击右下角的“AutoDL 创建实例”,按照指引一步步操作即可。

或者也可以在实例创建页面选择社区镜像:yinghuoai-sd-webui-fast ,GPU型号建议选择RTX 3090、4090等,性能强劲,出图速度快。

以上就是本文的主要内容。后续还有多篇关于AI写真的教程,以及各种风格照片的生成参数分享,如有兴趣,请及时关注,以免错过重要信息。

本文转自 https://juejin.cn/post/7379641602619506727,如有侵权,请联系删除。

现在AI绘画还是发展初期,大家都在摸索前进。

但新事物就意味着新机会,我们普通人要做的就是抢先进场,先学会技能,这样当真正的机会来了,你才能抓得住。

如果你对AI绘画感兴趣,我可以免费分享我在学习过程中收集的各种教程和资料。添加下方即可免费领取!

学完后,可以毫无问题地应对市场上绝大部分的需求。

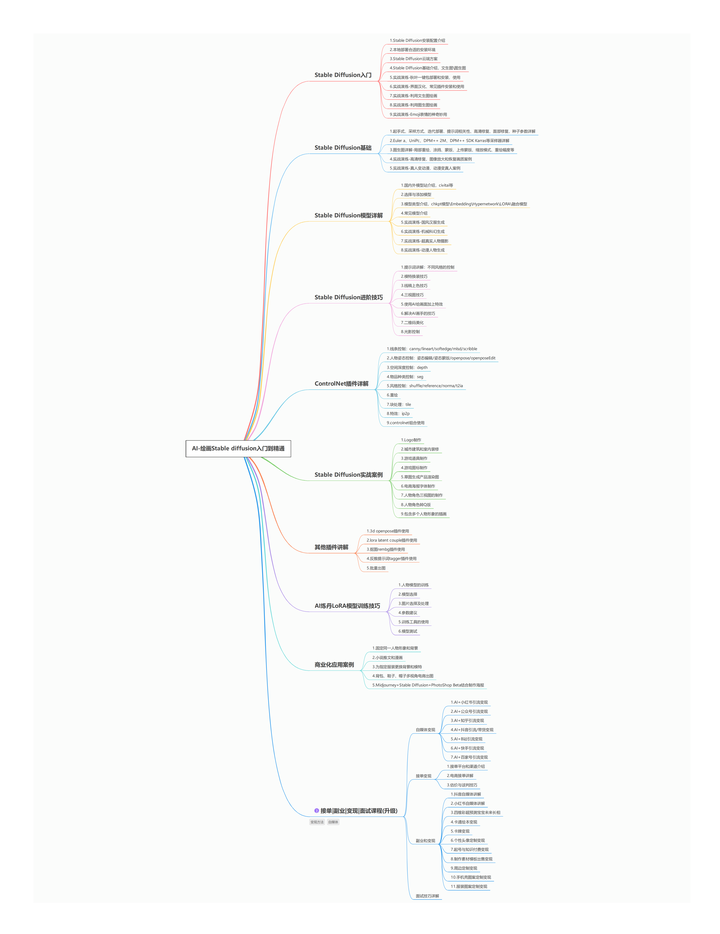

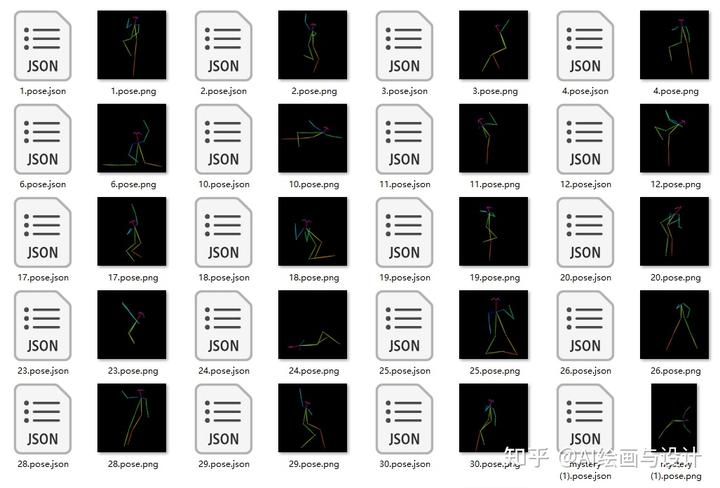

这份AI绘画资料包整理了Stable Diffusion入门学习思维导图、Stable Diffusion安装包、120000+提示词库,800+骨骼姿势图,Stable Diffusion学习书籍手册、AI绘画视频教程、AIGC实战等等。

【Stable Diffusion学习路线思维导图】

【Stable Diffusion安装包(含常用插件、模型)】

【AI绘画12000+提示词库】

【AI绘画800+骨骼姿势图】

【AI绘画视频合集】

这份完整版的stable diffusion资料我已经打包好,点击下方添加即可免费领取!