【Pytorch】一文向您详细介绍 torch.nn.DataParallel() 的作用和用法

下滑查看解决方法

🌈 欢迎莅临我的个人主页 👈这里是我静心耕耘深度学习领域、真诚分享知识与智慧的小天地!🎇

🎓 博主简介:985高校的普通本硕,曾有幸发表过人工智能领域的 中科院顶刊一作论文,熟练掌握PyTorch框架。

🔧 技术专长: 在CV、NLP及多模态等领域有丰富的项目实战经验。已累计提供近千次定制化产品服务,助力用户少走弯路、提高效率,近一年好评率100% 。

📝 博客风采: 积极分享关于深度学习、PyTorch、Python相关的实用内容。已发表原创文章500余篇,代码分享次数逾六万次。

💡 服务项目:包括但不限于科研辅导、知识付费咨询以及为用户需求提供定制化解决方案。

🌵文章目录🌵

- 🚀一、torch.nn.DataParallel() 的基本概念

- 🔬二、torch.nn.DataParallel() 的基本用法

- 💡三、torch.nn.DataParallel() 的深入理解

- 🔧四、torch.nn.DataParallel() 的注意事项和常见问题

- 🚀五、torch.nn.DataParallel() 的进阶用法与技巧

- 📚六、torch.nn.DataParallel() 的代码示例与深入解析

- 🌈七、总结与展望

下滑查看解决方法

🚀一、torch.nn.DataParallel() 的基本概念

在深度学习的实践中,我们经常会遇到模型训练需要很长时间的问题,尤其是在处理大型数据集或复杂的神经网络时。为了解决这个问题,我们可以利用多个GPU并行计算来加速训练过程。torch.nn.DataParallel() 是PyTorch提供的一个方便的工具,它可以让我们在多个GPU上并行运行模型的前向传播和反向传播。

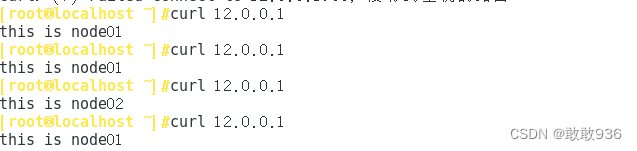

简单来说,torch.nn.DataParallel() 将数据分割成多个部分,然后在不同的GPU上并行处理这些数据部分。每个GPU都运行一个模型的副本,并处理一部分输入数据。最后,所有GPU上的结果将被收集并合并,以产生与单个GPU上运行模型相同的输出。

🔬二、torch.nn.DataParallel() 的基本用法

要使用 torch.nn.DataParallel(),首先你需要确保你的PyTorch版本支持多GPU,并且你的机器上有多个可用的GPU。以下是一个简单的示例,展示了如何使用 torch.nn.DataParallel():

import torch

import torch.nn as nn

# 假设我们有一个简单的神经网络模型

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc = nn.Linear(10, 10)

def forward(self, x):

x = self.fc(x)

return x

# 实例化模型

model = SimpleModel()

# 检查可用的GPU

if torch.cuda.device_count() > 1:

print("使用多个GPU...")

model = nn.DataParallel(model)

# 将模型移动到GPU上

model.to('cuda')

# 创建一个模拟的输入数据

input_data = torch.randn(100, 10).to('cuda')

# 执行前向传播

output = model(input_data)

print(output.shape)

这个示例展示了如何使用 torch.nn.DataParallel() 将一个简单的神经网络模型部署到多个GPU上。注意,我们只需要在实例化模型后检查GPU的数量,并使用 nn.DataParallel() 包装模型。然后,我们可以像平常一样调用模型进行前向传播,而不需要关心数据是如何在多个GPU之间分割和合并的。

💡三、torch.nn.DataParallel() 的深入理解

虽然 torch.nn.DataParallel() 的使用非常简单,但了解其背后的工作原理可以帮助我们更好地利用它。以下是一些关于 torch.nn.DataParallel() 的深入理解:

- 数据分割:

torch.nn.DataParallel()会自动将数据分割成多个部分,每个部分都会在一个GPU上进行处理。分割的方式取决于输入数据的形状和GPU的数量。 - 模型副本:在每个GPU上,都会创建一个模型的副本。这些副本共享相同的参数,但每个副本都独立地处理一部分输入数据。

- 结果合并:在所有GPU上的处理完成后,

torch.nn.DataParallel()会将结果合并成一个完整的输出。这个过程是自动的,我们不需要手动进行合并。

🔧四、torch.nn.DataParallel() 的注意事项和常见问题

虽然 torch.nn.DataParallel() 是一个非常有用的工具,但在使用它时需要注意一些事项和常见问题:

- GPU资源:使用

torch.nn.DataParallel()需要多个GPU。如果你的机器上只有一个GPU,或者没有足够的GPU内存来运行多个模型的副本,那么你可能无法使用它。 - 模型设计:并非所有的模型都适合使用

torch.nn.DataParallel()。一些具有特定依赖关系的模型(例如,具有共享层的RNN或LSTM)可能无法正确地在多个GPU上并行运行。 - 批处理大小:当使用

torch.nn.DataParallel()时,你可能需要调整批处理大小以确保每个GPU都有足够的数据进行处理。如果批处理大小太小,可能会导致GPU利用率低下。

🚀五、torch.nn.DataParallel() 的进阶用法与技巧

除了基本用法之外,还有一些进阶的用法和技巧可以帮助我们更好地利用 torch.nn.DataParallel():

-

自定义数据分割:虽然

torch.nn.DataParallel()会自动进行数据分割,但你也可以通过自定义数据加载器或数据集来实现更灵活的数据分割方式。 -

设备放置:在使用

torch.nn.DataParallel()时,你需要确保模型和数据都在正确的设备(即GPU)上。这通常通过调用.to('cuda')或.cuda()方法来实现。 -

模型参数同步:当在多个GPU上运行模型时,确保所有副本的模型参数在训练过程中保持同步是非常重要的。

torch.nn.DataParallel()会自动处理这个问题,但如果你在实现自定义的并行化逻辑时,需要特别留意这一点。 -

监控GPU使用情况:使用多个GPU时,监控每个GPU的使用情况是非常重要的。这可以帮助你发现是否存在资源不足或利用率低下的问题,并据此调整你的代码或硬件设置。

📚六、torch.nn.DataParallel() 的代码示例与深入解析

为了更深入地了解 torch.nn.DataParallel() 的工作原理,让我们通过一个更具体的代码示例来进行分析:

import torch

import torch.nn as nn

import torch.optim as optim

# 假设我们有一个更复杂的模型

class ComplexModel(nn.Module):

def __init__(self):

super(ComplexModel, self).__init__()

self.conv1 = nn.Conv2d(3, 64, kernel_size=3, stride=1, padding=1)

self.relu = nn.ReLU()

self.fc = nn.Linear(64 * 32 * 32, 10) # 假设输入图像大小为32x32

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = x.view(x.size(0), -1) # 展平特征图

x = self.fc(x)

return x

# 实例化模型

model = ComplexModel()

# 检查GPU数量

if torch.cuda.device_count() > 1:

print("使用多个GPU...")

model = nn.DataParallel(model)

# 将模型移动到GPU上

model.to('cuda')

# 创建损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 模拟输入数据和标签

input_data = torch.randn(64, 3, 32, 32).to('cuda') # 假设批处理大小为64,图像大小为32x32

labels = torch.randint(0, 10, (64,)).to('cuda') # 假设有10个类别

# 训练循环(简化版)

for epoch in range(10): # 假设只训练10个epoch

optimizer.zero_grad()

outputs = model(input_data)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

print(f'Epoch [{epoch+1}/{10}], Loss: {loss.item()}')

这个示例展示了如何使用 torch.nn.DataParallel() 来加速一个具有卷积层和全连接层的复杂模型的训练过程。注意,在训练循环中,我们不需要对模型进行任何特殊的处理来适应多GPU环境;torch.nn.DataParallel() 会自动处理数据的分割和结果的合并。

🌈七、总结与展望

通过本文的介绍,我们深入了解了 torch.nn.DataParallel() 的基本概念、基本用法、深入理解、注意事项和常见问题以及进阶用法与技巧。torch.nn.DataParallel() 是一个强大的工具,可以帮助我们充分利用多个GPU来加速深度学习模型的训练过程。然而,它并不是唯一的解决方案,还有一些其他的并行化策略和技术(如模型并行化、分布式训练等)可以进一步提高训练速度和效率。

随着深度学习技术的不断发展和硬件性能的不断提升,我们有理由相信未来的深度学习训练将会更加高效和灵活。让我们拭目以待吧!