1、人工智能的概念

人工智能概念,在1956年召开的达特茅斯会议上正式被提出。该会议是由信息学鼻祖克劳德.艾尔伍德.香农(ClaudeElwoodShannon)以及马文.明斯基(Marvin Minsky)、约翰.麦卡锡(JohnMcCarthy)等十位信息学、数学、计算机学的科学先驱,在美国东部的达特茅斯召开的一次具有传奇色彩的学术会议。会上首次出现了“人工智能”(ArtificialIntelligence,Al)这个术语,也是在这次会议上,他们决定,将像人类那样思考的机器称为“人工智能”。

提到“人工智能”不得不提的另一个名字,则是享有“人工智能之父”称号的计算机科学家艾伦.图灵(Alan Turing),他在其论文《Computing Machinery and Intelligence》中提出了著名的“图灵测试”,定义了判定机器是否具有“智能”的方法。

2、从统计理论到大模型,人工智能发展的飞跃

达特茅斯会议以后,截至今日人工智能历经了67年的发展,纵观其历史,大致可分为:统计理论、机器学习、深度学习和大模型四个发展阶段。从大模型阶段开始,其对人类意图的准确理解以及内容生成能力,则标志着人工智能从判别式时代,开始走向生成式时代。

3、从Word2Vec到Transformer,NLP技术浅析

在展开讨论GPT大模型之前,我们把时间稍微往前回溯一下,通过一些案例简要回顾一下Word2Vec、Seq2Seq等早期NLP技术,以及大模型的奠基技术:Transformer结构。

1)Word2Vec:

Word2Vec(Word to Vector)即:词-向量转换,是由托马斯.米科洛夫(Tomas Mikolov)等科学家于2013年在论文《Efficient Estimation of Word Representations in Vector Space》中提出的。

Word2Vec是NLP的重要思想,它提出了一种将自然语言的词语转化为“可计算”的向量的方法,这个过程通常称为“嵌入”(embedding)。

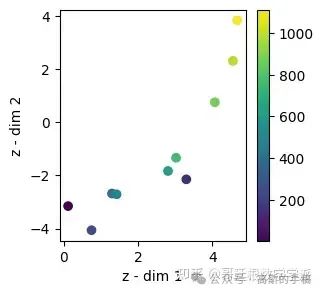

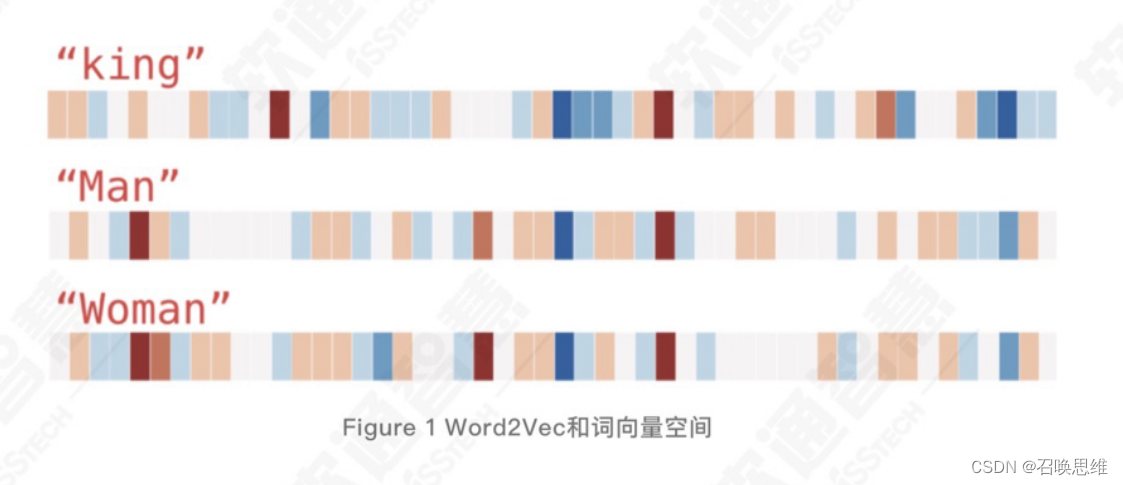

我们来看一个例子,下图将“King”、“Man”和“Women”三个词进行了Word2Vec操作,并对它们的向

量矩阵用颜色进行了可视化,其中每个色块代表一个特征(feature),特征向量用颜色表示:深红色为+2,白色为0,深蓝色为-2。从图中所显示的特征模式我们可以看到,“man”和“woman”两个词的向量矩阵在向量空间中的距离更近(这两个词的语义上相似度更高),而与“king”的距离更远(语义上差异更大)

Word2Vec的表示方法能够将词映射到一个高维的表示语义的空间中,即:词向量空间,使得计算机可以对自然语言进行“理解”和计算。

2)Seq2Seq:

Seq2Seq (Sequence to Sequence),即:“序列到序列”,是伊尔亚.苏茨克维(Ilya Sutskever)等科学家在NIPs 2014发表的论文《Sequence to Sequence Learning with NeuralNetworks》中被首次提出。该论文的一作--一伊尔亚.苏茨克维即现任OpenAI首席科学家,时任GoogleBrain研究科学家。该论文在谷歌学术引用目前已经超过2.1万次,可见其在NLP领域的重要性,在其发表至今近9年的时间里,NLP的发展可以说或多或少受到了该论文思想的影响。

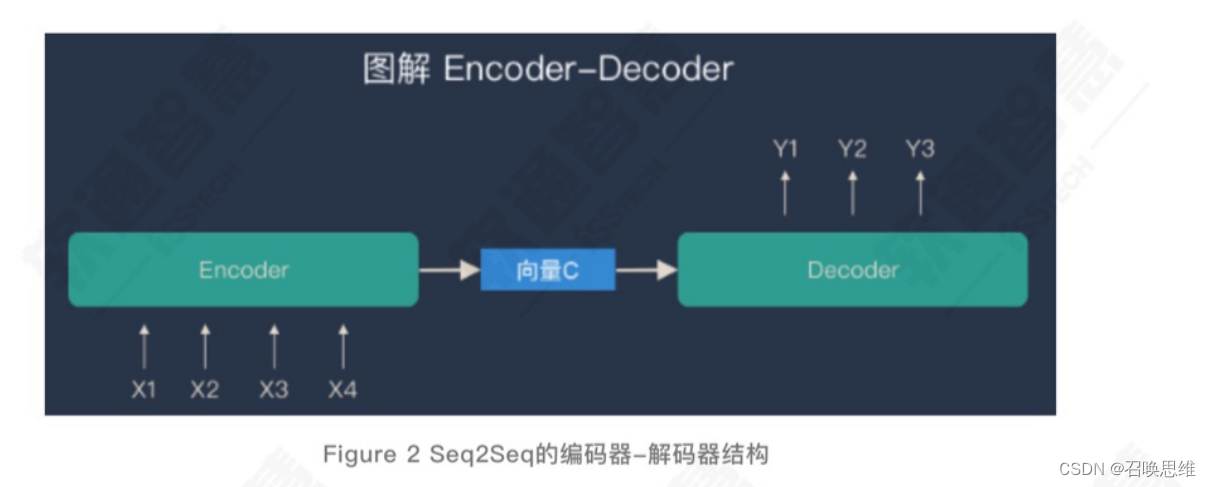

Seq2Seq的思想其实很直观,就是把语言生成任务建模为序列到序列的任务。何为序列?句子就是一个文本序列,模型的输入是一个序列,输出也是一个序列。其提出的初衷,主要是用于翻译任务,后来广泛应用到对话生成、摘要生成等文本生成任务当中。

这种结构的显著特点就是:通过编码器-解码器结构,维系着输入序列和输出序列的一个松散的映射关系,松散主要指,输入输出序列的长度是可变的,且无需严格对应。

在实现Seq2Seq时,根据应用场景和任务不同,我们可以构建不同的编码器和解码器,这也就意味着序列之间的映射方法不同,如:从一种语言映射到另一种语言,是翻译任务;从一个问题映射到一个答案,是问答系统等等。而编码器和解码器的具体实现,可以是NLP的经典结构循环神经网络(RecurrentNeuralNetwork,RNN),也可以是其改良版本长短期记忆网络(Long Short-Term Memory,LSTM),亦或是“注意力”(Attention)机制。

3)Tranformer:

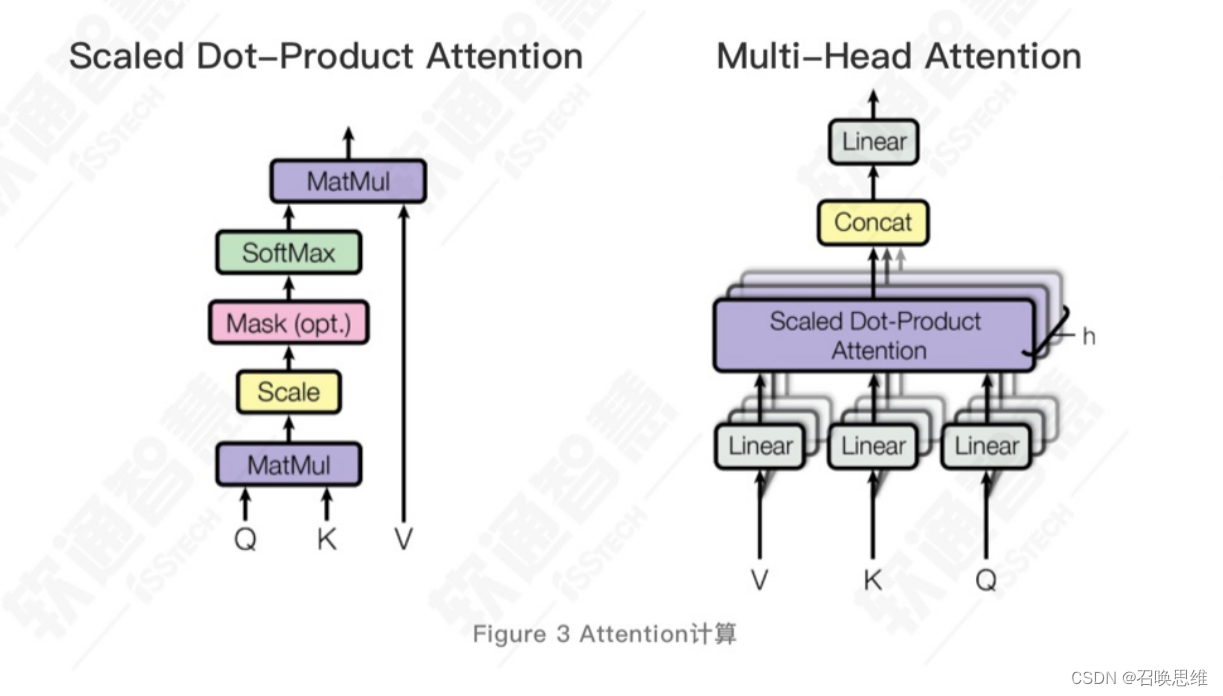

来到这里,一切开始变得熟悉起来:Transformer结构的本质,其实就是Seq2Seq的编码器-解码器模型加上“注意力”机制,该机制和Transformer结构,是谷歌公司翻译团队在2017发表的论文“AttentionIsAllYou Need”中首次提出。而何为“注意力”?简单地说,注意力能够在句子内部计算字词之间的相关性,使序列内部的字词产生关联,以更准确的将字词映射到词向量空间中。我们来看一个例子。假如我们有下面输入语料:

分词之后可以看出来,“聪明的”这个定语是用来修饰“小明”这个主语的。假设“小明”这个主语所对应

的token是一个三维空间(词向量空间实际维度要高得多)R当中的一个点,当我们用“聪明的”这个形

容词来修饰这个主语之后,那这个主语在空间R当中的位置相较于不被定语修饰的token的位置应该是有一定变化的(相当于该词的语境发生了变化,自身的含义也会发生变化)。同理,如果换成“愚蠢的小明”也将类似,将“愚蠢的”所对应的token的信息搬运到“小明”这个主语所对应的token,只是愚蠢的定语将会对“小明”对应的token做负向的修改。

通过“注意力”计算,可以使得模型不仅能够关注当前位置的词,而且能够关注句子中其他位置的词(上下文),从而可以更好的编码这个词,即将其他词的理解融入到当前词中。更重要的一点,通过“注意力”机制的位置编码(Positionalencoding)操作,能够使序列数据离散化,将循环神经网络系模型(RNN和LSTM等)难以并行化训练的问题很好的得以解决(RNN理解文章只能先看前文,再看后文,乱序的看意思不同;“注意力”机制模型可以乱序的看,也可以很多人一起看),从这个意义上看,可以说是“注意力”机制使得大模型的发展成为可能,正如其论文标题所述:Attention Is All You Need。

4)在对Word2Vec、Seq2Seq和Transformer等技术做了一些简单回顾后,我们下面开始对BERT和GPT两类常见的大模型结构展开讨论。

2018年,谷歌公司发布了基于Transformer结构的预训练模型:BERT(BidirectionalEncoder

Representations from Transformers)。作为双向编码器(Encoder) 的Transformer模型变体,BERT以独特的掩码(Mask)方式训练,能力则侧重于阅读理解、完形填空和翻译等任务,得益于

340M(million)的较大参数量,其在机器阅读理解顶级水平测试SQuAD1.1中,全部指标全面超越人类,并且还在11种不同的NLP测试中,创出全部最佳的惊人成绩,其中包括:将GLUE基准测试成绩推升至80.4%(将当时最好成绩提升了7.6%),MultiNLI准确度提高至86.7%(提升了5.6%)等。

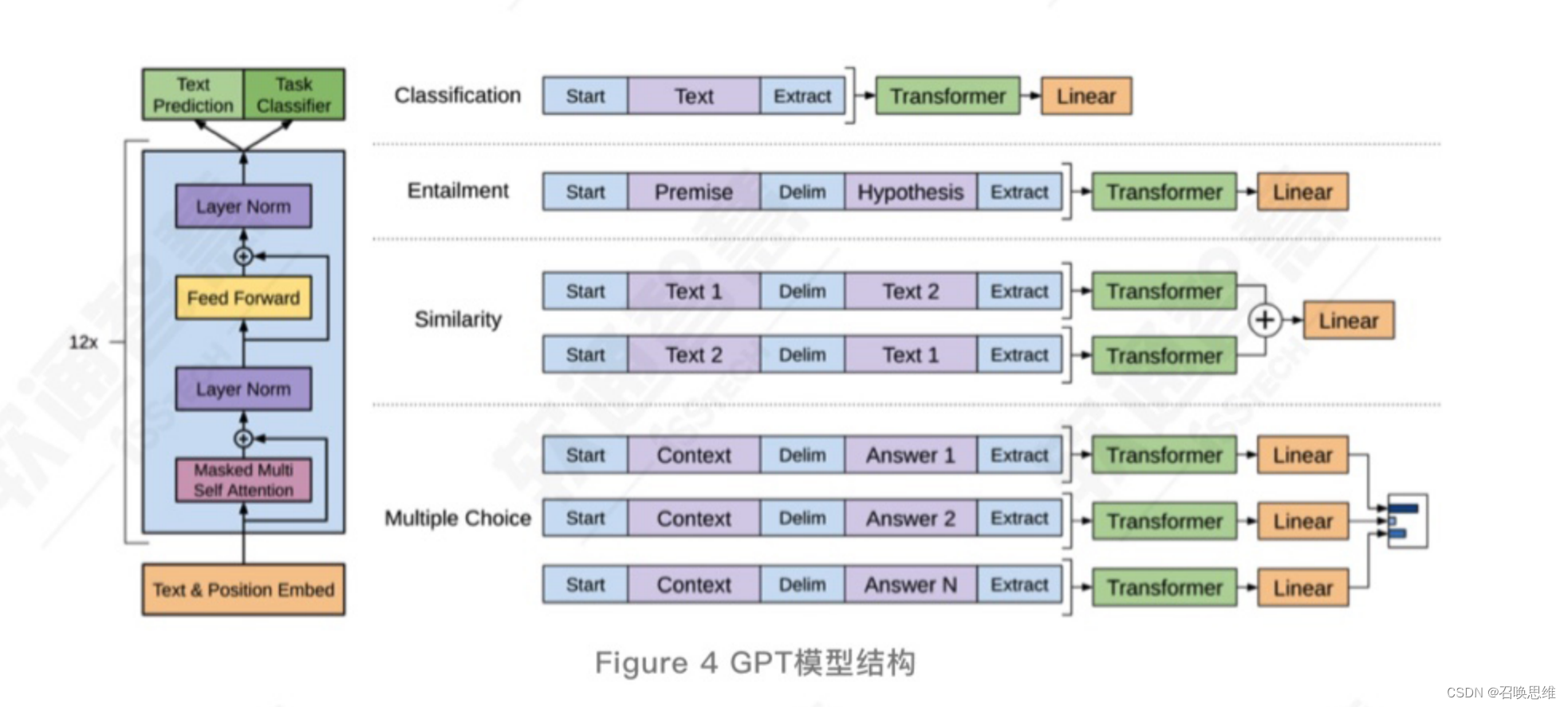

同年,OpenAI公司也发布了基于Transformer的预训练大模型:GPT(Generative Pre-trainingTransformer)。GPT则采用的是单向注意力解码器,构建了一个12层Transformer结构的模型,参数量为1.17亿(117M)。主要用于自然语言理解和生成任务,其注意力计算方向为单向,与人类的阅读、写作的方向一致。

另外,GPT-1还使用了一种半监督的训练方法,即结合了无监督的预训练和有监督的微调实现。该思想与杰弗里.辛顿(GeoffreyHinton)于2006年在《Science(科学)》上发表的奠基深度学习的论文《Reducing The Dimensionality of Data With NeuralNetworks》类似,但做了一些优化,即把无监督预训练的结构,全部使用“注意力”机制代替,这使得预训练模型本身就有较强的泛化能力,通过学习通用的表征就能够以相对固定的代价,获得广泛用于各种下游NLP任务的能力,极大降低了任务微调的成本。

因GPT的单向注意力解码器Transformer结构采用的自回归生成范式,即:其仅考虑上文信息,而不考虑下文信息,与BERT双向注意力编码器的设计理念上有很大的不同,这也使得GPT和BERT两种预训练模型有着不同的能力侧重:

在较小参数量的条件下(数亿级)BERT结构表现出优于GPT结构的NLP性能,但在大参数量条件下

(千亿级),BERT因过拟合现象(Overftting),适应复杂场景的泛化能力逐渐不及GPT结构模型。

因此,尽管GPT初代版本,性能并不及同期的BERT,未产生较大的影响,但经过几轮版本迭代后,于2022年末发布的参数量高达175B(1750亿)的ChatGPT,其认知能力几乎可以与人类媲美,并可使用自然语言完成各种文档甚至计算机代码的编写,而于2023年初发布的GPT-4则新增了对语音、图片等多模态的支持,并在包括GRE、SAT以及AP(AdvancedPlacement)考试中,获得了高于大多数人类的分数。

依托大模型的通用泛化认知水平,将引起对生产力发展、社会形态和人机关系的广泛讨论的同时,势必也将给城市治理带来技术利好,引发城市治理和服务的范式的转变。下面,我们将结合大模型的技术特点,以及软通智慧通过大模型赋能城市治理的案例实践,展开阐述。

4)上下文学习(In-Context Learning)与微调(Fine-tuning)

OpenAl在2020年发表的GPT3论文《Language Models are Few-Shot Learners》中提出了上下文

学习概念。大模型在推理阶段,能够在与用户的上下文会话中,学习并整合相关语境的知识,更精确地完成相应的NLP任务。

上下文学习与微调(Fine-tuning)过程有着本质的不同,微调会通过梯度下降(GradientDescent,GD)和前馈机制(BackPropagation,BP)更新模型参数权重,也就是说,微调学习过程将永久性改变模型的参数权重。

而上下文学习则是将会话的上下文,作为输入序列传递给模型,使得模型更好地关注在某个领域的话题和知识范围,而并不会更新模型的参数本身。

5)人工智能、通用人工智能、大语言模型

2022年11月30日,OpenAl发布大语言模型(LLM,Large LanguageModel))ChatGPT,用户数5天过百万、2个月过亿的成绩,一度刷新纪录成为史上增长最快的应用。ChatGPT的全民爆火揭开了人工智能(Al,ArtificialIntelligence)大模型时代的序幕,也预示着AI 迈向通用人工智能(AGl,ArtificialGeneral Intelligence)的新一轮冲刺。

目前业界对大模型并没有形成明确统一的定义,狭义上可指代大语言模型,基于Transformer 技术框架;广义上则包含了语言、声音、图像、视频等多模态大模型,技术框架也涵盖 StableDiffusion 等。

在大模型出现之前,人工智能通常需要针对特定的任务和场景设计专门的算法模型,能够执行的也是训练数据范围内的单一任务。大模型的突破,关键在于展现出了类人的通用智能“涌现”能力,能够学习多个领域知识、处理多种任务,因此也被称为通用大模型。

具体而言,大模型具备以下特点:

1.参数规模大

大模型的参数规模远大于传统深度学习模型。大模型发展呈现“规模定律”(ScalingLaw)特征,即:模型的性能与模型的规模、数据集大小和训练用的计算量之间存在幂律关系,性能会随着这三个因素的指数增加而线性提高,通俗而言就是“大力出奇迹”。不过“大”并没有一个绝对的标准,而是一个相对概念。传统模型参数量通常在数万至数亿之间,大模型的参数量则至少在亿级,并已发展到过万亿级的规模。如OpenAI的GPT-1到GPT-3,参数量从1.1亿大幅拉升到1750亿,GPT-4非官方估计约达1.8万亿。

2.泛化能力强

大模型能够有效处理多种未见过的数据或新任务。基于注意力机制(Attention),通过在大规模、多样化的无标注数据集上进行预训练,大模型能够学习掌握丰富的通用知识和方法,从而在广泛的场景和任务中使用,例如文本生成、自然语言理解、翻译、数学推导、逻辑推理和多轮对话等。大模型不需要、或者仅需少量特定任务的数据样本,即可显著提高在新任务上的表现能力。如OpenAI曾用GPT-4参加了多种人类基准考试,结果显示其在多项考试中成绩都超过了大部分人类(80%以上),包括法学、经济学、历史、数学、阅读和写作等。

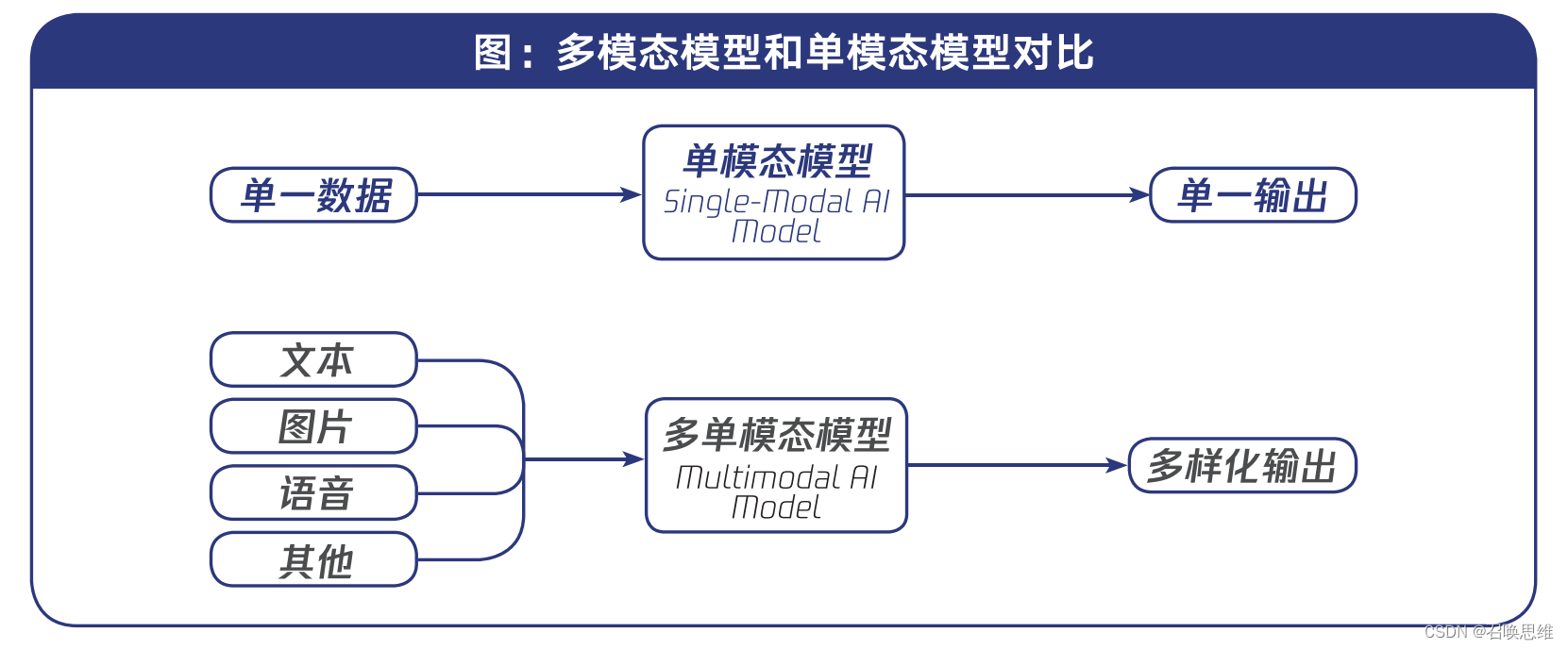

3.支持多模态

大模型可以实现多种模态数据的高效处理。传统深度学习模型大多只能处理单一数据类型(文本、语音或图像),大模型则可以通过扩展编/解码器、交叉注意力(Cross-Attention)、迁移学习(Transfer learning)等方式,实现跨模态数据的关联理解、检索和生成。多模态大模型(LMMs,Large MultimodalModels)能够提供更加全面的认知能力和丰富的交互体验,拓宽AI处理复杂任务的应用范围,成为业界探索迈向通用人工智能的重要路径之一。典型如OpenAI的Sora模型推出,掀起了全球多模态大模型的发展新热潮。

6)从ChatGPT到AI原生

一、 这自然要从 OpenAI 说起,前一年年底,ChatGPT 的横 空出世,标志着对话式 LLM 开始进入公众视野,为人们 提供了全新的人机交互方式。而 2023 年 3 月,同系 GPT-4.0 的发布则将 LLM 的规模和能力提升到一个新 的台阶,为 LLM 的广泛应用奠定了基础。再之后的 11 月份,OpenAI 再发力,GPTs 的到来,“用户自定义 ChatGPT”的能力,更是让世人领略了 OpenAI 作为 LLM 一哥的宏大叙事能力与强劲技术实力。

二、 New Bing(Bing AI)代表了微软在 LLM 领域的野心和 决心,它首次把当时世人能想到最有价值又可行的 LLM 应用场景——“智能对话+联网搜索”——无缝整合了起来, 大有干掉搜索行业和问答社区的趋势,而后事实证明,全 球 最强 IT 问 答社 区 Stack OverFlow 深 受其 害。 Google 紧随其后推出 Bard,作为其首次亮相的对话 LLM 产品,无疑具有其里程碑意义,尽管它的首秀并不尽如人意,车翻了又翻。

三、 Claude 2、PaLM 2、Llama 等模型与产品也展现了 LLM 在语言理解和多模态处理能力方面的探索,甚至 Claude 2 还一度被誉为实力可以硬刚 ChatGPT。而 Meta 开源的 Llama 2 更成为了 LLM 领域开源势力的典型代表,它的出现,犹如一颗投入平静湖面的石子,激荡起层层水波, “Llama 2 一开源,全球范围内进入了百模混战阶段”, 这个说法一点也不为过。 年底的“虚假宣传” Gemini 与“磁力链开源” Mistral 8x7B 两大神作,也凭借不输 GPT-4 的实力,将 LLM 狂 潮卷到天际。

四、 Stable Diffusion 和 Midjourney 这两大图像生成系统 的出现,极大地拓展和加速了 LLM 在计算机视觉领域的应 用,它们突破了传统图像生成方式的局限,仅需要用户提供 文字描述,就可以生成高质量的数字艺术作品。它们的图像 生成质量、样式多样性和用户便捷性都是极大的突破。这为 广大的个人用户和创意行业提供了强有力的工具,彻底改变 了数字艺术内容的创作方式。同时,它们也引发了人工智能 在创作领域的伦理和法律讨论。LLM 杀进多媒体领域。往 后 DALL-E 3 模型升级、Adobe 产品整合 LLM 能力、 语音模型 whisper-3 更新、AI 虚拟主播创造等,都是在 这条路上的进一步发展。

五、 AI 编程方面,Copilot 可以根据开发者的代码提示自动补 全代码,大大提高了开发效率。这也引发了代码原创性的讨 论,但它已经实实在在将 LLM 拉进了编程应用领域。

六、 LangChain 的出现,实现了 LLM 之间的链式交互,使多 个 LLM 模型串联工作,发挥各自的优势,并且可以将 LLM 模型与外部数据源进行连接,产生更强大的语言理解 和生成效果。这开启了 LLM 集成应用的新方向,并诞生了 一个新的细分领域“LLMOps”。

七、 “提示词工程”,这是 LLM 直接催生出来的新“学科”, 它的核心在于研究人类如何与 LLM 更好地进行“沟通”, 找到让 LLM 能够准确理解人类意图的方法。提示词工程探 索如何以 LLM 可以解析的方式来表达需要它完成的任务, 寻找 LLM 的“最佳输入形式”。通过注入提示词,提示词 工程建立了一套“人机交互语法”,来更精准地向 LLM 传 达想要它生成何种输出的指令。这为人们与 LLM 之间建立 高效、准确的“沟通桥梁”提供了可能性。什么“链式思考(CoT)”、“自动推理并使用工具(ART)”、“思维 树(ToT)”……甚至运用心理学对 LLM 进行“情绪提 示(EmotionPrompt)”,提示词工程俨然在将 LLM 一 点一点解剖,试图让人类成为可以将其掌控的“咒术师”。

八、 AutoGPT 的出现,带着 LLM Agent 的概念进入 LLM 发展的新阶段。LLM Agent 是一种基于 LLM 的智能代 理,它能够自主学习和执行任务,具有一定的“认知能力 和决策能力”。LLM Agent 的出现,标志着 LLM 从传 统的模型训练和应用模式,转向以 Agent 为中心的智能 化模式。LLM Agent 打破了传统 LLM 的被动性,使 LLM 能够主动学习和执行任务,从而提高了 LLM 的应用 范围和价值;它为 LLM 的智能化发展提供了新的方向, 使 LLM 能够更加接近于人类智能。

九、 AI 原生,目前还没有明确的定义,大致是说,不同于当前 各种应用在原本的基础上增加 AI 能力,使其智能化,但 它的智能只充当了“辅助”角色;在 AI 原生的语境下, LLM 从一开始就是应用的中枢,应用本身的架构、功能、 交互层是围绕 LLM 中枢来构建的。也许 ChatGPT 是最经典的“AI 原生”应用。此概念目前还处在萌芽期,明确 的概念、应用场景、架构、技术栈细节等尚未完成自洽。 换一种视角来看,这个概念的提出其实都没技术什么事, 有人称之为“造商业概念”,这里按下不表。

十、 相比国际上当前逢 AI 必 GenAI,国内更 多地还是在 LLM 这一层面,Robin Li 的“卷大模型没意 义,卷应用机会更大”,其实很深刻地指出了内中区别。大模型方面,百花齐放:百度的文心一言、抖音的云雀大模 型、智谱 AI 的 GLM 大模型、中科院的紫东太初大模型、 百川智能的百川大模型、商汤的日日新大模型、MiniMax 的 ABAB 大模型、上海人工智能实验室的书生通用大模型、腾讯的混元大模型、蚂蚁的百灵大模型等。 另一方面,除了大模型本身,中国在 LLM 相关技术领域也快速迭代发展,诸如 Dify.AI 的 LLMOps、Milvus 的向量 数据库、CodeGeeX 与 Comate 的 AI 编程、对 LLM Prompt 的研究、OneFlow 的深度学习框架。

值得一提的还有华为的盘古大模型,其中盘古气象大模型是 首个精度超过传统数值预报方法的 AI 模型,速度相比传统 数值预报提速 10000 倍以上,能够提供全球气象秒级预 报。盘古大模型的研究成果在国际顶级学术期刊《自然》正 刊发表,获得国际学术界的认可。 年底,零一万物推出的 Yi 模型,200K 上下文窗口,可处 理约 40 万字的文本,成为当时全球大模型中最长的上下文 窗口。其中 Yi-34B 在 Hugging Face 英文测试榜单中位 列第一,在 C-Eval 中文能力排行榜中超越所有开源模型。

7)机器学习、深度学习、循环神经网络、卷积神经网络、Transformer、GPT、BERT

1、机器学习 (Machinelearning),作为人工智能的一个分支,是指不需要进行显式编程,而由计算系统基于算法和数据集自行学习,做出识别、决策和预测的过程。

2、深度学习 (Deep learning) 是机器学习 (Machine learning) 中的一类算法,指利用多层神经网络,模仿人脑处理信息的方式从原始输入中逐步提取和表达数据的特征。

3、循环神经网络 (Recurrent Neural Network,RNN) 是具有时间联结的前馈神经网络(Feedforward Neural Networks),特点是必须按顺序处理,并且上一层的神经细胞层输出和隐藏状态具有较大的权重影响下一层的运算。循环神经网络必须完成上一步才能进行下一步,只能串行不能并行,因此循环神经网络具有“短时记忆”的特点,技术上把这个现象称为梯度消失或梯度爆炸,循环神经网络不擅长处理和捕捉长文本中的语义。

4、卷积神经网络 (Convolutional Neural Networks,CNN) 是一类包含卷积计算且具有深度结构的前馈神经网络 (Feedforward Neural Networks), 是深度学习 (Deep learning) 的代表算法之一。

5、Transformer 是一种基于注意力机制的序列模型,最初由 Google 的研究团队提出并应用于机器翻译任务。

6、Word2vec是一群用来产生词向量的相关模型。这些模型为浅而双层的神经网络,用来训练以重新建构语言学之词文本。

7、GPT,全称Generative Pre-Trained Transformer( 生成式预训练Transformer 模型 ),是一种基于互联网的、可用数据来训练的、文本生成的深度学习模型。

8、BERT(Bidirectional Encoder Representations from Transformers)是一种预训练的深度学习模型,用于自然语言处理任务,基于 Transformer 架构的双向编码器,通过无监督的学习方式预训练语言表示,以便能够捕捉语言的上下文信息。

9、人工智能:Artificial Intelligence,英文缩写为AI。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。人工智能是计算机科学的一个分支,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器。

10、AGI:Artificial General Intelligence,专指通用人工智能。这一领域主要专注于研制像人一样思考、像人 一样从事多种用途的机器。这一单词源于 AI,但是由于主流 AI 研究逐渐走向某一领域的智能化(如机器视觉、语音输入等),因此为了与它们相区分,增加了general。

11、生成式AI:AI-Generated Content,人工智能生成内容,是指基于人工智能技术,通过已有数据寻找规律, 并通过适当的泛化能力生成相关内容的技术,可以生成常见的如图像、文本、音频、视频等内容。

12、LLM:Large Language Model,大型语言模型,用深度学习算法处理和理解自然语言的基础机器学习模型,可以根据从海量数据集中获得的知识来识别、总结、翻译、预测和生成文本和其他内容。

13、NLP:Natural Language Processing,自然语言处理,是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法,主要应用于机器翻译、 舆情监测、自动摘要、观点提取、文本分类、问题回答、文本语义对比、语音识别、中文 OCR 等方面。