乳腺癌是重大的公共卫生挑战,需要有效的诊断方法。虽然超声、乳房 X 线照相和 MRI 仍然至关重要,但它们在定期、短间隔大规模筛查中的实用性有限。

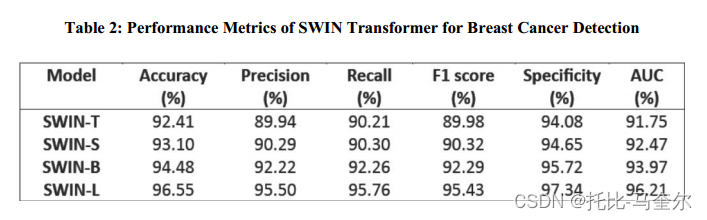

热成像作为一种非侵入性且经济有效的选择,具有常规自我筛查的潜力。本研究利用基于自注意力的 Vision Transformer 设计代替传统的 CNN,探索了用于乳腺癌检测的各种 SWIN 变压器变体和增强策略。使用 DMR-IR 基准数据集,将其划分为训练、测试和验证子集,比例为 70:15:15,获得的结果显示出巨大的前景。SWIN-L 架构表现出色,准确率达到 96.55%,精确度达到 95.50%,召回率达到 95.76%,F1 分数达到 95.43%,特异性达到 97.34%,AUC 达到 96.21%,从而展示了其在乳腺癌检测方面的卓越能力。

1. 引言

乳腺癌其根源包括基因组变化、荷尔蒙失衡和生活方式选择等因素 [1]。这种复杂疾病的进展与环境诱因和激素引起的 DNA 改变有关,导致其成为女性死亡的主要原因 [2]。快速诊断仍然至关重要,因为康复率会根据疾病阶段而波动。 每年一次的乳腺癌筛查对于早期发现和降低死亡率至关重要,超声成像因其可访问性、实时功能和成本效益而成为有前途的盟友。

医学影像中自动分析的集成有助于放射科医生识别肿块并减少假阴性,从而提高诊断准确性。5% 至 10% 的病例与 BRCA1 和 BRCA2 基因的遗传突变有关,它们与早期乳腺癌的相关性凸显了遗传影响的重要性 [4]。虽然成人接触毒素和辐射等物质会损害这些基因,但放射科医生可以利用他们的专业知识进行基于图像的鉴别诊断。热成像技术提供非侵入性和无辐射成像,为研究提供了一条有趣的途径,尤其是考虑到它在检测指示癌变组织的温度差异方面的潜力 [5]。

随着抗击乳腺癌的进展,人们提倡采用多种成像方式(包括乳房 X 线摄影和热成像)的多方面方法,它们的综合优势有助于提高早期检测率 [6]–[8]。 卷积神经网络 (CNN) 是深度学习的基石,已广泛应用于自动医学图像分析,尤其是在图像分类等任务中。 然而,由于局部感受野,它们在捕获远程信息方面存在固有的局限性,这给更复杂的视觉任务带来了挑战 [4]。深度学习算法中神经网络层的融合有望提高基于成像的分类器的医疗应用准确性 [10]。一个关键障碍是医学领域缺乏全面均衡的训练数据,再加上类别不平衡问题。值得注意的是,像 VGG-16 这样的架构以 CNN 为基础,在 ImageNet 等数据集的一般图像分析中表现出了显著的效果。

将 CNN 用于医学图像已经取得了令人鼓舞的成果,尤其是与关注显著区域的注意力机制结合使用时,可以有效提高算法性能 [9],[11]。虽然乳腺癌诊断的先前研究涵盖了热成像、肿瘤表征和图像采集协议等方面。最近深度学习技术(尤其是 CNN)的整合已显示出巨大的潜力。这种转向使用 CNN(甚至用于热图像)的转变表明,与传统的纹理或统计特征相比,人们越来越认识到 CNN 的有效性,尽管考虑到计算复杂性 [2]。

在动态深度学习领域,Transformer 架构最初由 Vaswani 等人为自然语言处理 (NLP) 量身定制,现在已启发了 Dosovitskiy 等人 [13] 提出的用于图像分类的 Vision Transformer (ViT) 方法。这种创新方法涉及将图像分割成类似于 NLP 单词的块,并由自关注模块加以利用,在重塑图像分析方面显示出巨大的前景 [14],[15]。开创性研究将 Transformer 方法扩展到热图像分析,特别关注使用不同块大小的自窗口 (SWIN) Transformer [16] 模型对乳房热图像 (热图) 进行分类。

2. 相关工作

通过对当前通过热成像检测乳腺癌的现状进行全面回顾,进行了文献调查,共获得 42 篇相关论文。通过对摘要和标题的仔细审查,排除了 32 篇不相关的论文,从而将 10 篇文章纳入本研究。这些选定的论文展示了机器学习和深度学习方法在热成像图像中的应用,主要侧重于乳腺癌检测。在随后的部分中,讨论围绕已确定的利用人工智能技术在热成像背景下检测乳腺癌的文章展开。

红外热成像能够通过选择性增强含有致密组织的区域内的对比度来超越与乳房 X 线摄影技术相关的限制,这对于解决年轻女性带来的成像挑战特别有利 [17]。Ekici 等人 [18] 提出了一种新算法,用于从生物数据、图像分析和图像统计的组合中提取特征。通过使用经过贝叶斯算法微调的卷积神经网络 (CNN),研究人员成功地将热成像图分为两组:表示正常情况的组和可疑组。设计的方法产生的结果显示出令人印象深刻的 98.95% 的准确率,展示了他们提出的算法在准确分类热成像数据方面的有效性。Husaini 等人 [19] 使用 Inception V3、Inception V4 和定制的 Inception MV4 模型开发了新的分类器,将来自 DMR 数据库的热成像图分为健康和患病组。对图像采用模糊、摇晃、倾斜和翻转等变换以提高准确度,研究表明,Inception V3 在灰度图像中的表现优于 V4 和 MV4,显示出更高的准确度。

在 Kakileti 等人 [20] 引用的研究中,研究了各种 CNN 架构,用于语义分割,重点是检测热图像中的热点。 研究结果表明,尽管热图像数据集有限,但与基于块的分类器相比,编码器解码器架构在准确性方面表现出色,可以有效识别热图像中的热点。

在 Krawczyk 等人 [21] 的研究中,引入了一种技术,通过使用多分类器系统来处理不平衡数据集,该系统以一组不对称特征为中心。该方法应用于 150 个热图,并在不同的对象子空间上训练了不同基础分类器的集合。 值得注意的是,最佳结果实现了 90.03% 的准确率、80.35% 的灵敏度和 90.15% 的特异性,凸显了该方法在解决不平衡数据集挑战方面的有效性。

Garia 等人 [22] 使用了 ViT 的不同变体,并表明 ViT 模型在乳腺癌检测方面的表现优于最先进的 CNN。Alia 等人 [23] 在他们的研究中使用 DMR-IR 数据集探索了具有注意力机制的 CNN 在检测热乳腺癌图像方面的潜力。提出了一种新模型,并评估了其准确率、灵敏度和特异性,结果优于现有方法。带有 AM 的 CNN 的测试准确率分别为 99.46%、99.37% 和 99.30%,与没有 AM 的 CNN 相比,准确率提高了 7%,超越了之前的模型。

在 [24] 中,引入了一种新颖的 CNN 架构,该架构从 U-net 结构中汲取灵感,用于对包含肿块和宏观钙化实例的乳房 X 线摄影数据集进行分类。 在对 692 张肿块图像和 603 张宏观钙化图像的组合数据集进行训练后,该模型实现了令人印象深刻的 94.31% 的准确率。随后在包含 202 张肿块图像和 152 张宏观钙化图像的单独数据集上进行的测试再次证实了其强大的性能。

在 [25] 中,通过添加自注意力机制对收集的 18,157 张乳房 X 光检查图像进行分类,并引入了新的基准数据集,CNN 的性能得到了增强。与以前的研究相比,该模型表现出了更优异的性能,准确率达到了 92.17%。

在另一项研究 [26] 中,引入了一种基于 CNN 的新方法,该方法结合了两个不同的注意单元来增强特征学习,以对来自 BreakHis 数据集的 7909 张组织病理学图像进行分类。该方法在 100 倍放大率下实现了出色的 98% 准确率,明显优于同一数据集上的近期方法。本研究旨在探索在使用热成像检测乳腺癌的背景下利用 SWIN 变换器的潜在好处,该变换器以比 ViT [16] 更高效的计算而闻名。

3. 材料和方法

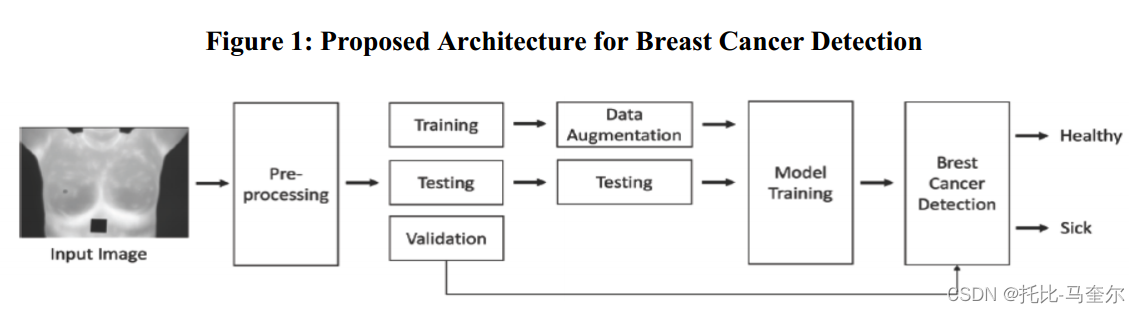

引入了一个基于 Transformer 的框架,用于使用热成像图像检测乳腺癌。为了提高模型的性能,我们采用了数据增强技术。图 1 概述了我们提出的系统的关键步骤。

3.1 数据集

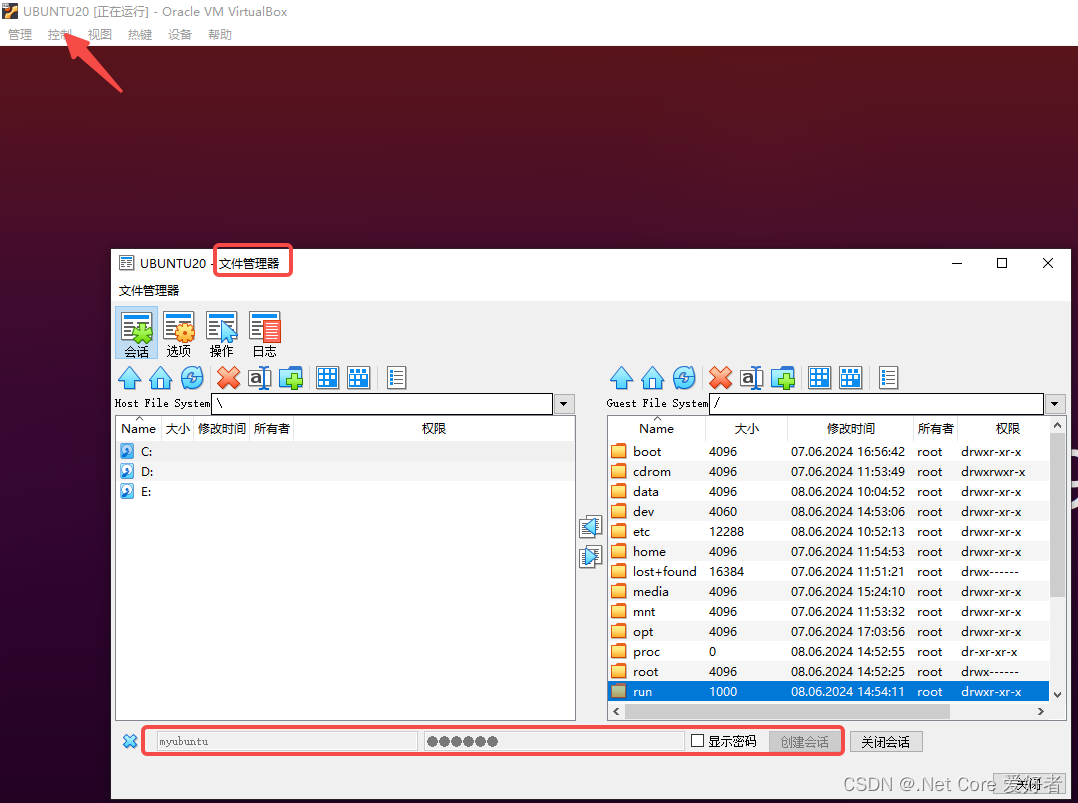

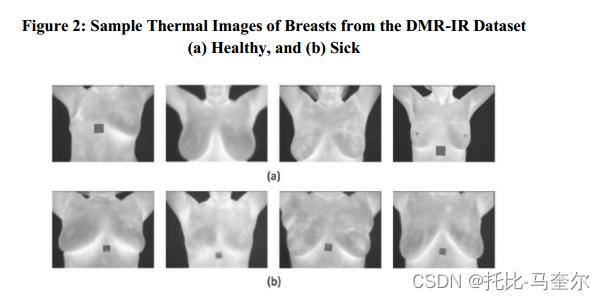

利用了来自公认的基准数据集 DMR-IR [27] 的热成像图像。研究特别结合了从该数据集中提取的正面热成像图像,共包含 290 名患者的数据。这些热图像是使用 FLIR SC-620 红外摄像机捕获的,分辨率为 640 × 480 像素。该数据集包含各种乳房形状和大小,如图 2 所示,共包含 185 张健康和 105 张患病图像供分析。

3.2 数据预处理

数据集被细分为三个独立的集合:训练、测试和验证。70% 的数据用于训练,15% 用于测试,另外 15% 用于验证。为了增强所提算法的整体泛化能力,所有图像都调整为 224 × 224 像素大小。

3.3 数据增强

通过数据增强,深度学习方法中的泛化难题得到了有效解决。该技术使神经网络能够掌握各种图像变化,并将其洞察力扩展到以前从未遇到过的图像,同时降低小数据集过度拟合的风险。为了实现这一点,对每幅图像应用了以下操作:

- 缩放:对图像尺寸进行随机抽样缩放,范围从 70% 到 120%

- 旋转:旋转,涉及图像在顺时针和逆时针方向上在 0 到 15 度的范围内旋转

- 水平翻转:水平翻转,以50%的概率实现图像水平翻转

- 垂直翻转:垂直翻转,以50%的概率实现图像垂直翻转

3.4 Swin Transformer

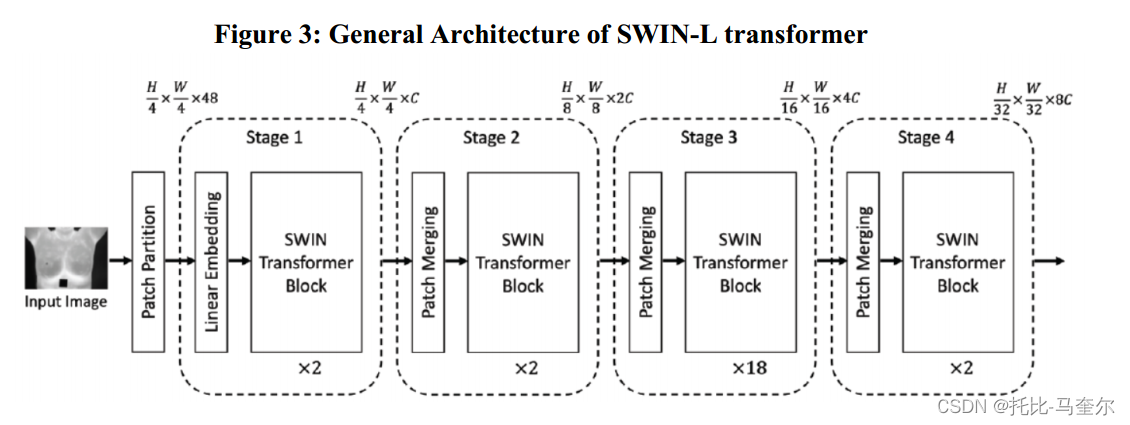

SWIN Transformer 为各种计算机视觉任务提供了一个多功能框架。这种分层 Transformer 采用一种独特的方法,使用移位窗口计算表示。这项创新通过将自注意力计算限制在非重叠的局部窗口,同时仍促进窗口间连接,提供显著的计算效率。Swin Transformer 的分层结构使其能够有效地对各种尺度的图像特征进行建模,使其非常适合一系列任务。它在推理过程中的线性计算复杂性增加了它的吸引力,尤其是对于分类任务。图 3 显示了 SWIN-L Transformer 的总体架构。SWIN Transformer 的突出特点在于它利用移位窗口来处理图像块,这种技术增强了模型识别具有任意平移的图像块的能力。以下是两个关键方面:

- 分层特征图:Swin Transformer 的分层特征图构建是通过一系列块合并操作实现的。这些操作涉及相邻 2×2 块的特征融合,通过线性变换有效减少标记数量,同时将维度加倍。随着网络深度的增加,特征图的分辨率逐渐增加。值得注意的是,自注意力计算是在非重叠窗口内本地进行的,确保计算复杂度保持线性缩放模式。

- ShiPed Windows:与执行全局自注意力计算、产生二次计算复杂度的传统 ViT 模型相比,Swin Transformer 采用了独特的方法。它动态地在分层特征图内的连续层之间移动窗口分区,从而促进局部和非重叠窗口内的自注意力计算,确保线性计算复杂度。这种方法显著提高了计算效率,同时保持了强大的性能。图 4 显示了两个连续的 SWIN Transformer 块。

W-MSA (Window based Multi-head Self-attention): 基于窗口的多头自注意力是一种自注意力机制,它将输入划分为固定大小的窗口,并在每个窗口内独立地应用自注意力。这种方法允许模型同时关注局部和全局上下文信息。

SW-MSA (Shifted Window based Multi-head Self-attention): 基于平移窗口的多头自注意力是W-MSA的一种变体,它通过将窗口在输入序列上平移来捕获不同位置的上下文信息。这有助于模型学习更广泛的依赖关系。

4. 结果和讨论

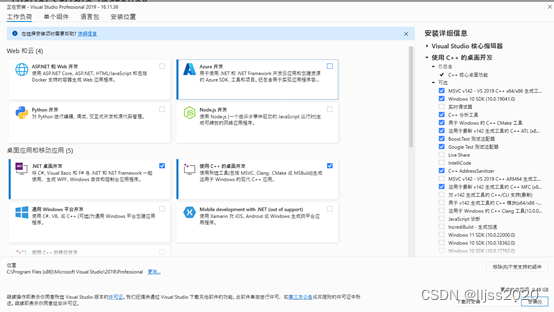

本文对 Swin Transformer 进行了全面的比较分析,其所有变体包括 SWIN-T (SWIN-tiny)、SWIN-S (SWIN-small)、SWIN-B (SWIN-base) 和 SWIN-L (SWIN-Large) 均已实现用于乳腺癌检测。表 1 列出了每个 SWIN Transformer 变体的具体信息,例如窗口大小、隐藏层数量以及每个阶段的块数量。

5. 结论和未来工作

热成像是一种有效的诊断工具,利用了红外技术。在本文中,我们提出了一种完全自动化的乳腺癌检测系统,包括两个主要阶段。首先,调整热图像的大小以提高计算效率,然后部署 Swin Transformer 进行分类。实验结果展示了 SWIN-L 变换器的卓越性能,准确率接近 96%,精确度 95%,召回率 96%,F1 得分 95%,特异性 97%,AUC 96%。