动手学深度学习28 批量归一化

- 批量归一化

- 代码

- 从零实现

- 调包简洁实现

- QA

https://www.bilibili.com/video/BV1X44y1r77r/?spm_id_from=autoNext&vd_source=eb04c9a33e87ceba9c9a2e5f09752ef8

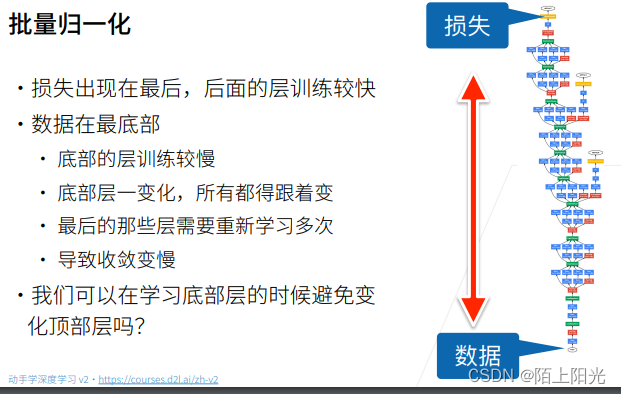

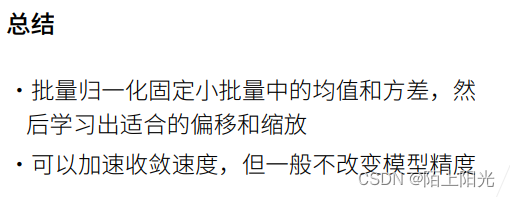

批量归一化

n个比较小的数相乘,值会越来越小。

批量归一化:在改变底部网络特征的时候,避免顶部网络不断的训练。

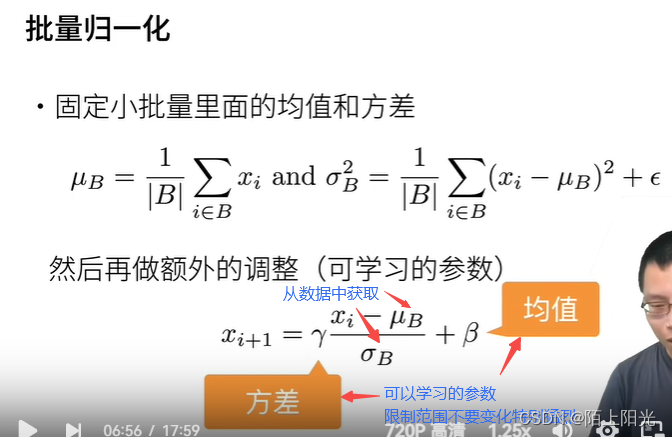

尝试把小批量在不同层输入数据的均值和方差固定住。

B:小批量的大小。

批量归一化带来的东西:

-

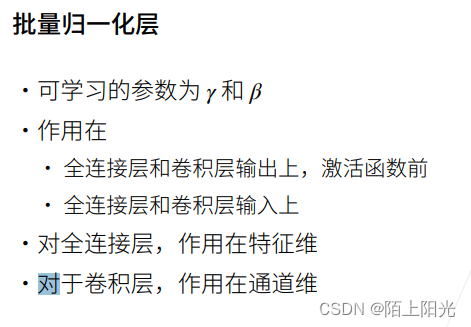

是个线性变换 让均值方差比较好,让变化不那么剧烈

-

把 批量大小* 高 * 宽=样本大小,那通道维就是特征维, 1*1的卷积也是这样做的。

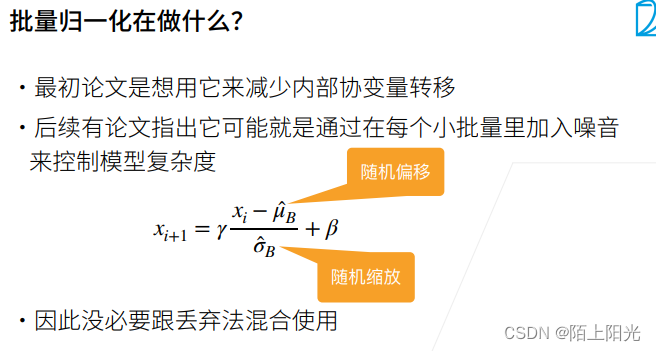

认为从数据中计算的均值方差是噪音。是控制模型复杂度的一个方法。

-

偏移和缩放拟合均值和方差。

-

加速收敛,允许用更大的学习率做训练。把每一层的输入均值方差都在一个层面,学习率可以用较大的。不会因为学习率过大导致梯度爆炸【上层网络】,学习率过小而无法收敛的问题【底层网络】。

代码

从零实现

import torch

from torch import nn

from d2l import torch as d2l

# gamma, beta 可以学的

# moving_mean, moving_var 整个数据集的【全局】均值方差 推理时用

# eps 一个很小的值,避免除0的东西, 一般固定值尽量不要改动 常见设定 eps=1e-5

# momentum 用于更新moving_mean, moving_var的变量 0.9

def batch_norm(X, gamma, beta, moving_mean, moving_var, eps, momentum):

# 通过is_grad_enabled来判断当前模式是训练模式还是预测模式

if not torch.is_grad_enabled():

# 如果是在预测模式下,直接使用传入的移动平均所得的均值和方差

# 不用批量而是用全局的均值方差,是因为一个批量可能是一个样本没有均值方差。

# 推理用全局的mean var

X_hat = (X - moving_mean) / torch.sqrt(moving_var + eps)

else:

# 输入shape是二维或者是四维

assert len(X.shape) in (2, 4)

if len(X.shape) == 2:

# 使用全连接层的情况,计算特征维上的均值和方差

mean = X.mean(dim=0) # 按行求均值 每一列求均值 均值是一个1*n的行向量

var = ((X - mean) ** 2).mean(dim=0) # 按行求方差 方差是一个1*n的行向量

else:

# 二维卷积 输入shape 4维

# 使用二维卷积层的情况,计算通道维上(axis=1)的均值和方差。

# 这里我们需要保持X的形状以便后面可以做广播运算

# 按照通道数求均值 把每一个通道的所有批量和所有高宽像素都用来求均值 keepdim=True 输出是1*n*1*1四维向量

mean = X.mean(dim=(0, 2, 3), keepdim=True)

# 输出是1*n*1*1四维向量

var = ((X - mean) ** 2).mean(dim=(0, 2, 3), keepdim=True)

# 当前X求出的 mean var

# 训练模式下,用当前的均值和方差做标准化

# 训练用小批量的均值和方差

X_hat = (X - mean) / torch.sqrt(var + eps)

# 训练中 更新移动平均的均值和方差

# smooth计算真实均值方差的方法 无限逼近真实数据的均值方差

moving_mean = momentum * moving_mean + (1.0 - momentum) * mean

moving_var = momentum * moving_var + (1.0 - momentum) * var

Y = gamma * X_hat + beta # 缩放和移位

# .data 返回tensor

return Y, moving_mean.data, moving_var.data

class BatchNorm(nn.Module):

# num_features:完全连接层的输出数量或卷积层的输出通道数。

# num_dims:2表示完全连接层,4表示卷积层

def __init__(self, num_features, num_dims):

super().__init__()

if num_dims == 2:

shape = (1, num_features)

else:

shape = (1, num_features, 1, 1)

# 参与求梯度和迭代的拉伸和偏移参数,分别初始化成1和0

# 放在nn.Parameter里面 需要被迭代参数

self.gamma = nn.Parameter(torch.ones(shape)) # 拟合的方差 不能为0 做乘法为0的话乘积为0训练不动了

self.beta = nn.Parameter(torch.zeros(shape)) # 拟合的均值

# 非模型参数的变量初始化为0和1 # 不用背迭代

self.moving_mean = torch.zeros(shape)

self.moving_var = torch.ones(shape)

def forward(self, X):

# 如果X不在内存上,将moving_mean和moving_var

# 复制到X所在显存上

if self.moving_mean.device != X.device:

# 这两个参数没有放到nn.Parameter中 要手动挪下数据

self.moving_mean = self.moving_mean.to(X.device)

self.moving_var = self.moving_var.to(X.device)

# 保存更新过的moving_mean和moving_var

# 在不同框架下实现的时候,注意eps的设定

Y, self.moving_mean, self.moving_var = batch_norm(

X, self.gamma, self.beta, self.moving_mean,

self.moving_var, eps=1e-5, momentum=0.9)

return Y

# LeNet模型

net = nn.Sequential(

nn.Conv2d(1, 6, kernel_size=5), BatchNorm(6, num_dims=4), nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2),

nn.Conv2d(6, 16, kernel_size=5), BatchNorm(16, num_dims=4), nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2), nn.Flatten(),

nn.Linear(16*4*4, 120), BatchNorm(120, num_dims=2), nn.Sigmoid(),

nn.Linear(120, 84), BatchNorm(84, num_dims=2), nn.Sigmoid(),

nn.Linear(84, 10))

# 训练网络

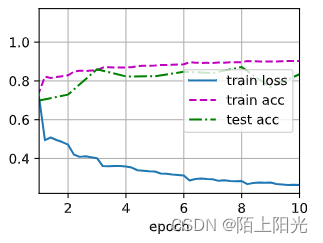

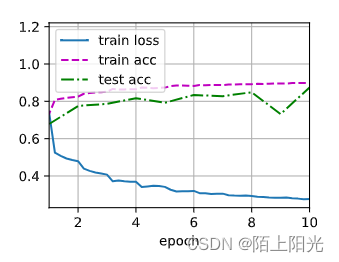

lr, num_epochs, batch_size = 1.0, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

# gamma学出来的是什么样子的

print(net[1].gamma.reshape((-1,)), net[1].beta.reshape((-1,)))

# 当网络学的很深的时候 可以对比最底层网络和最上层网络均值方差有什么区别

loss 0.263, train acc 0.903, test acc 0.834

17653.4 examples/sec on cuda:0

tensor([4.9547, 2.1918, 2.7570, 2.9478, 1.5544, 3.2417], device='cuda:0',

grad_fn=<ViewBackward0>) tensor([-2.5122, 1.4937, 0.9189, -2.8232, -2.1574, -1.6293], device='cuda:0',

grad_fn=<ViewBackward0>)

用BatchNorm收敛更快。

一样的数据,加不加BN可能效果一样。

当网络学的很深的时候 可以对比最底层网络和最上层网络均值方差有什么区别

调包简洁实现

import torch

from torch import nn

from d2l import torch as d2l

net = nn.Sequential(

nn.Conv2d(1, 6, kernel_size=5),

nn.BatchNorm2d(6), nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2),

nn.Conv2d(6, 16, kernel_size=5),

nn.BatchNorm2d(16), nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2), nn.Flatten(),

nn.Linear(256, 120), nn.BatchNorm1d(120), nn.Sigmoid(),

nn.Linear(120, 84), nn.BatchNorm1d(84), nn.Sigmoid(),

nn.Linear(84, 10))

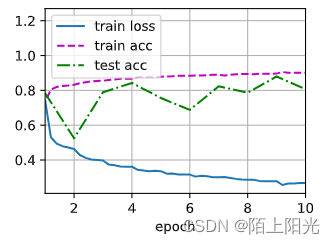

lr, num_epochs, batch_size = 1.0, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

loss 0.277, train acc 0.898, test acc 0.874

27529.3 examples/sec on cuda:0

测试精度震荡的原因:因为学习率大,把学习率调低就行了,再加上lenet是小模型,容易震荡

QA

1 xavier 的归一化 和BN层本质上没有区别。 选取好的初始化,在训练初始的时候比较稳定。BN在训练中数值都比较稳定

2 权重衰退更新时把每个权重除以一个小值,使得权重变得比较小,BN不对权重做太多处理

4 BN可以用在MLP中,主要用在比较深的网络中。

7 BN框架实现 默认第二维度是通道数维度,把其他所有维度都拉平计算均值方差

8 BN也是线性变换 和加一个线性层没什么区别。线性层不一定学到自己的想要的东西,不做的的话可能数值不稳定,可能不能训练到比较好的值域里面。

9 加BN后收敛加快, BN使得梯度可以变大一点 + 可以使用更大的lr = 收敛加快

10 重要程度:epoch数【可以选大 收敛结束可以中途停掉】 batchSize【根据内存调 要选的合适】 学习率【调完batchsize调】 相互相关 框架【看个人习惯】

11 XXnormalization 特别多。BN 是feature维度对样本做normalization。 layerNormalization在每一个样本里面的特征做normalization,通常用于比较大的网络。

12 BN一般不用在激活函数之后,因为是输入和输出的线性相关,可以尝试看看效果。

14 增加batchsize 看看每秒处理的样本数,增到一定程度。。。。看看效果