引言

多模态大模型是当今人工智能领域的热门方向之一。它不仅能处理文本,还能理解和生成图像、视频、语音等多种模态的数据。这种能力使得多模态大模型在自然语言处理、计算机视觉等多个领域展示出巨大的潜力和应用价值。那么,多模态大模型是如何训练出来的?其发展趋势如何?又面临哪些问题?本文将对这些问题进行深入探讨。

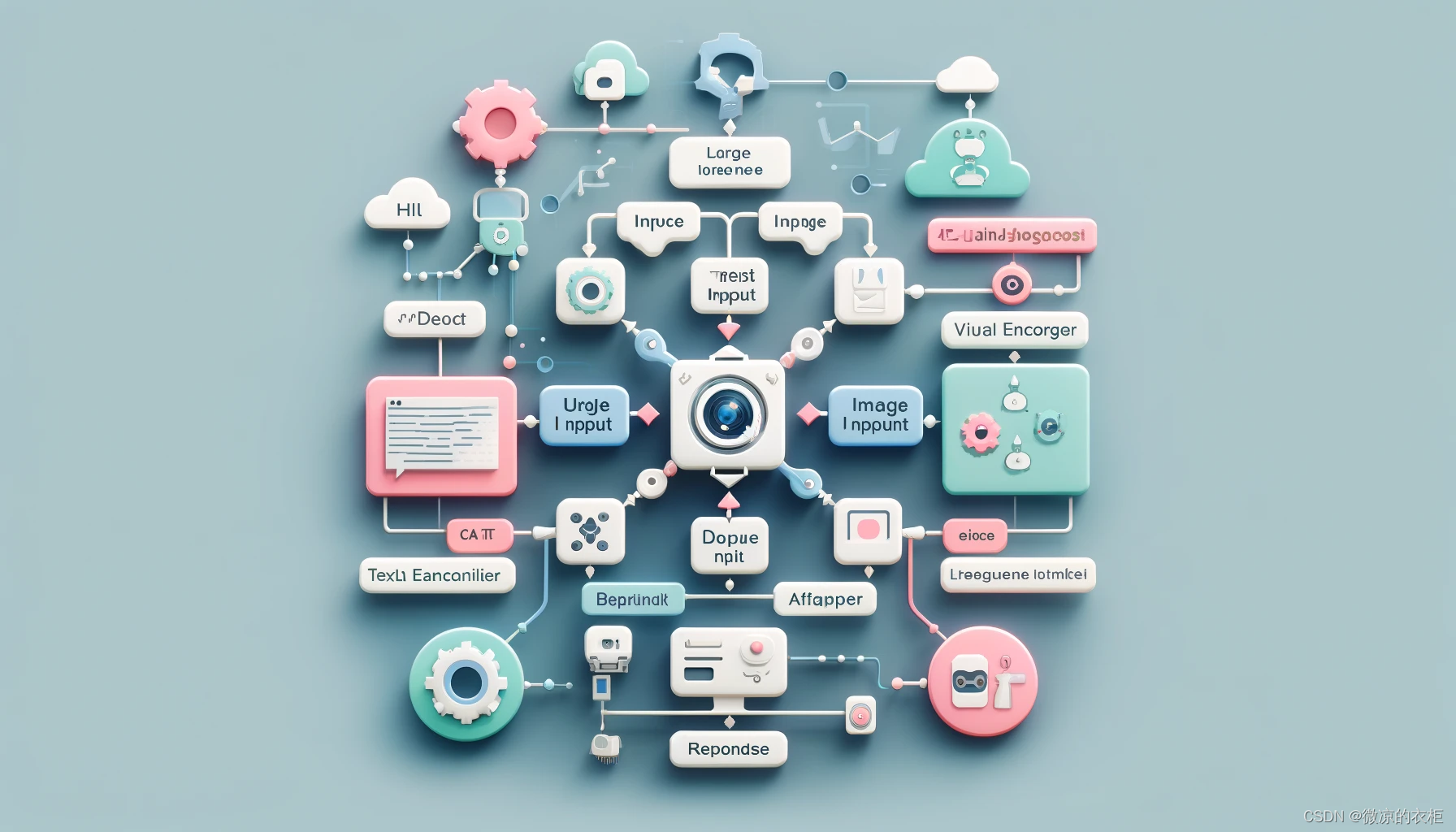

多模态大模型的训练与架构

多模态大模型的核心是如何将不同模态的数据进行有效的整合和理解。下面是多模态大模型的基本架构和训练方法:

基本架构

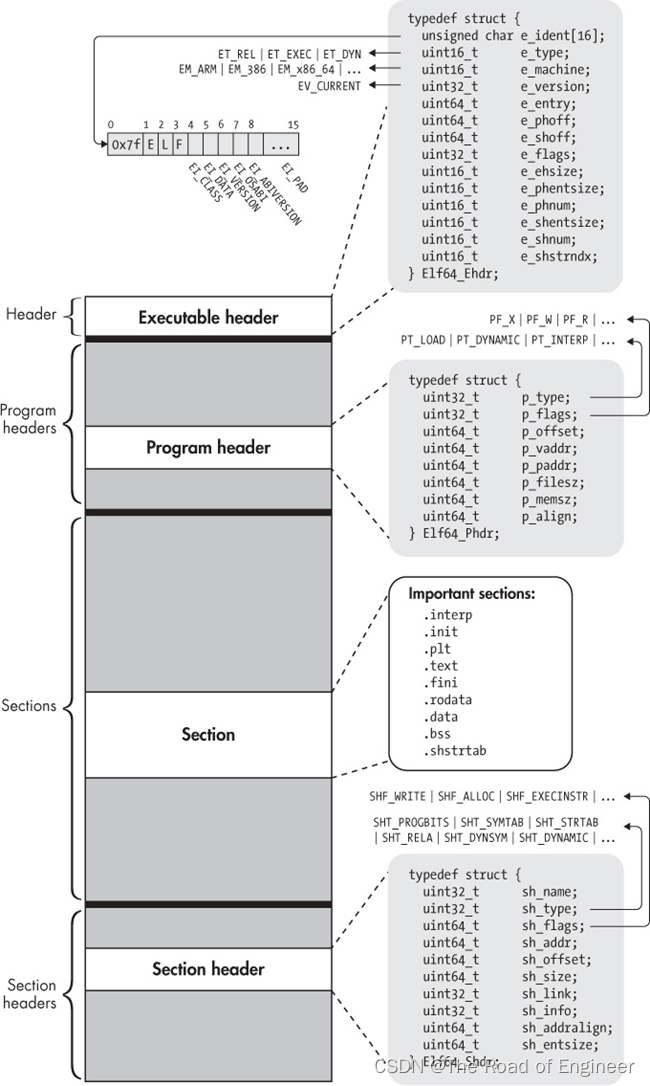

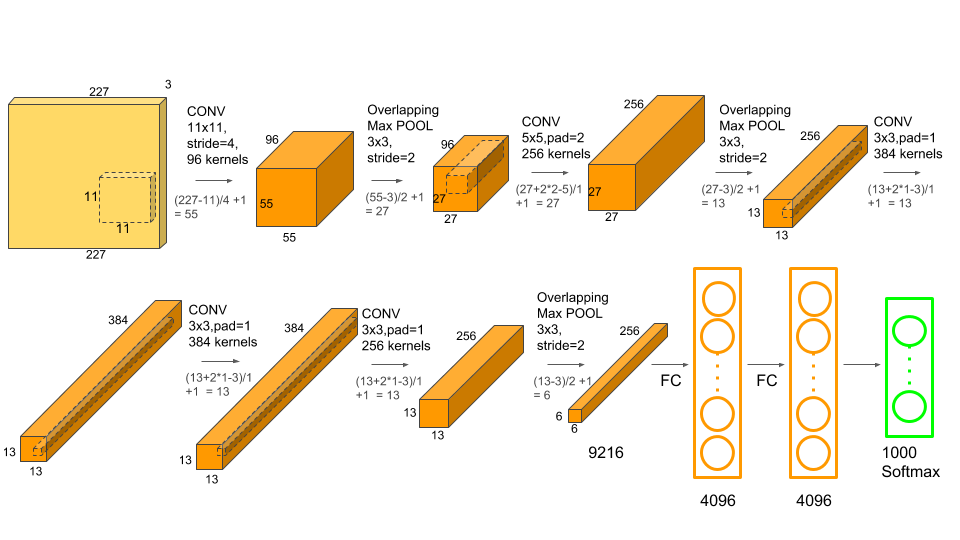

- 视觉编码器(Visual Encoder):用于提取图片或视频的特征,一般采用现成的视觉模型,如CLIP。

- 适配器(Adapter):将视觉特征映射到文本特征空间,使得图像信息可以与文本信息对齐。

- 大语言模型(Large Language Model, LLM):作为核心处理模块,利用其强大的语言理解和生成能力,整合多模态信息并生成最终输出。

- 多模态数据:用于训练模型的配对数据,如图片和其对应的描述文本。

- 指令调优(Instruct Tuning):通过预先设定的任务,让模型能够更好地理解和执行人类的指令。

典型系统

- BLIP:采用简单的线性映射方法,将图片特征直接嵌入文本空间,结构简单但效果显著。

- LLaVA:采用典型的多模态架构,包括视觉编码器和适配器,提供了良好的文本和图像理解能力。

- 千问QL:通过多阶段训练,特别是在第二阶段进行多任务学习,显著提升了模型的性能。

- SPINX:支持高清图像处理,并集成了多个视觉编码器,提高了视觉特征的提取和理解能力。

发展趋势

在多模态大模型的发展过程中,以下几个技术趋势尤为重要:

高清图像处理

高清图像处理技术可以显著提升多模态模型的性能。通过将高清图像切割成小块并保持其高分辨率输入,模型能够获得更丰富和精细的图像特征,从而提高整体的识别和生成能力。

多视觉编码器集成

集成多个视觉编码器可以有效补充单一编码器的不足,从而提供更全面的图像特征提取。不同编码器可以从不同角度理解图像信息,使得模型的视觉感知能力更强。

细粒度的文图对齐

细粒度的文图对齐技术通过精确标注图像中各个部分与文本描述的对应关系,进一步提高了模型的理解能力。这种标注需要在图像中明确指出每个对象的位置和其对应的文本描述,确保模型能够准确理解图像的深层含义。

文图交织数据

在训练多模态大模型时,除了严格对齐的文图数据,还需要大量不严格对齐的数据。这可以有效缓解模型的灾难性遗忘问题,保持大语言模型原有的语言和推理能力。

面临的问题

尽管多模态大模型展示了巨大的潜力,但在实际应用中仍面临不少挑战:

视觉感知能力弱

目前的多模态大模型在视觉感知方面的表现尚不理想,约35%的错误来源于视觉编码器。这表明模型在处理图像特征时仍存在很大的改进空间。

空间关系建模差

多模态大模型对图像中物体的空间关系理解较差。在测试中,模型在判断物体位置关系(如左侧和右侧)时经常出错。这主要是由于模型缺乏足够的空间关系数据进行训练。

深层语义理解难

多模态大模型在理解图像的深层语义时表现不佳。尽管在表层语义理解上有一定的成绩,但在涉及深层次含义(如漫画表达的寓意)时,模型的表现依然远低于人类水平。

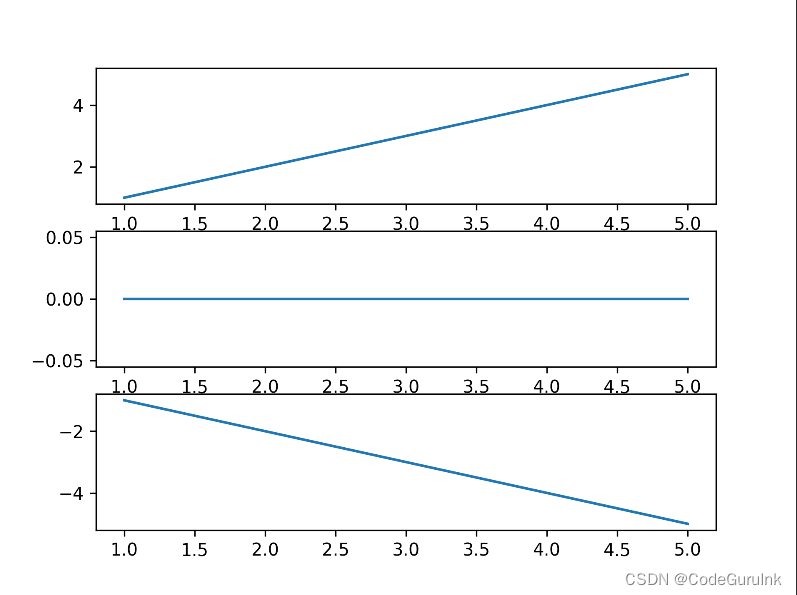

视觉数理推理能力不足

多模态大模型在进行视觉数理推理时表现较差。例如,在处理函数图像并求解最大局部值的问题时,模型往往无法正确回答。这反映出模型在视觉推理和逻辑推理方面的能力仍需提升。

结论与展望

多模态大模型作为人工智能领域的重要方向,展现出了广泛的应用前景和发展潜力。尽管目前在视觉感知、空间关系建模、深层语义理解和数理推理等方面还存在诸多挑战,但通过不断的技术创新和优化,相信这些问题终将得到解决。未来,多模态大模型有望在更多实际场景中发挥重要作用,推动人工智能技术的发展和应用。

进一步学习资源

- OpenAI GPT-4

- CLIP: Connecting Text and Images

- LLaVA: Large Language and Vision Assistant

- SPINX: Advanced Vision Encoder Integration

![[机缘参悟-191] - 《道家-水木然人间清醒1》读书笔记 -14- 关系界限 - 经济和人格上的独立,走向成熟的必经之路,才能更好的谈其他情感(IT)](https://img-blog.csdnimg.cn/direct/b8c265c5a7e043ce80c87e5d24ff4999.png)