提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 背景

- 一、Ollama安装

- 1.安装

- 2.安装后检验

- 3.运行模型

- 4.常用命令

- 二、安装maxkb

- 1.说明

- 2.docker安装maxkb

- 2.添加模型

- 3.创建应用

- 4.api域名无效

- 三、总结

背景

最近在学习ai相关内容,看到本地可以部署大语言模型,就尝试记录一下,本文章记录了安装ollama和前端页面maxkb

提示:以下是本篇文章正文内容,下面案例可供参考

一、Ollama安装

1.安装

直接执行命令

curl -fsSL https://ollama.com/install.sh | sh

2.安装后检验

ollama -v

能显示版本的话,就是安装好了

ollama api端口默认11434,可以直接访问

curl http://127.0.0.1:11434

会返回Ollama is running

3.运行模型

以通义千问为例

ollama run qwen:7b

上述命令就会直接下载并运行qwen:7b,运行成功即可对话

提示:关于ollama支持哪些模型,可以查看[ollama官网](https://ollama.com/)

4.常用命令

# 查看运行中的模型

ollama list

# 下载并运行模型 ollama run 模型名:版本

ollama run qwen:7b

# 删除模型 ollama rm 模型名:版本

ollama rm qwen:7b

二、安装maxkb

1.说明

maxkb可以作为ollama的前端页面,提供更友好的交互方式

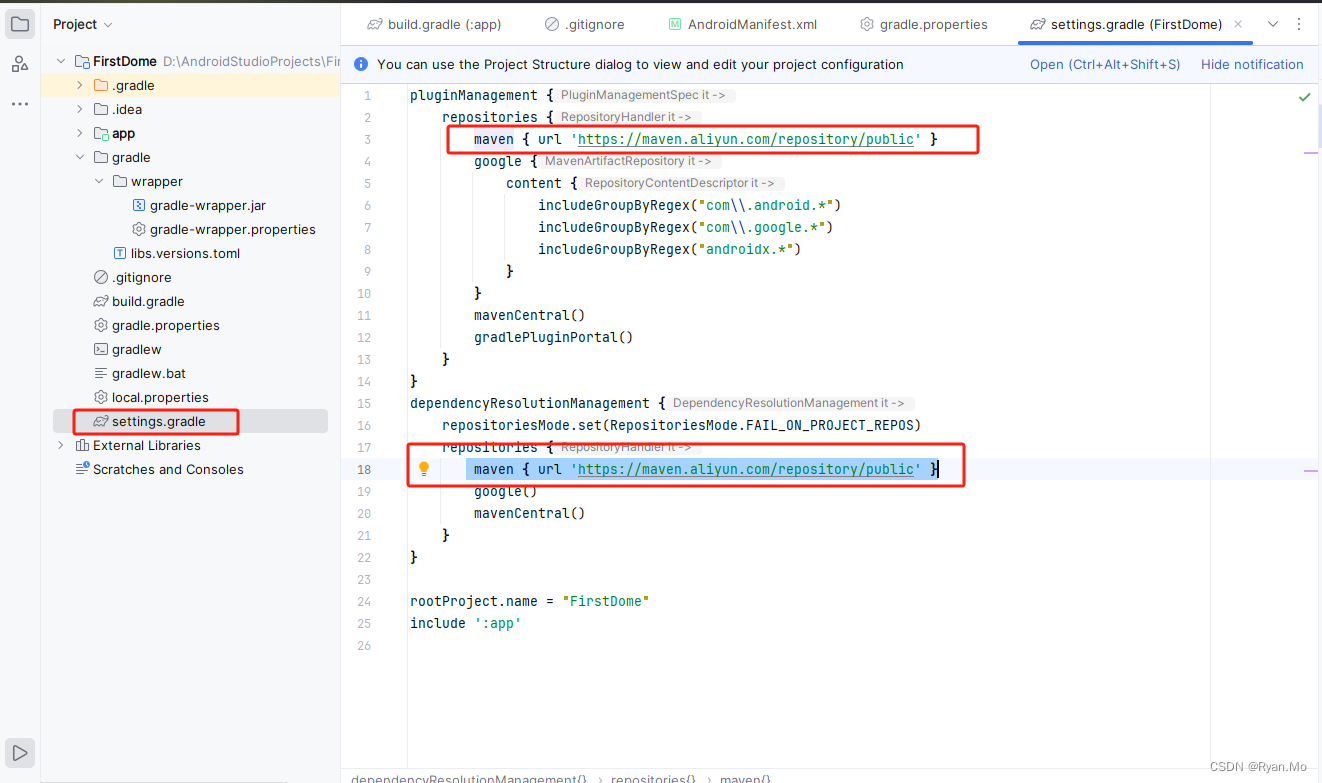

2.docker安装maxkb

docker run -d --name=maxkb -p 8080:8080 -v ~/maxkb:/var/lib/postgresql/data 1panel/maxkb

安装完成之后,访问ip:8080,即可进入maxkb界面,默认账号 admin/MaxKB@123…

2.添加模型

名称和apikey可以随便填

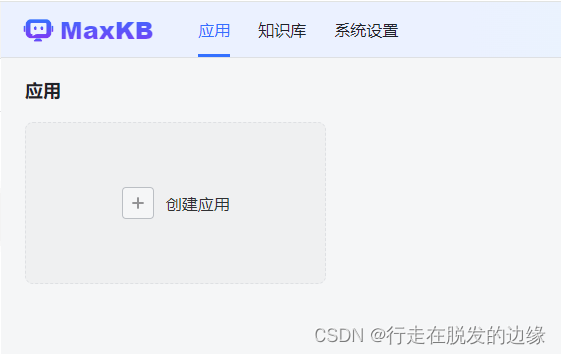

3.创建应用

4.api域名无效

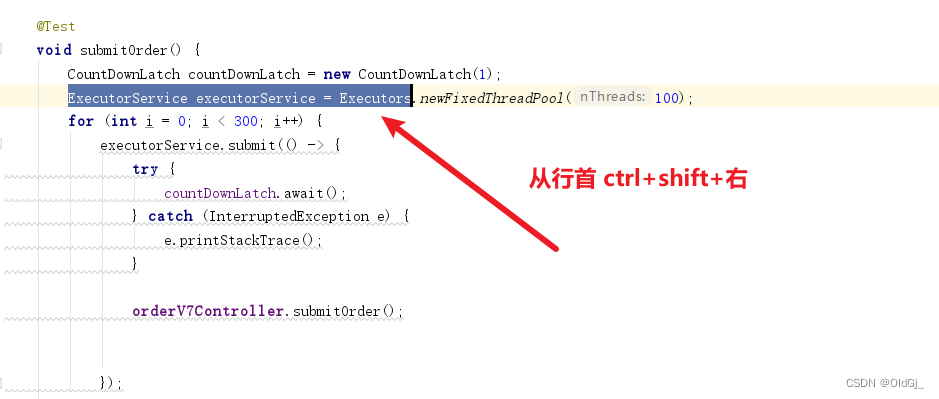

浏览器访问http://127.0.0.1:11434能正确响应,但是访问192.168.0.101:11434无发访问,跟ollama配置有关系。

找到ollama配置文件,我的是在这个目录/etc/systemd/system/ollama.service,添加环境变量OLLAMA_HOST

如:

Environment=“OLLAMA_HOST=0.0.0.0:11434”

保存后重新加载配置,再重启ollama服务,就能解决ollama只能127.0.0.1访问的问题

相关命令

# 重载daemon文件

systemctl daemon-reload

# 重启

systemctl restart ollama

三、总结

先这样吧,后续慢慢研究再记录