1. 部署InternLM2-Chat-1.8B 模型进行智能对话

1.1配置环境

创建开发机

Intern Studio 官网网址:https://studio.intern-ai.org.cn/

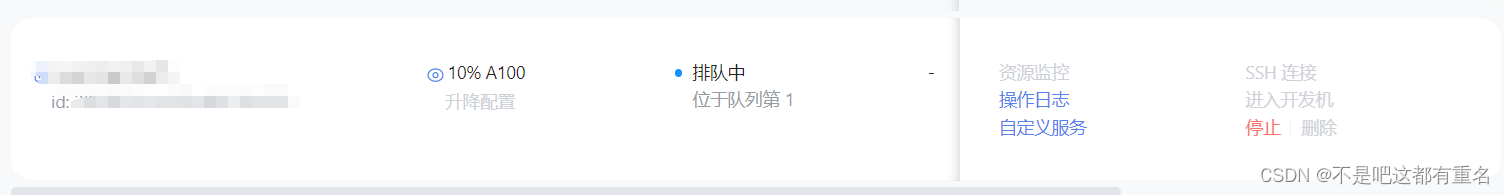

进入官网后,选择创建开发机,填写 开发机名称 后,点击 选择镜像 使用 Cuda11.7-conda 镜像,然后在资源配置中,使用 10% A100 * 1 的选项,立即创建开发机器。

然后机器会排队创建(等待的有点久嗷,不知道为啥)。

配置环境

进入开发机在terminal后输入环境配置命令如下:

studio-conda -o internlm-base -t demo

# 与 studio-conda 等效的配置方案

# conda create -n demo python==3.10 -y

# conda activate demo

# conda install pytorch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 pytorch-cuda=11.7 -c pytorch -c nvidia

激活环境

conda activate demo

安装其他依赖包:

pip install huggingface-hub==0.17.3

pip install transformers==4.34

pip install psutil==5.9.8

pip install accelerate==0.24.1

pip install streamlit==1.32.2

pip install matplotlib==3.8.3

pip install modelscope==1.9.5

pip install sentencepiece==0.1.99

1.2 下载 InternLM2-Chat-1.8B 模型

创建文件夹

mkdir -p /root/demo

touch /root/demo/cli_demo.py #touch主要用于创建空文件或设置文件的时间戳

touch /root/demo/download_mini.py

cd /root/demo

在download_mini.py中复制以下代码:

import os

from modelscope.hub.snapshot_download import snapshot_download

# 创建保存模型目录

os.system("mkdir /root/models")

# save_dir是模型保存到本地的目录

save_dir="/root/models"

snapshot_download("Shanghai_AI_Laboratory/internlm2-chat-1_8b",

cache_dir=save_dir,

revision='v1.1.0')

然后运行该文件以下载模型参数文件。

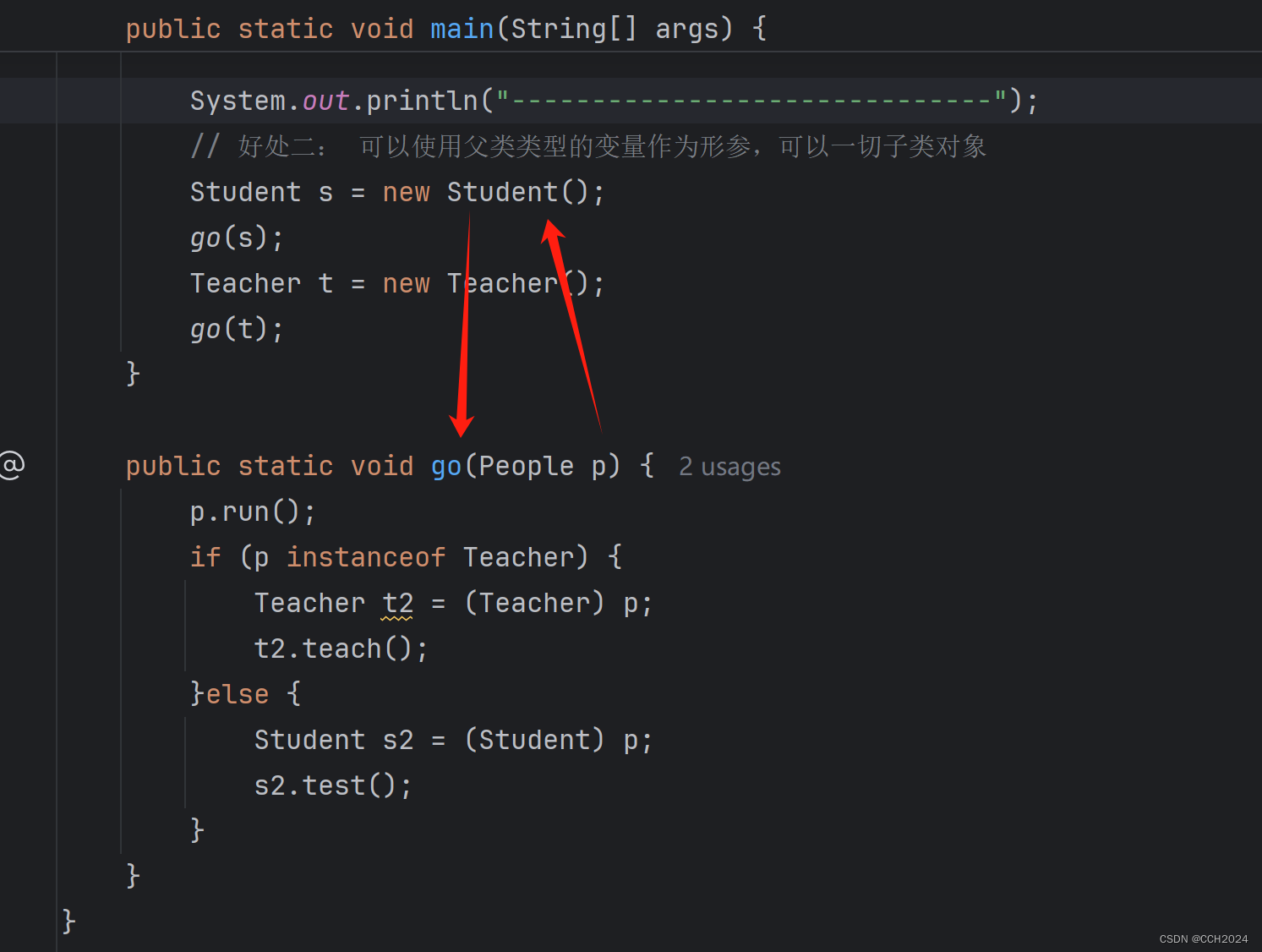

1.3 运行cli_demo

在cli_demo.py中复制以下内容,然后运行

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name_or_path = "/root/models/Shanghai_AI_Laboratory/internlm2-chat-1_8b"

tokenizer = AutoTokenizer.from_pretrained(model_name_or_path, trust_remote_code=True, device_map='cuda:0')

model = AutoModelForCausalLM.from_pretrained(model_name_or_path, trust_remote_code=True, torch_dtype=torch.bfloat16, device_map='cuda:0')

model = model.eval()

system_prompt = """You are an AI assistant whose name is InternLM (书生·浦语).

- InternLM (书生·浦语) is a conversational language model that is developed by Shanghai AI Laboratory (上海人工智能实验室). It is designed to be helpful, honest, and harmless.

- InternLM (书生·浦语) can understand and communicate fluently in the language chosen by the user such as English and 中文.

"""

messages = [(system_prompt, '')]

print("=============Welcome to InternLM chatbot, type 'exit' to exit.=============")

while True:

input_text = input("\nUser >>> ")

input_text = input_text.replace(' ', '')

if input_text == "exit":

break

length = 0

for response, _ in model.stream_chat(tokenizer, input_text, messages):

if response is not None:

print(response[length:], flush=True, end="")

length = len(response)

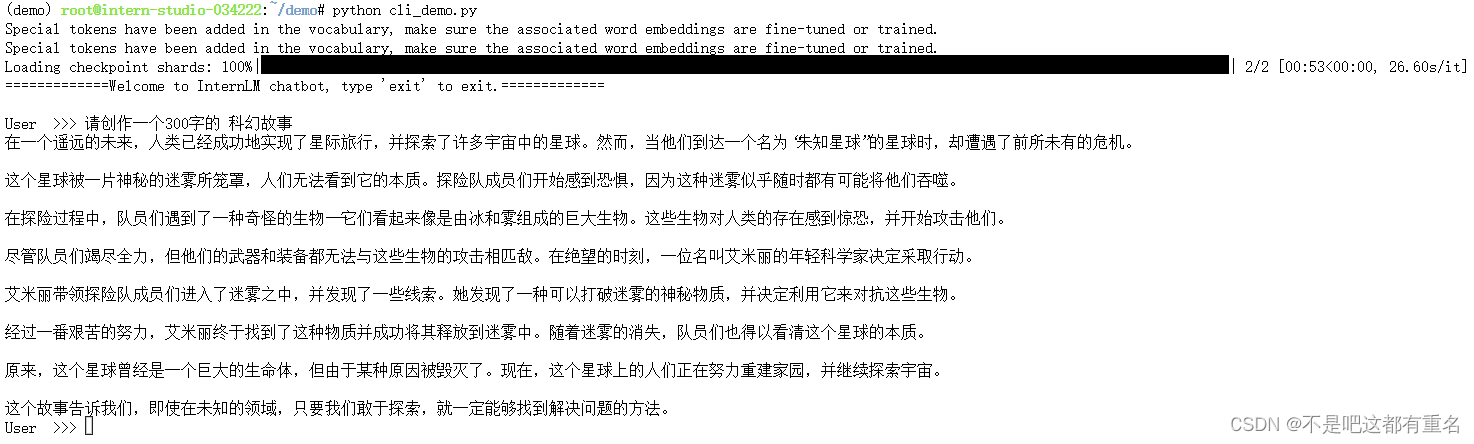

运行效果如下:

有点怪啊,最后总是有一句总结句>_<

2.部署实战营优秀作品 八戒-Chat-1.8B模型

2.1简介

八戒-Chat-1.8B 是利用《西游记》剧本中所有关于猪八戒的台词和语句以及 LLM API 生成的相关数据结果,进行全量微调得到的猪八戒聊天模型。作为 Roleplay-with-XiYou 子项目之一,八戒-Chat-1.8B 能够以较低的训练成本达到不错的角色模仿能力,同时低部署条件能够为后续工作降低算力门槛。

项目链接:https://www.modelscope.cn/models/JimmyMa99/BaJie-Chat-mini/summary

2.2环境配置

基本环境和上一节一致,只需要激活

conda activate demo

从git仓库拉取

cd /root/

git clone https://gitee.com/InternLM/Tutorial -b camp2

# git clone https://github.com/InternLM/Tutorial -b camp2

cd /root/Tutorial

2.3下载运行Demo

下载

python /root/Tutorial/helloworld/bajie_download.py

运行

streamlit run /root/Tutorial/helloworld/bajie_chat.py --server.address 127.0.0.1 --server.port 6006

端口映射

在powershell中运行下述命令

# 从本地使用 ssh 连接 studio 端口

# 将下方端口号 38374 替换成自己的端口号

ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 38374

这个38374端口号可以在SSH连接中查看,然后输入下方的密码(我似乎没有输入密码,但是仍然可以用?)

打开 http://127.0.0.1:6006 后,结果如下:

3.实战:使用 Lagent 运行 InternLM2-Chat-7B 模型

3.1 初步介绍 Lagent 相关知识

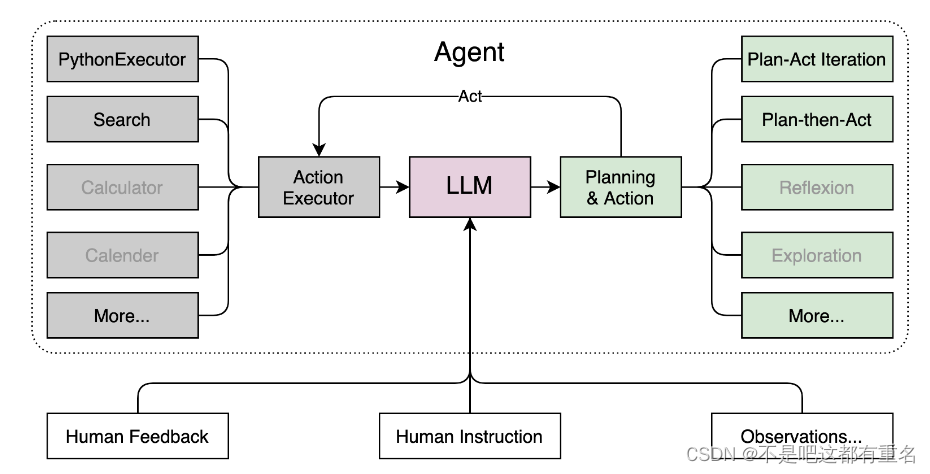

Lagent 是一个轻量级、开源的基于大语言模型的智能体(agent)框架,支持用户快速地将一个大语言模型转变为多种类型的智能体,并提供了一些典型工具为大语言模型赋能。它的整个框架图如下:

Lagent的特点:

- 流式输出:提供 stream_chat 接口作流式输出,本地就能演示酷炫的流式 Demo。

- 接口统一,设计全面升级,提升拓展性,包括:

Model : 不论是 OpenAI API, Transformers 还是推理加速框架 LMDeploy 一网打尽,模型切换可以游刃有余;

Action: 简单的继承和装饰,即可打造自己个人的工具集,不论 InternLM 还是 GPT 均可适配;

Agent:与 Model 的输入接口保持一致,模型到智能体的蜕变只需一步,便捷各种 agent 的探索实现; - 文档全面升级,API 文档全覆盖。

3.2配置环境

激活环境

conda activate demo

切换目录

cd /root/demo

拉取代码库

git clone https://gitee.com/internlm/lagent.git

# git clone https://github.com/internlm/lagent.git

cd /root/demo/lagent

git checkout 581d9fb8987a5d9b72bb9ebd37a95efd47d479ac

pip install -e . # 源码安装

3.3 使用 Lagent 运行 InternLM2-Chat-7B 模型为内核的智能体

切换路径

cd /root/demo/lagent

构造软链接

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm2-chat-7b /root/models/internlm2-chat-7b

打开 lagent 路径下 examples/internlm2_agent_web_demo_hf.py 文件,并修改对应位置 (71行左右) 代码,修改运行demo中的模型路径为本地路径

# 其他代码...

value='/root/models/internlm2-chat-7b'

# 其他代码...

运行

streamlit run /root/demo/lagent/examples/internlm2_agent_web_demo_hf.py --server.address 127.0.0.1 --server.port 6006

端口映射,同上一节

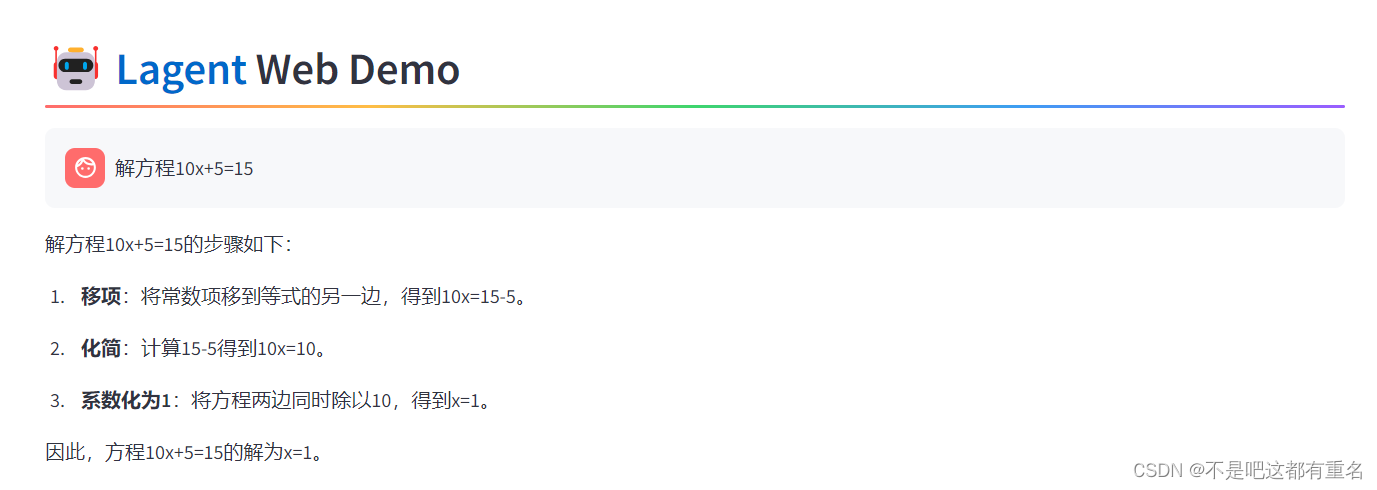

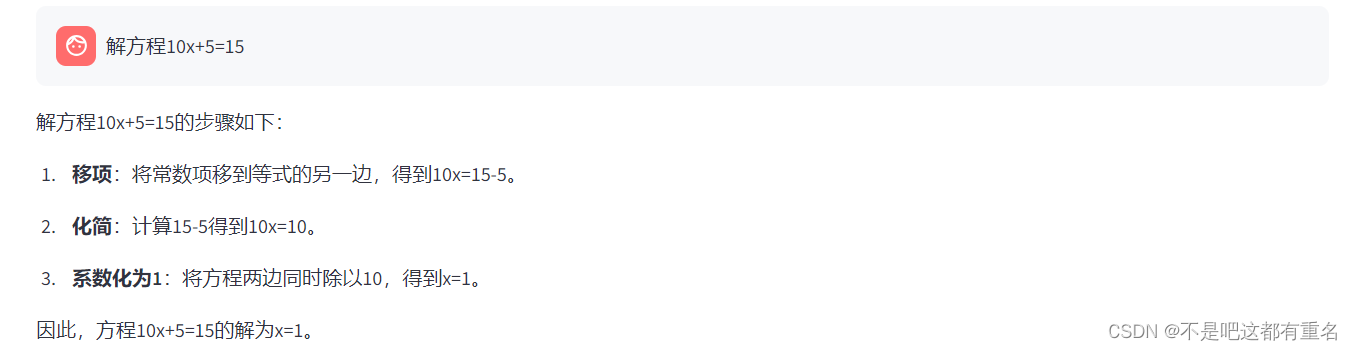

结果展示如下,(未勾选数据分析)

勾选数据分析

似乎没什么区别?

4.实战:实践部署 浦语·灵笔2 模型

4.1 初步介绍 XComposer2 相关知识

浦语·灵笔2 是基于 书生·浦语2 大语言模型研发的突破性的图文多模态大模型,具有非凡的图文写作和图像理解能力,在多种应用场景表现出色,总结起来其具有:

- 自由指令输入的图文写作能力: 浦语·灵笔2 可以理解自由形式的图文指令输入,包括大纲、文章细节要求、参考图片等,为用户打造图文并貌的专属文章。生成的文章文采斐然,图文相得益彰,提供沉浸式的阅读体验。

- 准确的图文问题解答能力:浦语·灵笔2 具有海量图文知识,可以准确的回复各种图文问答难题,在识别、感知、细节描述、视觉推理等能力上表现惊人。

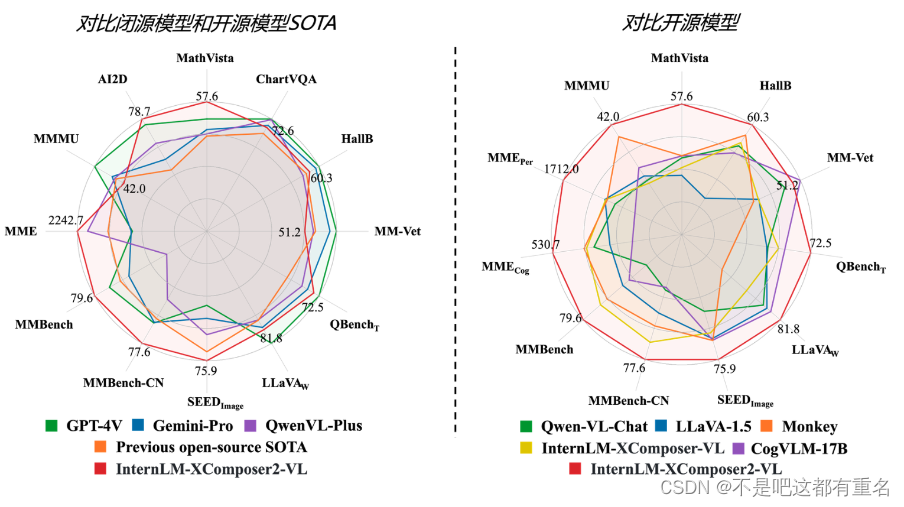

- 杰出的综合能力: 浦语·灵笔2-7B 基于 书生·浦语2-7B 模型,在13项多模态评测中大幅领先同量级多模态模型,在其中6项评测中超过 GPT-4V 和 Gemini Pro。

可以看到该模型在开源模型中效果非常好,在闭源模型和开源SOTA中也表现强劲。

4.2 环境配置

启动环境

conda activate demo

补充安装依赖包

pip install timm==0.4.12 sentencepiece==0.1.99 markdown2==2.4.10 xlsxwriter==3.1.2 gradio==4.13.0 modelscope==1.9.5

拉取InternLM-XComposer 代码

cd /root/demo

git clone https://gitee.com/internlm/InternLM-XComposer.git

# git clone https://github.com/internlm/InternLM-XComposer.git

cd /root/demo/InternLM-XComposer

git checkout f31220eddca2cf6246ee2ddf8e375a40457ff626

创建软链接

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm-xcomposer2-7b /root/models/internlm-xcomposer2-7b

ln -s /root/share/new_models/Shanghai_AI_Laboratory/internlm-xcomposer2-vl-7b /root/models/internlm-xcomposer2-vl-7b

4.3图文写作实战

启动InternLM-XComposer:

cd /root/demo/InternLM-XComposer

python /root/demo/InternLM-XComposer/examples/gradio_demo_composition.py \

--code_path /root/models/internlm-xcomposer2-7b \

--private \

--num_gpus 1 \

--port 6006

记得开端口映射

实现效果如下

4.4图片理解实战

运行InternLM-XComposer2-vl

conda activate demo

cd /root/demo/InternLM-XComposer

python /root/demo/InternLM-XComposer/examples/gradio_demo_chat.py \

--code_path /root/models/internlm-xcomposer2-vl-7b \

--private \

--num_gpus 1 \

--port 6006

效果展示: