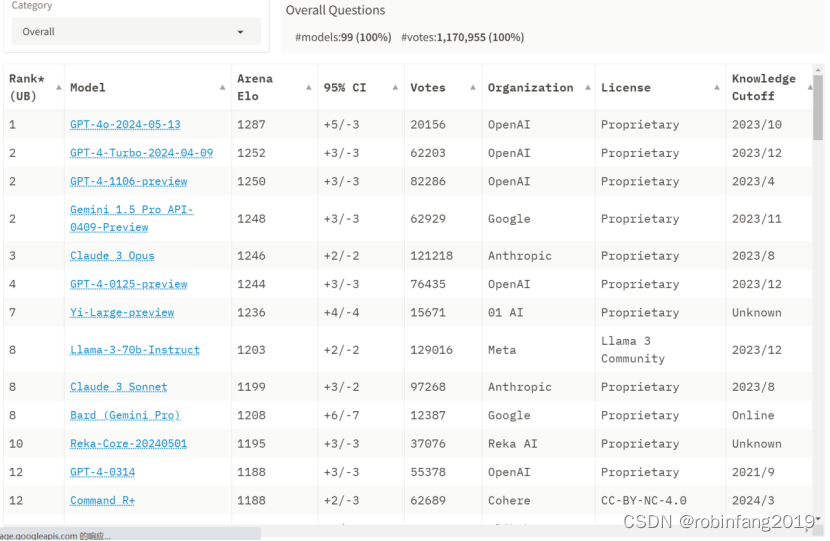

Chatbot Arena由伯克利大学主导团队 LMSYS Org 发布了一个针对大语言模型的基准平台 Chatbot Arena。该平台采用匿名、随机的方式让不同的大模型产品进行对抗评测,基于国际象棋等竞技游戏中广泛使用的埃洛等级分系统,通过用户投票产生,系统每次会随机选择两个不同的大模型机器人和用户聊天,并让用户在匿名的情况下选择哪款大模型产品的表现更好一些。最后系统根据用户的选择判定大模型产品的积分,以排行榜的形式出现在首页中。

现已有1170955匿名投票,99个大模型参与排名,并有越来越多人开始在该平台为不同的大模型产品投票。

Chatbot Arena发布一个更新的排行榜,其中包含更多模型和两个数据集,用于人类偏好相关研究,最新榜单地址:

https://huggingface.co/spaces/lmsys/chatbot-arena-leaderboard

1、最新排名(2024年5月20日)及关键指标解读

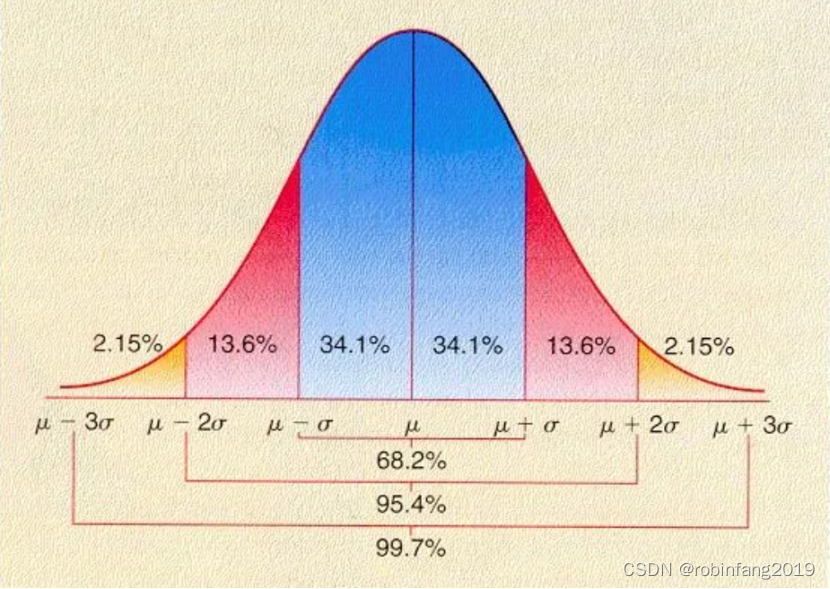

Arena Elo评分系统:原来是一种评估玩家相对技能水平的方法,广泛应用于竞技游戏和体育运动中。在Chatbot Arena的上下文中,这个系统被用来评估大型语言模型(LLM)的性能。Chatbot Arena通过众包的形式,采用匿名、随机的方式对不同的LLMs进行打分。这意味着用户可以对同一个问题的不同模型进行投票,赢得的模型可以获得一定的分数,因此,这个分数越高,模型效果越好。

95%CI:提供了一个关于Elo得分准确性的估计范围,帮助理解这些得分是如何反映模型实际性能的。

License:最常见的Proprietary(专有),创建者保留了所有的权利,没有公开发布其源代码或不允许他人自由使用、修改或分发;其次还有CC-BY-NC-4.0(创作共用-署名-非商业性使用4.0国际),广泛使用的创作共用许可协议;还有就是如Llama 3 Community 许可协议( Meta AI 公司发布的开源许可协议)

Knowledge cutoff:代表了AI模型数据最后一次更新的时间点,如排名第一的GPT-4O模型knowledge cutoff是2023年10月,那么它对于2023年10月之后发生的事情就没有知识了。这对于评估和使用基于AI的系统尤其重要,因为它直接影响到模型的有效性和可靠性。

2、评测基本过程

Chatbot Arena借鉴了搜索引擎时代的横向对比评测思路。它首先将所有上传评测的“参赛”模型随机两两配对,以匿名模型的形式呈现在用户面前;随后号召真实用户输入自己的提示词,在不知道模型型号名称的前提下,由真实用户对两个模型产品的作答给出评价。

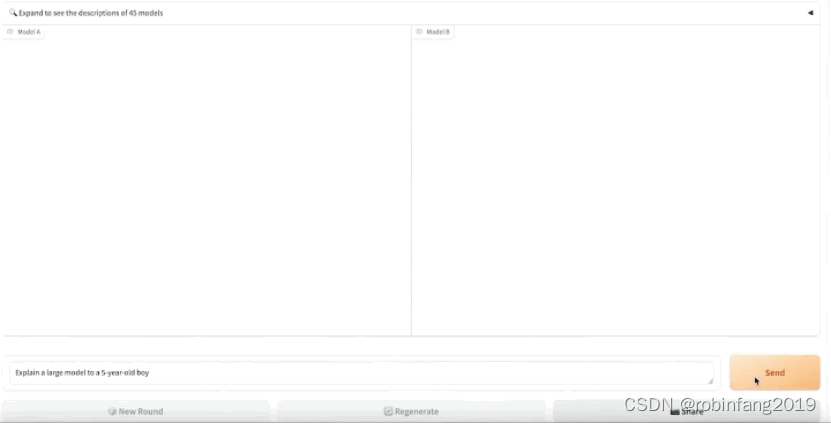

在盲测平台https://arena.lmsys.org/上,大模型们两两相比,用户自主输入对大模型的提问,模型A、模型B两侧分别生成两PK模型的真实结果,用户在结果下方做出投票四选一:A模型较佳、B模型较佳,两者平手,或是两者都不好。提交后,可进行下一轮PK。

3、数据集

3.1 33K聊天机器人竞技场对话数据

链接:lmsys/chatbot_arena_conversations

该数据集包含23年4月至6月在Chatbot Arena上收集的33000个已清理的对话,这些对话具有成对的人类偏好。每个示例包括两个模型名称、其完整的对话文本、用户投票、匿名用户ID、检测到的语言标签、OpenAI审核API标签、额外的有毒标签和时间戳。

为了确保数据的安全发布,我们试图删除所有包含个人身份信息(PII)的对话。此外,我们还包括了OpenAI审核API输出,以标记不适当的对话。然而,我们选择不删除所有这些对话,以便研究人员可以研究与野外LLM使用相关的安全相关问题以及OpenAI审核过程。例如,我们包括了由我们自己的有毒标记器生成的其他有毒标签,这些标签是通过在手动标记的数据上微调T5和RoBERTa来训练的。

3.2 3K MT-bench人类注释

链接:lmsys/mt_bench_human_judgments

除了与Chatbot Arena进行众包评估外,我们还使用MT-bench进行了受控的人类评估。

该数据集包含3.3K专家级配对人类偏好,用于6个模型为响应80个MT工作台问题而生成的模型响应。6种型号是GPT-4、GPT-3.5、Claud-v1、Vicuna-13B、羊驼-13B和LLAMA-13B。注释员大多是在每个问题的主题领域具有专业知识的研究生。