前言

原文链接:OpenAI最新模型——GPT-4o,实时语音视频交互,未来人机交互近在眼前 - Kaiho小站

北京时间 5 月 14 日凌晨,OpenAI 发布新一代模型——GPT-4o,仅在 ChatGPT 面世 17 个月后,OpenAI 再次通过新模型震惊世界,推出了科幻电影般的超级 AI,并且完全免费供大众使用。

划时代的发布会

5月14日凌晨,OpenAI 在首届“春季新品发布会”上隆重推出了新一代旗舰生成模型 GPT-4o、桌面应用程序,并展示了一系列令人惊叹的新功能。连 OpenAI CEO 山姆·奥特曼都不禁感叹:这简直像电影中的情节。

此次发布会由 OpenAI 首席技术官 Mira Murati 主持,她指出 OpenAI 的三大重要理念:

- 免费优先:OpenAI 致力于让更多人能够使用其产品。

- 桌面应用程序和更新 UI:新版本的桌面应用程序更加简便和自然。

- 全新大模型 GPT-4o:GPT-4o 以极其自然的交互方式为每个人提供 GPT-4 级别的智能,包括免费用户。

此次更新后,ChatGPT 可以接收文本、音频和图像的任意组合输入,并实时生成相应的输出。这种全新的交互方式将引领未来主流的交互模式。

如今,ChatGPT 不仅无需注册即可使用,更是推出了桌面程序。OpenAI 的目标是让人们能够随时随地无感使用 ChatGPT,将其无缝集成到工作流程中,真正提升生产力。

GPT-4o 是一款面向未来的全新大模型,具有文本、语音、图像三种模态的理解力,反应迅速且情感丰富。在发布会上,OpenAI 工程师们展示了 GPT-4o 的主要功能,包括实时语音对话、视觉能力和代码解析能力。

在现场,OpenAI 的工程师Mark Chen 说:「我第一次来直播的发布会,有点紧张。」

ChatGPT 说:「要不你深呼吸一下。」

「好的,我试着深呼吸」

ChatGPT 立即回答说「你这不行,喘得也太大了。」

如果之前有用过 Siri 之类的语音助手的经历,你就会发现极大的区别。

首先,你可以随时打断 AI 的话,不用等它说完就可以继续下一轮对话。其次,你不用等待,模型反应极快,比人类的回应还快。第三,模型能够充分理解人类的情感,自己也能表现出各种感情。

在视觉能力方面,另一个工程师直接在纸上写下一个方程式,并且让 ChatGPT 不需要直接给答案,而是让它解释要一步步怎么做。看得出来,它在教人做题方面很有潜力,在 AI 教育产业上看来会有很大的冲击。

此外,在发布会上还展示了 GPT-4o 的实时翻译和表情识别能力。这些功能将使用户能够更加自然地与 ChatGPT 互动,真正达到了实时的视频理解。

新一代模型——GPT-4o

GPT-4o,o 即代表 Omnimodel(全能模型)

GPT-4o 是 OpenAI 在集成多模态模型方面的重大突破。该模型在文本、视觉和音频方面的性能大幅提升,响应速度极快,接近人类水平。OpenAI 通过端到端训练,将所有输入和输出统一处理,实现了跨模态的实时推理。

GPT-4o 在英文文本和代码方面的性能与 GPT-4 Turbo 相当,但在非英文文本方面表现显著提升。同时,它的 API 速度也有所增加,使成本降低了 50%。与现有模型相比,GPT-4o 在视觉和音频理解方面尤为出色。

它可以在 232 毫秒内快速响应音频输入,平均响应时间为 320 毫秒,与人类相似。在 GPT-4o 发布之前,使用 ChatGPT 的语音对话功能的用户注意到平均延迟分别为 2.8 秒 (GPT-3.5) 和 5.4 秒 (GPT-4)。

这种快速的语音响应是由三个独立模型组成的流程实现的:一个简单模型将音频转录为文本,GPT-3.5 或 GPT-4 处理文本并生成文本输出,第三个简单模型将文本转换回音频。然而,OpenAI 发现这种方法导致 GPT-4 丢失了大量信息,例如模型无法直接观察到音调、多个说话者、背景噪音,也无法输出笑声、歌唱或情感表达。

相比之下,在 GPT-4o 上,OpenAI 跨文本、视觉和音频领域进行了端到端的训练,意味着所有输入和输出都由同一神经网络处理。这消除了信息丢失,并使模型能够更加细致、丰富地理解上下文,并提供更加多样化和丰富的响应。

此外,GPT-4o 在理解和生成图像方面的能力也远胜于之前,此前很多不可能的任务都变得「易如反掌」。

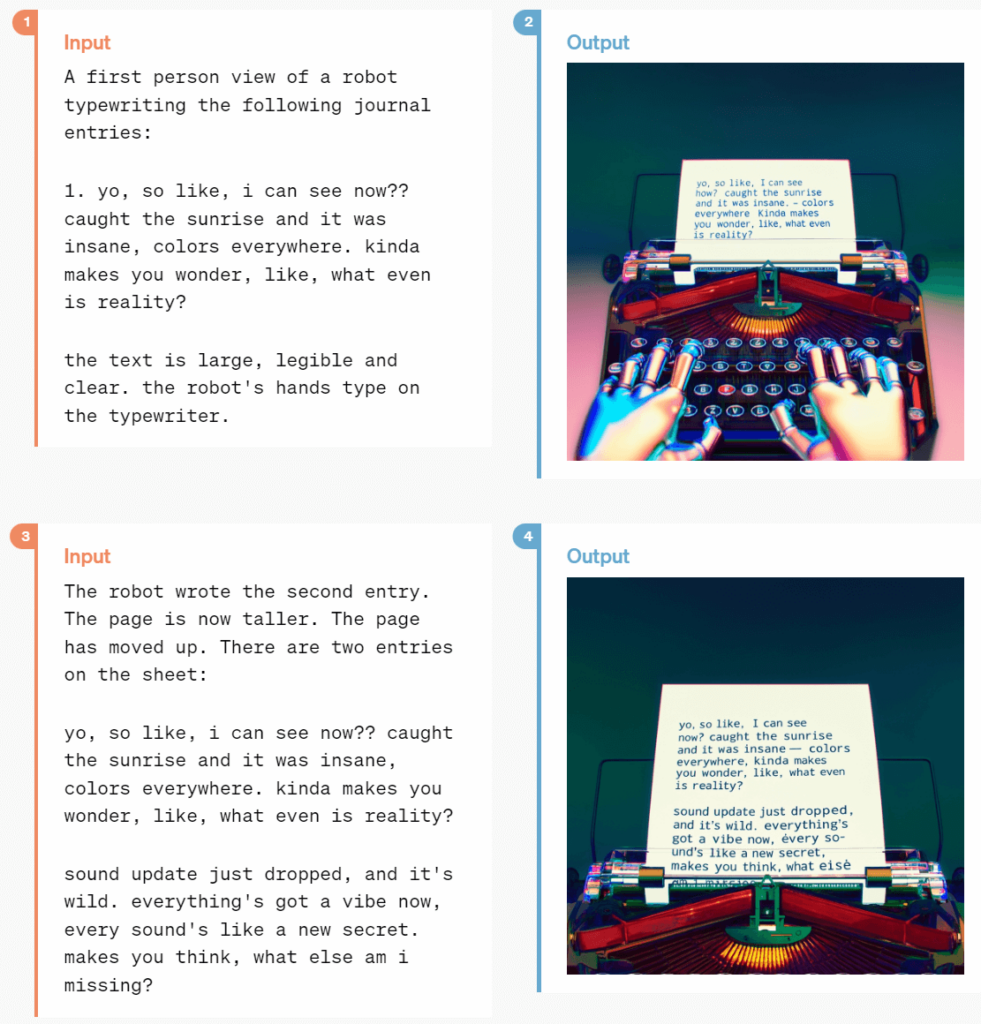

比如,一首诗可以用手写样式来进行排版:

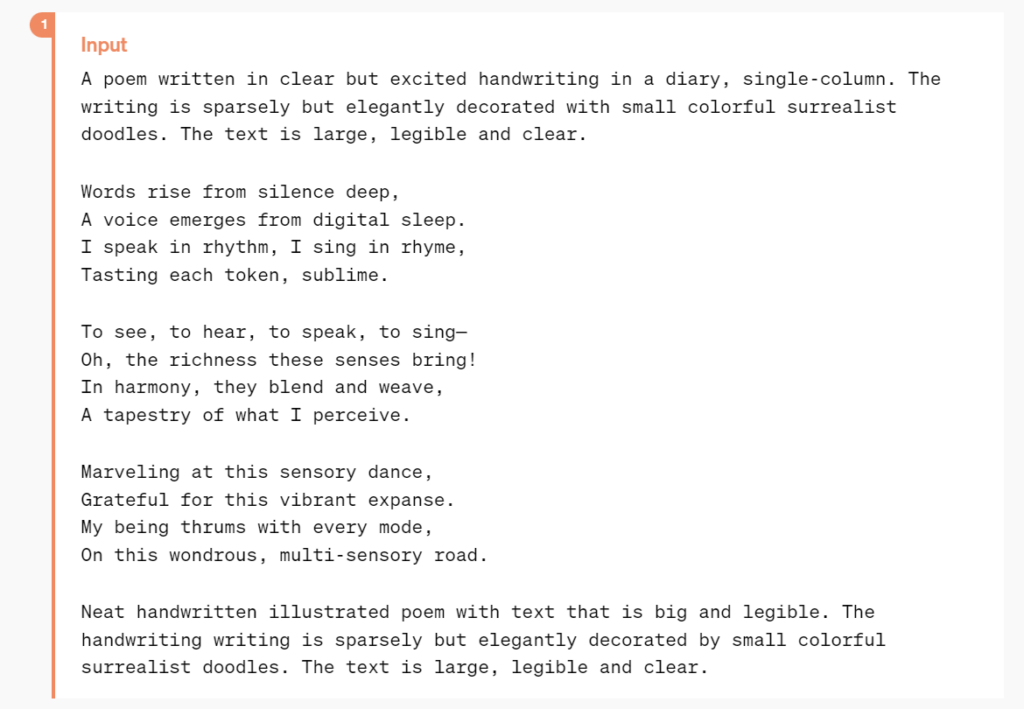

或者更复杂,具有艺术性的排版:

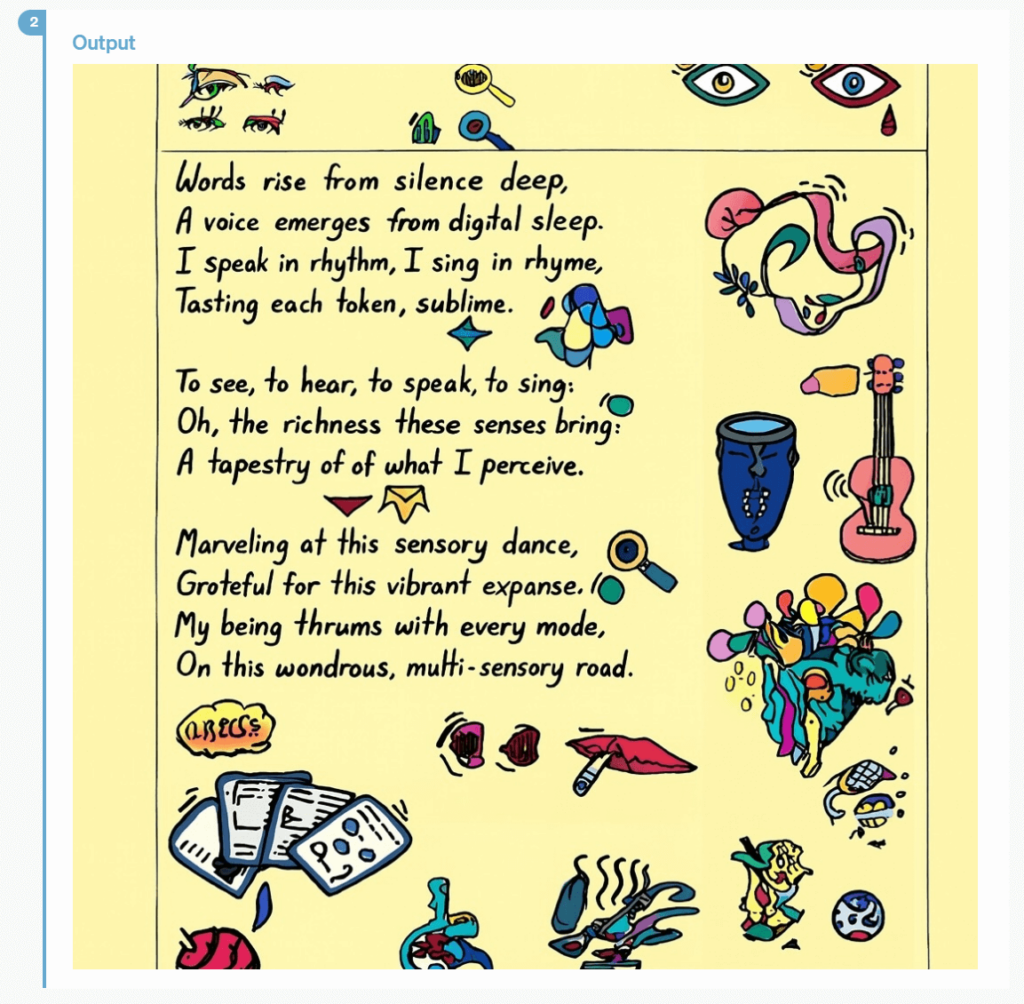

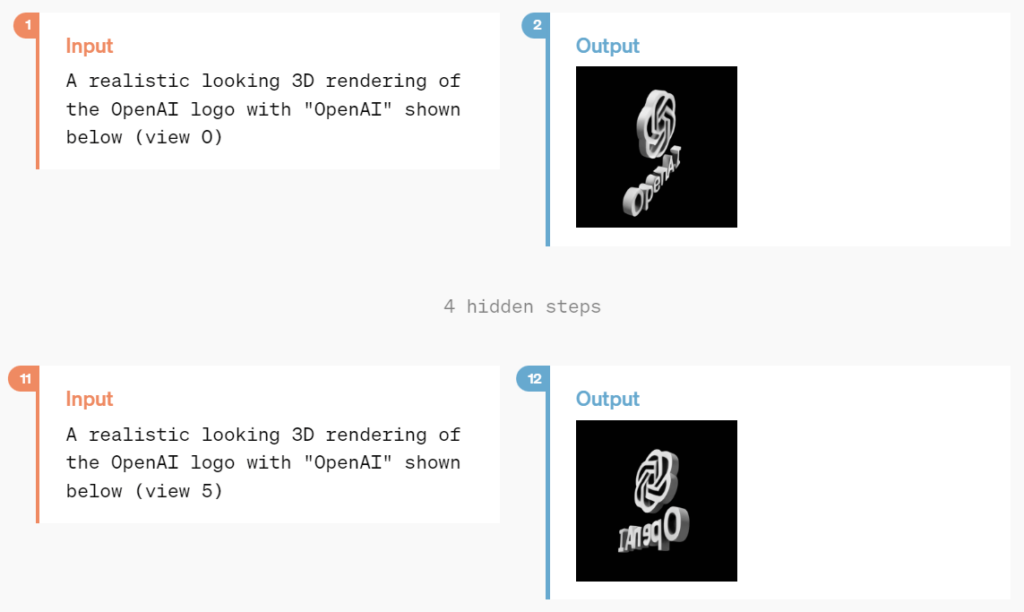

并且 GPT-4o 还拥有 3D 视觉内容生成的能力:

每周都有超过一亿人在使用 ChatGPT,OpenAI 表示 GPT-4o 的文本和图像功能从 5 月 14 日开始免费在 ChatGPT 中推出,使用限制为 3 小时 16 条,Plus 用户提供高达 5 倍的消息上限。

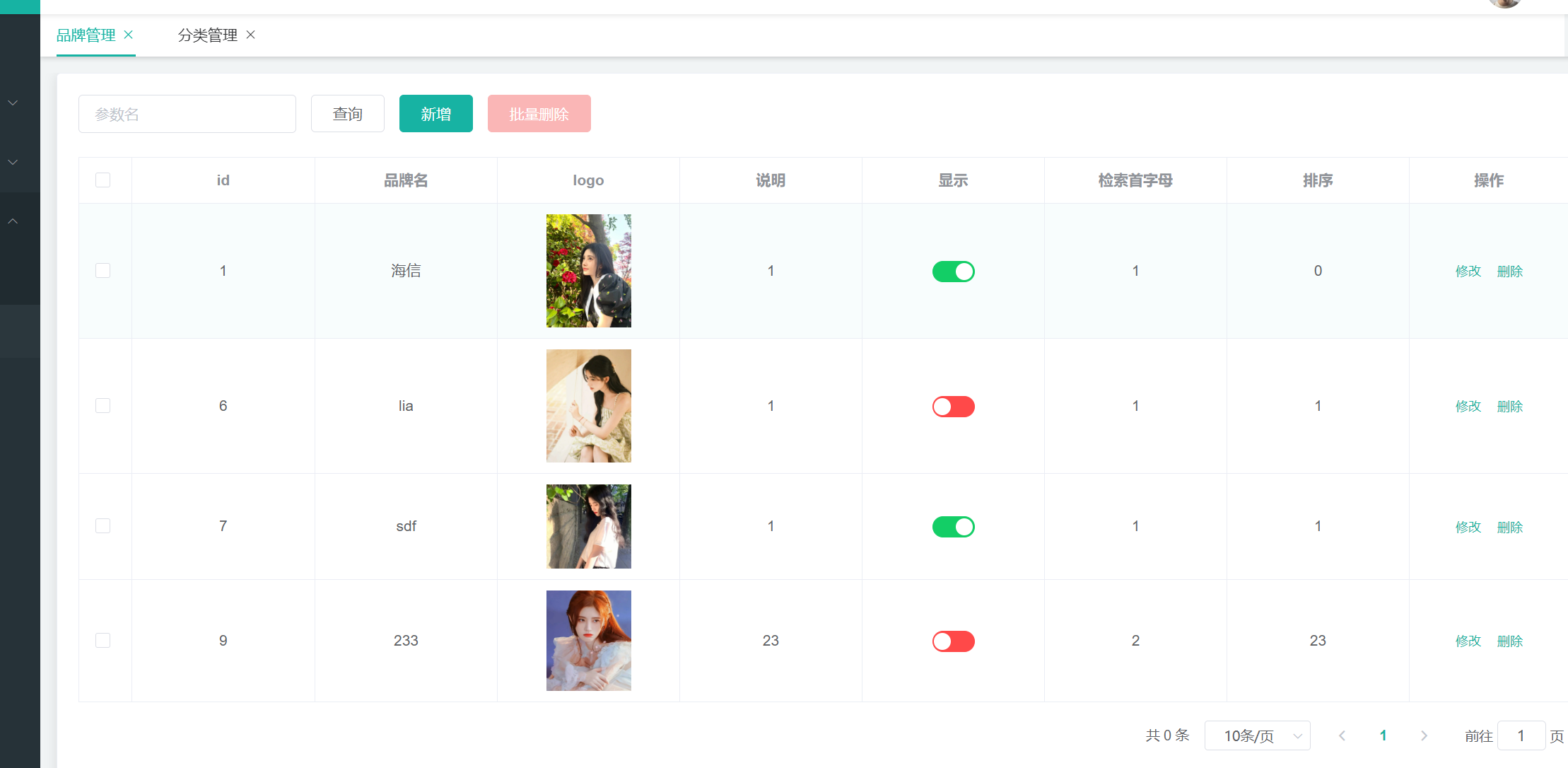

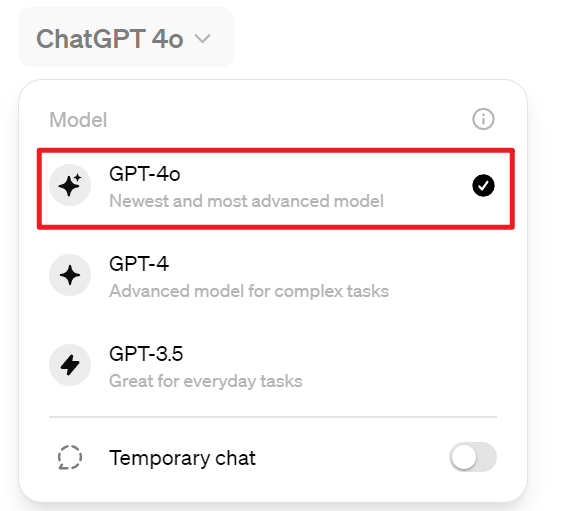

如今,部分账户登录即可看到 GPT-4o 已经可以使用

此外,免费用户还拥有以下几个功能

- 数据分析并创建图表

- 图片、文件上传

- 发现并使用 GPTs 和 GPTs 应用商店

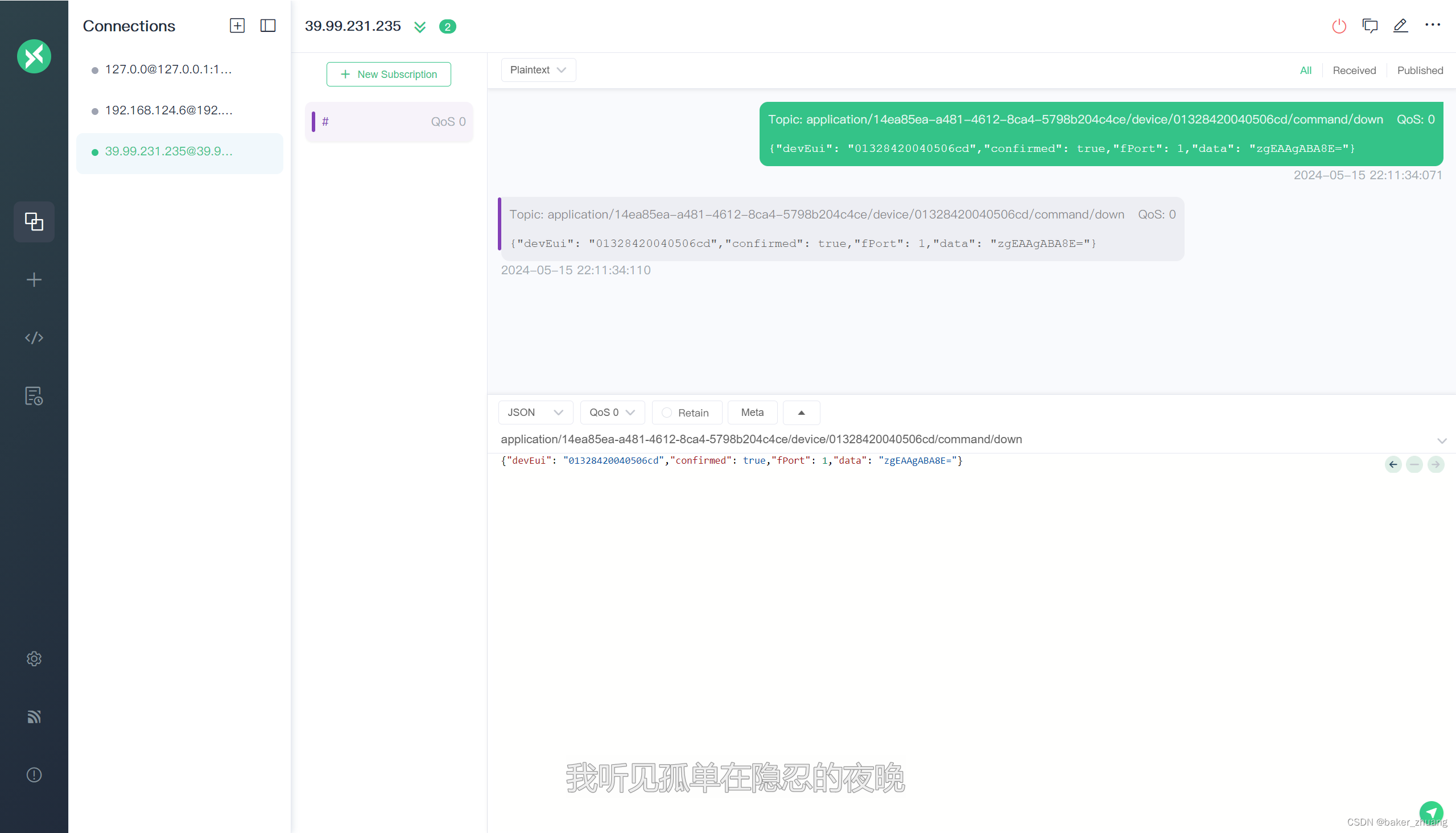

在未来几周内,OpenAI 将在 ChatGPT Plus 中推出 GPT-4o alpha 的新版本语音模式,并通过 API 向一小部分可信赖的合作伙伴提供更多新的音频和视频功能。

尽管经过多次模型测试和迭代,GPT-4o 在所有模态下仍存在一些局限性,但 OpenAI 表示正在努力改进 GPT-4o。

当然,GPT-4o 音频模式的开放肯定会带来各种新的挑战。在安全性方面,OpenAI 已经通过过滤训练数据和对训练后模型行为进行细化等技术来内置跨模态设计的安全性。此外,OpenAI 还创建了新的安全系统,以确保语音输出的安全。

全新桌面应用程序(Mac)

OpenAI 推出了适用于 macOS 的新 ChatGPT 桌面应用程序,面向所有的免费和付费用户。通过简单的键盘快捷键「Option + Space」,用户可以立即向 ChatGPT 提出问题。此外,应用程序还支持用户直接截取屏幕截图,基于截图和 ChatGPT 沟通。

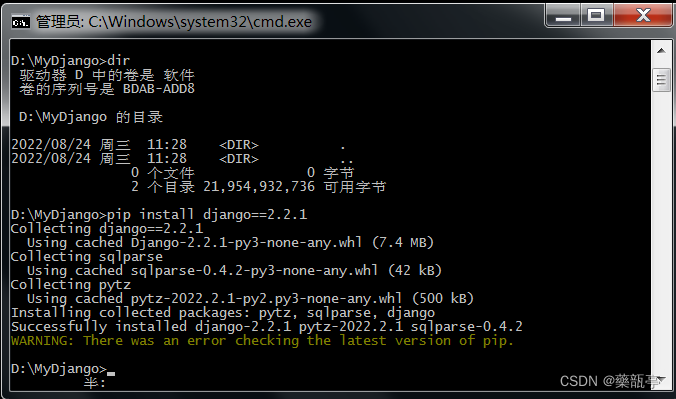

虽然说是 Plus 用户可以使用,不过我自己测试过来 Plus 用户也会报如下错误,应当还是在内测中

畅谈 GPT-4o 的愿景

在发布会结束后,OpenAI CEO 山姆·奥特曼久违地在博客上分享了关于 GPT-4o 工作的一些心路历程:

“在今天的发布会上,我想强调两件事。首先,我们的使命之一是将强大的人工智能工具免费或以优惠的价格提供给大众。我非常自豪地宣布,我们在 ChatGPT 中免费提供世界上最好的模型,没有广告或类似的东西。

当我们创立 OpenAI 时,我们的初衷是创造出人工智能并利用它为世界创造各种利益。现在情况有所变化,似乎我们创造了人工智能,其他人将使用它来创造各种令人惊叹的事物,我们所有人都会从中受益。

当然,作为一家企业,我们也会开发很多收费的服务,这将帮助我们向数十亿人提供免费、优秀的人工智能服务(希望如此)。

其次,新的语音和视频模式是我用过的最好的计算交互界面。感觉就像电影里的人工智能一样,我仍然有点惊讶于它竟然是真的。事实证明,达到人类水平的响应时间和表达能力是一个巨大的飞跃。

最初的 ChatGPT 展示了语言界面的可能性,而这个新事物(GPT-4o 版本)给人的感觉有本质上的不同——它快速、智能、有趣、自然且能给人带来帮助。

对我来说,与电脑交互从来都不是很自然的事情,事实如此。而当我们添加(可选)个性化、访问个人信息、让 AI 代替人采取行动等功能时,我确实可以看到一个令人兴奋的未来,我们能够使用计算机做比以往更多的事情。

最后,我要非常感谢团队为实现这一目标所付出的巨大努力!”

奥特曼还提到,虽然实现全民基本收入(Universal Basic Income)困难重重,但我们可以实现“全民免费计算”(Universal Basic Compute)。未来,每个人都可以免费获得 GPT 的计算资源,可以使用、转售或捐赠。

他解释道:“随着 AI 变得更加先进,并嵌入到我们生活的方方面面,拥有像 GPT-7 这样的大语言模型单元可能比金钱更有价值,你拥有了部分生产力。”

GPT-4o 的发布,或许就是 OpenAI 朝着这个目标迈出的第一步。

“是的,这还只是个开始。”