模型输入 Prompts

一个语言模型的提示是用户提供的一组指令或输入,用于引导模型的响应,帮助它理解上下文并生成相关和连贯的基于语言的输出,例如回答问题、完成句子或进行对话。

- 提示模板(Prompt Templates):参数化的模型输入

- 示例选择器(Example Selectors):动态选择要包含在提示中的示例 fewshots 提示样例选择

提示模板 Prompt Templates

Prompt Templates 提供了一种预定义、动态注入、模型无关和参数化的提示词生成方式,以便在不同的语言模型之间重用模板。

一个模板可能包括指令、少量示例以及适用于特定任务的具体背景和问题。

通常,提示要么是一个字符串(LLMs),要么是一组聊天消息(Chat Model)。

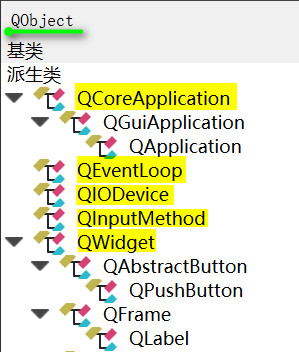

类继承关系:

lua

复制代码

BasePromptTemplate --> PipelinePromptTemplate

StringPromptTemplate --> PromptTemplate

FewShotPromptTemplate

FewShotPromptWithTemplates

BaseChatPromptTemplate --> AutoGPTPrompt

ChatPromptTemplate --> AgentScratchPadChatPromptTemplate

BaseMessagePromptTemplate --> MessagesPlaceholder

BaseStringMessagePromptTemplate --> ChatMessagePromptTemplate

HumanMessagePromptTemplate

AIMessagePromptTemplate

SystemMessagePromptTemplate

PromptValue --> StringPromptValue

ChatPromptValue

代码实现:github.com/langchain-a…

使用 PromptTemplate 类生成提升词

通常,PromptTemplate 类的实例,使用Python的str.format语法生成模板化提示;也可以使用其他模板语法(例如jinja2)。

使用 from_template 方法实例化 PromptTemplate

python

复制代码

from langchain import PromptTemplate

prompt_template = PromptTemplate.from_template(

"Tell me a {adjective} joke about {content}."

)

# 使用 format 生成提示

prompt = prompt_template.format(adjective="funny", content="chickens")

print(prompt)

# 输出样例

Tell me a funny joke about chickens.

使用构造函数(Initializer)实例化 PromptTemplate

使用构造函数实例化 prompt_template 时必须传入参数:input_variables 和 template。

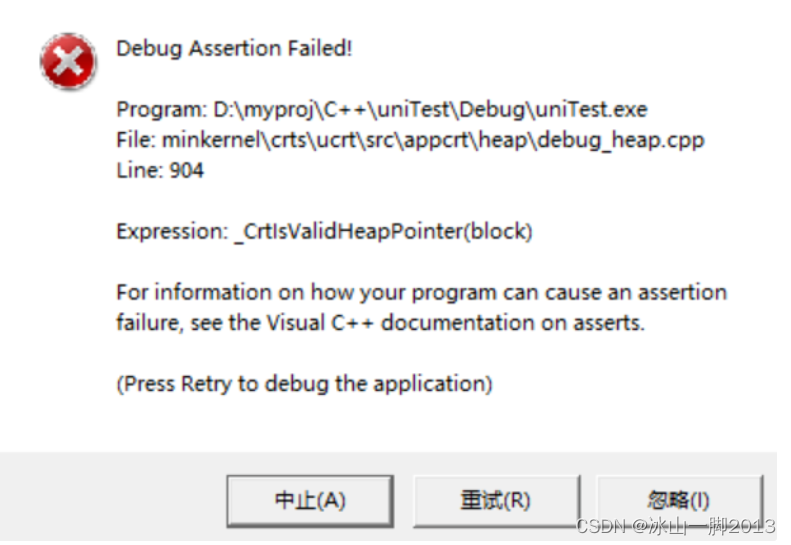

在生成提示过程中,会检查输入变量与模板字符串中的变量是否匹配,如果不匹配,则会引发异常;

示例1

python

复制代码

from langchain import PromptTemplate

from langchain_openai import OpenAI

import os

api_key = 'sk-xxx'

os.environ["OPENAI_API_KEY"] = api_key

serp_api = 'xxx'

os.environ["SERPAPI_API_KEY"] = serp_api

valid_prompt = PromptTemplate(

input_variables=["adjective", "content"],

template="Tell me a {adjective} joke about {content}"

)

prompt = valid_prompt.format(adjective="funny", content="chickens")

llm = OpenAI(model_name="gpt-3.5-turbo-instruct", max_tokens=1000)

result = llm(prompt)

print(f"result: {result}")

示例2

python

复制代码

prompt_template = PromptTemplate.from_template(

"讲{num}个给程序员听得笑话"

)

from langchain_openai import OpenAI

llm = OpenAI(model_name="gpt-3.5-turbo-instruct", max_tokens=1000)

prompt = prompt_template.format(num=2)

print(f"prompt: {prompt}")

result = llm(prompt)

print(f"result: {result}")

使用 jinja2 生成模板化提示

python

复制代码

from langchain import PromptTemplate

from langchain_openai import OpenAI

import os

api_key = 'sk-xx'

os.environ["OPENAI_API_KEY"] = api_key

serp_api = 'xxx'

os.environ["SERPAPI_API_KEY"] = serp_api

jinja2_template = "讲{{num}}个 给程序员听得笑话"

template_prompt = PromptTemplate.from_template(jinja2_template, template_format="jinja2")

prompt = template_prompt.format(num="2")

print(prompt)

llm = OpenAI(model_name="gpt-3.5-turbo-instruct", max_tokens=1000)

result = llm(prompt)

print(f"result: {result}")

使用 ChatPromptTemplate 类生成适用于聊天模型的聊天记录

ChatPromptTemplate 类的实例,使用format_messages方法生成适用于聊天模型的提示。

使用 from_messages 方法实例化 ChatPromptTemplate

python

复制代码

import os

from langchain.prompts import ChatPromptTemplate

from langchain.chat_models import ChatOpenAI

api_key = 'sk-xx'

os.environ["OPENAI_API_KEY"] = api_key

serp_api = 'xxx'

os.environ["SERPAPI_API_KEY"] = serp_api

template = ChatPromptTemplate.from_messages([

("system", "You are a helpful AI bot. Your name is {name}."),

("human", "Hello, how are you doing?"),

("ai", "I'm doing well, thanks!"),

("human", "{user_input}"),

])

# 生成提示

messages = template.format_messages(

name="Bob",

user_input="What is your name?"

)

print(messages)

chat_model = ChatOpenAI(model_name="gpt-3.5-turbo", max_tokens=1000)

result = chat_model(messages)

print(result)

摘要总结

python

复制代码

import os

from langchain.prompts import ChatPromptTemplate

from langchain.chat_models import ChatOpenAI

api_key = 'sk-xxx'

os.environ["OPENAI_API_KEY"] = api_key

serp_api = 'xxxx'

os.environ["SERPAPI_API_KEY"] = serp_api

summary_template = ChatPromptTemplate.from_messages([

("system", "你将获得关于同一主题的{num}篇文章(用-----------标签分隔)。首先总结每篇文章的论点。然后指出哪篇文章提出了更好的论点,并解释原因。"),

("human", "{user_input}"),

])

# 生成提示

messages = summary_template.format_messages(

num=3,

user_input='''1. [PHP是世界上最好的语言]

PHP是世界上最好的情感派编程语言,无需逻辑和算法,只要情绪。它能被蛰伏在冰箱里的PHP大神轻易驾驭,会话结束后的感叹号也能传达对代码的热情。写PHP就像是在做披萨,不需要想那么多,只需把配料全部扔进一个碗,然后放到服务器上,热乎乎出炉的网页就好了。

-----------

2. [Python是世界上最好的语言]

Python是世界上最好的拜金主义者语言。它坚信:美丽就是力量,简洁就是灵魂。Python就像是那个永远在你皱眉的那一刻扔给你言情小说的好友。只有Python,你才能够在两行代码之间感受到飘逸的花香和清新的微风。记住,这世上只有一种语言可以使用空格来领导全世界的进步,那就是Python。

-----------

3. [Java是世界上最好的语言]

Java是世界上最好的德育课编程语言,它始终坚守了严谨、安全的编程信条。Java就像一个严格的老师,他不会对你怀柔,不会让你偷懒,也不会让你走捷径,但他教会你规范和自律。Java就像是那个喝咖啡也算加班费的上司,拥有对邪恶的深度厌恶和对善良的深度拥护。

'''

)

print(messages)

chat_model = ChatOpenAI(model_name="gpt-3.5-turbo", max_tokens=1000)

result = chat_model(messages)

print(result)

使用 FewShotPromptTemplate 类生成 Few-shot Prompt

构造 few-shot prompt 的方法通常有两种:

- 方法1 从示例集(set of examples)中手动选择;

- 方法2 通过示例选择器(Example Selector)自动选择.

示例选择器 Example Selectors

如果你有大量的参考示例,就得选择哪些要包含在提示中。最好还是根据某种条件或者规则来自动选择,Example Selector 是负责这个任务的类。

BaseExampleSelector 定义如下:

python

复制代码

class BaseExampleSelector(ABC):

"""用于选择包含在提示中的示例的接口。"""

@abstractmethod

def select_examples(self, input_variables: Dict[str, str]) -> List[dict]:

"""根据输入选择要使用的示例。"""

ABC 是 Python 中的 abc 模块中的一个缩写,它表示 “Abstract Base Class”(抽象基类)。在 Python 中,抽象基类用于定义其他类必须遵循的基本接口或蓝图,但不能直接实例化。其主要目的是为了提供一种形式化的方式来定义和检查子类的接口。

使用抽象基类的几点关键信息:

- 抽象方法:在抽象基类中,你可以定义抽象方法,它没有实现(也就是说,它没有方法体)。任何继承该抽象基类的子类都必须提供这些抽象方法的实现。

- 不能直接实例化:你不能直接创建抽象基类的实例。试图这样做会引发错误。它们的主要目的是为了被继承,并在子类中实现其方法。

- 强制子类实现:如果子类没有实现所有的抽象方法,那么试图实例化该子类也会引发错误。这确保了继承抽象基类的所有子类都遵循了预定的接口。

如何系统的去学习大模型LLM ?

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的 AI大模型资料 包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

😝有需要的小伙伴,可以V扫描下方二维码免费领取🆓

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

阶段1:AI大模型时代的基础理解

- 目标:了解AI大模型的基本概念、发展历程和核心原理。

- 内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践 - L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

- 目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

- 内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例 - L2.2 Prompt框架

- L2.2.1 什么是Prompt

- L2.2.2 Prompt框架应用现状

- L2.2.3 基于GPTAS的Prompt框架

- L2.2.4 Prompt框架与Thought

- L2.2.5 Prompt框架与提示词 - L2.3 流水线工程

- L2.3.1 流水线工程的概念

- L2.3.2 流水线工程的优点

- L2.3.3 流水线工程的应用 - L2.4 总结与展望

- L2.1 API接口

阶段3:AI大模型应用架构实践

- 目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

- 内容:

- L3.1 Agent模型框架

- L3.1.1 Agent模型框架的设计理念

- L3.1.2 Agent模型框架的核心组件

- L3.1.3 Agent模型框架的实现细节 - L3.2 MetaGPT

- L3.2.1 MetaGPT的基本概念

- L3.2.2 MetaGPT的工作原理

- L3.2.3 MetaGPT的应用场景 - L3.3 ChatGLM

- L3.3.1 ChatGLM的特点

- L3.3.2 ChatGLM的开发环境

- L3.3.3 ChatGLM的使用示例 - L3.4 LLAMA

- L3.4.1 LLAMA的特点

- L3.4.2 LLAMA的开发环境

- L3.4.3 LLAMA的使用示例 - L3.5 其他大模型介绍

- L3.1 Agent模型框架

阶段4:AI大模型私有化部署

- 目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

- 内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

学习计划:

- 阶段1:1-2个月,建立AI大模型的基础知识体系。

- 阶段2:2-3个月,专注于API应用开发能力的提升。

- 阶段3:3-4个月,深入实践AI大模型的应用架构和私有化部署。

- 阶段4:4-5个月,专注于高级模型的应用和部署。

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓