文章目录

- 背景

- 构建自动化内容生产平台

- 系统架构设计

- 架构详细设计

- 流程介绍

- 笔记来源

- 笔记抓取干预

- 笔记 AIGC 赋能

- 笔记 Rule 改写

- 笔记特征库构建

- 附录

- Bash Cron 定时任务

- Golang 与 Pyhon AIGC 实践

- 小结

背景

在大模型的浪潮下,ChatGPT、Sora、Gemini、文言一心 等新技术不断涌现。如何将新技术融合至业务落地,开辟新赛道、提升产品竞争力 是大家比较关心的。因为一旦新融合场景契合可行,对人们生产、生活将是里程碑的创新、跃进。

本文将介绍基于 LLM[大模型]、利用 AIGC 为笔记生产赋能。

主要场景为地图。可简要概括为,利用人工智能手段生成地图类特征笔记,以便于在地图类场景分发【商业路径这里不做赘述】。

注:地图场景可替换为其他场景,前提是具备其垂类场景的模型。

构建自动化内容生产平台

要实现在地图垂类场景下笔记的分发,需要稳定的、高质的内容不断生成。形成规模化后,用户习惯、心智才会逐渐培养、形成。

就持续性、规模化 而言,自动化是达成目标的之一路径。

首要任务是搭建一个可自动化生产内容的系统。同时,构建内容管理平台,是为了支持:数据量化、手动干预(紧急上/下线)、内容提质 等衍生能力。

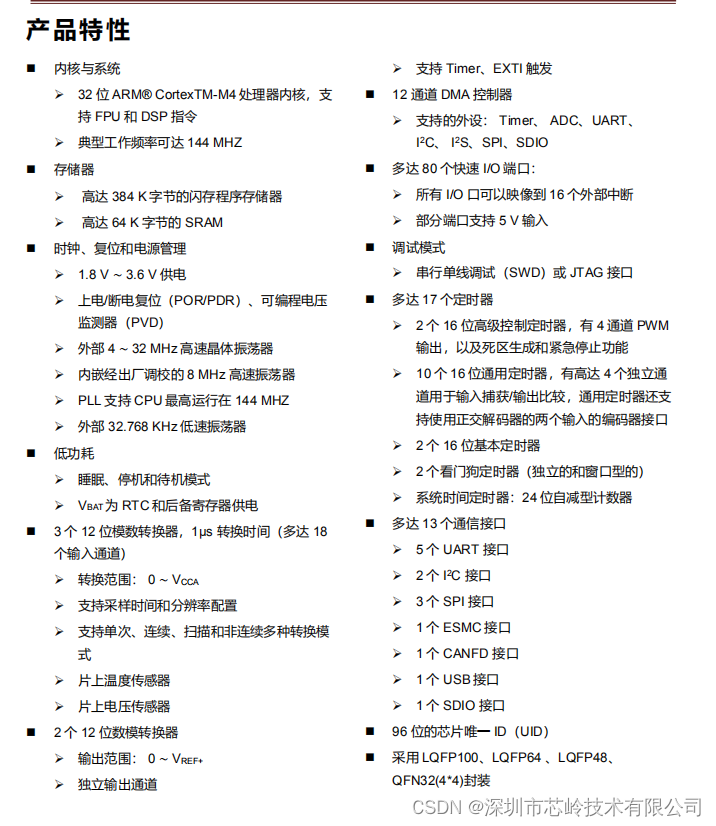

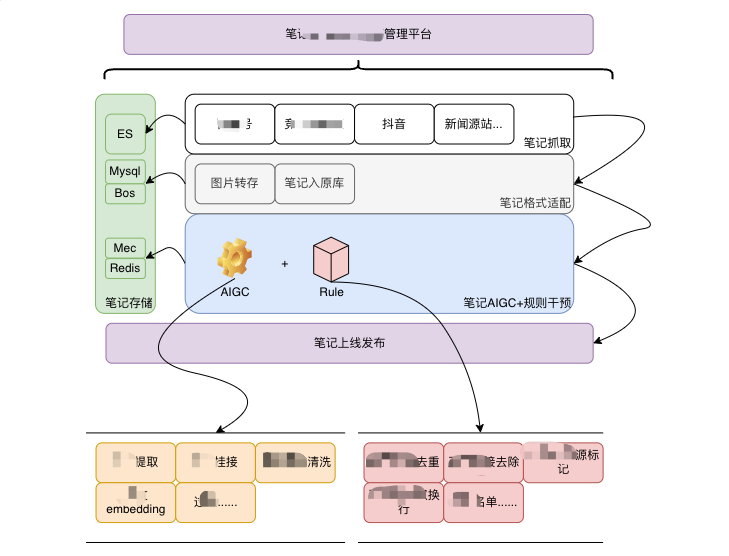

系统架构设计

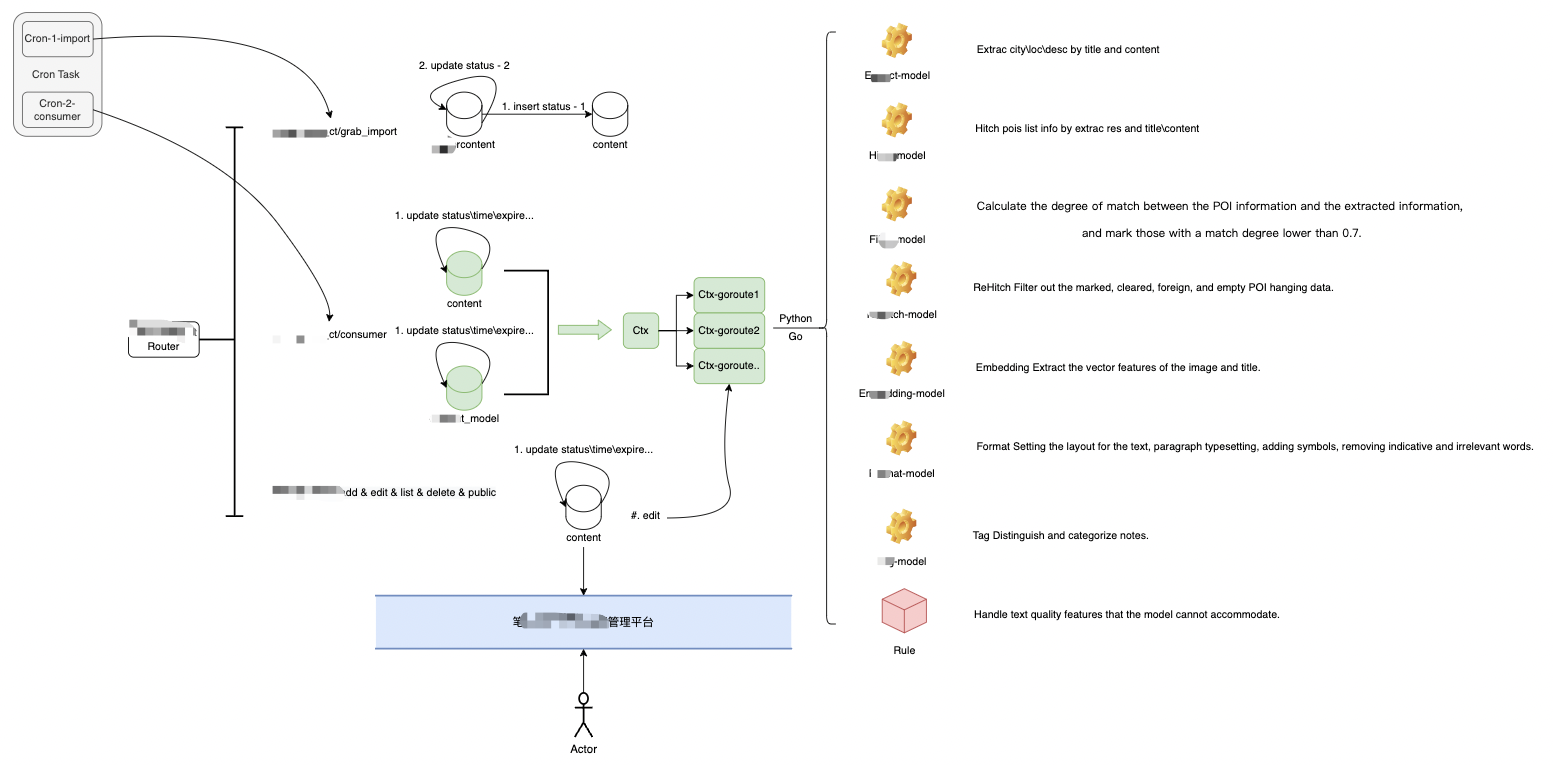

架构详细设计

流程介绍

笔记来源

在实际场景中,笔记来源并不能像 “测试” 或者 “Demo” 一样,随便给几个 Prompt ,利用模型生成一篇。这样的笔记也不会被用户人群关注,没有实用、情感、或者其他价值。

就有价值的笔记源来说,实时咨询、财经、文娱、旅游…等垂类信息是较好的来源。

我们可以通过爬虫,对新闻类、财经类、旅游类…等网站进行内容抓取,作为笔记数据源。

笔记抓取干预

有了稳定的数据源之后,需要对内容进行清洗、过滤,通过 “漏洞策略” ,提出契合 “地图特征“ 的笔记。

这里的策略可以是简单的黑白名单,主要是进行 ”粗筛“ ,精细化的清洗将会交给 LLM 处理。

笔记 AIGC 赋能

经过笔记抓取、粗略干预后的笔记,基本可以保证是覆盖 ”地图特征“ 的,但其中含有杂质,且缺少精细化的挂接。

- 比如,错误的位置信息、文章和主题的匹配度、水文、软广 等杂质。

- 再比如,相关位置信息没有对应的 loc 位置坐标,无法构建特征数据等。

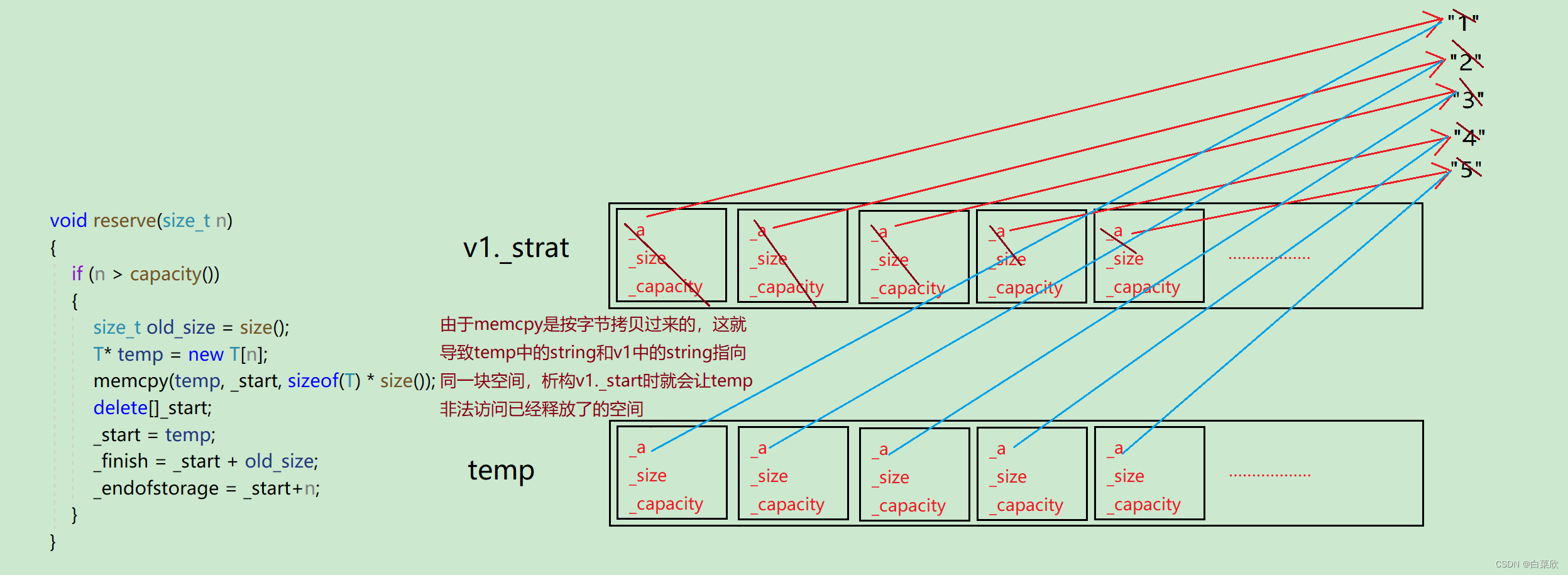

这就需要通过 LLM 基于 位置信息进行训练,进而利用 模型组成系列模组,对内容重新进行赋能。

考虑到笔记文章的质量、后续的特征建库、及分发,这里主要进行下列模型处理:

- Extract-model:Extrac city\loc\desc by title and content

- Hitch-model:Hitch pois list info by extrac res and title\content

- Filter-model:Calculate the degree of match between the POI information and the extracted information, and mark those with a

match degree lower than 0.7. - Embedding-model:Embedding Extract the vector features of the image and title.

- …

经过这些模型处理后,剩下的笔记基本上就符合后续的分发,且质量完全可以得到保证。

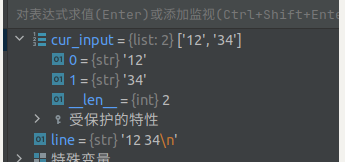

笔记 Rule 改写

AIGC 赋能后,在实际生产中发现,人工智能并不能解决全部问题。

像文本换行、特殊字符处理、文本提示/引导词/敏感词过滤,还是需要辅助以规则,进行外层兜底策略处理,对笔记进行改写。

笔记特征库构建

TODO

附录

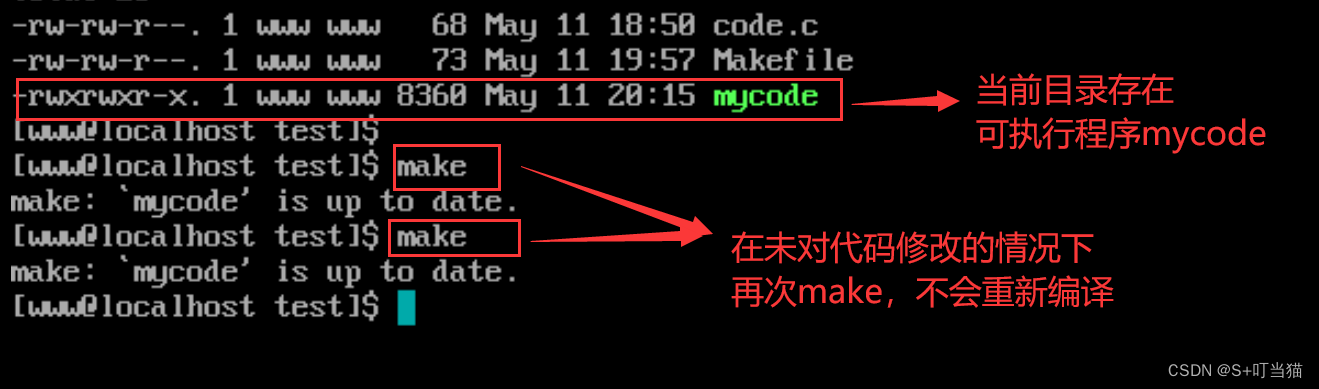

Bash Cron 定时任务

* 具体脚本代码可私信。

* * * * * cd /home/map/work/cron && sh import.sh >/dev/null 2>&1

*/10 * * * * cd /home/map/work/cron && sh consumer.sh >/dev/null 2>&1

Golang 与 Pyhon AIGC 实践

output, err := exec.Command("python3", rootDir+"/scripts/handler.py", url, fileName, env.RootDir()+"/imgfile/").CombinedOutput()

#!usr/bin/env python

# -*- coding:utf-8 _*-

import re

import sys

import json

# 检查文件是否存在,如果不存在则创建

if not os.path.exists(LOCKFILE):

with open(LOCKFILE, 'w') as f:

f.write('0') # 写入初始并发计数

# 最大并发数

MAX_CONCURRENT = 4

......

小结

在实际生产中,已经证明 “ 通过 大模型 和 AIGC 加持, 与垂类业务相结合 ” 的道路是完全行的通的。并且生产力、产品质量 都有惊人的提升,具备很高的发展潜能及空间。

由于篇幅有限,具体特征库构建及内容分发在后续博文介绍。