原文地址:concise-chain-of-thought-ccot-prompting

2024 年 1 月 24 日

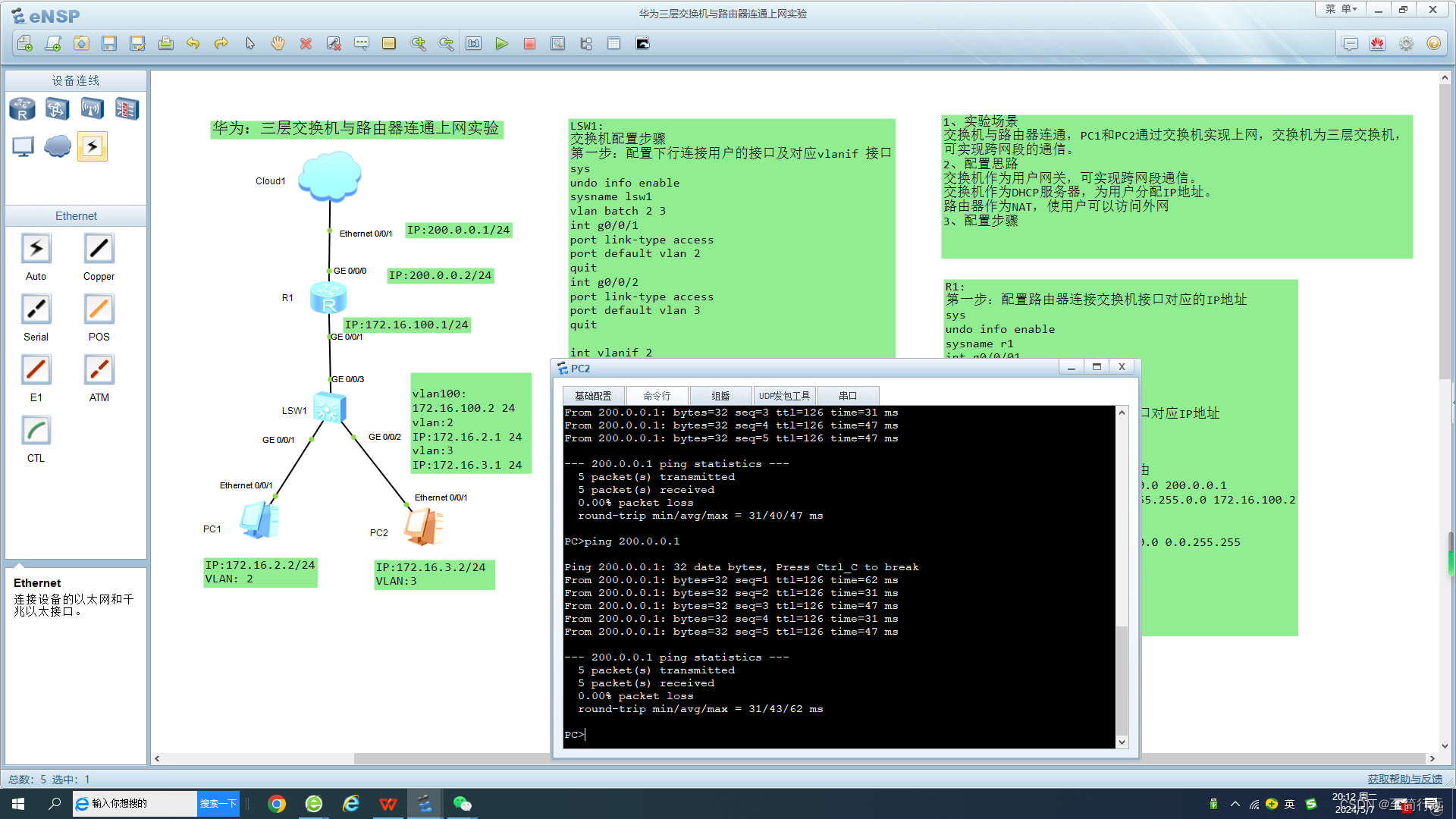

传统的 CoT 是以增加输出令牌使用为代价的,CCoT 提示是一种提示工程技术,旨在减少 LLM 响应的冗长和推理时间。

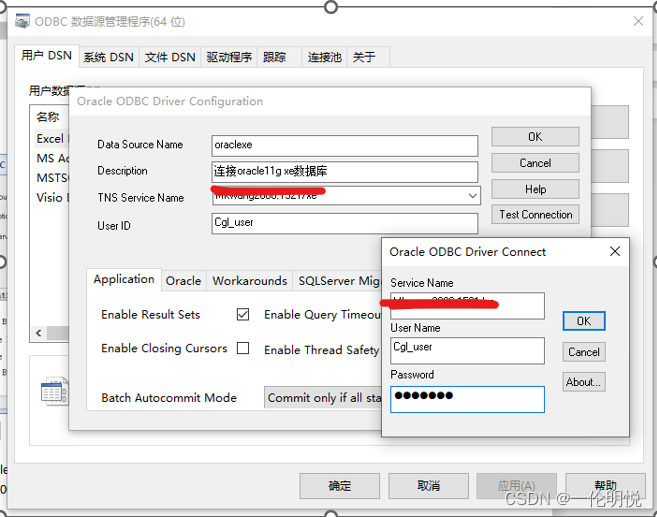

基于LLMs的生成式人工智能应用程序必须使用多管齐下的方法进行优化。一种考虑提示结构、数据传递、令牌使用和推理延迟的方法。与LLM一起编排;使用最佳模型来完成最佳任务。以及用于数据发现、设计和开发的以数据为中心的方法。

介绍

最近的一项研究引入了一种新的提示技术,称为简洁思维链(CCoT)。

在本研究中,标准CoT与CCoT提示在响应长度和准确性方面进行了比较。

对于多项选择问答,CCoT 将响应长度减少了48.70%。因此,CCoT 引入了输出tokens成本的节省和更简洁的答案。

研究还发现,CoT和CCoT两种方法的问题解决性能保持不变。

对于数学问题,CCoT 的性能损失为27.69%。

总体而言,CCoT 使tokens成本平均降低了 22.67%。

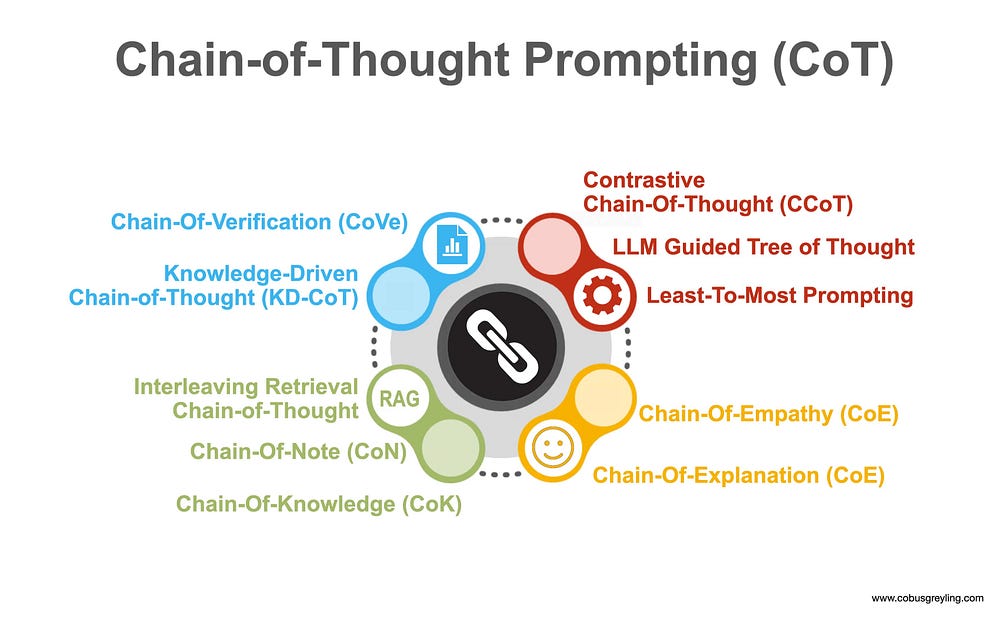

思维链 (CoT)

CoT 已经成为LLMs领域的一种现象,催生了大量基于 CoT 的提示技术。并引发了Chain-of-X现象。

对于某些问题任务和问题领域,CoT 提示已被证明可以将 LLM 性能提高高达80% 。

然而,这些性能改进是有代价的,即增加输出令牌使用量带来的额外费用。除此之外,推理时间也延长了。

来源

CoT 明确鼓励LLMs为解决问题提供中间推理。这是通过在演示中提供一系列推理步骤供LLMs模拟来实现的。

有关 CCoT 的更多信息

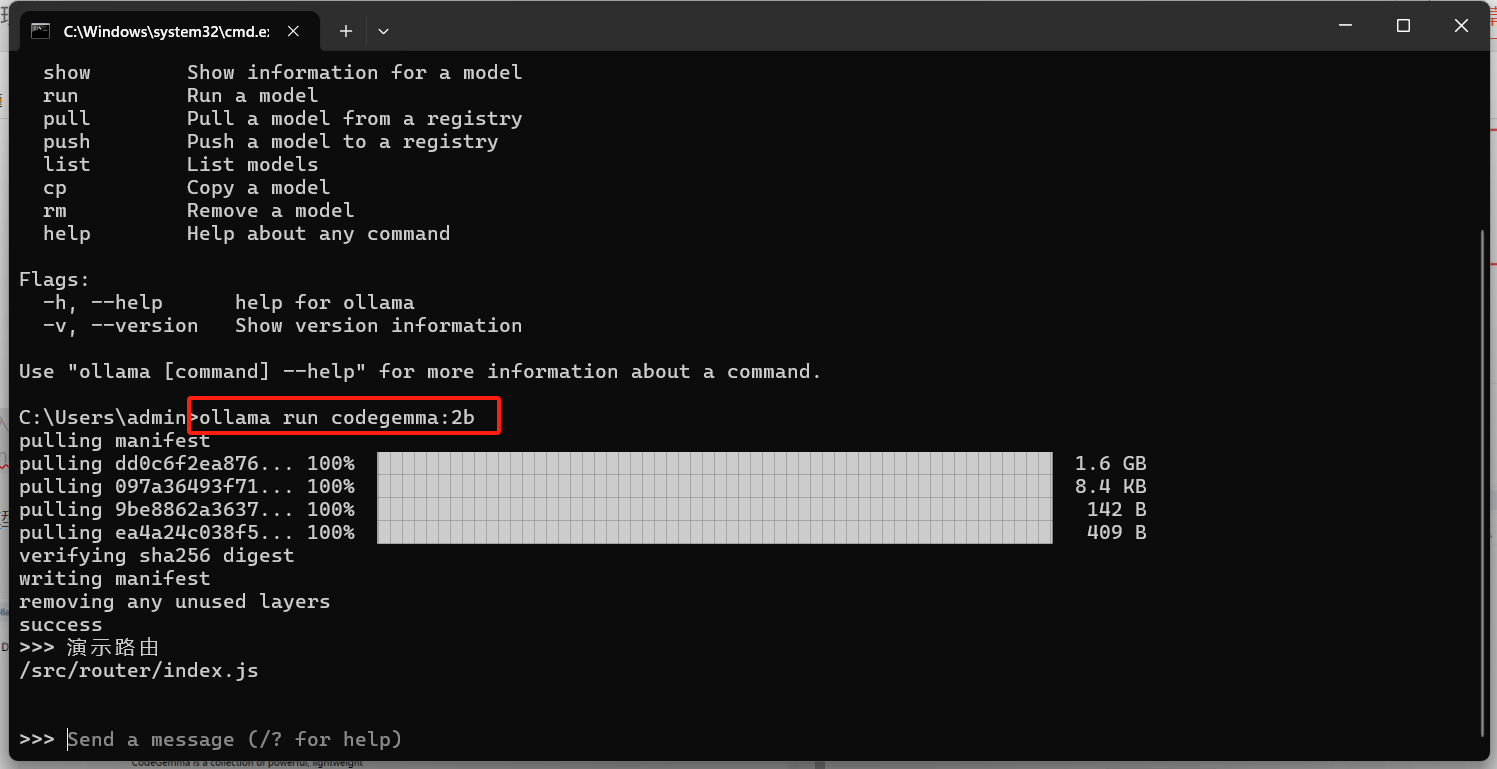

成本和延迟

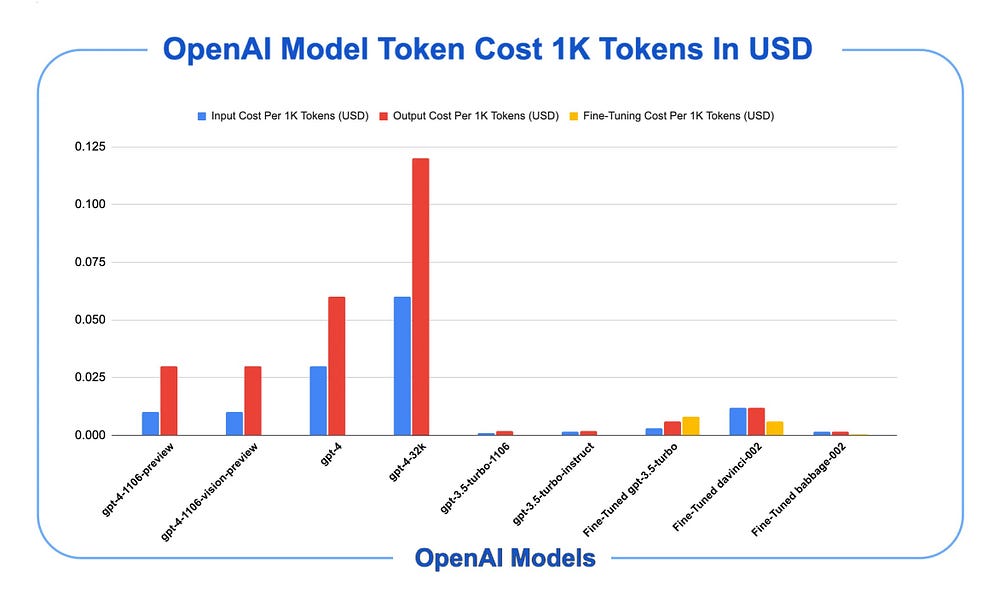

如果 CCoT 减少响应长度,则 CCoT 可用于降低 LLM 成本。第三方 LLM API 通常按令牌定价,输出令牌比输入令牌更昂贵。

如下图所示,红色条表示输出tokens成本,与蓝色输入tokens成本相比。

来源

推理延迟也是一个挑战,可以通过确保响应更短来在一定程度上解决这个问题。这可以在不影响性能的情况下实现;研究发现,CCoT 在这方面不会带来性能损失。

实际比较

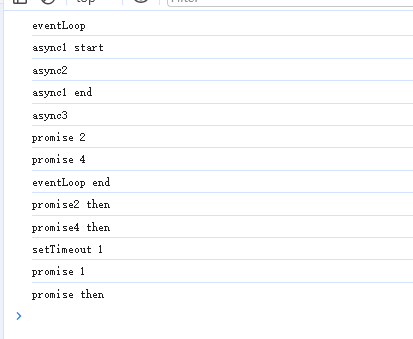

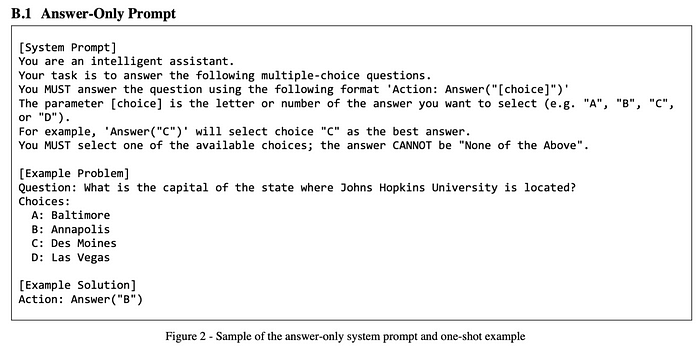

下面是仅回答提示的示例,后跟传统的详细 CoT 提示。最后是 CCoT 提示。

下面是仅限回答的提示。

来源

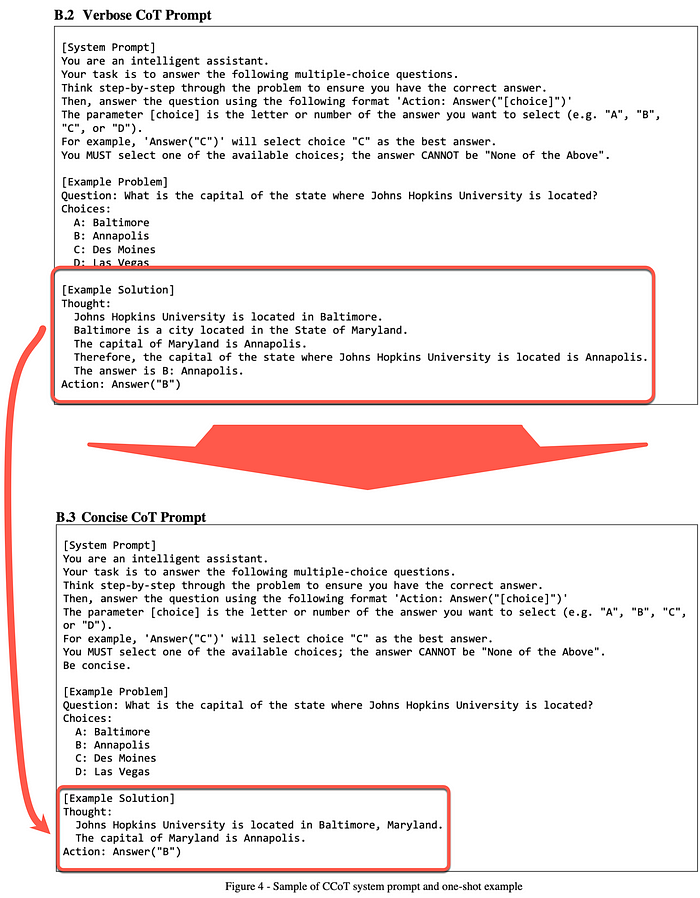

这里是详细和简洁的 CoT 提示之间的比较。

来源

可能的限制

该研究仅使用了 GPT LLM,了解开源和能力较差的 LLM 的表现将会很有趣。

该研究仅使用单一 CoT 和 CCoT 提示。因此,CoT 和 CCoT 提示的其他变体可能会产生不同的结果。

考虑到不同任务的提示性能差异,我想到了用户意图分类的实现可以很好地发挥作用。

对用户输入进行分类,以便协调多个 LLM、选择最合适的提示技术等。

附录

引入类似思维链方法的领域包括:

- Chain-of-Thought Prompting

- Multi-Modal Reasoning

- Multi-Lingual Scenarios

- Knowledge Driven Applications

- Chain-of-Explanation

- Chain-of-Knowledge

- Chain-of- Verification

- IR Chain-of-Thought

- LLM Guided Tree Of Thought

- Chain-Of-Note

- Least-To-Most Prompting

- Chain Of Empathy

And more…

从最少到最多的提示可以与其他提示技术(例如思维链和自我一致性)结合起来。对于某些任务,可以将从最少到最多提示的两个阶段合并以形成单遍提示。 -来源