(原标题:天工一刻 | 一文看懂MoE混合专家大模型)

随着大模型技术迎来颠覆性突破,新兴AI应用大量涌现,不断重塑着人类、机器与智能的关系。

为此,昆仑万维集团重磅推出《天工一刻》系列产业观察栏目。在本栏目中,我们将对大模型产业热点、技术创新、应用案例进行深度解读,同时邀请学术专家、行业领袖分享优秀的大模型行业趋势、技术进展,以飨读者。

MoE混合专家大模型最近究竟有多火?

举个例子,在此前的GTC 2024上,英伟达PPT上的一行小字,吸引了整个硅谷的目光。

“GPT-MoE 1.8T”

这行小字一出来,X(推特)上直接炸锅了。

“GPT-4采用了MoE架构”,这条整个AI圈疯传已久的传言,竟然被英伟达给“无意中”坐实了。消息一出,大量AI开发者们在社交平台上发帖讨论,有的看戏吐槽、有的认真分析、有的开展技术对比,一时好不热闹。

MoE大模型的火热,可见一斑。

近半年多以来,各类MoE大模型更是层出不穷。在海外,OpenAI推出GPT-4、谷歌推出Gemini、Mistral AI推出Mistral、连马斯克xAI的最新大模型Grok-1用的也是MoE架构。

而在国内,昆仑万维也于今年4月17日正式推出了新版MoE大语言模型「天工3.0」,拥有4000亿参数,超越了3140亿参数的Grok-1,成为全球最大的开源MoE大模型。

MoE究竟是什么?它有哪些技术原理?它的优势和缺点是什么?它又凭什么能成为当前最火的大模型技术?

以上问题,本文将逐一回答。

MoE核心逻辑:术业有专攻

MoE,全称Mixture of Experts,混合专家模型。

MoE是大模型架构的一种,其核心工作设计思路是“术业有专攻”,即将任务分门别类,然后分给多个“专家”进行解决。

与MoE相对应的概念是稠密(Dense)模型,可以理解为它是一个“通才”模型。

一个通才能够处理多个不同的任务,但一群专家能够更高效、更专业地解决多个问题。

(图片来源:《GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding》)

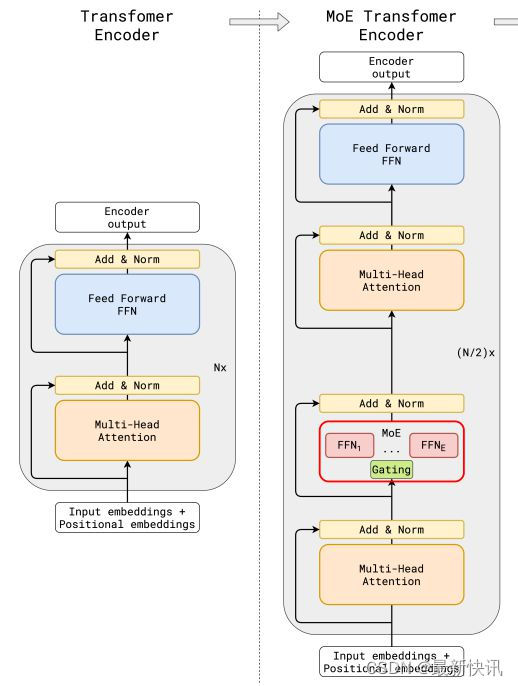

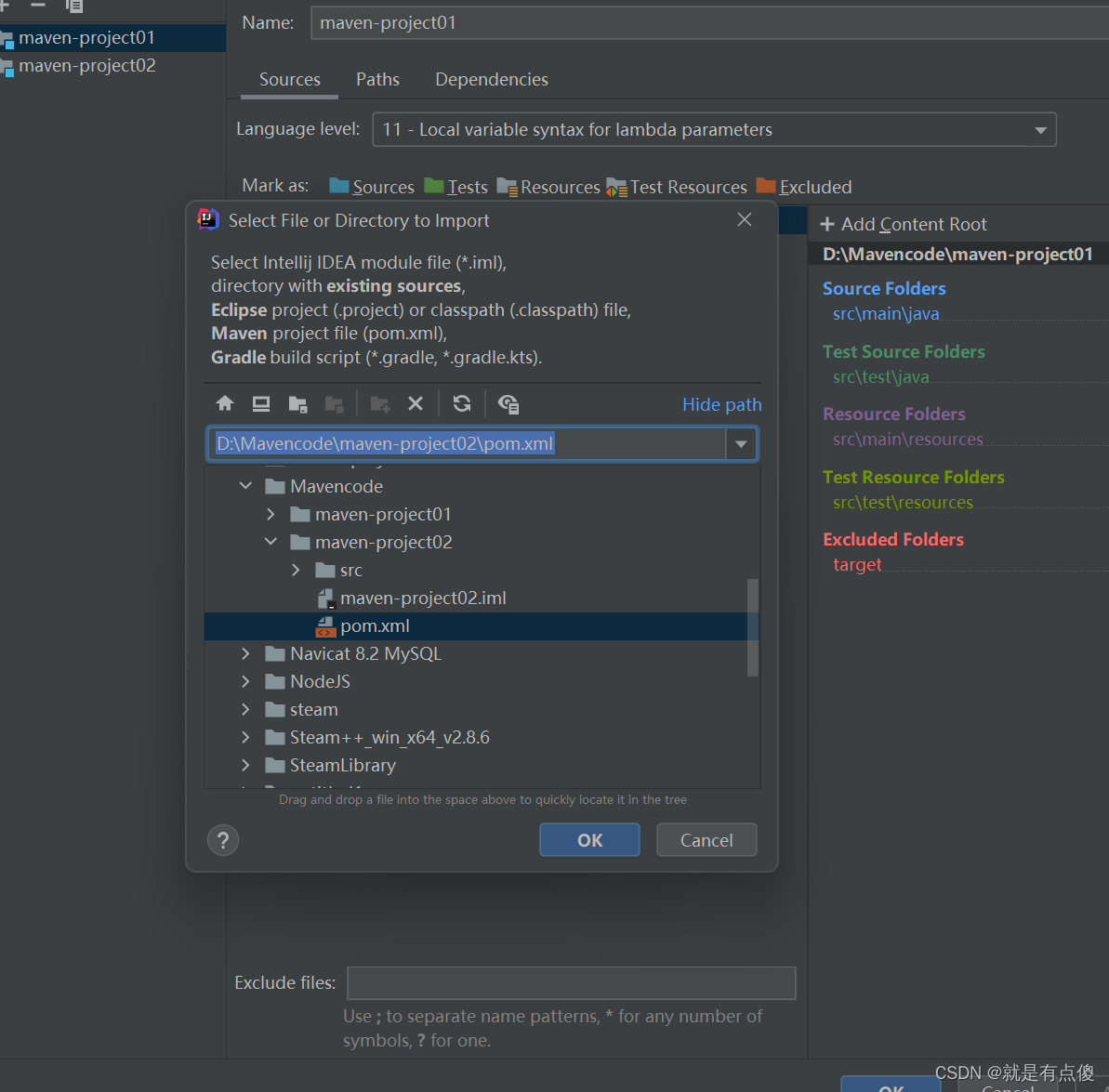

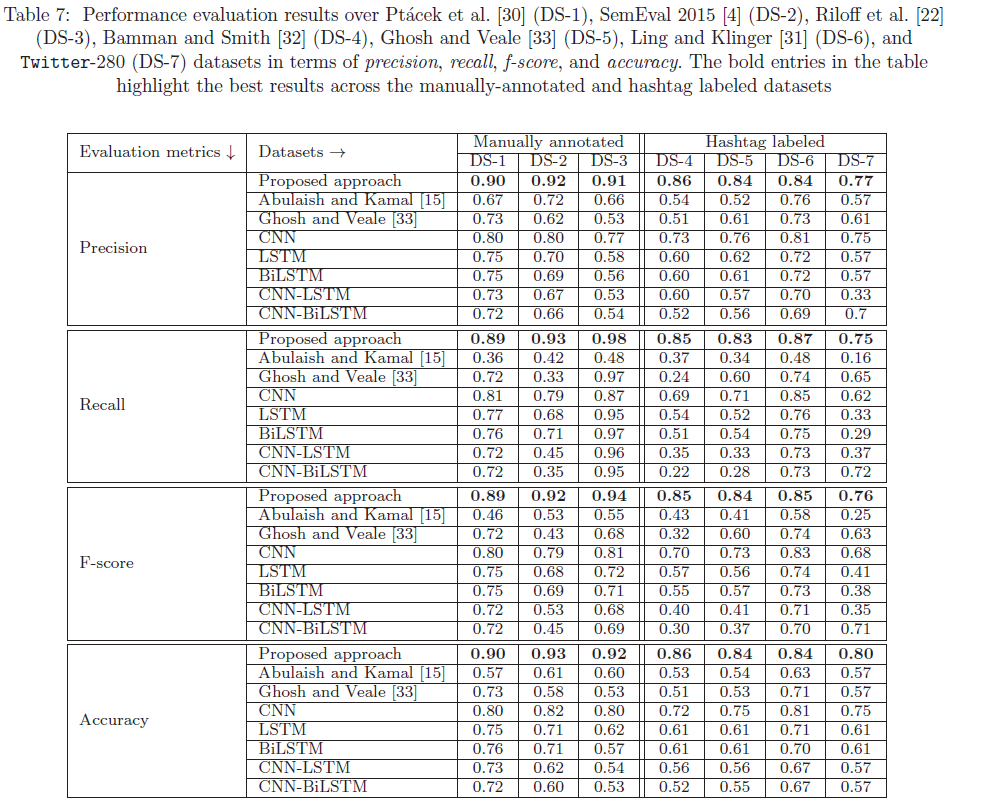

上图中,左侧图为传统大模型架构,右图为MoE大模型架构。

两图对比可以看到,与传统大模型架构相比,MoE架构在数据流转过程中集成了一个专家网络层(红框部分)。

下图为红框内容的放大展示:

(图片来源:Zian (Andy) Wang)

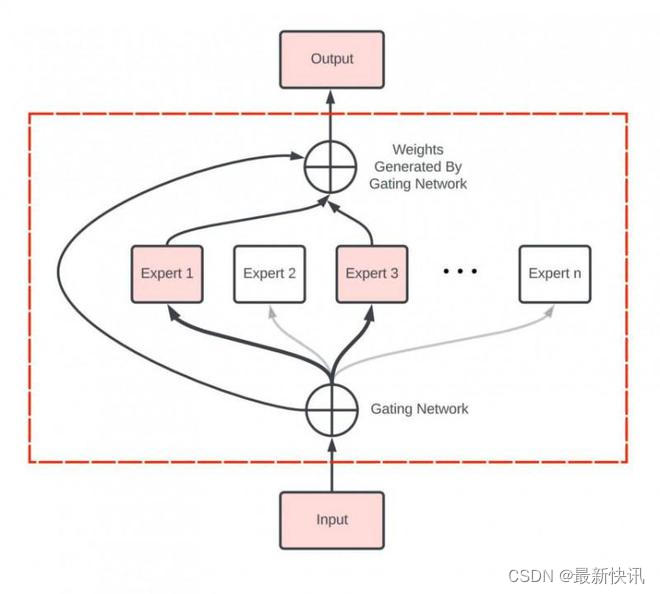

专家网络层的核心由门控网络(Gating Network)和一组专家模型(Experts)构成,其工作流程大致如下:

1、数据首先会被分割多个区块(Token),每组数据进入专家网络层时,首先会进入门控网络。

2、门控网络将每组数据分配给一个或多个专家,每个专家模型可以专注于处理该部分数据,“让专业的人做专业的事”。

3、最终,所有专家的输出结果汇总,系统进行加权融合,得到最终输出。

当然,以上只是一个概括性描述,关于门控网络的位置、模型、专家数量、以及MoE与Transformer架构的具体结合方案,各家方案都略有差别,但核心思路是一致的。

与一个“通才网络”相比,一组术业有专攻的“专家网络”能够提供更好的模型性能、更好地完成复杂的多种任务,同时,也能够在不显著增加计算成本的情况下大幅增加模型容量,让万亿参数级别的大模型成为可能。

Scaling Law:让模型更大

MoE之所以受到整个AI大模型行业的追捧,一个核心的原因是——今天的大模型,正迫切地需要变得更大。

而这一切的原因,则要追溯到Scaling Law。

Scaling Law,规模定律,也译为缩放定律。这不是一个严格的数学定律,它只是用来描述物理、生物、计算机等学科中关于系统复杂属性变化的规律。

而在大语言模型里,从Scaling Law能够衍生出一个通俗易懂的结论:

“模型越大,性能越好。”

更准确的描述是:当AI研究人员不断增加大语言模型的参数规模时,模型的性能将得到显著提升,不仅能获得强大的泛化能力,甚至出现智能涌现。

自人工智能诞生以来,人们一直试图设计出更巧妙的算法、更精密的架构,希望通过人类的智慧将机器设计得更聪明,达到通用人工智能。

但以OpenAI为代表的业内另一种声音说:“我反对!”

2019年,机器学习先驱Rich Sutton曾经发表过一篇经典文章《The Bitter Lesson》,该文几乎被全体OpenAI成员奉为圭臬。

文中认为,也许这种传统方法是一种错误的思路;也许试图用人类智慧设计出通用人工智能的这个路径,在过去几十年间,让整个行业都走了大量弯路,付出了苦涩的代价。

而真正正确的路径是:不断扩大模型规模,再砸进去天文数字的强大算力,让Scaling Law创造出更“聪明”的人工智能,而不是靠人类自己去设计。

在这一轮大模型火起来之前,遵循这一思路的科学家一直是业内的少数派,但自从GPT路线在自然语言处理上大获成功之后,越来越多研究人员加入这一阵列。

追求更大的模型,成为了人工智能性能突破的一大核心思路。

然而问题随之而来。

众所周知,随着大模型越来越大,模型训练的困难程度、资源投入、训练时间都在指数型提升,可模型效果却无法保证等比例提升。

随着模型越来越大,稳定性也越来越差,种种综合原因让大模型参数量长久以来限制在百亿与千亿级别,难以进一步扩大。

如何在有限的计算资源预算下,如何训练一个规模更大、效果更好的大模型,成为了困扰行业的问题。

此时,人们将目光投向了MoE。

MoE:突破万亿参数大关

早在1991年,两位人工智能界的泰斗Michael Jordan与Geoffrey Hinton就联手发布了MoE领域的奠基论文《Adaptive Mixtures of Local Experts》,正式开创了这一技术路径。

2020年,《GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding》论文又首次将MoE技术引入到Transformer架构中,拉开了“MoE+大模型”的大幕。

2022年,Google《Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity》论文中提出的MoE大模型更是一举突破了万亿参数大关。

Switch Transformers模型参数达到1.57万亿,与此前的T5模型相比,在相同的计算资源下获得高达7倍的模型预训练速度提升,并实现了4倍的模型加速。

而正如文章开头所言,本届GTC上英伟达侧面证实了那个公认的传言:OpenAI在2023年推出的GPT-4,同样采用了MoE架构,其模型效果与计算效率都得到了显著提升。

总结起来,MoE在大模型领域的优势包括:

1、与传统的Dense模型相比,MoE能够在远少于前者所需的计算资源下进行有效的预训练,计算效率更高、速度更快,进而使得模型规模得到显著扩大,获得更好的AI性能。

2、由于MoE在模型推理过程中能够根据输入数据的不同,动态地选择不同的专家网络进行计算,这种稀疏激活的特性能够让模型拥有更高的推理计算效率,从而让用户获得更快的AI响应速度。

3、由于MoE架构中集成了多个专家模型,每个专家模型都能针对不同的数据分布和构建模式进行搭建,从而显著提升大模型在各个细分领域的专业能力,使得MoE在处理复杂任务时性能显著变好。

4、针对不同的专家模型,AI研究人员能够针对特定任务或领域的优化策略,并通过增加专家模型数量、调整专家模型的权重配比等方式,构建更为灵活、多样、可扩展的大模型。

不过,天下没有免费的性能提升,在拥有种种优势之于,MoE架构也存在着不少挑战。

由于MoE需要把所有专家模型都加载在内存中,这一架构对于显存的压力将是巨大的,通常涉及复杂的算法和高昂的通信成本,并且在资源受限设备上部署受到很大限制。

此外,随着模型规模的扩大,MoE同样面临着训练不稳定性和过拟合的问题、以及如何确保模型的泛化性和鲁棒性问题、如何平衡模型性能和资源消耗等种种问题,等待着大模型开发者们不断优化提升。

结语

总结来说,MoE架构的核心思想是将一个复杂的问题分解成多个更小、更易于管理的子问题,并由不同的专家网络分别处理。这些专家网络专注于解决特定类型的问题,通过组合各自的输出来提供最终的解决方案,提高模型的整体性能和效率。

当前,MoE仍旧是一个新兴的大模型研究方向,研究资料少、资源投入大、技术门槛高,其研发之初仍旧以海外巨头为主导,国内只有昆仑万维等少数玩家能够推出自研MoE大模型。

不过,值得注意的是,虽然以扩大模型参数为核心的“暴力出奇迹”路线主导了当前的人工智能行业研究,但时至今日也没有人能拍着胸脯保证,Scaling Law就是人类通往通用人工智能的唯一正确答案。

从1991年正式提出至今,MoE架构已历经了30年岁月;深度神经网络更是70年前就已提出的概念,直到近十多年间才取得突破,带领人类攀上人工智能的又一座高峰。

MoE不是人工智能技术前进道路的终点,它甚至不会是大模型技术的最终答案。未来,还将有大量感知、认知、计算、智能领域的挑战摆在研究者面前,等待着人们去逐一解决。

所幸的是,怕什么真理无穷,进一寸有一寸的欢喜。

参考资料:

1、GShard: Scaling Giant Models with Conditional Computation and Automatic Sharding

2、Mixture of Experts: How an Ensemble of AI Models Decide As One

3、Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity

4、「天工2.0」MoE大模型发布

本文来源:大众新闻 责任编辑: 杜娟_ND0804

![[力扣]——387.字符串中的第一个唯一字符](https://img-blog.csdnimg.cn/direct/9121aa197197402cb95c3cb53b9afab4.png)