最近在研究数据湖,虽然不知道研究成果是否可以用于工作,但我相信机会总是留给有准备的人。

数据湖尤其是最近提出的湖仓一体化概念,很少有相关的资料,目前开源的项目就三个,分别是hudi, detla lake, iceberg。最终选择使用detla lake,因为国外有相关的书籍,国内一些关于spark书籍也有提到detla lake。花了一些钱把国内外相关的书籍都买了一遍,发现全部都是用scala来实现的,很少用java来实现,决定参考其他大牛,例如:https://edu.csdn.net/course/detail/35238的做法,逐步把自己自学成果总结一下。

入门肯定先是弄一个类似HelloWorld的例子,就叫HelloDeltaLake吧。

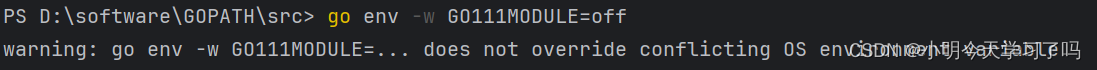

可能大家都以为涉及Spark是不是要先部署一套Spark环境,经过尝试,发现原来不需要,研发环境可以使用常用的window 11操作系统,跟一般java项目一样先通过IDEA建立一个Maven工程,这里有几个注意点:

1、detla lake建议使用java 8,11,17,8新版IDEA不太支持了,17又太新了,所以最终选择11

2、pom.xml里面要注意spark和detla lake一定要对应scala的版本号,具体如下面代码字里面的2.12,三者必须一致,我尝试过spark用2.13,delta lake用2.12结果报错,总之这个问题花了很多时间去解决。

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>org.example</groupId>

<artifactId>detla-lake-with-java</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>11</maven.compiler.source>

<maven.compiler.target>11</maven.compiler.target>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.5.1</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.12</artifactId>

<version>3.5.1</version>

</dependency>

<dependency>

<groupId>io.delta</groupId>

<artifactId>delta-spark_2.12</artifactId>

<version>3.1.0</version>

</dependency>

<dependency>

<groupId>com.fasterxml.jackson.core</groupId>

<artifactId>jackson-core</artifactId>

<version>2.17.0</version>

</dependency>

</dependencies>

</project>3、最后就是录入简单的程序了

package detal.lake.java;

import org.apache.spark.sql.Dataset;

import org.apache.spark.sql.Row;

import org.apache.spark.sql.SaveMode;

import org.apache.spark.sql.SparkSession;

public class HelloDetlaLake {

public static void main(String[] args) {

SparkSession spark = SparkSession.builder()

.master("local[*]")

.appName("delta_lake")

.config("spark.sql.extensions", "io.delta.sql.DeltaSparkSessionExtension")

.config("spark.sql.catalog.spark_catalog", "org.apache.spark.sql.delta.catalog.DeltaCatalog")

.getOrCreate();

Dataset<Row> data = spark.range(0,5).toDF();

data.write().format("delta").mode(SaveMode.Overwrite).save("file:///D:\\bigdata\\detla-lake-with-java\\delta-table-data");

Dataset<Row> df = spark.read().format("delta").load("file:///D:\\bigdata\\detla-lake-with-java\\delta-table-data");

df.printSchema();

df.show();

}

}

代码很简单,不需要运行spark,然后用1~5生成一个5行数据,保存到D:\bigdata\detla-lake-with-java\delta-table-data这个目录,然后再去把数据查询回来,该代码是直接使用 https://edu.csdn.net/course/detail/35238 课程里面提供的。

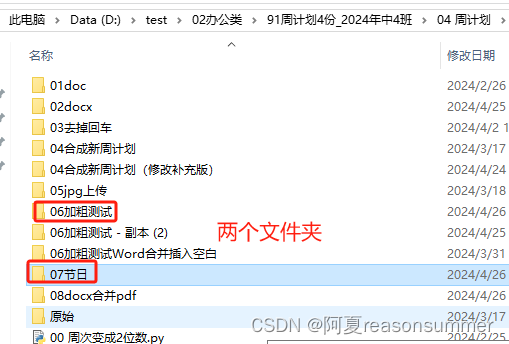

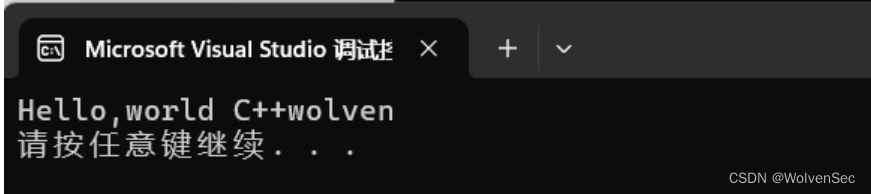

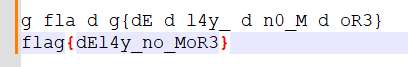

最终在IDEA运行结果: