通过5个条件判定一件事情是否会发生,5个条件对这件事情是否发生的影响力不同,计算每个条件对这件事情发生的影响力多大,写一个线性神经网络模型pytorch程序,最后打印5个条件分别的影响力。

一

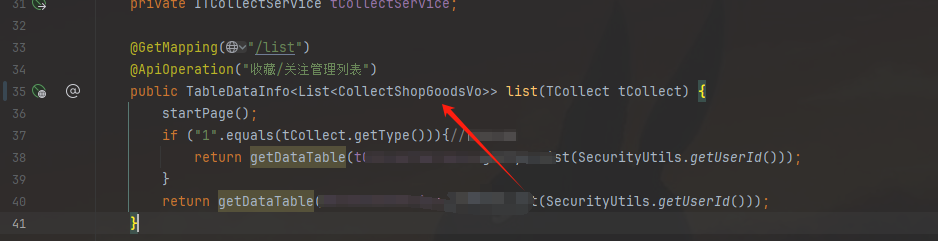

在这个场景中,一个线性神经网络(也就是一个单层全连接网络)可以用于根据五个条件来预测一件事情是否会发生。然而,线性模型的一个关键特性是它的输出是输入的线性组合,这意味着影响力的计算相对直接:它们就是模型的权重。

下面是一个使用PyTorch实现的简单线性神经网络模型,该模型将五个条件作为输入,并输出一个预测值。模型训练后,我们可以打印出每个输入条件对应的权重,这些权重可以被解释为每个条件对输出的影响力。

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import TensorDataset, DataLoader

# 假设每个条件是一个标量值,且我们有一些样本数据和对应的标签

num_conditions = 5

num_samples = 100 # 示例样本数量

input_dim = num_conditions

output_dim = 1 # 二分类问题(事情发生/不发生)

# 生成一些随机样本数据和对应的标签

# 在实际应用中,你应该使用真实的数据

X = torch.randn(num_samples, input_dim)

y = torch.randint(0, 2, (num_samples, output_dim), dtype=torch.float32) # 随机生成0或1作为标签

# 为了简化,我们这里不使用训练/测试集划分,而是使用全部数据进行训练

dataset = TensorDataset(X, y)

dataloader = DataLoader(dataset, batch_size=10, shuffle=True)

# 线性神经网络模型

class LinearModel(nn.Module):

def __init__(self, input_dim, output_dim):

super(LinearModel, self).__init__()

self.linear = nn.Linear(input_dim, output_dim)

def forward(self, x):

return self.linear(x)

# 实例化模型

model = LinearModel(input_dim, output_dim)

# 定义损失函数和优化器

criterion = nn.BCEWithLogitsLoss() # 使用二元交叉熵作为损失函数,但包含sigmoid的逆操作

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练模型

num_epochs = 100

for epoch in range(num_epochs):

for inputs, labels in dataloader:

# 前向传播

outputs = model(inputs)

loss = criterion(outputs.squeeze(), labels.squeeze())

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 模型训练完成后,获取权重

weights = model.linear.weight.data.squeeze()

# 打印每个条件的影响力(权重)

print("Influence of each condition (based on trained weights):")

for i, weight in enumerate(weights):

print(f"Condition {i+1}: {weight.item()}")在这个例子中,我们创建了一个简单的线性神经网络模型,并用随机生成的数据对它进行了训练。训练完成后,我们打印出了模型学习到的权重,这些权重可以被解释为每个输入条件对输出的影响力。请注意,这个例子使用了随机生成的数据和标签,因此在实际应用中,应该使用真实的数据来训练模型。

此外,由于线性模型的表达能力有限,它可能无法捕捉到输入条件之间复杂的相互作用。如果问题确实存在非线性关系,那么可能需要考虑使用更复杂的模型,如多层感知机(MLP)、决策树或支持向量机(SVM)等。

二

在线性神经网络模型中,我们通常假设输出是输入的线性组合。在这个场景中,我们可以将每个条件视为一个特征,并为每个特征分配一个权重,这个权重可以解释为该特征(条件)对输出的影响力。线性模型非常简单,易于解释,但它们可能不如更复杂的模型(如神经网络)在复杂任务上表现得好。

下面是一个使用PyTorch构建的线性模型示例,该模型通过5个条件来预测一件事情是否会发生,并计算每个条件的影响力(即权重)。

import torch

import torch.nn as nn

import torch.optim as optim

# 假设每个条件是一个数值特征

num_conditions = 5

# 线性模型

class LinearModel(nn.Module):

def __init__(self, num_conditions):

super(LinearModel, self).__init__()

self.linear = nn.Linear(num_conditions, 1) # 输出是单个值,表示事情发生的概率或得分

def forward(self, x):

return self.linear(x)

# 实例化模型

model = LinearModel(num_conditions)

# 生成一些随机数据作为示例条件(在实际应用中,这些将是你的真实条件数据)

conditions = torch.randn(100, num_conditions) # 假设有100个样本,每个样本有5个条件

targets = torch.randn(100, 1) # 假设的目标值,你需要根据你的问题替换为真实标签

# 定义损失函数和优化器

criterion = nn.MSELoss() # 假设我们用均方误差作为损失函数

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练模型

for epoch in range(100): # 假设我们训练100轮

optimizer.zero_grad()

outputs = model(conditions)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

if (epoch+1) % 10 == 0:

print(f'Epoch {epoch+1}/{100}, Loss: {loss.item()}')

# 模型训练完成后,我们可以查看权重,它们表示每个条件的影响力

weights = model.linear.weight.data.squeeze()

# 打印每个条件的影响力

print("Influence of each condition:")

for i, weight in enumerate(weights):

print(f"Condition {i+1}: {weight.item()}")

在这个例子中,我们创建了一个简单的线性模型,它有5个输入特征(对应5个条件)和1个输出。我们随机生成了一些输入数据和目标值来模拟训练过程。在训练完成后,我们打印出了线性层的权重,这些权重可以被解释为每个条件对输出的影响力。

请注意,这个例子使用了随机生成的数据和均方误差损失函数。在实际应用中,需要根据问题的具体情况来选择合适的损失函数,并使用真实数据来训练和评估模型。此外,这里的“影响力”是模型权重的直接解释,它假设了线性关系,可能不适用于所有情况,特别是当条件与输出之间存在非线性关系时。

三

在线性神经网络模型中,我们通常不会直接计算每个输入特征(在这里是“条件”)对输出的“影响力”,因为线性模型本身就是通过权重来直接表示输入和输出之间的关系。权重可以被解释为每个输入特征对输出的相对重要性或影响力。

以下是一个简单的PyTorch线性回归模型的例子,它可以用来估计五个条件对事件发生的影响力。在这个例子中,将使用随机生成的数据来演示如何训练模型,并最后打印出学习到的权重,这些权重可以被看作是条件对事件发生的影响力。

import torch

import torch.nn as nn

import torch.optim as optim

# 假设我们有5个条件,每个条件是一个特征

num_conditions = 5

# 假设我们有一些训练数据

num_samples = 100

# 随机生成一些训练数据

X = torch.randn(num_samples, num_conditions)

# 随机生成一些目标输出(仅用于示例,实际情况中这些应该是基于条件的真实标签)

y = torch.randn(num_samples, 1)

# 定义一个简单的线性模型

class LinearModel(nn.Module):

def __init__(self, input_dim):

super(LinearModel, self).__init__()

self.linear = nn.Linear(input_dim, 1)

def forward(self, x):

return self.linear(x)

# 实例化模型

model = LinearModel(num_conditions)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练模型

num_epochs = 100

for epoch in range(num_epochs):

# 前向传播

outputs = model(X)

loss = criterion(outputs, y)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 打印损失值

if (epoch+1) % 10 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}')

# 模型训练完成后,我们可以查看学习到的权重

weights = model.linear.weight.data

# 打印每个条件的影响力(权重)

print("Influence of each condition (learned weights):")

for i in range(num_conditions):

print(f"Condition {i+1}: {weights[0, i].item()}")

在这个例子中,model.linear.weight.data 包含了学习到的权重,这些权重可以被解释为每个条件对输出的影响力。请注意,由于我们使用了随机生成的数据,所以学习到的权重也将是随机的,并且不具有实际预测价值。在实际应用中,应该使用真实的数据来训练模型。

此外,这里的“影响力”是基于模型权重的直接解释,它假设了线性关系。在更复杂的非线性模型中,如深度神经网络,这种直接的解释可能不再适用,需要使用其他方法来估计特征的影响力,例如梯度解释或置换特征重要性等。

四

线性神经网络模型,或称为线性回归模型,在结构上是线性的,即模型的输出是其输入的线性组合。当我们将线性神经网络用于分类任务(例如,判定一件事情是否会发生)时,通常会在输出层使用阈值函数(如sigmoid或step function)将线性输出转换为类别标签。

然而,线性模型本身并不能直接提供关于输入特征(在本例中是5个条件)对输出影响力的明确解释。线性模型的权重可以被解释为特征对输出的相对重要性,但它们并不直接等同于影响力,因为它们是在所有特征同时存在的情况下被估计的。

下面是一个使用PyTorch实现的简单线性神经网络模型,该模型通过5个条件来预测一件事情是否会发生,并在训练结束后打印出线性层的权重,作为每个条件对输出的相对重要性的近似。

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

# 假设5个条件作为输入特征

num_conditions = 5

# 输出为二分类问题,即事情发生(1)或不发生(0)

num_classes = 1

# 生成一些模拟数据

np.random.seed(0) # 保证可复现性

X = np.random.randn(100, num_conditions) # 100个样本,每个样本有5个条件

y = np.random.randint(2, size=(100, num_classes)) # 100个样本的随机二分类标签

# 转换为PyTorch张量

X_tensor = torch.tensor(X, dtype=torch.float32)

y_tensor = torch.tensor(y, dtype=torch.float32)

# 定义线性神经网络模型

class LinearNet(nn.Module):

def __init__(self, input_dim, output_dim):

super(LinearNet, self).__init__()

self.linear = nn.Linear(input_dim, output_dim)

def forward(self, x):

out = self.linear(x)

# 可以添加sigmoid激活函数将输出限制在0和1之间,但这里为了展示线性关系,我们省略它

# out = torch.sigmoid(out)

return out

# 实例化模型

model = LinearNet(num_conditions, num_classes)

# 定义损失函数和优化器

criterion = nn.MSELoss() # 均方误差损失,注意这里我们没有使用sigmoid激活函数,所以使用MSE是合适的

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 训练模型

num_epochs = 100

for epoch in range(num_epochs):

# 前向传播

outputs = model(X_tensor)

loss = criterion(outputs, y_tensor)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

if (epoch+1) % 10 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}')

# 打印线性层的权重,作为每个条件对输出的相对重要性的近似

print("Approximate influence of each condition (based on linear layer weights):")

for i, weight in enumerate(model.linear.weight.data.flatten()):

print(f"Condition {i+1}: {weight.item()}")请注意,这个程序使用了均方误差(MSE)作为损失函数,并且没有在线性层的输出上应用sigmoid激活函数。这是因为我们希望直接观察线性层的权重作为影响力的一种近似。然而,这并不是一个典型的分类问题设置。在实际的分类问题中,可能会希望在线性层的输出上应用sigmoid或softmax激活函数,并使用二元交叉熵(BCE)或交叉熵(CE)作为损失函数。

此外,由于这个程序使用了随机生成的输入数据和标签,因此训练出的模型权重没有实际意义。在实际应用中,应该使用真实的数据集来训练模型,并相应地解释模型权重。

五

在PyTorch中,创建一个简单的线性模型来评估五个条件对某件事情发生的影响力可以使用一个线性层来实现。下面是一个基本的示例来展示如何构建这样的模型、训练它,并打印出每个条件的权重,这些权重可以看作是每个条件对事件发生的影响力。

首先,需要安装PyTorch。可以从PyTorch官方网站找到关于如何安装的指导。

接下来,可以使用以下的PyTorch代码:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义模型

class SimpleLinearModel(nn.Module):

def __init__(self):

super(SimpleLinearModel, self).__init__()

# 此处定义了一个包含五个输入特征和一个输出节点的线性层

self.linear = nn.Linear(5, 1)

def forward(self, x):

return self.linear(x)

# 创建模型实例

model = SimpleLinearModel()

# 定义损失函数,这里使用均方误差

criterion = nn.MSELoss()

# 定义优化器,这里使用SGD(随机梯度下降)

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 假设你有一些数据来自于你的五个条件

# 这里X是特征数据,y是标签(事件是否发生,使用0或1表示)

# 比如,这里是一些随机生成的示例数据

X = torch.randn(100, 5) # 100个样本,每个样本有5个条件

y = torch.randn(100, 1) # 100个标签

# 训练过程

epochs = 100

for epoch in range(epochs):

# 前向传播

outputs = model(X)

loss = criterion(outputs, y)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 打印状态信息

if (epoch+1) % 10 == 0:

print(f'Epoch [{epoch+1}/{epochs}], Loss: {loss.item():.4f}')

# 在训练后,打印每个条件的影响力

weights = model.linear.weight.data.numpy()[0]

for i, weight in enumerate(weights, 1):

print(f"Condition {i} influence: {weight:.4f}")请注意,这段代码只是一个简单的示例,而实际情况中需要有实际数据对模型进行训练,以及可能需要对模型进行调参以达到较好的训练效果。上面的代码中,我们随机生成了特征和标签数据进行训练,需要在 X 和 y 中填入你的真实数据。

此外,`model.linear.weight`表示的是线性层中权重值,它是一个大小为(1, 5)的张量。在这个模型中,每个权重对应于一个条件对事件发生概率的影响力。