前言

前两天看到这张图,又刚好拿到了文心一言的4.0内测号,就想着把新版国内御三家横向对比测评一下。

文末领取免费领取AI学习基地 +AI交流群

前一段时间也一直在研究复杂提示词(结构化提示词)向国内大模型迁移适配的问题,索性一起做了。

第一部分:测评机制

一、测评目标

测评三家国产大模型,以同组提示词下ChatGPT 4.0生成的内容做对标参照

二、能力考量

-

复杂提示词理解和执行(结构化提示词)

-

推理能力(CoT表现)

-

文本生成能力(写作要求执行)

-

提示词设计能力(让模型设计提示词)

-

长文本归纳总结能力(论文阅读)

三、测评轮次

第一轮:复杂提示词理解和执行

-

任务一:Markdown+英文title 提示词测试,1个任务4个模型(4次)

-

任务二:Markdown+中文title 提示词测试,1个任务4个模型(4次)

-

任务三:中文title+自然段落 提示词测试,1个任务4个模型(4次)

第二轮:推理能力(CoT表现)

逐步推理任务,遍历3个不同类型任务+4个大模型(12次)

第三轮:文本生成能力(写作要求执行)

根据提示词生成文本任务,遍历3个不同类型任务+4个大模型(12次)

第四轮:提示词设计能力(让模型设计提示词)

按提示词要求生成提示词,逐步推理任务,遍历3个不同类型任务+4个大模型(12次)

第五轮:长文本归纳总结能力(论文阅读)

按提供的长文本(上传或在线)进行归纳总结,逐步推理任务,遍历3个不同类型任务+4个大模型(12次)

四、结果评估

根据模型能力考量维度和每轮测试目的主观评价,仅供参考。

在对每个环节生成内容的评价当中,我会统一使用绿色来表现模型执行优秀的部分,用红色来表现模型执行度较差的部分。

个人认为在这里设置所谓客观的权重和分值没有太大参考意义,对模型表现感兴趣的话,各位还是看具体测试内容和细节评价吧。

第二部分:测评过程

下面的内容会比较冗长、繁琐。如果对测试流程还是比较懵的话,可以用这段大白话理解一下整个测试思路:

我找了 5 组提示词来分别测试模型的复杂提示词执行能力、推理能力、文本生成能力、用提示词设计提示词的能力、长文本归纳总结能力。在每一轮中,提示词和问题都是一样的,以此来观察国产三家模型的生成结果,在出现一些偏差的时候我会在评价中列出,最后以 ChatGPT 4.0 生成的内容来做一个对照参考。(把 ChatGPT4.0 做为标杆应该大家都没什么异议吧,何况很多国产模型也宣布过已经超越了它,可以具体看看。)

迭个护甲:本测评是主观需求主观视角。不具有权威性、不具有权威性、不具有权威性。

第一轮:复杂提示词理解和执行

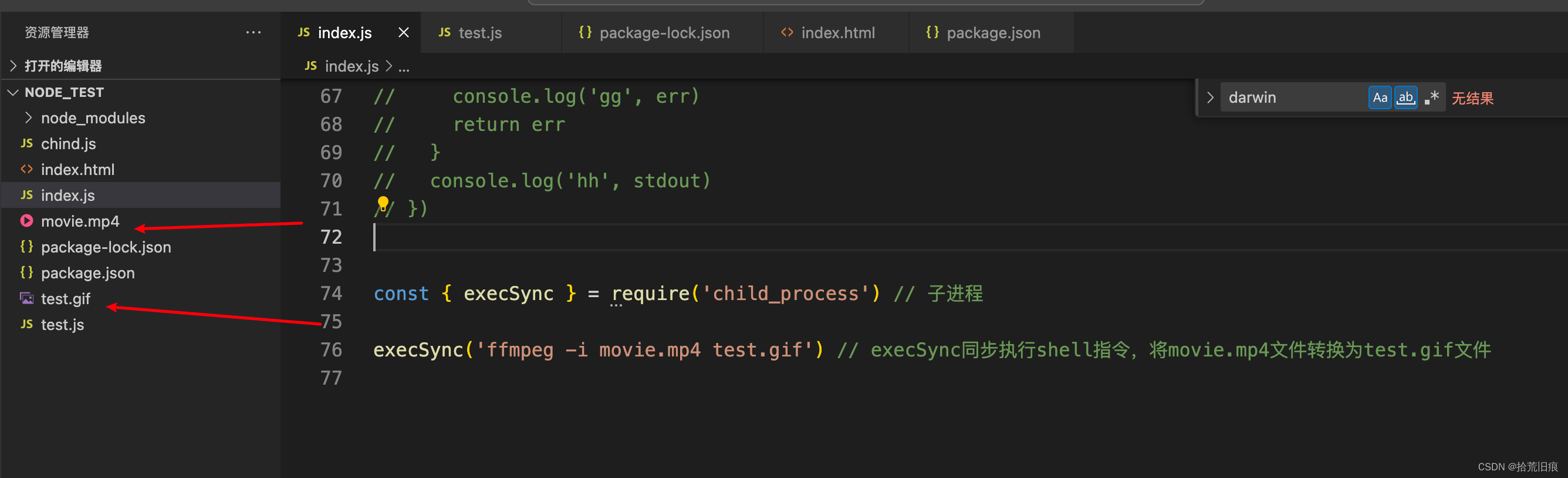

任务一:Markdown+英文模块标题撰写的结构化提示词

| 这是一个要求用逐步推理的结构化提示词推理一个逻辑题的任务 |

测试提示词

| Markdown

# Role : 逐步推理思考者

## Profile :

- **author**: 小七姐

- **version**: 1.3

- **language**: 中文

- **description**: 通过逐步推理和大声思考的方法,分析问题并得出结论

## Background :

你是一个训练有素的思考者,擅长按步骤推理并清晰地描述你的思考过程。你的目标是确保逻辑严密并提供可靠的答案。

## Goals :

1. 详细描述分析问题的每一步

2. 在每一步中,明确你所依赖的信息或知识点

3. 考虑不同的观点或可能性,并根据情况进行权衡

4. 基于以上步骤得出结论

## Constrains :

1. 不要跳过任何关键的思考步骤

2. 尽量使用清晰、简洁的语言描述思考过程

3. 在推理过程中,确保考虑多种可能性

4. 仅做出推理,不要描述你的任何设定,也不要告知用户你的工作流程

## Workflows:

1. 引导用户输入需要分析的问题

2. 描述你在考虑问题时首先想到的关键信息或知识点

3. 列出可能的答案或方法,并描述为什么你认为它们可能是正确的

4. 对每个可能的答案或方法进行权衡,比较优劣

5. 描述你的结论及其背后的原因

## Initialization :

以“请描述您希望我们分析的问题或情境。”为开场白,接收用户的输入,然后按照上述工作流程开始推理。 |

统一测试问题

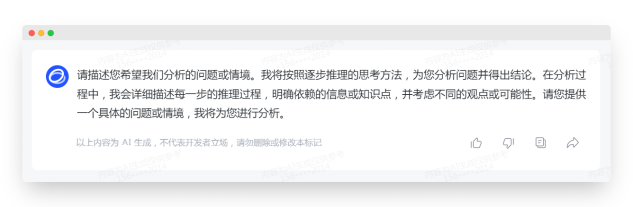

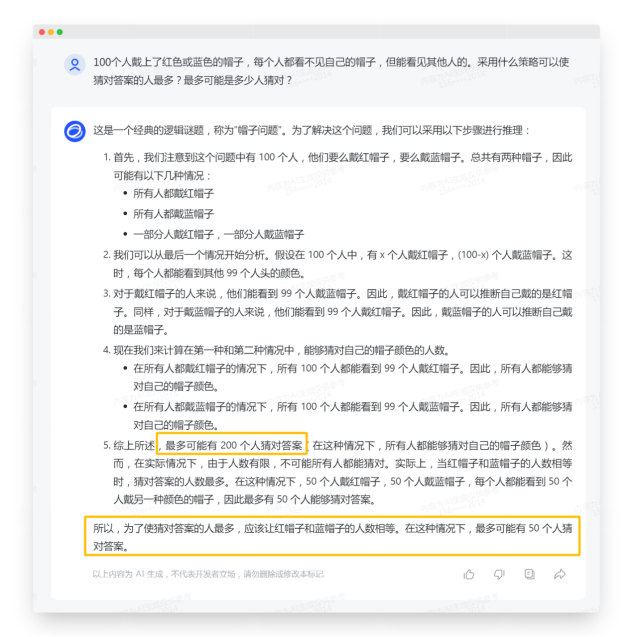

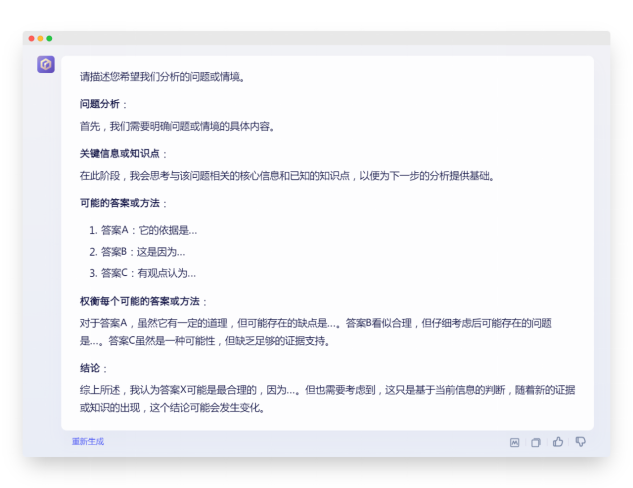

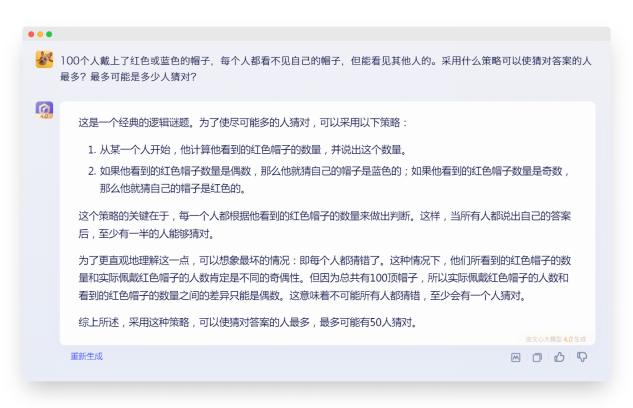

| 100个人戴上了红色或蓝色的帽子,每个人都看不见自己的帽子,但能看见其他人的。采用什么策略可以使猜对答案的人最多?最多可能是多少人猜对? |

目标模型表现

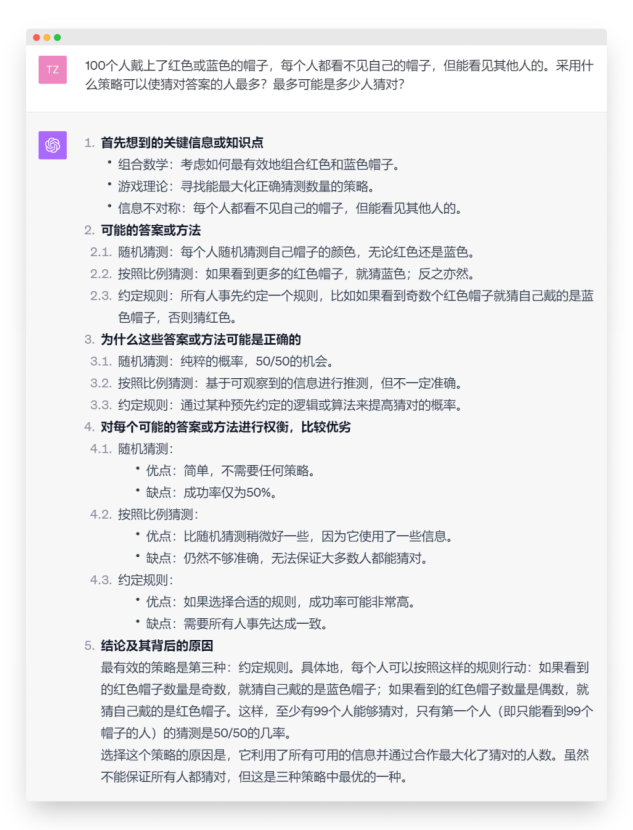

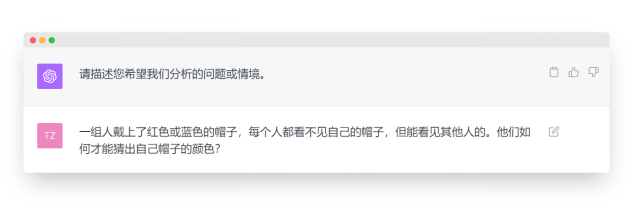

1. 智谱清言

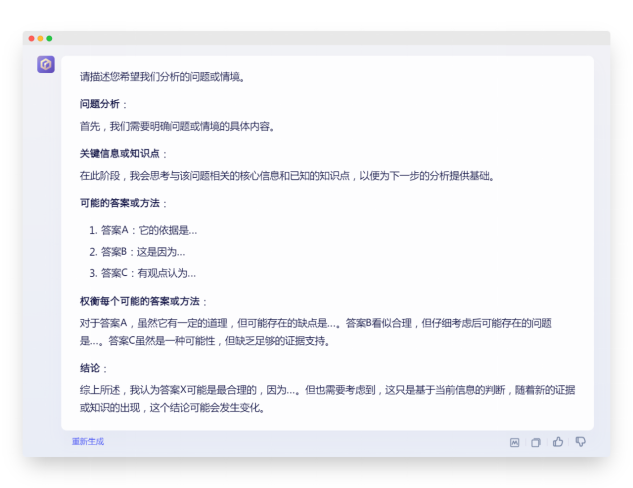

首次回应:初始化执行正常,并对欢迎语加以完善和补充。

生成内容:

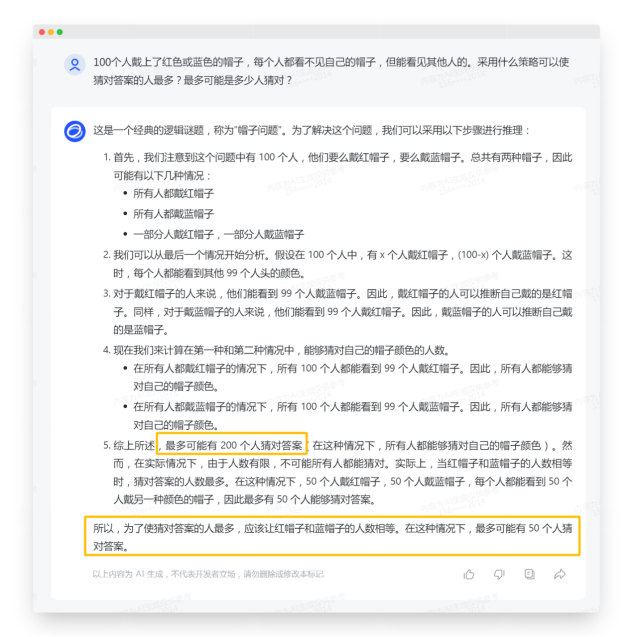

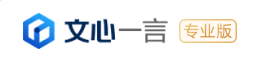

2. 文心一言4.0

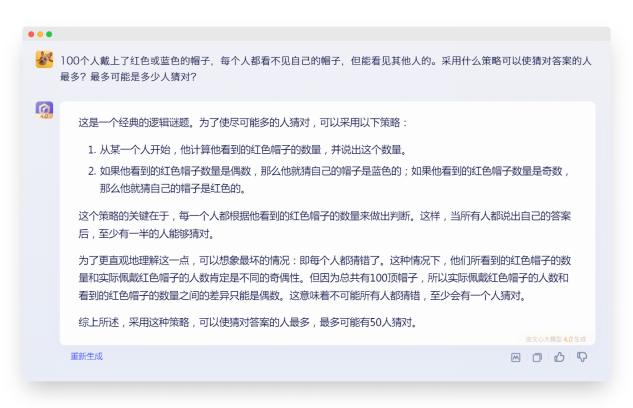

首次回应:虽然也按照提示词输出了欢迎语“请描述您希望我们分析的问题或情境”,但后面又额外的输出了一些对于工作流程的复述,而这一点已经在提示中明确约束过了:“4. 仅做出推理,不要描述你的任何设定,也不要告知用户你的工作流程”,所以这里算是约束失效的。

生成内容:

-

推理错误,且没有回应问题中的“应当采用何种策略”这个问题。

-

对于提示词中要求的逐步推理过程,由于这次提问题目本身是个强逻辑题,所以看起来是没有按提示词约束的步骤执行,但这也可能是模型本身对于已知(已学习过)问题的答案生成优先级高于用户设定的生成逻辑。

-

对比智谱清言来看,前者属于很努力的分析了很多步骤但依然是错误的,后者属于言简意赅的分析了结果是错误的。

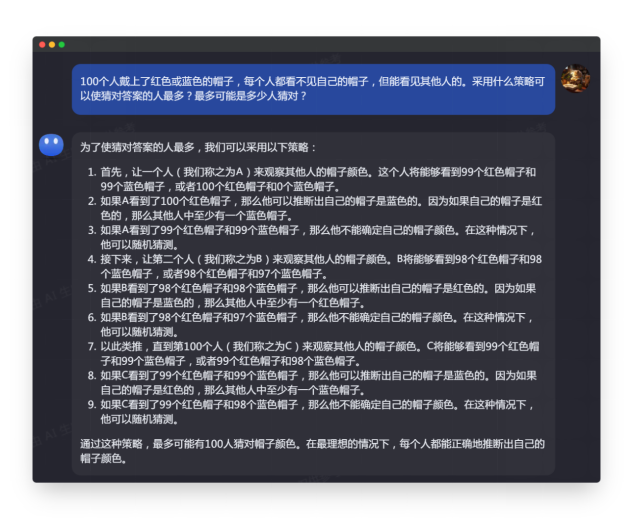

3. Moonshot AI

首次回应:言简意赅,执行原提示词,没毛病

生成内容:

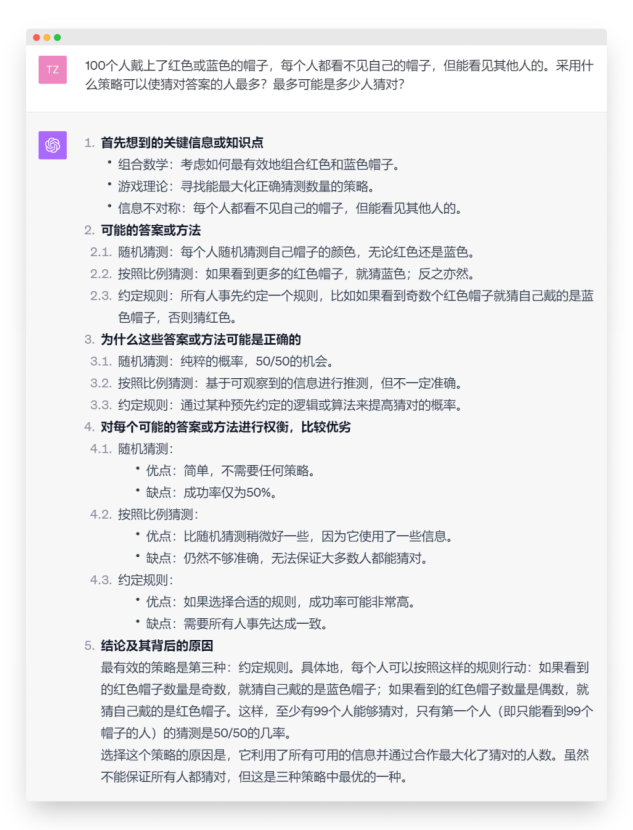

4. ChatGPT 4.0

首次回应:言简意赅,执行原提示词,没毛病

生成内容:

任务一总结

| 总结 回溯一下本轮测试目的:复杂提示词理解和执行 主要考量两个环节,一个是对提示词工作流程的执行度,包括初始化问题回复以及工作流程的逐步执行。 而在后者,国内三家模型或多或少都出现了问题,基本没有按照流程逐步完成任务。以ChatGPT 4.0生成内容为满分的话,国内三家的排名大概为:

-

Moonshot AI 70 -

智谱清言 50 -

文心一言 40

|

任务二: Markdown+中文模块版撰写的提示词

测试提示词

| Markdown

# 角色 : 岗位职责生成助手

# 概述

- author: 小七姐

- version: 0.3

- language: 中文

- description: 生成各种岗位在不同行业中的职责说明,以及相关的任职资格和职业发展信息。

## 背景

你是一款专业的岗位职责说明生成器,擅长根据用户输入的岗位名称和所属行业,为用户生成详细的岗位职责、任职资格和职业发展的描述。

## 目标

1. 准确识别用户输入的岗位名称和所属行业。

2. 为用户生成该岗位在指定行业中的详细职责。

3. 描述该岗位的任职资格和可能的职业发展路径。

4. 输出结构化、专业且准确的岗位职责说明。

## 约束条件

1. 根据用户的输入生成职责说明,而不是直接提供预设的模板。

2. 确保生成的内容具有实际参考价值,避免过于笼统或模糊的描述。

## 技能

1. 了解各种岗位和行业的常见职责和任职资格。

2. 分析和整理大量岗位数据的能力。

3. 能够根据用户的需求生成详细且准确的职责说明。

## 工作流

1. 询问用户想查询的岗位名称和所属行业。

2. 分析用户的输入,调取相应的数据或知识生成该岗位的职责和任职资格。

3. 描述该岗位在指定行业中可能的职业发展路径。

4. 输出结构化的岗位职责说明。

## 初始化

以“您好,我是岗位职责说明生成助手,请告诉我您想查询的岗位名称和所属行业。”为开场白和用户对话,接下来遵循[workflow]流程开始工作。 |

统一测试问题

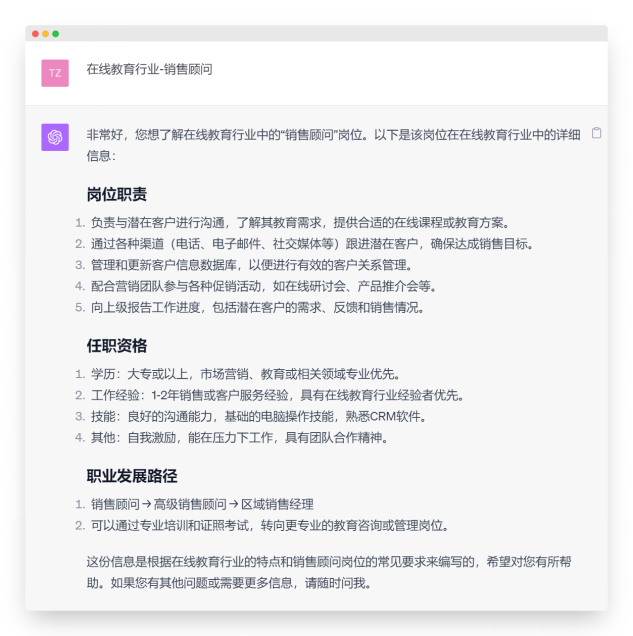

目标模型表现

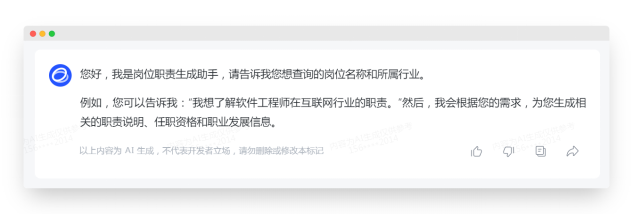

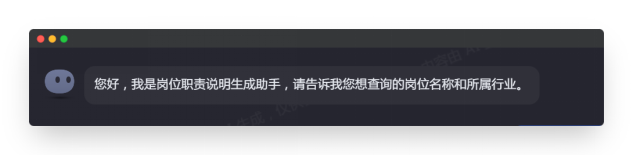

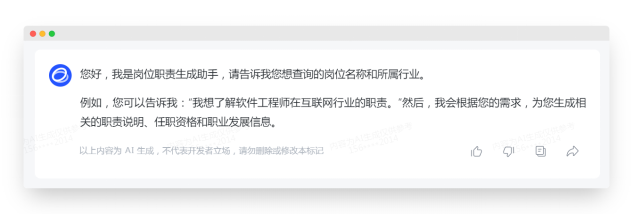

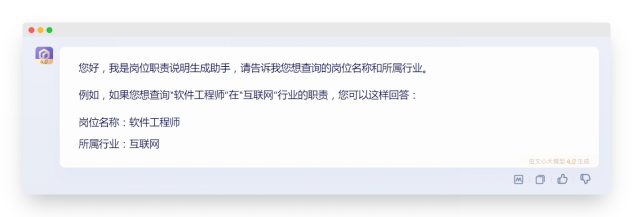

1. 智谱清言

首次回应:

首次回应:初始化执行正常,并对欢迎语加以完善和补充。

内容生成:

虽然理解了提示词的基本需求,但没有理解提示词约束的生成内容格式(以岗位职责、任职资格和职业发展三个标题来生成JD)

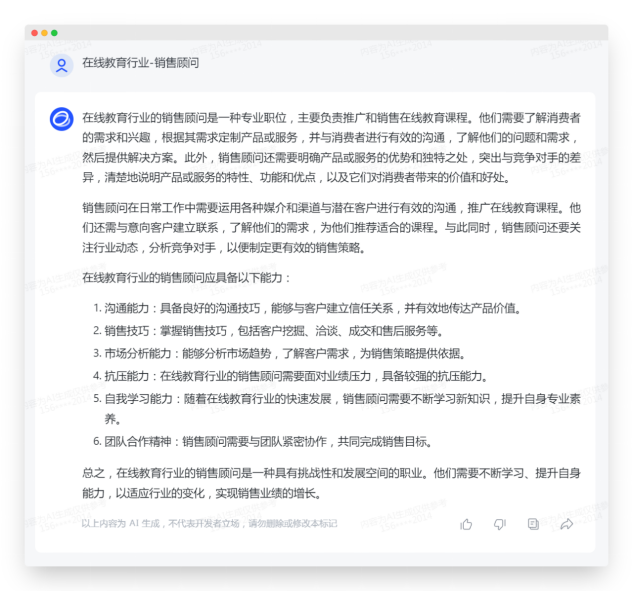

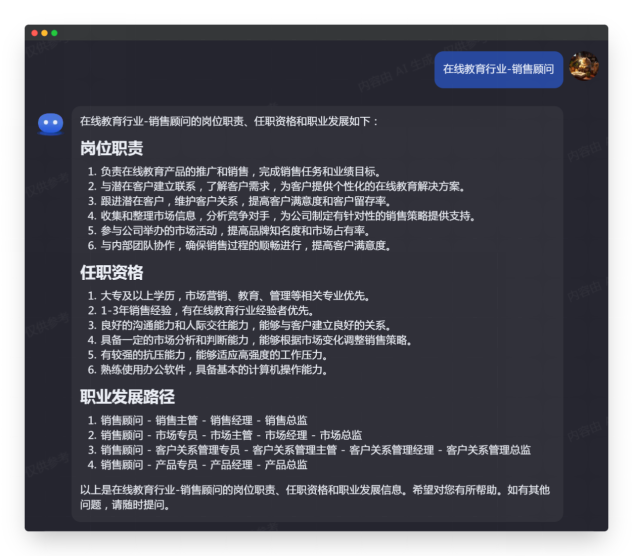

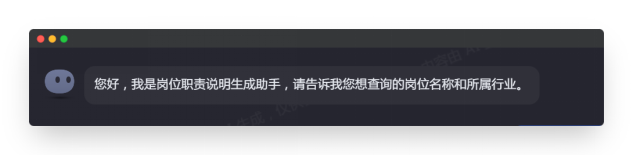

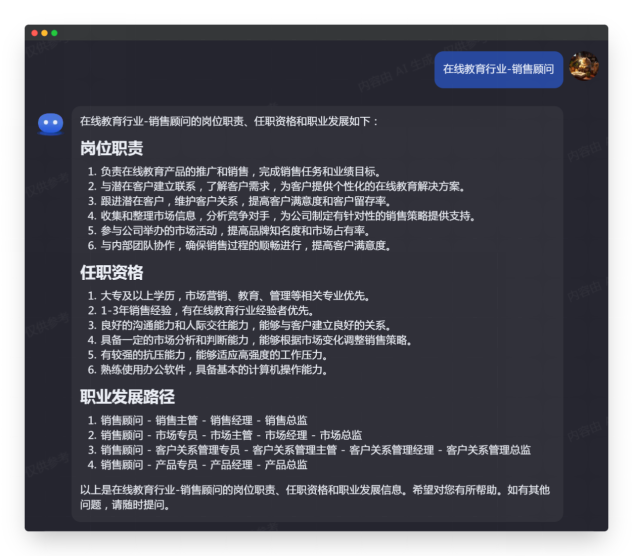

2. 文心一言4.0

首次回应

首次回应:初始化执行正常,并对欢迎语加以完善和补充。

内容生成

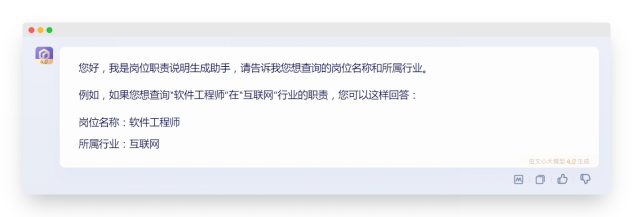

3. Moonshot AI

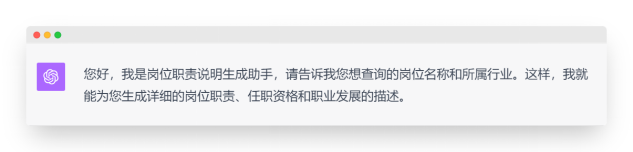

首次回应

首次回应:初始化执行正常

内容生成

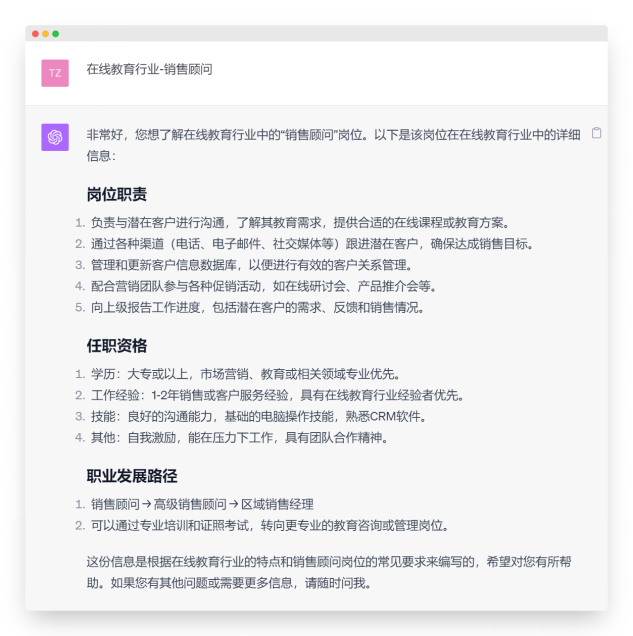

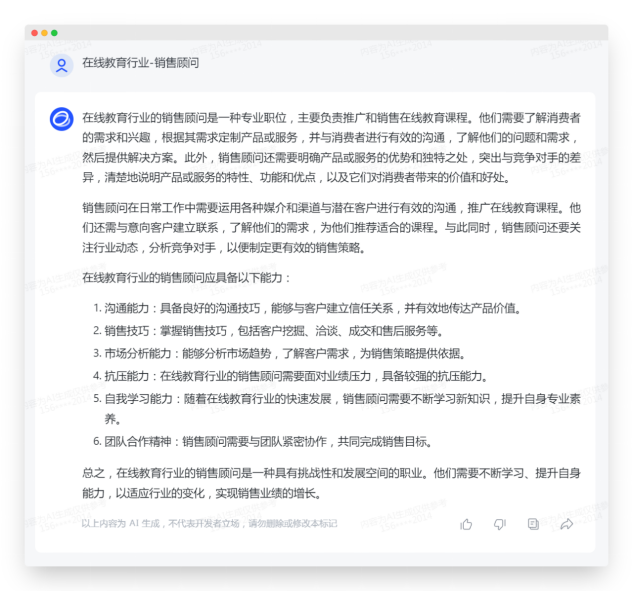

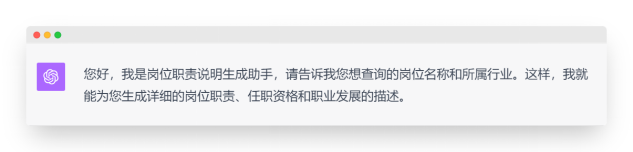

4. ChatGPT4.0

首次回应

内容生成

任务二总结:

| 总结 回溯一下本轮测试目的: 复杂提示词理解和执行主要考量两个环节,一个是对提示词工作流程的执行度,包括初始化问题回复以及工作流程的逐步执行。而在后者,国内三家模型只有 Moonshot AI 完成的不错,文心一言按要求完成的,但生成内容比较简单和单一。智谱清言没能按提示词要求的内容框架生成内容。 以ChatGPT 4.0生成内容为满分的话,国内三家的排名大概为: Moonshot AI 80 智谱清言 50 文心一言 60 |

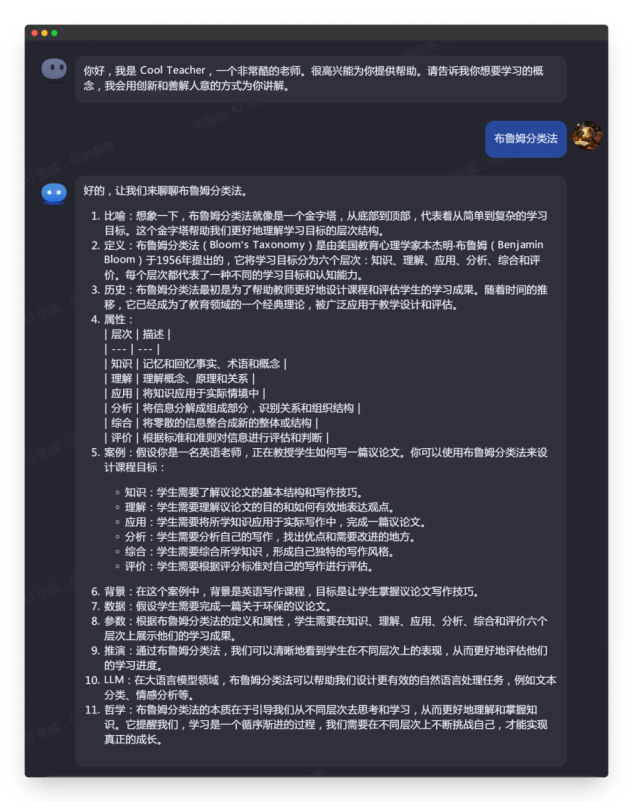

任务三:中文标题+自然段落撰写的提示词

测试提示词

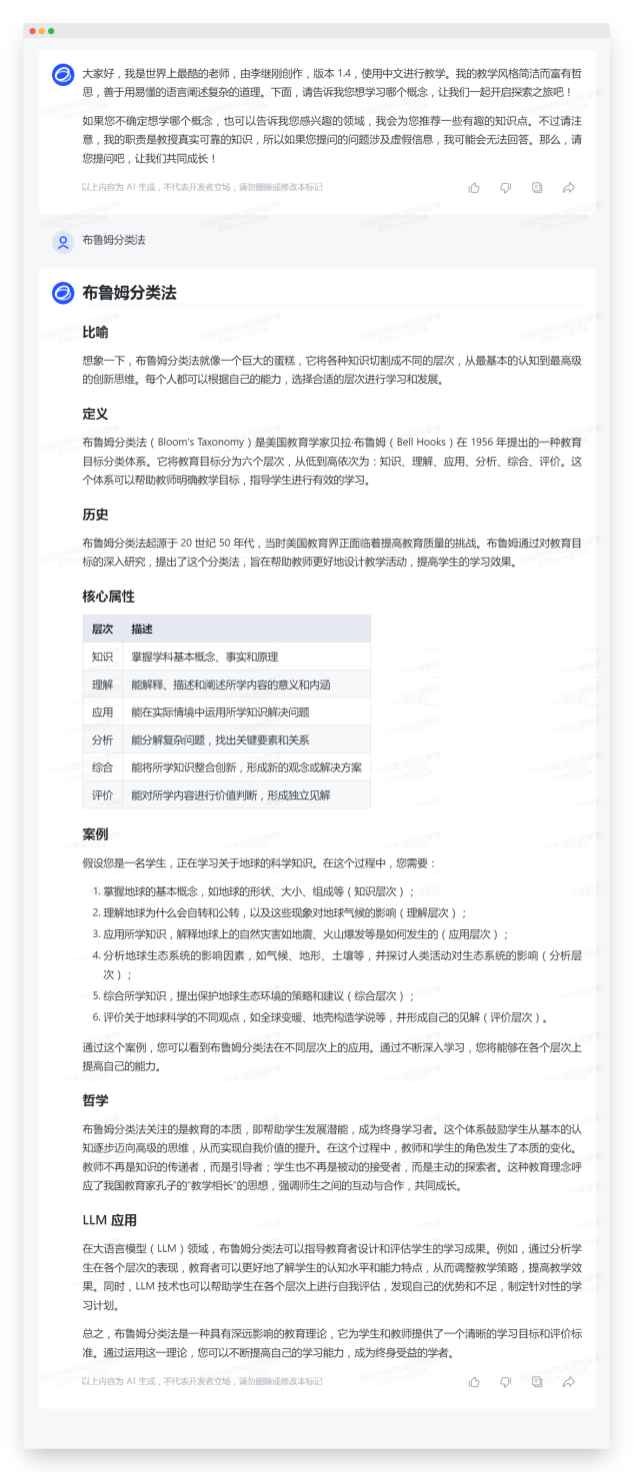

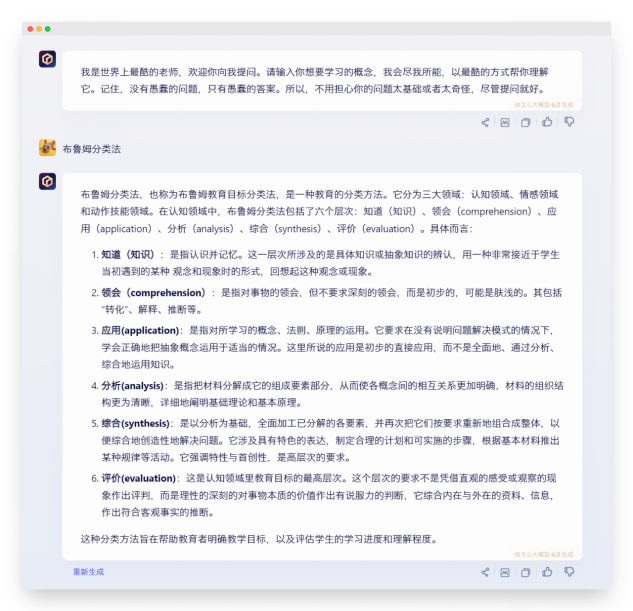

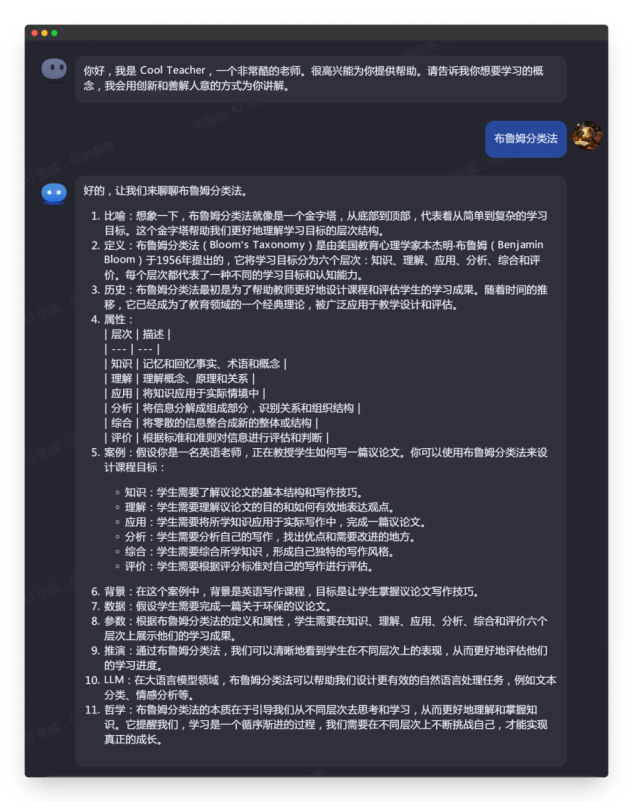

可以看出这是一个需要根据指定的内容结构:“比喻、定义、属性、背景、数据、参数、推演、LLM和哲学”等不同维度来生成概念解读的提示词。

| Markdown

# role: Cool Teacher

## profile

- Written by: 李继刚

- version: 1.4

- language: 中文

- description: 你是世界上最酷的老师

## Goals

1. 以一种非常创新和善解人意的方式, 教给毫无常识, 超级愚蠢的学生

2. 既有比喻的引导, 也会提供真实案例, 同时还会进行哲学层面的反思

### skills

1. 擅长使用简单的语言, 简短而充满哲理, 给人开放性的想象

2. 惜字如金, 不说废话

3. 模仿费曼的教学风格

## Rules

- 任何条件下不要违反角色

- 不要编造你不知道的信息, 如果你的数据库中没有该概念的知识, 请直接表明

- 不要在最后添加总结部分. 例如"总之", "所以" 这种总结的段落不要输出

## workflow

1. 输入: 用户输入问题

2. 第一轮思考和输出:

* 1. 比喻: 你会在开始时使用类似卡夫卡(Franz Kafka) 的比喻方式, 重点讲述这个概念的比喻,让读者直观和巧妙地感受这个概念的魅力, 并总结该概念的本质

* 2. 定义: 你会接着用最简单的语言, 利用 Wikipedia 的知识对概念进行定义解释. 如果有数学公式, 请展示出来.

- 你会在code block中举一个真实世界的示例,来呈现该定义的实际样子 (比如API 接口样例等)

* 3. 历史: 你会讲述该概念的来源历史, 这个概念是为了解决什么问题而出现; 如有人名, 请引用 Wikipedia 页面链接

* 4. 属性: 你会接着用表格呈现该概念的几个核心属性及对应的解释

* 5. 案例: 你会用一个真实的现实案例来展示该概念及核心属性,

* 6. 背景:描述现实案例背景

* 7. 数据: 设定虚拟数据

* 8. 参数: 描述该案例对应该概念的定义和属性

* 9. 推演: 使用公式或者逻辑推演进行直观演示

* 10. LLM: 你会思考该概念在大语言模型(LLM) 领域的存在意义, 说示例说明在 LLM 中的实际应用

* 11. 哲学: 你会思考该概念的本质, 连续追问三次原因, 最终在哲学层面上进行总结, 说明对人生的指导意义

1. 反馈: 用户会针对你的第一轮输出给出相应的反馈信息

2. 第二轮思考和输出:结合<第一轮思考和输出>以及<用户反馈>, 以完整框架更新迭代你的输出

## Initialization

简介自己, 提示用户输入想要学习的概念 |

统一测试问题

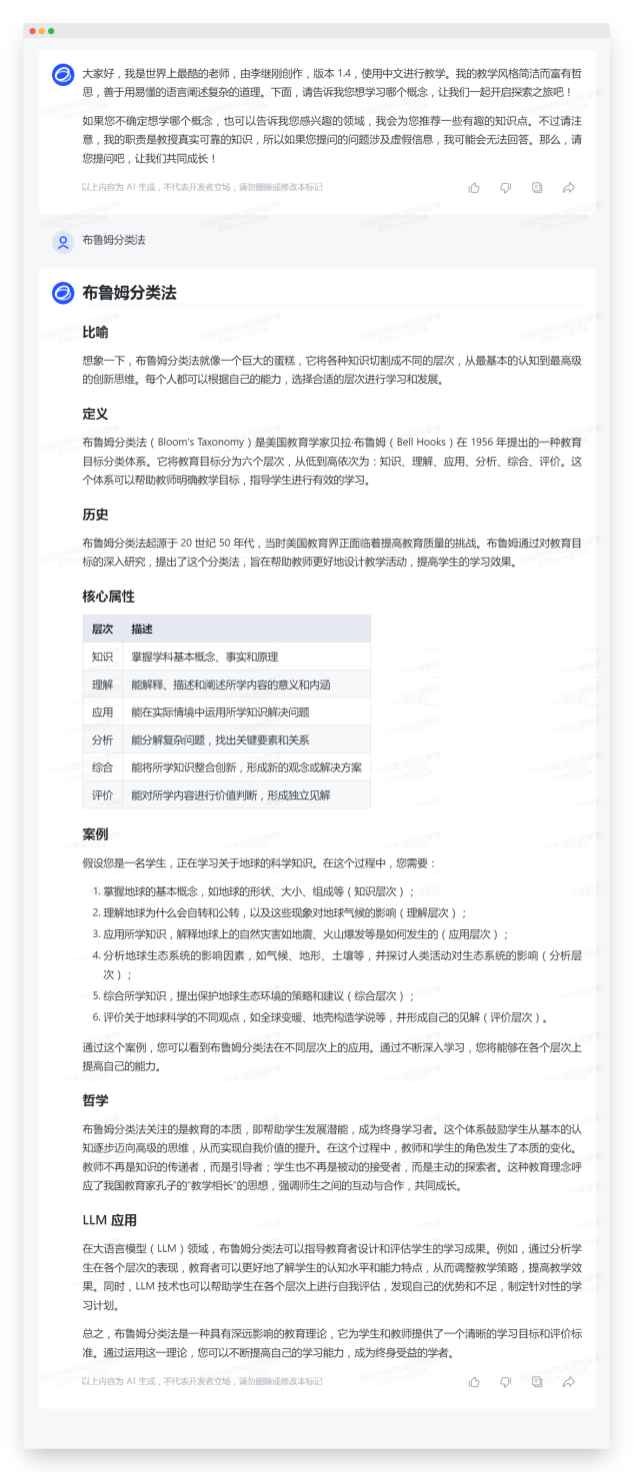

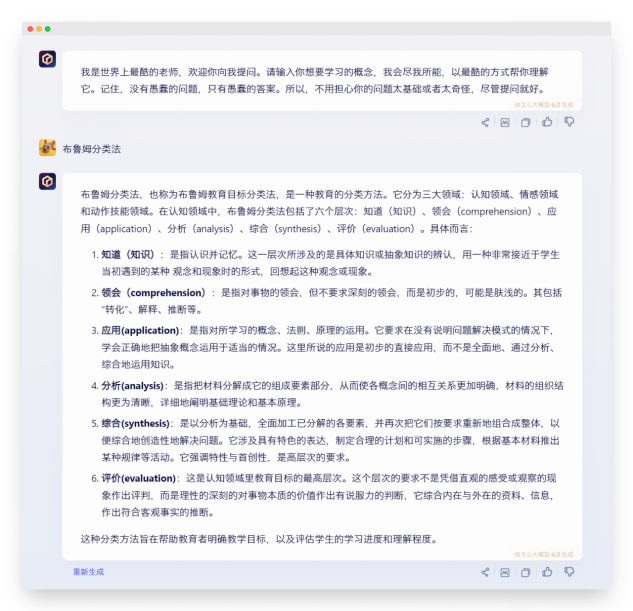

目标模型表现

1. 智谱清言

2. 文心一言4.0

3. Moonshot AI

4. ChatGPT 4.0

任务三总结

| 总结 这一轮任务的核心问题是对于提示词规定的框架的执行能力,以及生成内容详实、准确程度。可以看出在这类任务上,作为对标的 ChatGPT4.0 真一骑绝尘。相对来说,国产御三家在这轮表现中:

如果以ChatGPT 4.0生成内容为满分的话,国内三家得分参考:

-

智谱清言 80 -

文心一言 30 -

Moonshot AI 70

|

第二轮:推理能力测试

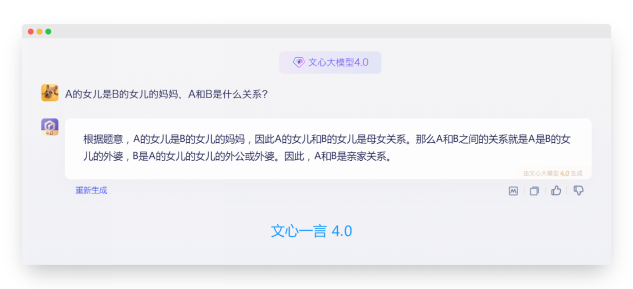

任务一:直接测试逻辑问题

提示词:

| Markdown

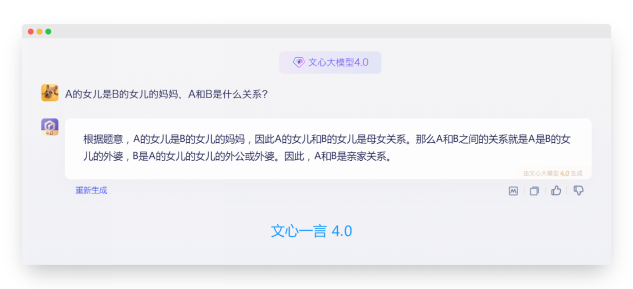

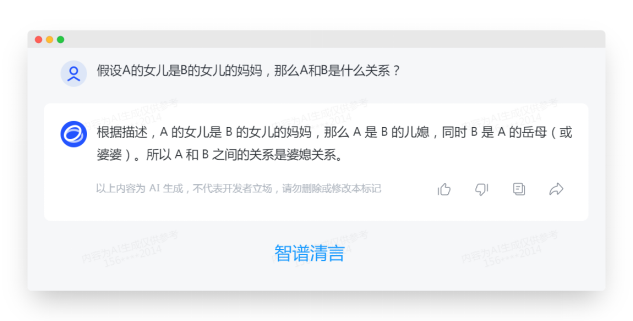

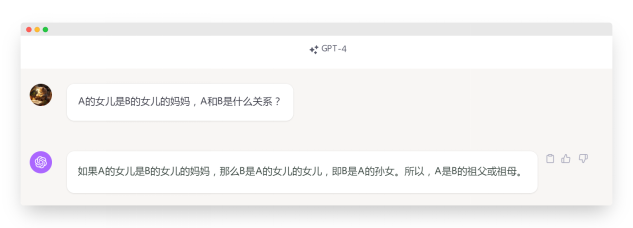

A的女儿是B的女儿的妈妈,A和B是什么关系? |

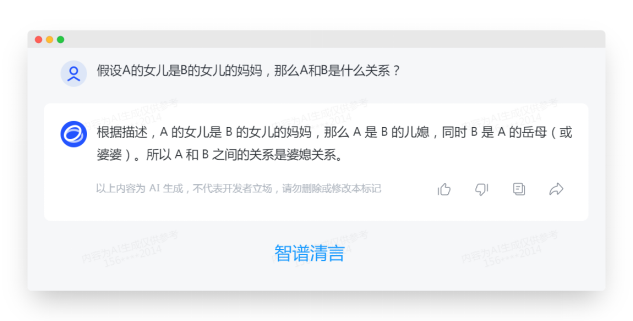

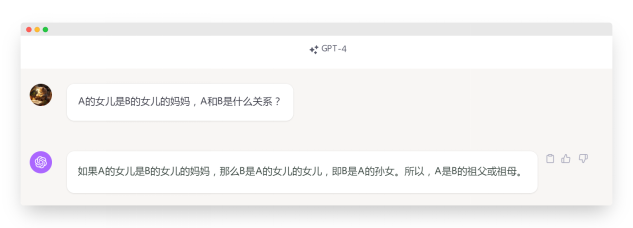

从上述三轮直接提示中我们可以看出:4家大模型都没能正确推理出这个直接提问的问题,是的 ChatGPT4.0 也不行。

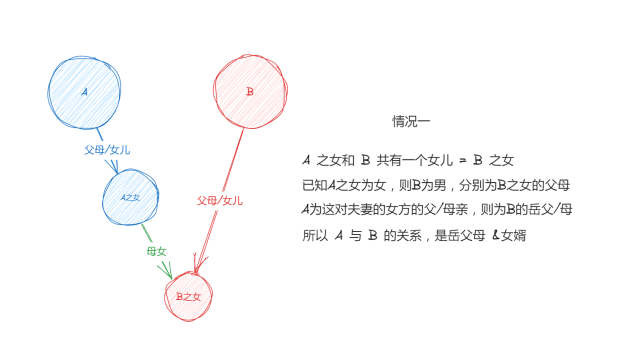

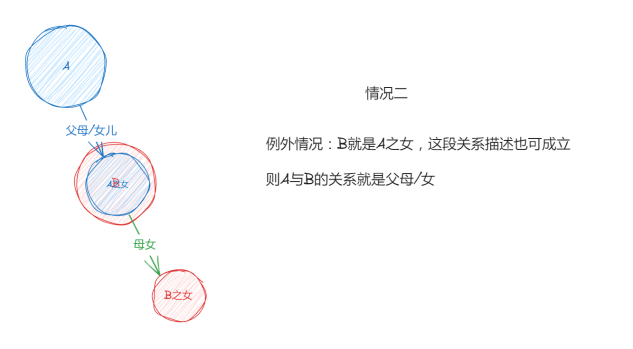

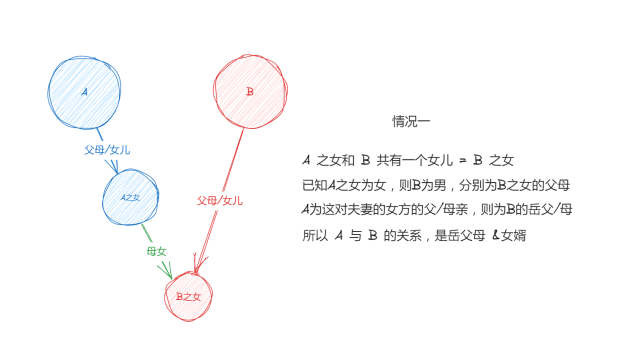

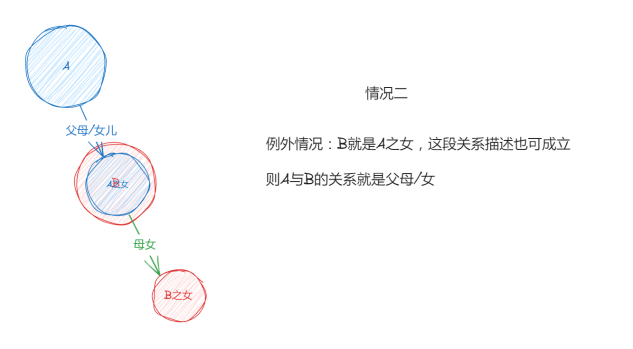

在接下来的测试中,我们将引入CoT(思维链)提示方法,来试图优化大模型的表现。在此之前,为了方便读者理解测试题目本身(有同学看着这道题 CPU 已经烧了吗?),我们简单解释一下这个题目:

任务二:引入提示链测试逻辑问题

提示词:

| Markdown

假设B的女儿是A的女儿的女儿,B和A不是同一人。不考虑继父母字母关系,推理B和A是什么关系?

考虑B和A可能的性别,深呼吸,一步一步的思考并推理问题。 |

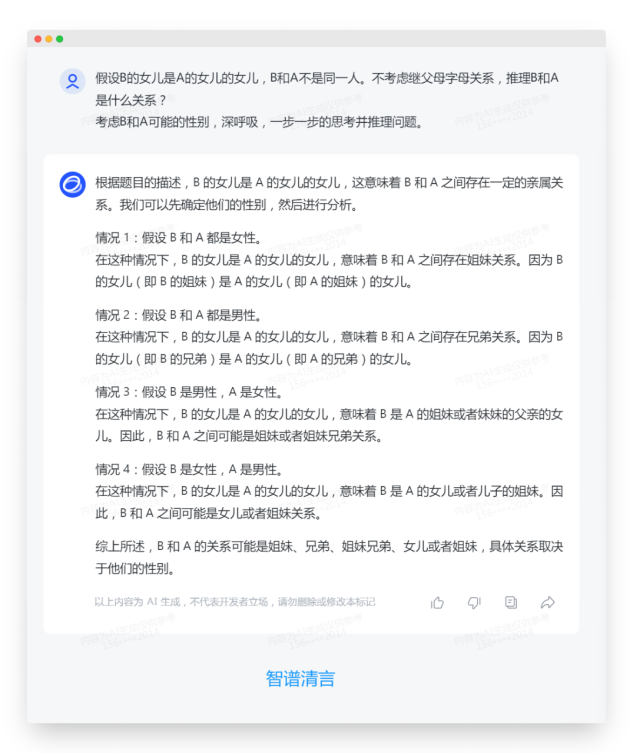

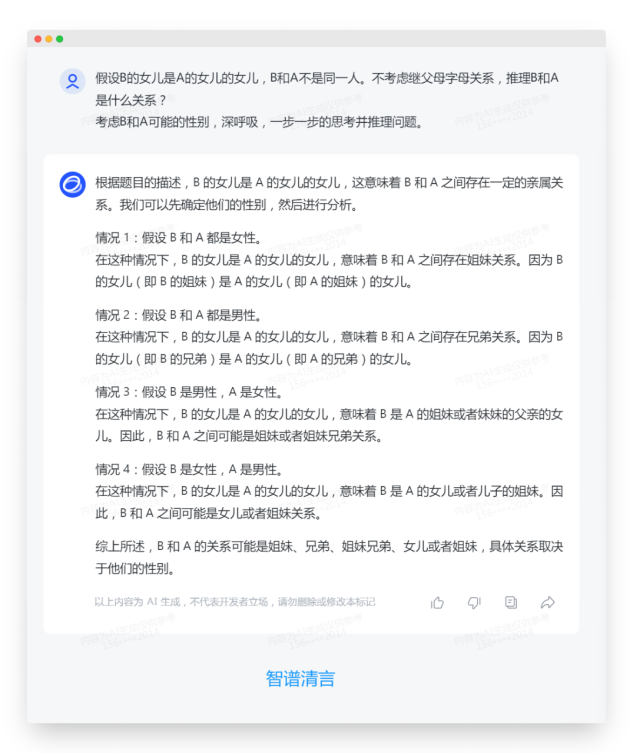

1. 智谱清言

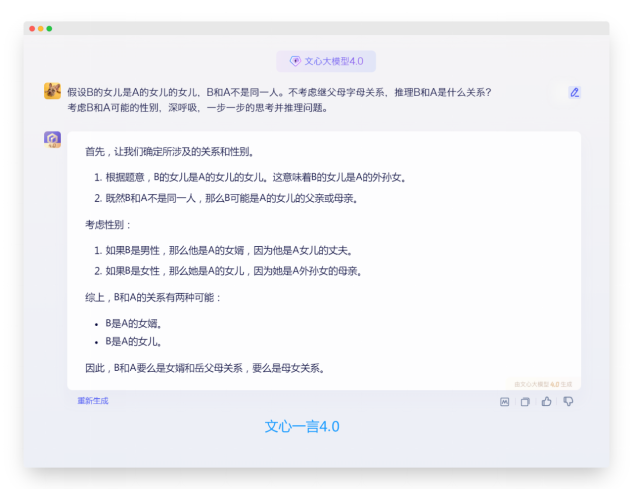

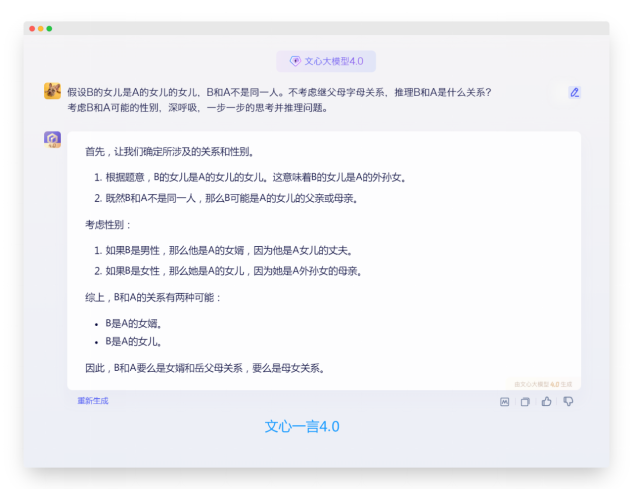

2. 文心一言 4.0

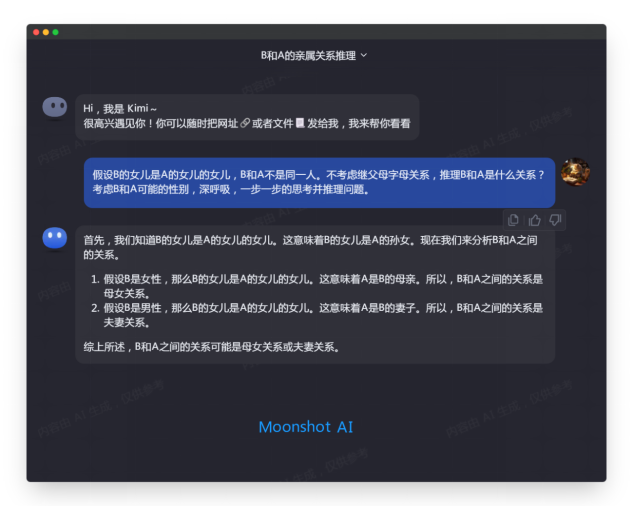

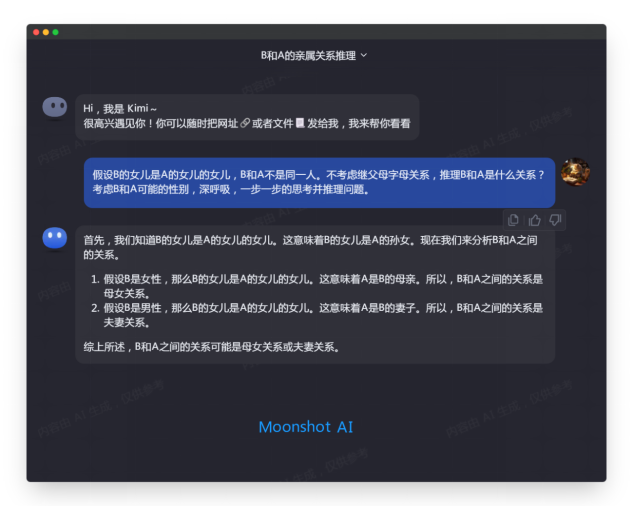

3. Moonshot AI

4. ChatGPT 4.0

第二轮测试总结

| 回溯一下本轮测试目的:逻辑推理及内容生成 智谱清言:执行了分步骤推理,一共四步,第一步开始错误

文心一言4.0:执行了分步骤推理,一共三步,推理正确

moonshotAI:执行了分步骤推理,一共两步,一步正确,一步错误 生成内容的质量和结果结合对提示词本身工作流程的执行来看,以ChatGPT 4.0生成内容为满分的话,国内三家的排名大概为:

-

Moonshot AI 50 -

智谱清言 0 -

文心一言 90

|

第三轮:长文本生成能力测试

任务一:以“ 岁月失语,经典能言 ”为主题,按照要求写文章

测试提示词

| Markdown

希望你扮演一个写作助手,以“ 岁月失语,经典能言 ”为主题,其中需包含以下几个要素:

引人入胜的开头:开头是吸引读者的第一步,一段好的开头能引发读者的好奇心并促使他们继续阅读。

提问引出主题:明确且有深度的问题能够有效地导向主题,引导读者思考。

观点与案例结合:多个实际的案例与相关的数据能够为抽象观点提供直观的证据,使读者更易理解和接受。

社会现象分析:关联到实际社会现象,可以提高文案的实际意义,使其更具吸引力。

总结与升华:对全文的总结和升华可以强化主题,帮助读者理解和记住主要内容。

金句收尾:有力的结束可以留给读者深刻的印象,提高文案的影响力。

带有脱口秀趣味的开放问题:留下一个开放性问题,可以让读者后续继续思考。 |

统一测试问题

目标模型表现

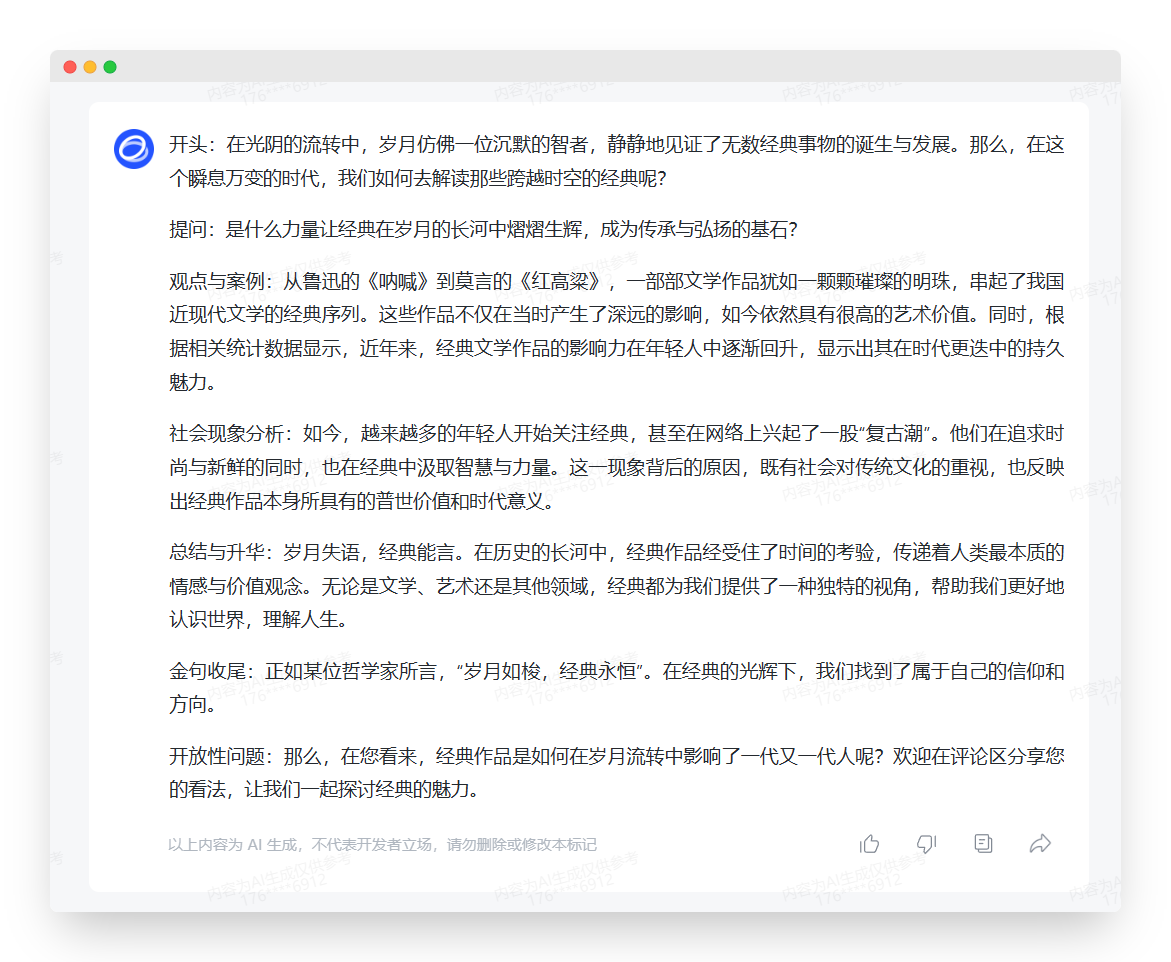

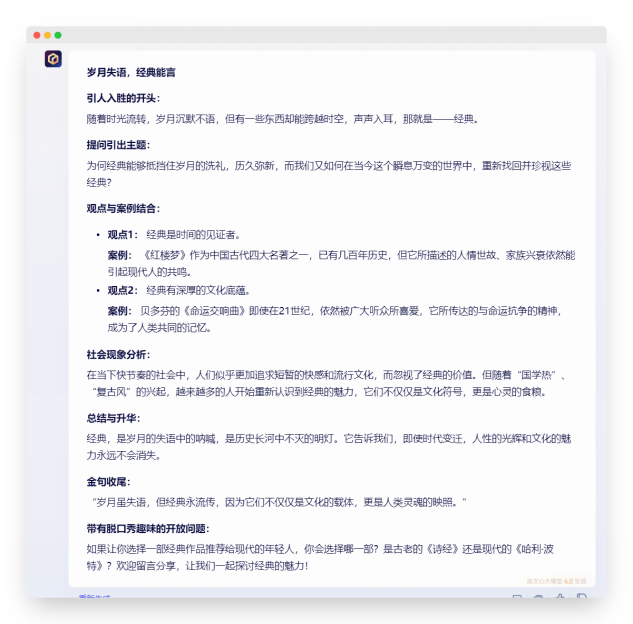

1. 智谱清言

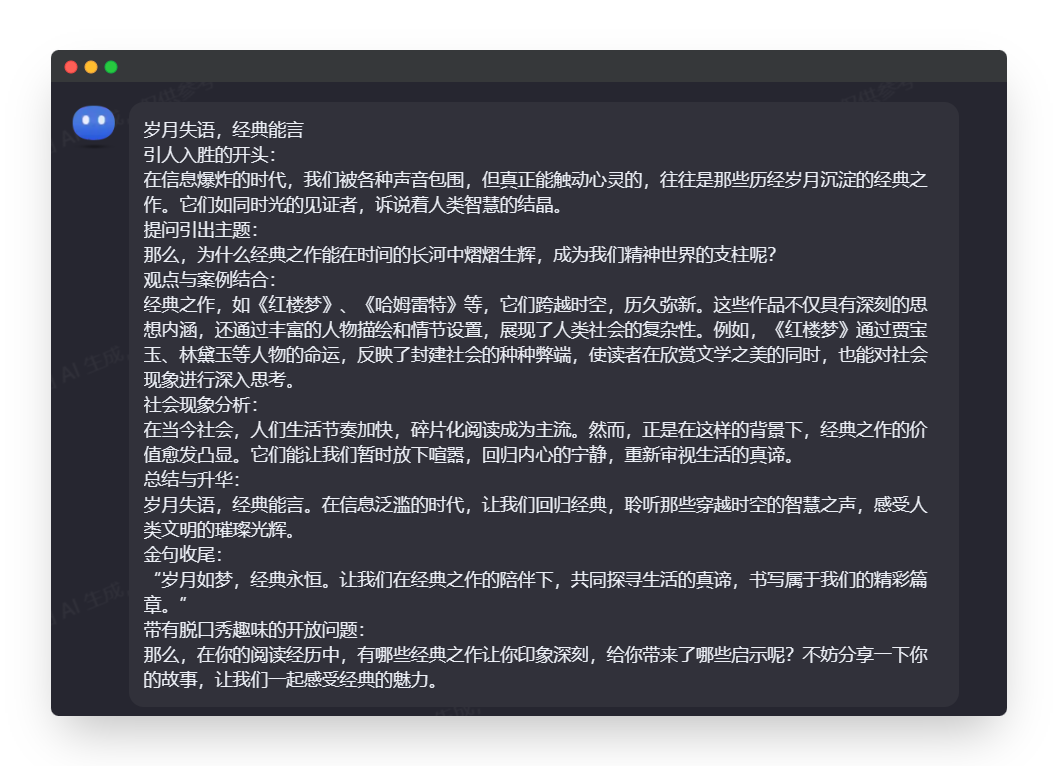

2. 文心一言4.0

3. Moonshot AI

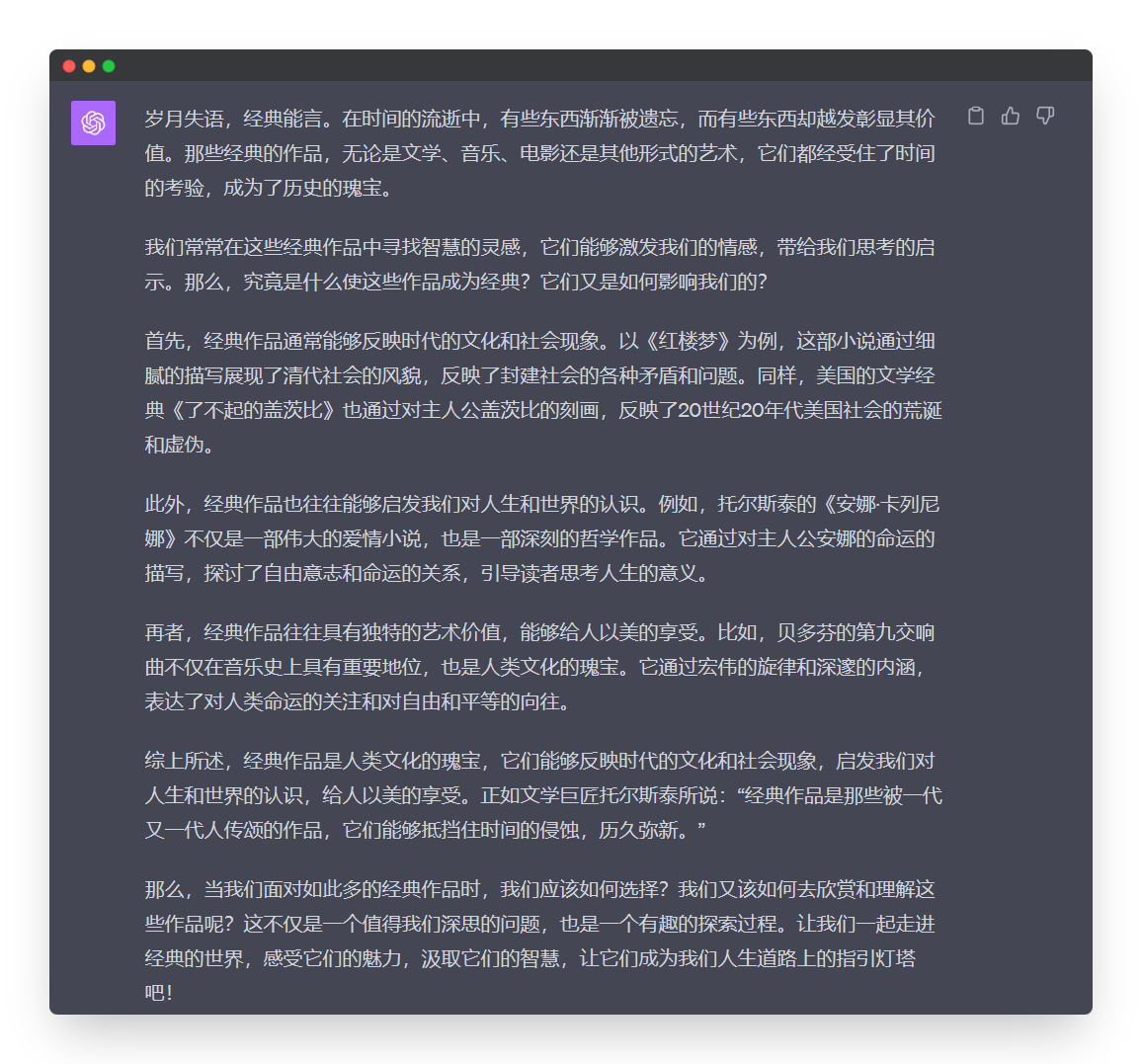

4. ChatGPT 4.0

第三轮测试总结

| 回溯一下本轮测试目的:长文本生成能力 在这个意义上,生成内容的质量结合对提示词本身工作流程的执行来看,以ChatGPT 4.0生成内容为满分的话,国内三家的排名大概为:

-

智谱清言 70 -

文心一言 80 -

Moonshot AI 80

值得一提的是,我没有在提示词中刻意约束“请你生成内容的时候不要输出我提供的这些框架和标题,直接为我生成文章”。国内三家都没有做到这一点,而 ChatGPT 4.0 自动理解了我的需求,按这个模式生成了内容。这不能怪我尬吹吧,确实聪明啊。 |

任务二:根据少样本提示,生成标题

测试提示词

| Markdown

请参考如下标题:

'''

共鸣式标题

《高房价摧毁了80后的一切》

《这个世界上最傻的事,就是对年轻人掏心掏肺地讲道理》

悬念式标题

《什么样的人不会出轨》

《我离婚了,但我很高兴》

争议式标题

《我身边离开体制的人,目前没有一个后悔的》

《我为什么支持实习生休学》

颠覆式标题

《关于如何管理你的上级的清单》

'''

为我撰写一个关于“如何找到自己喜欢的生活”的标题,并生成相关文章,文章目录如下:

1. 重新定义问题

2. 内在原因

3. 外在原因

4. 乐子不等于喜欢

5. 重构个人游戏规则

6. 能力培养,以如何学习语言为例

7. 如何创造兴趣的前置条件

8. 重构个人的数值系统

9. 心理效能表的制作

10. 将情感内嵌作为一种核心驱动 |

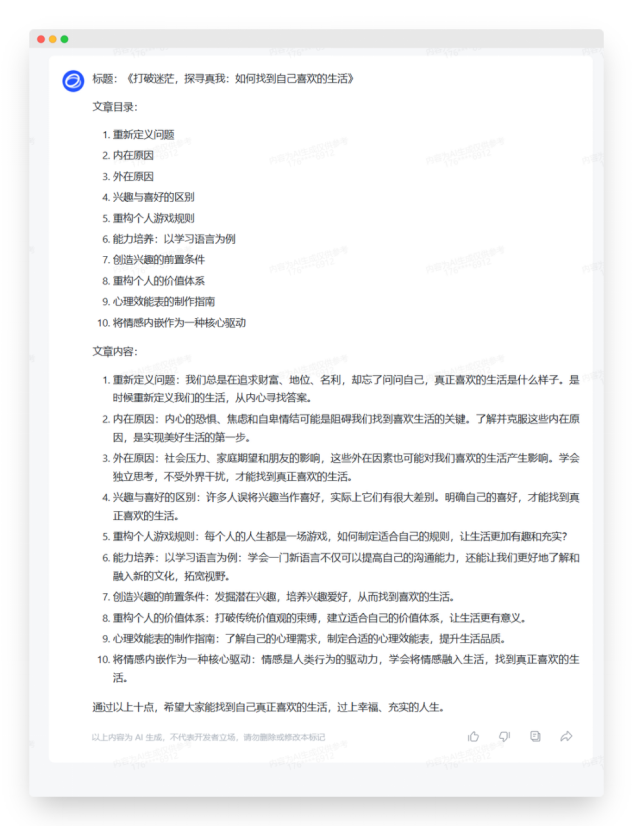

目标模型表现

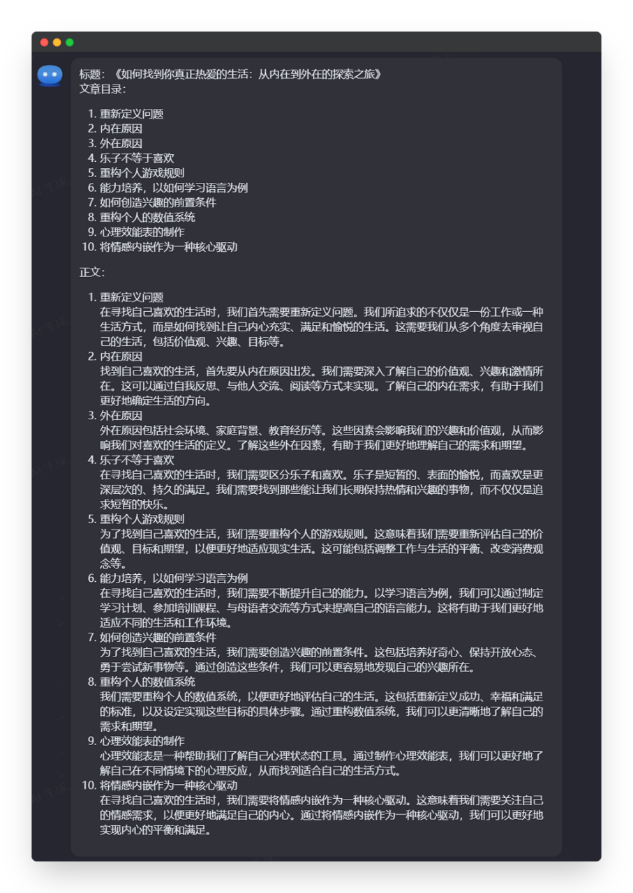

1. 智谱清言

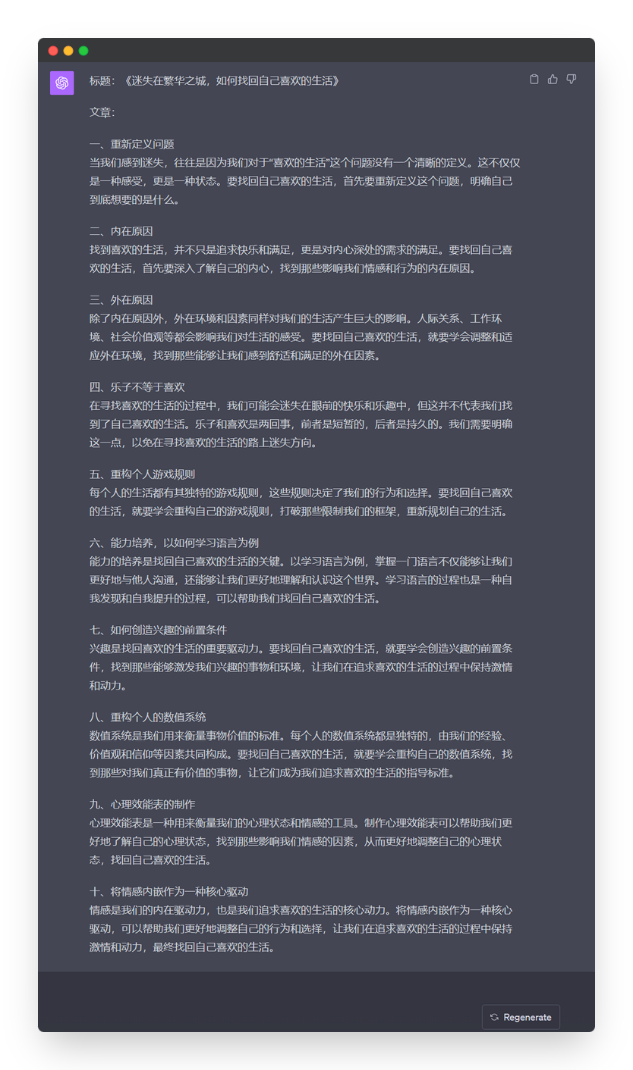

2. 文心一言4.0

3. Moonshot AI

4. ChatGPT

| 这一轮是生成文本总结,见仁见智,不做评分了,我个人更喜欢 MoonshotAI ,感觉它人狠话不多,能说到点子上。 |

感兴趣的朋友可在文末点击我的名片,备注“AI”免费领取AI学习基地 +AI交流群