Meta LLaMA是Meta公司开源的大模型,作为大模型开源界得鼻祖, 刚刚发布LLaMA3。从ChatGPT 拉开了大模型竞赛的序幕,Meta 选择了开源,至此大模型也开始百花齐放的时期,但是开源模型一直无法超过必源模型,如今LLaMA3发布,大有后来居上的趋势。

01 Meta LLaMA3的优势

- 基于超过 15T token 训练,相当于 Llama 2 数据集的 7 倍还多;

- 支持 8K 长文本,改进的 tokenizer 具有 128K token 的词汇量,可实现更好的性能;

- 在大量重要基准中均具有最先进性能;

- 在 8B 和 70B 大小上采用了分组查询注意力 (GQA,包括增强的推理和代码能力;

- 结合了三种类型的并行策略:数据并行、模型并行和流水线并行,训练效率比 Llama 2 高 3 倍;

- 带有 Llama Guard 2、Code Shield 和 CyberSec Eval 2 的新版信任和安全工具

- 先进的训练堆栈,可以自动执行错误检测、处理和维护,

- 通过 PPO 和 DPO 从偏好排名中学习也极大地提高了 LLaMA3 在推理和编码任务上的性能。

- 其他同等规模模型的比较,前者表现出 SOTA 水平.

- 目前还在开发的最大模型是 400B+ 参数的杀手锏.

此外,Meta还支持丰富的应用生态, Meta 提供的生成式 AI 能力在免费产品中性能是最强大的。在 Facebook、Instagram、WhatsApp 和 Messenger 上,用户现在可以借助 Meta AI 进行搜索,无需在应用程序之间切换.

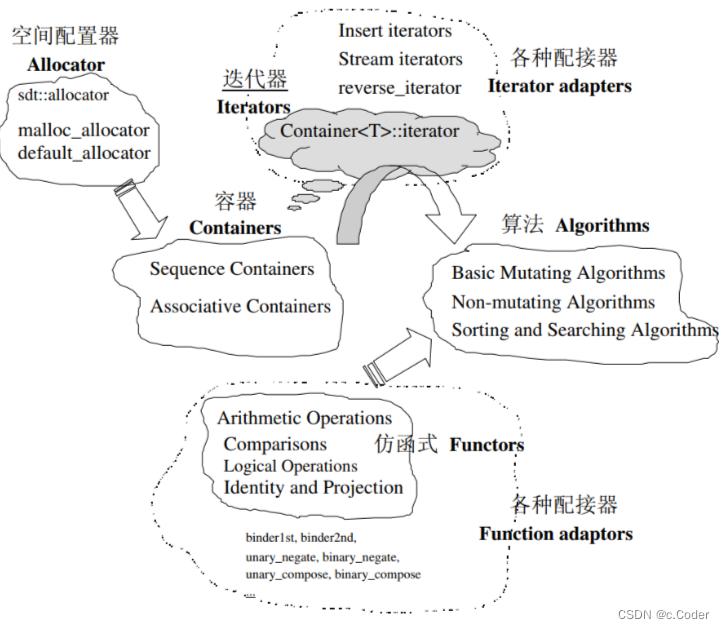

02 Meta LLaMA3的架构

Llama 3 选择了相对标准的纯解码器 Transformer 架构。与 Llama 2 相比,Llama 3 做了几个关键的改进,包括:

- Llama 3 使用具有 128K token 词汇表的 tokenizer,可以更有效地对语言进行编码,从而显著提高模型性能;

- 为了提高 Llama 3 模型的推理效率,研究团队在 8B 和 70B 大小的模型上采用了分组查询注意力 (GQA);

- 在 8192 个 token 的序列上训练模型,使用掩码确保自注意力不会跨越文档边界。

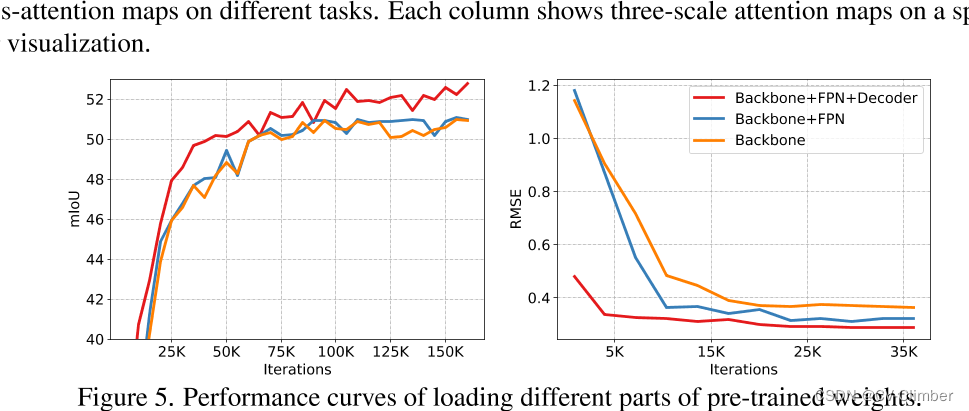

03 Meta LLaMA3 性能

(1)预训练模型的性能

(2)指令微调性能

(3)人工评估

涵盖 12 个关键用例:寻求建议、头脑风暴、分类、封闭式问答、编码、创意写作、抽取、扮演一个角色/人物、开放式问答等,下图针对 Claude Sonnet、Mistral Medium 和 GPT-3.5 对这些类别和提示进行人工评估的汇总结果

04 Meta LLaMA3使用

是驴是马,得让群众跑一跑才知道, Meta也是毫不吝啬,提供多种使用的方式给各位技术爱好者玩耍.

05 彦宏, 您怎么看

李彦宏近期表示,这样通过降维剪裁出来的模型,比直接用开源模型调出来的模型,同等尺寸下,效果明显更好;同等效果下,成本明显更低。“所以开源模型会越来越落后。

确实大模型时代, 需要很多金钱投入, 在这些方面, 往往大公司很有优势,这一点不可否认, 但是计算机近些年发展如此快速,得益于计算机技术不断开源, 比如我们常用linux操作系统、java语言、大数据hadoop、云平台k8s、opentelemetry、深度学习框架pytorch、tensorflow等等,我相信大模型也不例外,现在大模型发展就2条主线,开源和闭源, 开源也有优秀的模型,比如, Meta的LLama ,画图的Stable diffusion等推动大模型社区不断发展, 涌现更多创业型、创新型的小公司, 更多惠及到每个技术人

各位读者,你们觉得呢?

【大模型应用篇1】学会对模型念咒语

【大模型应用篇2】提示词实践-短剧文案

【大模型应用篇3】LLM时代下的智能体

【大模型应用篇4】普通人构建智能体的工具