2021年大数据挑战赛

B题 口罩佩戴检测

原题再现:

新冠疫情的爆发对人类生命安全及全球经济发展造成了重大影响。虽然现在国内疫情基本得到有效遏制,但日常防控仍不可松懈。戴口罩是预防新冠肺炎最便捷、最有效的措施和方法。人脸佩戴口罩的自动化识别可以有效检测人群佩戴口罩情况,是抑制疾病在人流量大的公共场合快速传播和保护身体健康的重要技术手段。

图 1 中,每个方框(包围盒)框选出一张人脸,不同的方框颜色用于区分是否佩戴口罩。

附件 1 训练样本中包含 train_images 和 train_anotations 两个文件夹,分别提供了 653 张图片和对应的标签信息,请你查阅相关文献,回答以下问题。

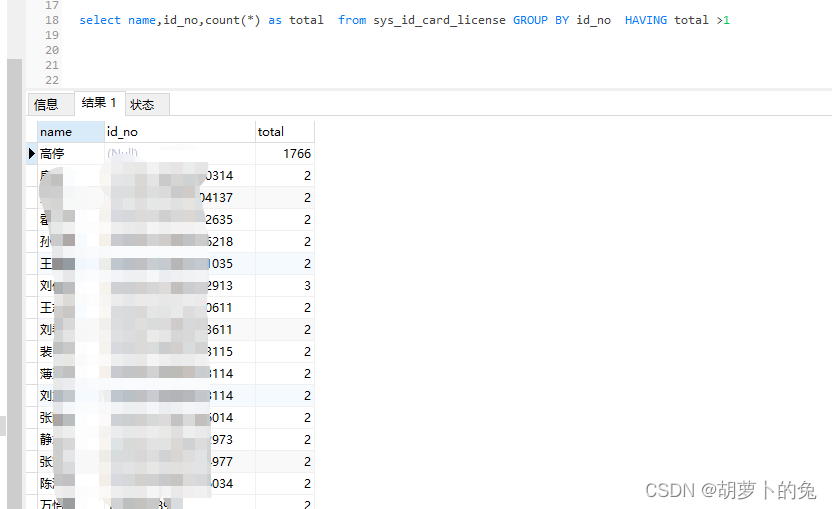

问题 1: 每个标签文件(xml 格式)中,记录了相应图片中所包含人脸信息。见图 2,以标签文件 250.xml 为例,每个元素代表一张人脸,表示该人脸处于“佩戴口罩/未佩戴口罩/未正确佩戴口罩”的其中一种状态。则记录了该人脸的包围盒的左上、右下两个顶点的坐标。你的任务是用程序(建议 Python 软件,其他软件也可以自行选用)读取 xml 中保存的数据,并参考图 1 的方式将人脸框和口罩佩戴状态进行展示,论文中重点展示“250.png” 和“477.png”这两张图片。

问题 2: 运用 653 张图片和对应的标签信息,设计人脸口罩检测算法,检测任意一张图片中存在的人脸的位置和口罩佩戴情况,并对你的算法进行校验。量化指标为 <被正确分类的人脸的数量>/<标签文件中包含的所有人脸数量>。对某张人脸来说,当且仅当 IoU 大于 0.45 时,才被认为被正确分类。

问题 3: 使用检测算法对“附件 2 测试样本”文件夹下 test_images 中包含的图片进行检测,并将检测结果汇总填写到“赛题 B 提交结果.xlsx”表格中,单独上传到竞赛平台。所有图片的标记文件需要放到项目源文件中上传。

整体求解过程概述(摘要)

新冠疫情在全球的蔓延,危害着全球 70 多亿人口的生命财产安全,虽然我国的疫情已经总体得到遏制,但国外疫情依旧严重,由于境外输入导致的小规模新冠疫情在我国时常发生。目前我国要求人员在乘坐火车、地铁等公共交通工具,和出入商场、医院等人员聚集场所时必须佩戴口罩。针对人员是否佩戴口罩,现在采用的主要方式是人工查看,在固定的出入口配备检查人员,这种方式不具有全天性,且在人群大流量流通区域容易出现漏检的情况,这样给防疫安全工作带来了很大的隐患,因此实现人脸口罩的自动化识别就能解决这些问题,有效的检测人群佩戴口罩的情况,给我国的防疫工作智能化做出贡献,抑制新冠疫情在我国的传播,保护人民群众的生命安全。

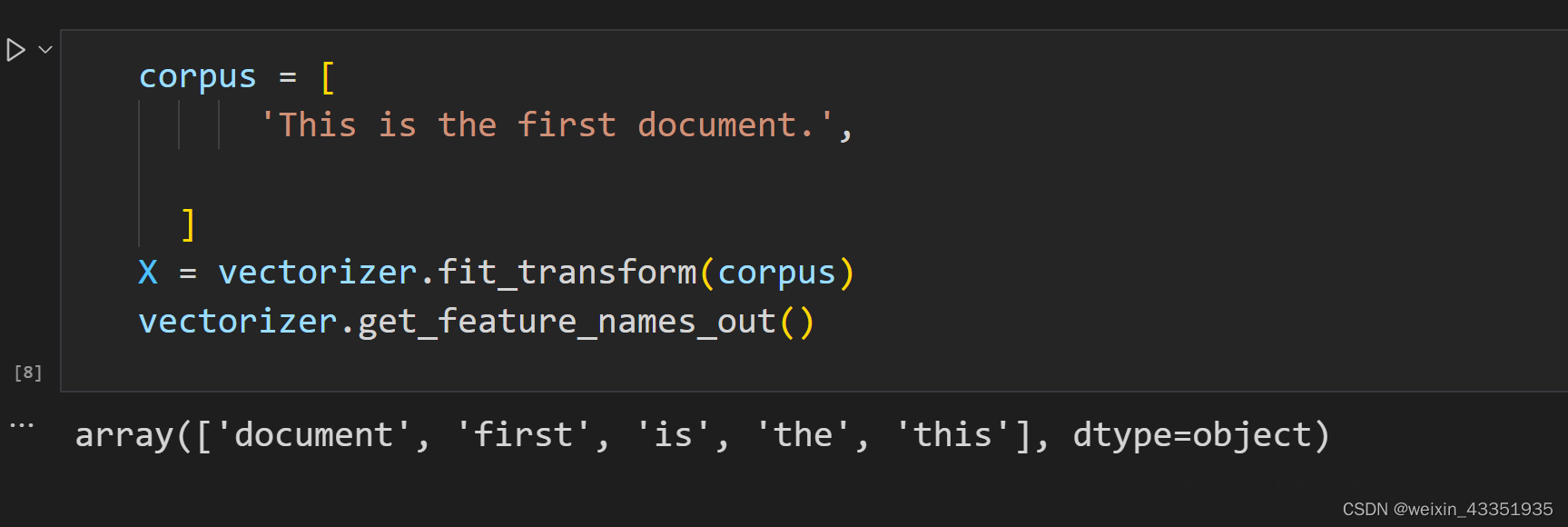

对于问题一,通过分析标签文件,理解标签文件中包含的对应图片尺寸、人脸坐标信息,以及人脸佩戴口罩情况,将标签信息在对应的图片上可视化。选用 Python 语言结合 OpenCV 包编写程序,对于“佩戴口罩、未佩戴口罩、未正确佩戴口罩”三种情况,分别选用黄、红、绿三种目标框进行框选,并且在方框的下方显相应的人脸佩戴口罩情况“with_mask、without_mask、mask_weared_incorrect”标注。

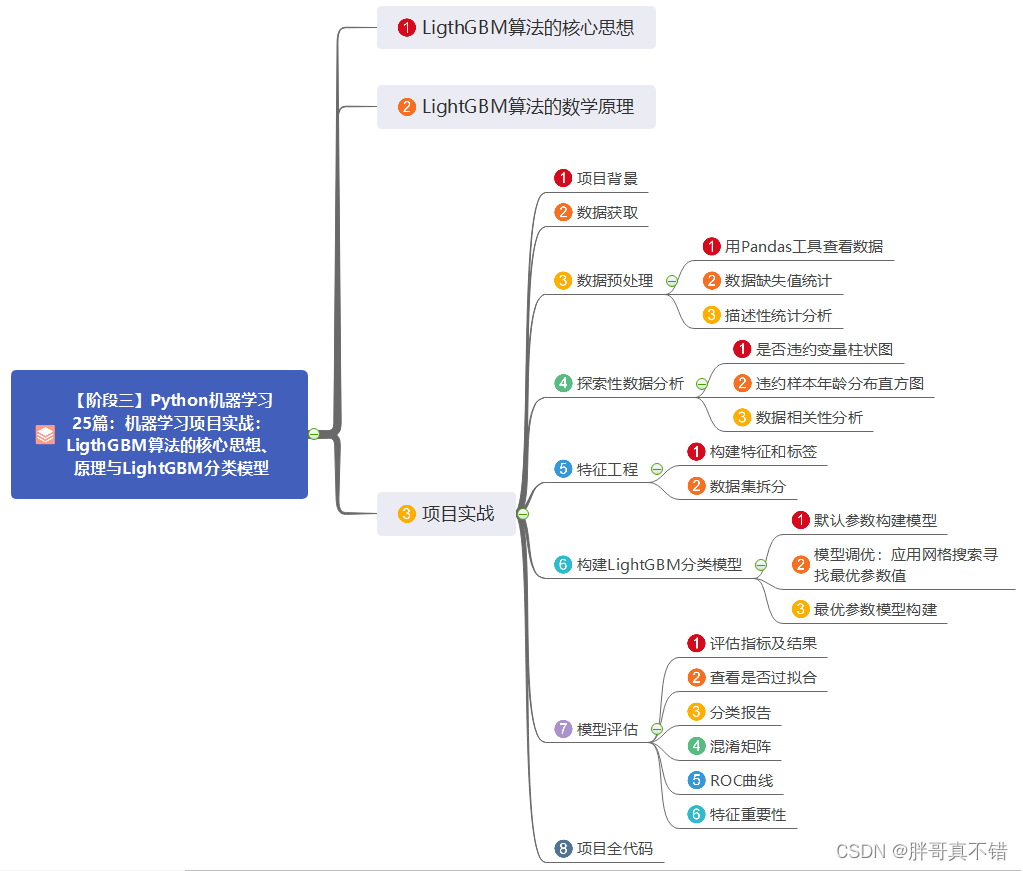

对于问题二,结合成熟的深度学习目标检测算法,和本题的实际应用背景,考虑人脸口罩检测的精确性和实时性,选用最新的 YOLOv5 算法作为本题的人脸口罩检测算法的主体框架;在对训练集数据进行分析时,发现样本数据较小而且类别数据不均衡,于是对 YOLOv5 算法采用 MSFE 损失函数进行改进,尽量消除因为数据不平衡带来的检测精度下降问题;在模型训练阶段,对训练集样本进行 9:1 划分(9 份训练集,1 份验证集),在训练过程中结合检测框和类别损失函数等随迭代次数的变化曲线,最终确定epoch=1000 作为最终迭代次数,模型训练完成之后,进行模型的测试。本模型的准确度acc 值高达 96.1%,precision 达到 86.2%,召回率 97.1%,mAP 值达到 79.1%(IOU=0.45)。

对于问题三,需要利用问题二设计的算法,对测试集样本进行人脸口罩佩戴检测,将检测的原图片经过算法进行口罩佩戴情况标注后,输出出来,然后将检测到的每张图片包含的人脸数目、正确佩戴口罩数目、未佩戴口罩数目、未正确佩戴口罩数目输出并且填写到结果表格中。

模型假设:

根据题目中所给信息以及要求,本文做出如下假设:

(1) 假设训练样本的标签文件(.xml 格式)与训练集图片一一对应;

(2) 假设训练样本的标签文件对人脸佩戴口罩类别的标注正确;

(3) 假设训练样本的标前文件对人脸的框选位置合理;

(4) 假设训练集标样本的标签文件不存在对图片人脸口罩检测漏标的情况。

问题分析:

问题一分析

通过分析题目要求,问题一是一个将附件 1 训练样本中标签信息(人脸口罩佩戴类别、人脸检测框),显示到对应达到图片中的问题。基于以上问题,我们首先读取标签文件(.xml)与对应的图片,然后根据数字图像处理的知识,通过 PIL 包中的 Image 的 Rectangle 函数在对应的图片中画出检测框,然后在根据口罩佩戴情况类别的不同显示不同的颜色框,并直观显示标签文件中“with_mask、without_mask、mask_weared_incorrect”的分类状态,然后利用循环程序一次性标记出一张图片中的所有人脸标签信息。

问题二分析

通过分析问题二的要求,需要设计一个人脸口罩检测算法,首先第一步是检测人脸,定位人脸的位置,然后依据人脸佩戴口罩的状态,分为“戴口罩、未戴口罩、未正确佩戴口罩”三类。人脸口罩检测首先是一个目标检测的问题,考虑到各类成熟目标检测算法的特点,以及本题的实际背景,我们不仅需要检测精度高而且需要做到实时检测,只有这样的模型才能符合本题背景的需求,于是最终选定基于深度学习的 YOLOv5 模型来解决这个问题。

问题三分析

针对问题三,我们需要利用问题二得到的人脸口罩检测模型对测试集的图片进行人脸口罩检测,查看“问题 B 提交结果.xlsx”文件,我们需要统计模型检测到每张图片中人脸的数目、正确佩戴数量、未佩戴数量、未正确佩戴数量;所以我们只需要将测试集中的 200 张图片输入到我们训练的模型中,然后输出以上数据,并填入相应的表格中即完成本题的任务要求。

模型的建立与求解整体论文缩略图

全部论文请见下方“ 只会建模 QQ名片” 点击QQ名片即可

程序代码:

部分程序如下:

from __future__ import division

import os.path

from PIL import Image

import numpy as np

import shutil

import cv2

from tqdm import tqdm

ImgPath = './convertor/fold0/images/val/' #原始图片

path = './convertor/fold0/labels/val/' #原始标注

ProcessedPath = './process_data/' #生成后数据

txtfiles = os.listdir(path)

print(txtfiles)

#patch img_size

patch_size = 1024

#slide window stride

stride = 600

txtfiles = tqdm(txtfiles)

for file in txtfiles: #遍历txt进行操作

image_pre, ext = os.path.splitext(file)

imgfile = ImgPath + image_pre + '.jpg'

txtfile = path + image_pre + '.txt'

# if not os.path.isdir(file): # 判断是否是文件夹,不是文件夹才打开

# print(file)

img = cv2.imread(imgfile)

sp = img.shape

img_h, img_w = sp[0], sp[1]

f = open(os.path.join(path, file), "r")

lines = f.readlines()

savepath_img = ProcessedPath + 'images' + '/val' #处理完的图片保存路径

savepath_txt = ProcessedPath + 'labels' + '/val' #处理完的图片标签路径

if not os.path.exists(savepath_img):

os.makedirs(savepath_img)

if not os.path.exists(savepath_txt):

os.makedirs(savepath_txt)

bndbox = []

boxname = []

for line in lines:

c, x_c, y_c, w, h, _ = line.split(' ')

c, x_c, y_c, w, h = float(c), float(x_c), float(y_c), float(w), float(h)

bndbox.append([x_c, y_c, w, h])

boxname.append([c])

# print("boxname: ", boxname)

# b = bndbox[1]

# print(b.nodeName)

#a: x起点, b: y起点, w: 宽, h: 高

a = []

b = []

for a_ in range(0, img_w, stride):

a.append(a_)

for b_ in range(0, img_h, stride):

b.append(b_)

cropboxes = []

for i in a:

for j in b:

cropboxes.append([i, j, i + patch_size, j + patch_size])

i = 1

top_size, bottom_size, left_size, right_size = (150, 0, 0, 0)

def select(m, n, w, h):

# m: x起点, n: y起点, w: 宽, h: 高

bbox = []

# 查找图片中所有的 box 框

for index in range(0, len(bndbox)):

boxcls = boxname[index]#获取回归框的类别

# print(bndbox[index])

# x min

x1 = float(bndbox[index][0] * img_w - bndbox[index][2] * img_w/2)

# y min

y1 = float(bndbox[index][1] * img_h - bndbox[index][3] * img_h/2)

# x max

x2 = float(bndbox[index][0] * img_w + bndbox[index][2] * img_w/2)

# y max

y2 = float(bndbox[index][1] * img_h + bndbox[index][3] * img_h/2)

# print("the index of the box is", index)

# print("the box cls is",boxcls[0])

# print("the xy", x1, y1, x2, y2)

#如果标记框在第一个范围内则存入bbox[] 并转换成新的格式

if x1 >= m and x2 <= m + w and y1 >= n and y2 <= n + h:

a1 = x1 - m

b1 = y1 - n

a2 = x2 - m

b2 = y2 - n

box_w = a2 - a1

box_h = b2 - b1

x_c = (a1 + box_w/2)/w

y_c = (b1 + box_h/2)/h

box_w = box_w / w

box_h = box_h / h

bbox.append([boxcls[0], x_c, y_c, box_w, box_h]) # 更新后的标记框

if bbox is not None:

return bbox

else:

return 0

img = Image.open(imgfile)

for j in range(0, len(cropboxes)):

# print("the img number is :", j)

# 获取在 patch 的 box

Bboxes = select(cropboxes[j][0], cropboxes[j][1], patch_size, patch_size)

if len(Bboxes):

with open(savepath_txt + '/' + image_pre + '_' + '{}'.format(j) + '.txt', 'w') as f:

for Bbox in Bboxes:

for data in Bbox:

f.write('{} '.format(data))

f.write('\n')

#图片裁剪

try:

cropedimg = img.crop(cropboxes[j])

# print(np.array(cropedimg).shape)

cropedimg.save(savepath_img + '/' + image_pre + '_' + str(j) + '.jpg')

# print("done!")

except:

continue