吴恩达机器学习理论基础—逻辑回归模型

说明:逻辑回归解决的是分类问题:例如常见的二分类问题。即得到的输出结果只有两个值的信息。

逻辑回归概念基础

逻辑回归用来解决数据集为0和1的二分类的问题

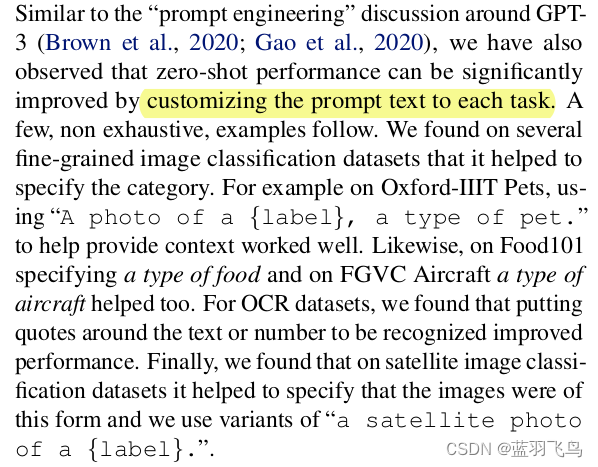

使用逻辑回归模型来解决对应的问题则需要使用一个函数将实数集映射为[0,1]区间上的离散值。常用的函数是:sigmoid函数(也称逻辑回归函数)函数图像如下所示

需要注意的是函数不是连续的函数存在两个无穷间断点,其中z是线性回归模型中使用的函数

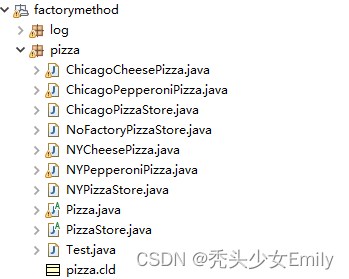

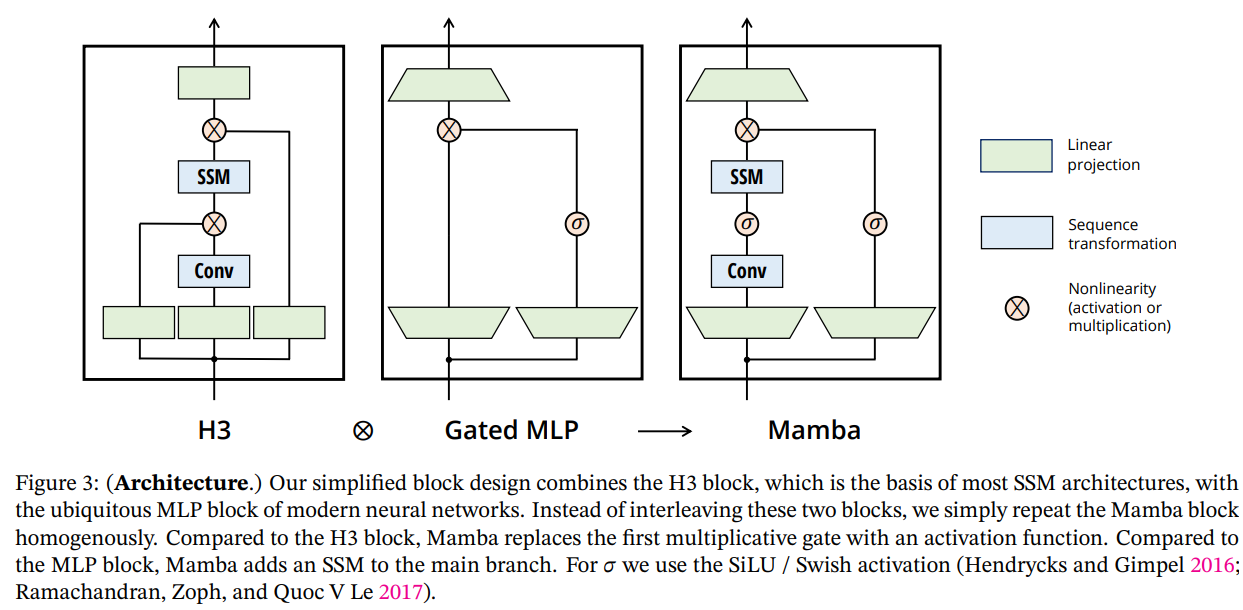

整个逻辑回归模型的构建过程如下图所示

决策边界问题

选择一个常见的阈值,将预测的结果判定为0或者1,一般情况下可以选择0.5作为边界条件,大于0.5预测值设置为1,相反小于0.5预测值设置为0。从而完成整个算法。

可视化逻辑回归的决策边界过程

-

情况一:当决策边界是一条直线的情况下。(线性回归的情况下)

-

情况二:当决策边界不是一条直线的情况下(多项式回归的情况下)

总结:通过对以上案例的学习可以了解到,决策边界可以简单的理解为在带入sigmoid函数之前的线性模型z:即为数据对应的决策边界

逻辑回归代价函数(损失函数)

在进行模型优化之前首先要先确定逻辑回归的代价函数,便于进一步优化。确定表达式中的w和b的值。

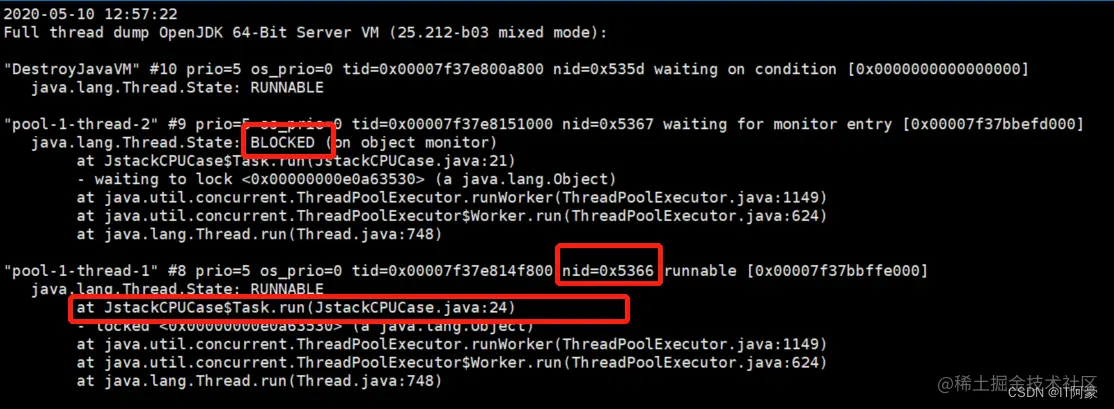

在课程中首先定义了均方误差损失:并说明了若使用均方误差损失的话,用梯度下降算法来进行优化则无法得到最有的值(存在多个局部最优值)

因此需要将损失函数优化成为凸函数的形式。

- 当预测值为1时有(两个离散值的概率之和为1)

- 当预测值为0时(其损失函数在0附近的损失最小)

梯度下降进行训练

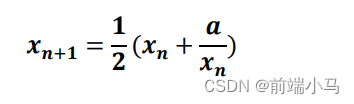

经过优化之后的损失函数:

使用梯度下降算法来进行训练,与线性回归的梯度下降算法相比,f(x)的形式不同(定义不一样)表达的式子相同(小批量梯度下降算法,设置学习率)

过拟合问题与解决

在提出过拟合问题之前首先提出了拟合不足和具有高偏差的问题

根据的特征过多且该特征并无相关的关系时(即在训练的过程中存在偏见)

通过对象式回归提出过拟合(高偏差)的问题(简单的说是模型可以很好的拟合数据集但却无法和测试集进行较好的拟合)

- 解决方法一:使用较少的特征进行训练和选择丢弃一些无效的特征数据来进行预测。

- 解决方法二:使用较小的参数值使得对训练的结果影响较小。

- 解决方法三:收集更多的数据来进行训练和实现(有时是不可以实现的)