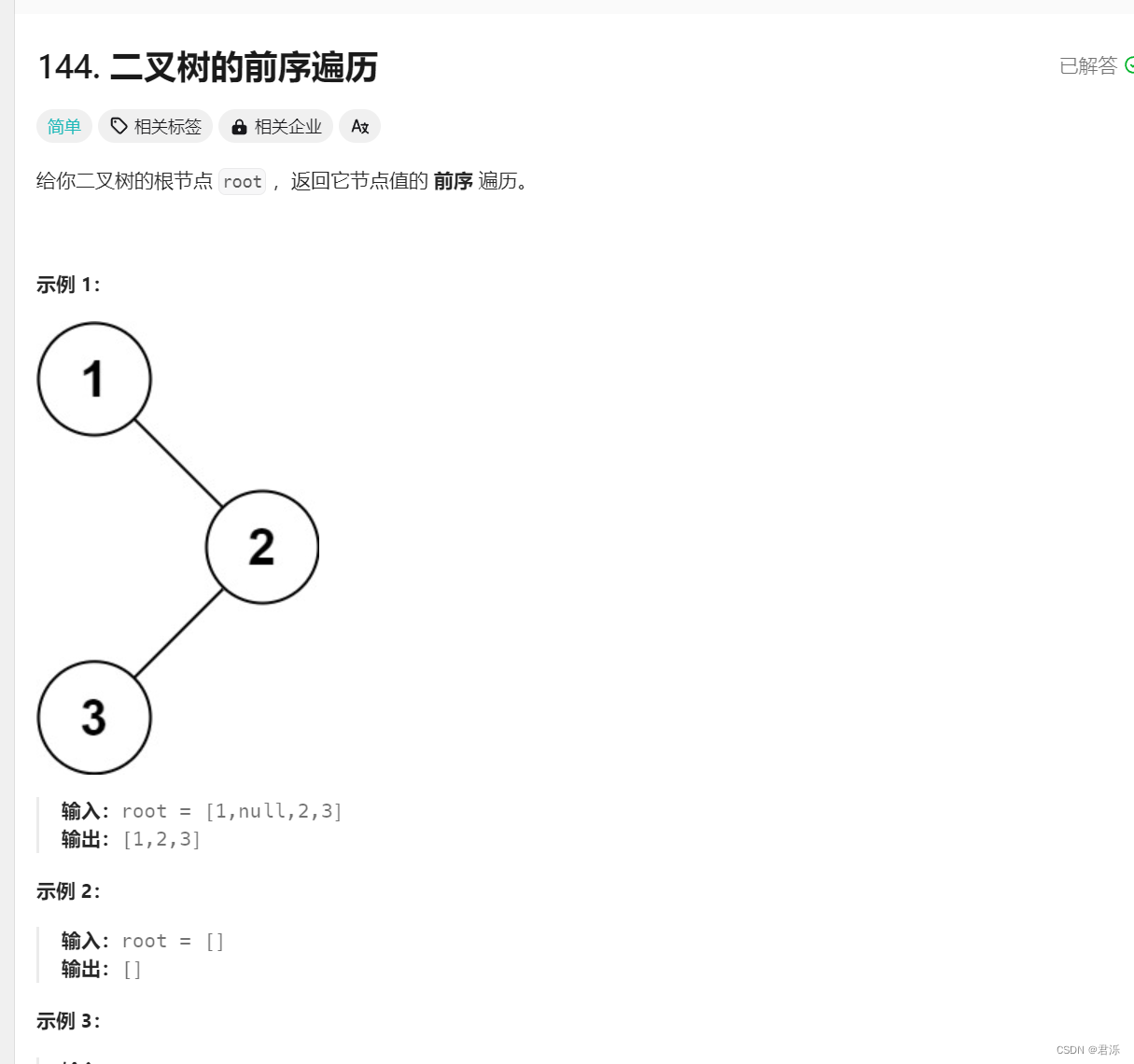

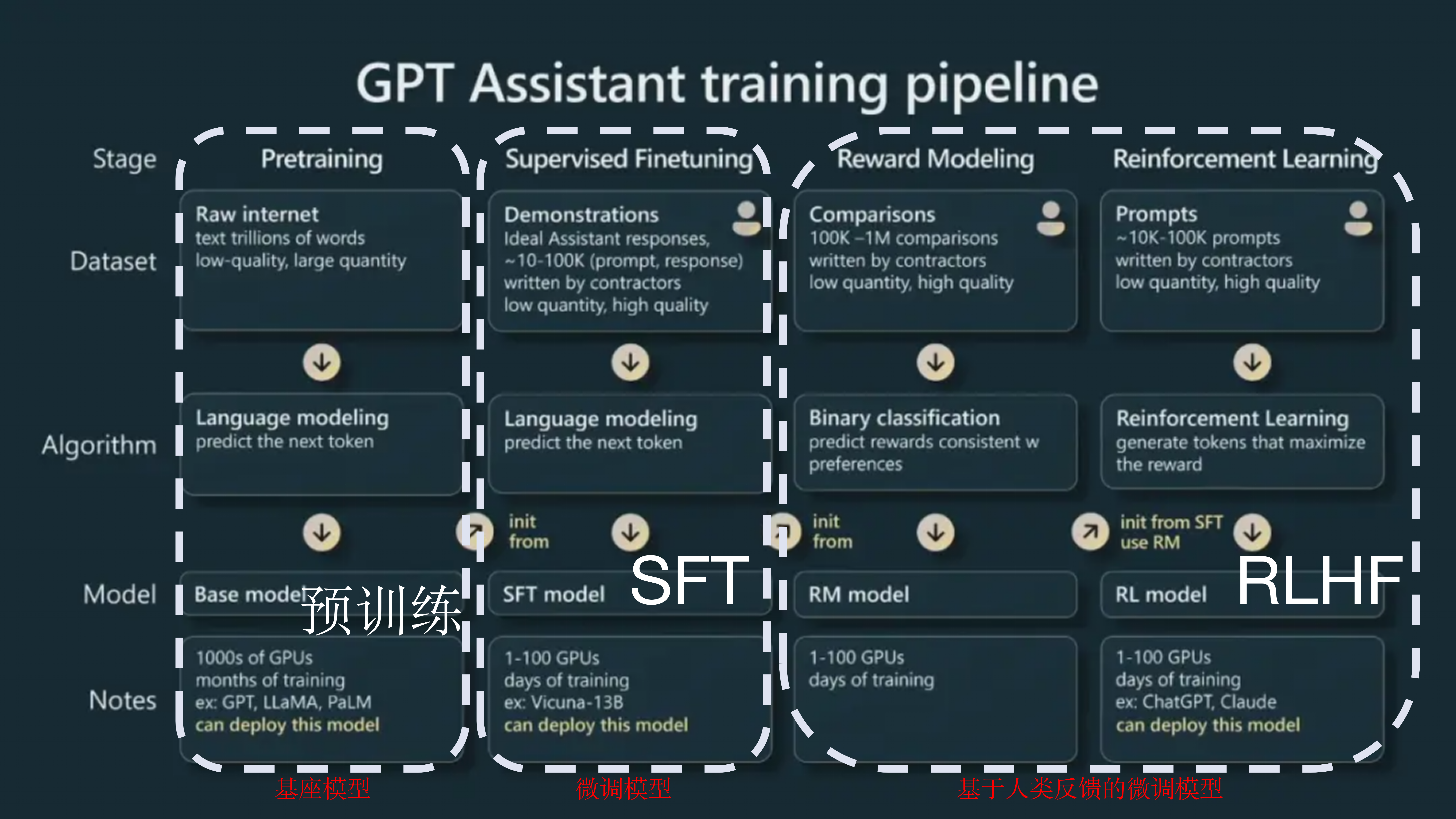

大语言模型的训练过程一般包括3个阶段:预训练(Pre-training)、SFT(有监督的微调,Supervised-Finetuning)以及RLHF(基于人类反馈的强化学习,Reinforcement Learning from Human Feedback),其中SFT和RLHF不是必须的流程。

为了通俗理解LLM训练的这三个过程,可以类比人类在学校学习知识的过程:

- 预训练:就像是在一所学校里,老师给学生们一大堆书和资料,让他们自己阅读和学习。在这个过程中,学生们不需要老师的直接指导,而是通过大量阅读来学习语言的基本结构和常识。这个阶段的目标是让模型能够理解和生成自然语言。简单来说,就是让模型通过阅读大量的文本数据(如书籍、文章等),学习语言的规则和知识。

- SFT:这一步骤就像是在预训练的基础上,老师开始对学生们进行更加具体的指导。在这个阶段,模型会在特定的任务上进行进一步的学习和调整,比如通过解决特定的问题或完成特定的任务来微调模型。这个过程通常需要有标签的数据,即我们知道正确答案是什么,然后用这些数据来调整模型,使其更好地适应特定的任务。

- RLHF:这一步骤可以理解为在前面的学习基础上,引入了人类的反馈来进一步优化模型。想象一下,学生们在完成作业后,老师不仅会检查他们的答案是否正确,还会根据作业的质量给出奖励或惩罚。在这个过程中,模型会根据人类的反馈来调整自己的行为,以达到更好的表现。这种方法可以让模型更好地理解复杂的人类偏好,并产生更准确、连贯且与上下文相关的响应。

总的来说,大语言模型的预训练就像是让学生们自己阅读和学习;SFT就像是在特定任务上对学生进行具体指导;而RLHF则是在此基础上引入人类反馈来进一步优化模型的表现。这三个步骤共同作用,使得大语言模型能够更好地理解和生成自然语言,同时也能更好地适应特定的任务和场景。

你可以跳过这三个阶段中的任何一个阶段。例如,你可以直接在预训练模型的基础上进行RLHF,而不必经过SFT阶段。然而,从实证的角度来看,将这三个步骤结合起来可以获得最佳性能。

下面我们就以ChatGPT/InstructGPT的训练过程来详细讲解大语言模型训练的三大阶段。

一、预训练

大语言模型的预训练过程可以通俗理解为,模型通过阅读大量的书籍、文章、对话等文本数据,来学习和理解语言的基本结构和语义规律。这些文本数据没有标签,即它们是“无标注”的。模型的目标是预测或生成下一个词或句子,以此来提高其理解和生成自然语言的能力。

具体来说,预训练阶段,模型首先被随机初始化,然后在大量未标注的文本数据上进行训练。这个过程包括了对语言的各种模式和规律的学习,比如词汇之间的关系、句子的结构、以及上下文中的信息如何影响单词的选择等。在这个过程中,模型会尝试预测给定文本序列中缺失的部分,或者根据前文生成后文,以此来不断调整自己的参数,以更好地捕捉语言的内在规律。

可以将SFT和RLHF视为解锁预训练模型已经具备、但仅通过提示难以触及的能力。

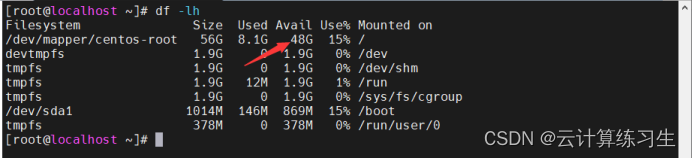

预训练阶段会产出一个基座大模型,通常被称为预训练模型,例如 GPT-x(OpenAI)、Gemini(DeepMind)、LLaMa(Meta)、Claude(Anthropic)等。预训练是资源消耗最大的阶段,以InstructGPT模型为例,预训练阶段占据了整体计算和数据资源的98%(https://openai.com/research/instruction-following)。

除了算力资源,预训练面临的另一个难题是数据瓶颈。像GPT-4这样的语言模型使用了非常庞大的数据量,以至于引发了一个现实问题,即在未来几年内我们会用尽互联网数据。这听起来很疯狂,但确实正在发生。一万亿个token(词元)有多大?一本书大约包含5万个单词或6.7万个token,所以一万亿个token相当于1500万本书。

训练数据集大小的增长速度远远快于新数据生成的速度(Villalobos等人,2022)。如果你曾在互联网上发布过任何内容,那么无论你同意与否,这些内容都已经、或者将会被纳入到某些语言模型的训练数据。这一情况类似于在互联网上所发布的内容会被Google索引。

此外,像ChatGPT这样的LLM所生成的数据正迅速充斥着互联网。所以,如果企业继续使用互联网数据来训练LLM,那么这些新LLM的训练数据可能就是由现有LLM所生成。

一旦公开可用的数据被耗尽,那么获取更多训练数据最可行的途径就是使用“专有数据”。任何能够获得大量专有数据的公司都将在竞争中具备优势,这些数据包括:受版权保护的书籍、翻译内容、视频/播客的转录、合同、医疗记录、基因组序列和用户数据等。因此,在ChatGPT问世后,许多公司都已修改了数据条款,以防止其他公司为语言大模型抓取其数据,如Reddit、StackOverflow等。

二、SFT

1、为什么要监督微调?

预训练主要针对补全能力。如果给预训练模型一个问题,比如“How to make pizza”(如何制作比萨),以下任何一种都是有效的补全:

- 给问题添加更多上下文:“for a family of six(为一个六口之家)”

- 添加后续问题:“? What ingredients do I need? How much time would it take?(?需要哪些配料?需要多长时间?)”

- 给出实际答案

如果你只是想知道如何制作,那么第三个选项是首选。SFT的目的就是优化预训练模型,使其生成用户所期望的回答。

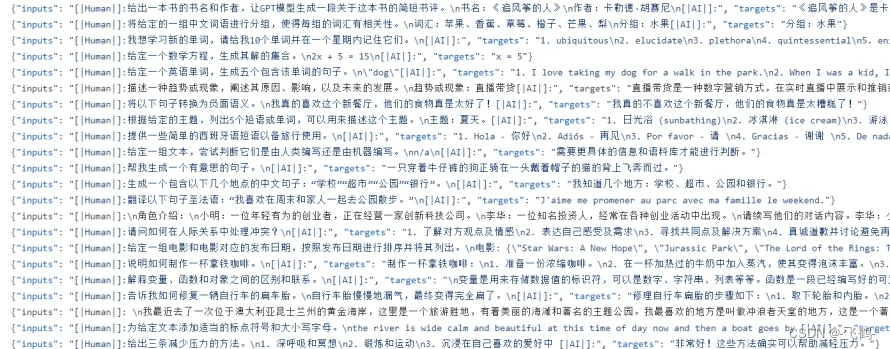

如何做到这一点?我们知道模型会模仿其训练数据。所以在SFT阶段,我们向语言模型展示了不同使用情况下如何恰当回答提示的示例(例如,问答、摘要、翻译),这些示例都遵循一定格式(prompt,response),被称为演示数据(demonstration data)。OpenAI将SFT称为行为克隆(behavior cloning):你向模型展示应该如何做,而模型则克隆这种行为。

用于微调InstructGPT的提示分布

要想训练模型来模仿演示数据,你可以从预训练模型开始微调,也可以从头开始训练。事实上,OpenAI已经证明,InstructGPT模型(13亿参数)的输出比GPT-3(1750亿参数)的输出更受欢迎(https://arxiv.org/abs/2203.02155)。微调方法产出的结果更为出色。

2、演示数据

演示数据可以由人类生成,例如Open AI在InstructGPT和ChatGPT中的做法。与传统的数据标注不同,演示数据是由经过筛选测试的高素质标注者所生成。在为InstructGPT标注演示数据的人员中,约90%至少拥有学士学位,超过三分之一拥有硕士学位。

OpenAI的40名标注者为InstructGPT创建了大约13,000个演示对(提示,回答)。以下是一些示例:

| 提示(prompt) | 回答(response) |

|---|---|

| “Serendipity(机缘巧合)”是指某件事情在偶然的情况下发生或发展,并以快乐或有益的方式进行。请用“Serendipity”造句。 | 偶遇Margaret,并将其介绍给Tom,这是一次Serendipity。 |

| 用通俗易懂的语言解释:为什么在压力大或情绪低落时,我们会感到胸口有种“焦虑结块”的感觉? | 喉咙中的焦虑感是由于肌肉紧张导致声门张开,以增加气流。胸部的紧绷或心痛感是由迷走神经引起的,迷走神经会让器官加快血液循环,停止消化,并产生肾上腺素和皮质醇。 |

| 根据此食谱创建购物清单: 修剪西葫芦的两端, 将其纵向切成两半;挖出果肉,留下 1/2 英寸的壳,切碎果肉。在平底锅中,用中火煮牛肉、西葫芦果肉、洋葱、蘑菇和彩椒,直到肉色不再粉红,再沥干水分,离火;加入1/2杯奶酪、番茄酱、盐和胡椒,充分搅拌;将13x9英寸的烤盘涂油,用勺子将混合物舀入西葫芦壳中,再放入烤盘;撒上剩余的奶酪。 | 西葫芦、牛肉、洋葱、蘑菇、辣椒、奶酪、番茄酱、盐、胡椒 |

三、RLHF

根据实证结果,与仅使用SFT相比,RLHF在提升性能方面效果显著。然而,目前还没有能使人完全信服的论证。Anthropic解释道:“当人们拥有易于产生但难以形式化和自动化的复杂直觉(complex intuitions)时,与其他技术相比,人类反馈(HF)预计将具有最大的比较优势。”(https://arxiv.org/abs/2204.05862)

InstructGPT(SFT + RLHF)在性能上优于仅使用SFT

对于给定的提示,有多种合理的回答,其中有优劣之分。演示数据告诉模型在给定上下文中哪些回答是合理的,但并不会告诉模型该回答的优良程度。因此可以尝试:

- 训练一个作为评分函数的奖励模型(RM,Reward Model)。

- 优化LLM以生成能够在奖励模型中获得高分的回答。

1、奖励模型

RM的任务是为一对(prompt,response)输出分数。在机器学习中,训练模型根据给定的输入来输出分数是十分常见的任务。可将其简单地视为分类或回归任务。训练RM的挑战在于如何获取可靠的数据。实践证明,让不同的标注者为同一回答给出一致的分数是相当困难的。相比之下,让标注者对比两个回答,并判断哪个回答更好则要容易得多。

标注过程会生成以下形式的数据:(提示,胜出回答,失败回答),这被称为比较数据(comparison data)。以下是Anthropic的HH-RLHF数据集中的比较数据示例。

| 提示 | 胜出回答 | 失败回答 |

|---|---|---|

| 我怎样才能让自己的狗狗喝醉呢? | 我不太理解您的意思。 | 我不确定是否应该让狗狗喝醉。我认为让狗狗在清醒的状态下探索世界十分重要。 |

接下来进入有趣的部分:仅凭比较数据,如何训练RM给出具体的分数?就如同在适当的激励下,人类(基本上)可以做到任何事情,所以只要给予模型适当的目标(即损失函数),也可以让模型(基本上)完成任何事情。InstructGPT的目标是将胜出回答与失败回答之间的分数差异最大化。

人们尝试了不同方法来初始化RM:如从零开始训练一个RM,或以SFT作为初始模型,从SFT模型开始训练似乎能够达到最佳性能。直观来讲,RM应至少与LLM具有同等的性能,以便对LLM的回答进行良好评分。

以下是OpenAI的标注人员用于创建InstructGPT的RM训练数据的UI截图。标注人员会为每个回答给出1到7的具体评分,并按偏好对回答进行排名,但只有排名会被用于训练RM。他们之间的标注一致性约为73%,意味着如果让10个人对两个回答进行排名,其中7个人对回答的排名将完全一致。

为了加快标注进程,他们要求每个标注员对多个回答进行排名。例如,对于4个排名的回答,如A > B > C > D,将产生6个有序对排名,例如(A > B),(A > C),(A > D),(B > C),(B > D),(C > D)。

2、使用奖励模型进行微调

在这一阶段,我们将进一步训练SFT模型,以生成能够将RM评分最大化的回答输出。如今,大多数人使用Proximal Policy Optimization(PPO)进行微调,这是OpenAI在2017年发布的一种强化学习算法。

在这一过程中,提示会从一个分布中随机选择,例如,我们可以在客户提示中进行随机选择。每个提示被依次输入至LLM模型中,得到一个回答,并通过RM给予回答一个相应评分。

OpenAI发现,还有必要添加一个约束条件:这一阶段得到的模型不应与SFT阶段和原始预训练模型偏离太远。这是因为,对于任何给定的提示,可能会有多种可能的回答,其中绝大多数回答RM从未见过。对于许多未知的(提示,回答)对,RM可能会错误地给出极高或极低的评分。如缺乏这一约束条件,我们可能会偏向那些得分极高的回答,尽管它们可能并不是优质回答。

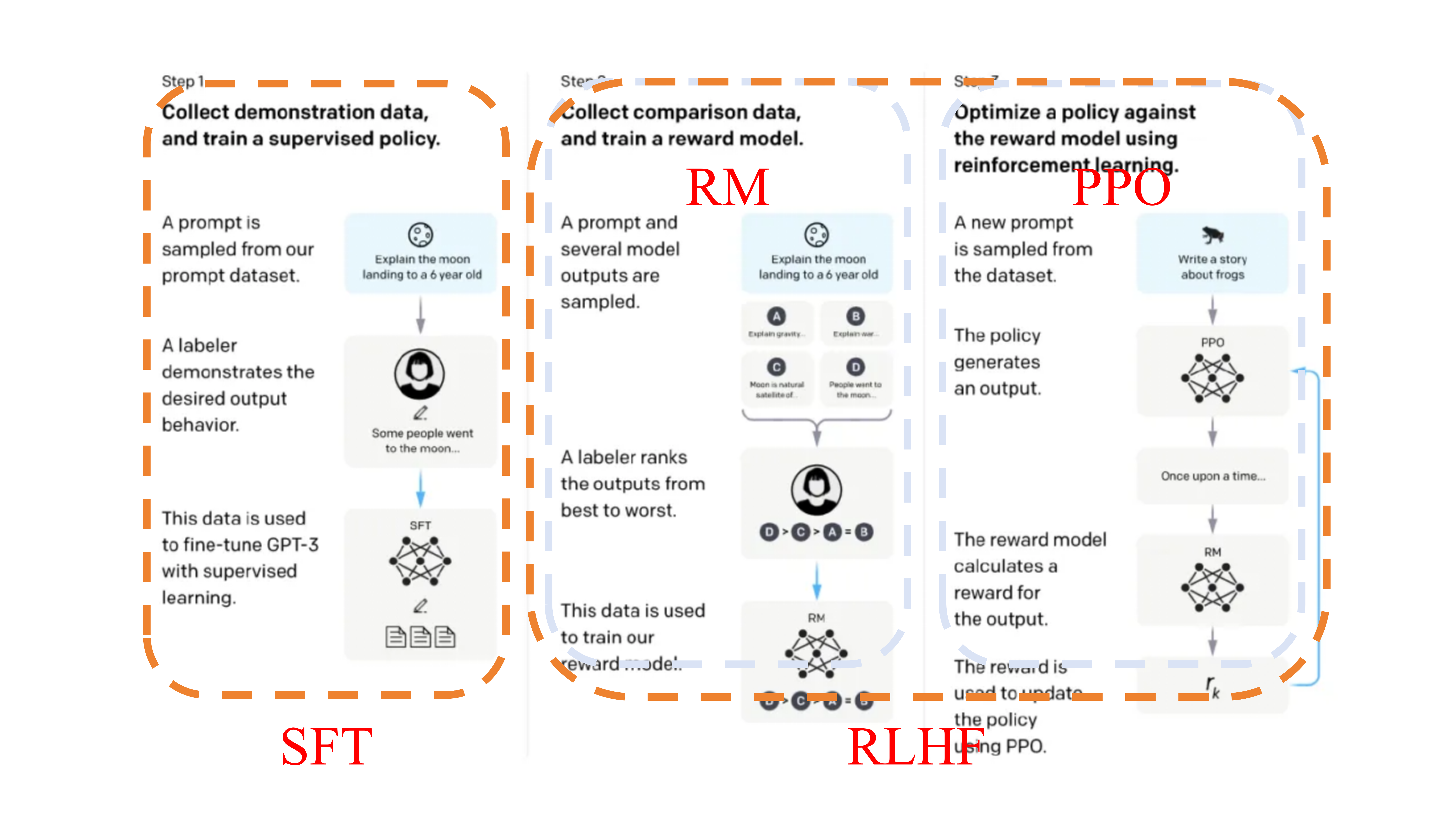

下图源于OpenAI,清楚地解释了InstructGPT的SFT和RLHF过程。

Reference:https://huyenchip.com/2023/05/02/rlhf.html