大家好,今日必读的大模型论文来啦!

1.CT-LLM:仅 20 亿参数,基于中文的大型语言模型

来自开源研究社区 Multimodal Art Projection、复旦大学和香港科技大学的研究团队及其合作者,推出了一个 20 亿参数的大型语言模型(LLM)——CT-LLM。

据介绍,CT-LLM 主要采用中文文本数据,并使用了由 12000 亿个 token 组成的庞大语料库,其中包括 8000 亿个中文 token、3000 亿个英文 token 和 1000 亿个代码 token。这种策略性组合有助于该模型更好地理解和处理中文,并通过对齐技术进一步增强了这一能力。

结果显示,CT-LLM 在 CHC-Bench 上表现出色,在中文任务中有不俗的表现,并通过 SFT 展示了其在英文任务中的能力。这项研究挑战了目前主要在英语语料库中训练 LLM,然后将其应用于其他语言的模式。

论文链接:

https://arxiv.org/abs/2404.04167

2.TableLlama:开放式表格通用大模型

该研究为使开源大型语言模型(LLM)成为适用于各种基于表格的任务的通用模型,迈出了重要一步。

来自俄亥俄州立大学的研究团队构建了一个新的数据集 TableInstruct,其中包含各种现实的表格和任务,用于指令微调和评估 LLM。他们通过对 Llama 2 (7B) 和 LongLoRA 进行微调,进一步开发了首个针对表格的开源通用模型 TableLlama,从而应对长上下文挑战。

在 8 个域内任务中的 7 个任务上,TableLlama 在每个任务上都取得了与当前 SOTA 相当或更好的性能,尽管后者通常具有针对特定任务的设计。在 6 个域外数据集上,与基础模型相比,TableLlama 的绝对值提高了 5-44 个百分点,这表明在 TableInstruct 上进行的训练增强了模型的通用性。

论文链接:

https://arxiv.org/abs/2311.09206

项目地址:

https://osu-nlp-group.github.io/TableLlama/

3.Concept Weaver:在文本到图像模型中实现多概念融合

虽然在定制“文生图”模型方面取得了重大进展,但生成结合了多个个性化概念的图像仍然具有挑战性。

在这项工作中,来自韩国科学技术院和 Adobe 的研究团队,提出了一种在推理时组成定制文本到图像扩散模型的方法——Concept Weaver。

具体来说,该方法将整个过程分为两个步骤:创建与输入提示语义一致的模板图像,然后使用概念融合策略对模板进行个性化处理。融合策略将目标概念的外观融入模板图像,同时保留其结构细节。

结果表明,与其他方法相比,该方法可以生成多个自定义概念,并具有更高的身份保真度。此外,该方法还能无缝处理两个以上的概念,并密切遵循输入提示的语义,而不会混合不同主体的外观。

论文链接:

https://arxiv.org/abs/2404.03913

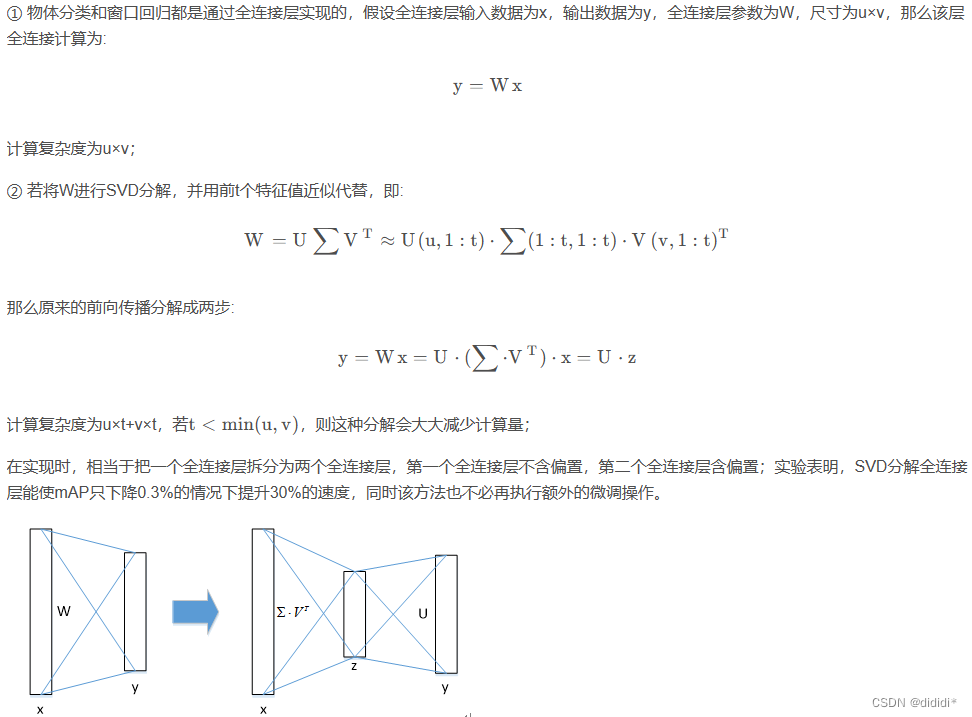

4.从语言嵌入的特征字段理解物理特性

计算机能否仅通过视觉感知物体的物理特性?认知科学和视觉科学的研究表明,人类擅长纯粹根据视觉外观识别材料并估计其物理特性。

在这项工作中,伊利诺伊大学香槟分校团队提出了一种利用图像集密集预测物体物理特性的新方法。受人类如何通过视觉进行物理推理的启发,他们利用大型语言模型(LLM)为每个物体提出候选材;然后,构建语言嵌入点云,并使用零样本核回归方法估计每个 3D 点的物理属性。

该方法准确、无需注释,适用于开放世界中的任何物体。实验证明了所提方法在各种物理属性推理任务中的有效性,如估算常见物体的质量以及摩擦力和硬度等其他属性。

论文链接:

https://arxiv.org/abs/2404.04242

项目地址:

https://ajzhai.github.io/NeRF2Physics/

5.微软研究院:让语言模型利用一般偏好进行自我改进

这项工作研究了大型语言模型(LLMs)的后训练(post-training),利用来自强大 oracle 的偏好反馈来帮助模型迭代改进自身。

后训练 LLM 的典型方法是人类反馈强化学习(RLHF),这种方法传统上将奖励学习和后续策略优化分开。然而,这种奖励最大化方法受限于“按点计算”奖励的性质(如 Bradley-Terry 模型),无法表达复杂的不等式或循环偏好关系。虽然 RLHF 的研究进展表明,奖励学习和策略优化可以合并为一个单一的对立目标,从而实现稳定性,但它们仍然受制于奖励最大化框架。最近,新一轮研究避开了奖励最大化的假设,转而直接对“成对”(pair-wise)或一般偏好进行优化。

微软研究院团队提出了一种可证明、可扩展的算法“直接纳什优化”(DNO),其将对比学习的简单性和稳定性与优化一般偏好的理论通用性结合在一起。由于 DNO 是一种使用基于回归目标的批量 on-policy 算法,因此其实现简单高效。

此外,DNO 还能在迭代过程中实现单调改进,这有助于其超越强大的“教师模型”(如 GPT-4)。结果显示,由 DNO 对齐的 7B 参数 Orca-2.5 模型在 AlpacaEval 2.0 上对 GPT-4-Turbo 的胜率达到了 33%(即使在控制了响应长度之后),比初始化模型的高出 26%(7% 到 33%)。它甚至优于参数更多的模型,包括 Mistral Large、Self-Rewarding LM(70B 参数)和旧版本的 GPT-4。

论文链接:

https://arxiv.org/abs/2404.03715

6.增强物联网智能:基于 Transformer 的强化学习方法

物联网(IoT)的普及使得互联设备产生的数据激增,为复杂环境中的智能决策带来了机遇和挑战。

然而,传统的强化学习(RL)方法由于处理和解释物联网应用中固有的复杂模式和依赖关系的能力有限,往往难以充分利用这些数据。

来自亚喀巴科技大学研究团队及其合作者提出了一种新颖的框架,它将 transformer 架构与近端策略优化 (PPO) 相集成,以应对这些挑战。

通过利用 transformer 的自我关注机制,他们的方法增强了 RL 智能体在动态物联网环境中的理解和行动能力,从而改进了决策过程。该研究团队在从智能家居自动化到工业控制系统等各种物联网场景中展示了此方法的有效性、决策效率和适应性的显著提高。该研究团队详细探讨了 transformer 在处理异构物联网数据中的作用,评估了该框架在不同环境中的性能,并与传统的 RL 方法进行了对比。

结果表明,该方法使 RL 智能体在驾驭复杂的物联网生态系统方面取得了SOTA 。

论文链接:

https://arxiv.org/abs/2404.04205

7.RLCM:通过强化学习微调一致性模型

强化学习(RL)通过直接优化获取图像质量、美学和指令跟随能力的奖励,改进了扩散模型的引导图像生成。然而,由此产生的生成策略继承了扩散模型的迭代采样过程,导致生成速度缓慢。

为了克服这一局限性,一致性模型提出学习一类新的生成模型,直接将噪声映射到数据,从而产生一种只需一次采样迭代就能生成图像的模型。

在这项工作中,为了优化文本到图像生成模型从而获得特定任务奖励,并实现快速训练和推理,来自康奈尔大学的研究团队提出了一种通过 RL 对一致性模型进行微调的框架——RLCM,其将一致性模型的迭代推理过程构建为一个 RL 过程。RLCM 在文本到图像生成能力方面改进了 RL 微调扩散模型,并在推理过程中以计算量换取样本质量。

实验表明,RLCM 可以调整文本到图像的一致性模型,从而适应那些难以通过提示来表达的目标(如图像压缩性)和那些来自人类反馈的目标(如审美质量)。与 RL 微调扩散模型相比,RLCM 的训练速度明显更快,提高了在奖励目标下测量的生成质量,并加快了推理过程,只需两个推理步骤就能生成高质量图像。

论文链接:

https://arxiv.org/abs/2404.03673

项目地址:

https://rlcm.owenoertell.com/