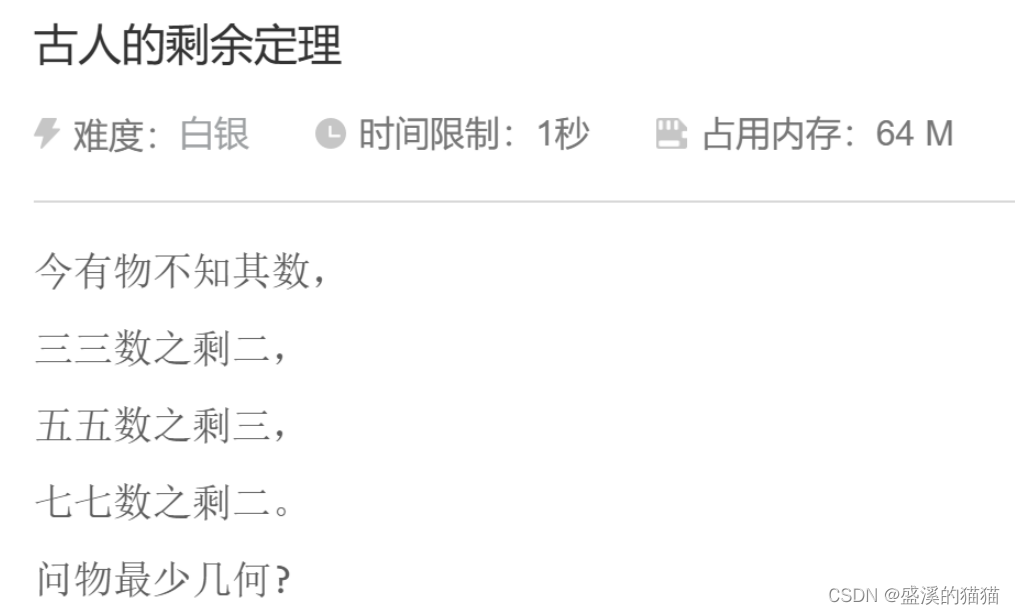

古人的剩余定理

难度:白银

©时间限制:1秒

巴占用内存:64M

今有物不知其数,

三三数之剩二,

五五数之剩三,

七七数之剩二。

问物最少几何?

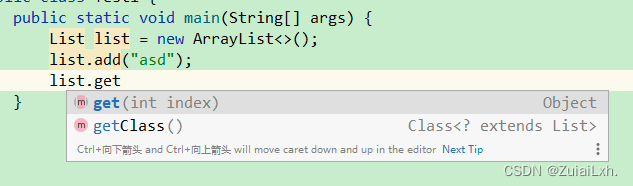

#include <bits/stdc++.h>

using namespace std;

int main(){

for(int i=1;i<=1000;i++){

if(i%3 == 2 && i%5 == 3&& i%7==2)

{

cout << i;

break;

}

}

return 0;

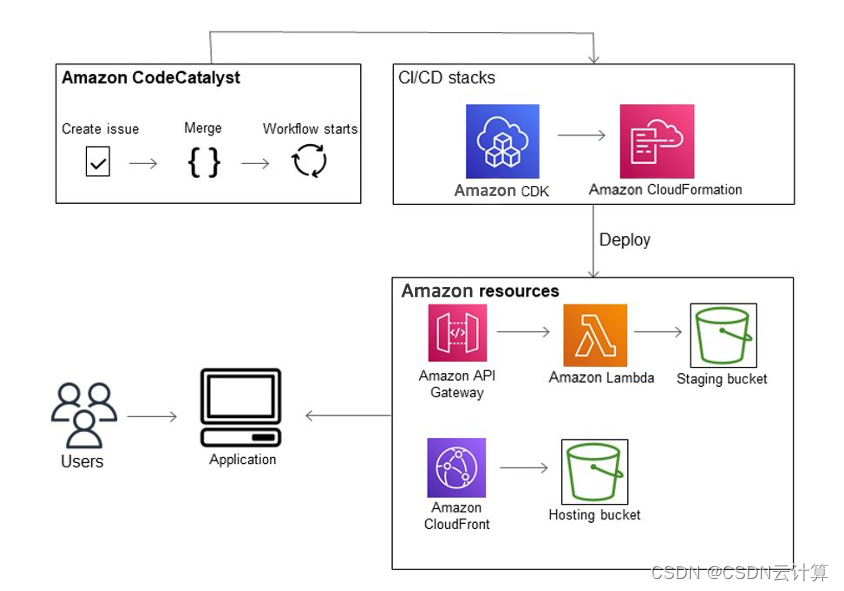

}已知在3.1得到了新闻内容、以及用户的偏好表示,在3.2我们构建出了新闻的传播图:其中根节点v1表示新闻片段,其他节点{v2,…,vn}表示共享根新闻的用户。所以在这部分将对应的新闻内容、用户的偏好表示作为节点的特征向量,使传播图融合用户及新闻的信息。经络两层图卷积层后在经过readout函数,readout函数对所有节点嵌入进行平均池操作,得到图嵌入(即User Engagement Embedding)。

其次,由于新闻内容通常包含了关于新闻可信度的更明确信号,所以我们将新闻文本嵌入和用户参与嵌入串联起来作为最终的新闻嵌入,来丰富新闻嵌入信息(实际上就是加大了文本嵌入的所占权重)

4、实验

4.1、各模型的实验结果

先上结果,其测试了两种情况:(1)只利用新闻文本嵌入 (2)新闻文本嵌入+用户参与嵌入

当只利用新闻文本嵌入时,测试了四种文本编码器。通过在两个数据集上的结果可观察到word2vec和bert的平均效果更好。实际上由于bert可以利用上下文的语义信息应该比word2vec(未利用上下文,只是简单的字典对照来获得向量表示)表现更好,而此处的结果却是word2vec表现更好,令人困惑。

利用新闻文本嵌入+用户参与嵌入时,控制得到新闻文本嵌入的编码器为bert(后面会解释为什么使用bert),对得到图嵌入的部分测试了三种模型,其介绍如上(ps. UPFD为该论文提出的模型)。建议在原论文的链接处找到提出这两个模型的原论文加深理解。对比个模型的结果见上图小字部分。

4.2、消融实验

(1)改变图神经网络的结构,并测试各种节点特征的表现情况。对比Profile和word2vec两行可得出使用用户偏好作为节点特征比使用用户资料信息表现更好,对比word2vec、bert两行可得到使用bert作为文本编码器的效果更好。

(2)改变UPFD的框架,并在两个数据集上进行测试如下:

5、结论

使用用户的历史帖子作为偏好表示,并将其作为图神经网络的节点特征可提高假新闻的检测效果。

————————————————

版权声明:本文为CSDN博主「Nefu_lyh」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_46126258/article/details/119727609