1. BabyAGI概览

babyAGI是一个AI驱动的任务管理系统,其中babyagi.py脚本中定义了整个的流程,使用OpenAI的NLP能力根据目标创建新的任务,使用Chroma和Weaviate作为上下文存储和获取任务结果。

babyAGI实际上是一个死循环,它执行以下几步

- 从任务列表中获取第一个任务

- 将任务发送给agent,agent使用 OpenAI 的 API 根据上下文完成任务

- 将生成的结果存在向量数据库chroma或weaviate中

- 创建新任务,并根据上一个任务的目标和结果重新确定任务列表的优先级

execution_agent()使用了OpenAI提供的API,他有两个参数:

- 目标

- 任务

它通过OpenAI的API发送一个Prompt,Prompt包含了任务的描述、目标和任务本身,结果会以字符串形式的反馈。

task_creation_agent()函数使用OpenAI API创建基于目标和之前任务结果的新任务。这个函数有四个参数:

- 目标

- 之前任务的结果

- 任务的描述

- 当前任务列表

它返回一个新任务的列表,并将新任务处理成一个字典,每个字典包含任务名称

prioritization_agent()函数只有一个参数,当前任务的id,它向OpenAI API发送提示词,返回一个编号的重新确定优先级的任务列表。

最后,使用Chroma/Weaviate向量数据库来存储和检索上下文任务结果。脚本根据TABLE_NAME变量中指定的表名创建一个Chroma/Weaviate集合。然后使用Chroma/Weaviate将任务结果存储到集合中,同时包括任务名称和任何额外的元数据。

2. BabyAGI源码解读

babyagi的程序主体放在babyagi.py文件中,大概600行左右的程序。

主要用的依赖有

- chromadb

- tiktoken

- openai

- llama-cpp-python 主要用来运行llama模型

1. 参数获取

代码首先是一些从环境变量中获取的参数,需要配置的参数有

- OPENAI_API_MODEL或LLM_MODEL 使用的openai的模型名称

- OPENAI_API_KEY openai的api key,后续我们可以进行造,以支持其他模型接口

- RESULTS_STORE_NAME 结果存放的名称

- INSTANCE_NAME 实体名称,也就是你的角色名

- OBJECTIVE 目标

- INITIAL_TASK或FIRST_TASK 初始任务或第一个任务

- OPENAI_TEMPERATURE openai的temperature

- COOPERATIVE_MODE 协作方式,alone、local以及distribute

- JOIN_EXISTING_OBJECTIVE 是否加入已经存在的目标

client = chromadb.Client(Settings(anonymized_telemetry=False))

# Engine configuration

# Model: GPT, LLAMA, HUMAN, etc.

LLM_MODEL = os.getenv("LLM_MODEL", os.getenv("OPENAI_API_MODEL", "gpt-3.5-turbo")).lower()

# API Keys

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY", "")

if not (LLM_MODEL.startswith("llama") or LLM_MODEL.startswith("human")):

assert OPENAI_API_KEY, "\033[91m\033[1m" + "OPENAI_API_KEY environment variable is missing from .env" + "\033[0m\033[0m"

# Table config

RESULTS_STORE_NAME = os.getenv("RESULTS_STORE_NAME", os.getenv("TABLE_NAME", ""))

assert RESULTS_STORE_NAME, "\033[91m\033[1m" + "RESULTS_STORE_NAME environment variable is missing from .env" + "\033[0m\033[0m"

# Run configuration

INSTANCE_NAME = os.getenv("INSTANCE_NAME", os.getenv("BABY_NAME", "BabyAGI"))

COOPERATIVE_MODE = "none"

JOIN_EXISTING_OBJECTIVE = False

# Goal configuration

OBJECTIVE = os.getenv("OBJECTIVE", "")

INITIAL_TASK = os.getenv("INITIAL_TASK", os.getenv("FIRST_TASK", ""))

# Model configuration

OPENAI_TEMPERATURE = float(os.getenv("OPENAI_TEMPERATURE", 0.0))

dotenv现在使用的越来越多了,也可能和12-factor有关。

2. 扩展配置

这一段主要的功能是,为babyagi加载扩展功能,其使用importlib实现了热加载的行为

其配置项有

- DOTENV_EXTENSIONS 配置要加载的额外项,多个使用逗号分隔

- ENABLE_COMMAND_LINE_ARGS 启用命令行参数传入

# Extensions support begin

def can_import(module_name):

try:

importlib.import_module(module_name)

return True

except ImportError:

return False

DOTENV_EXTENSIONS = os.getenv("DOTENV_EXTENSIONS", "").split(" ")

# Command line arguments extension

# Can override any of the above environment variables

ENABLE_COMMAND_LINE_ARGS = (

os.getenv("ENABLE_COMMAND_LINE_ARGS", "false").lower() == "true"

)

if ENABLE_COMMAND_LINE_ARGS:

if can_import("extensions.argparseext"):

from extensions.argparseext import parse_arguments

OBJECTIVE, INITIAL_TASK, LLM_MODEL, DOTENV_EXTENSIONS, INSTANCE_NAME, COOPERATIVE_MODE, JOIN_EXISTING_OBJECTIVE = parse_arguments()

# Human mode extension

# Gives human input to babyagi

if LLM_MODEL.startswith("human"):

if can_import("extensions.human_mode"):

from extensions.human_mode import user_input_await

# Load additional environment variables for enabled extensions

# TODO: This might override the following command line arguments as well:

# OBJECTIVE, INITIAL_TASK, LLM_MODEL, INSTANCE_NAME, COOPERATIVE_MODE, JOIN_EXISTING_OBJECTIVE

if DOTENV_EXTENSIONS:

if can_import("extensions.dotenvext"):

from extensions.dotenvext import load_dotenv_extensions

load_dotenv_extensions(DOTENV_EXTENSIONS)

# TODO: There's still work to be done here to enable people to get

# defaults from dotenv extensions, but also provide command line

# arguments to override them

# Extensions support end

3.打印配置

print("\033[95m\033[1m" + "\n*****CONFIGURATION*****\n" + "\033[0m\033[0m")

print(f"Name : {INSTANCE_NAME}")

print(f"Mode : {'alone' if COOPERATIVE_MODE in ['n', 'none'] else 'local' if COOPERATIVE_MODE in ['l', 'local'] else 'distributed' if COOPERATIVE_MODE in ['d', 'distributed'] else 'undefined'}")

print(f"LLM : {LLM_MODEL}")

4. 检查配置项

- 检查了目标

OBJECTIVE和初始任务INITIAL_TASK是否填写。 - 配置的llama_cpp的模型和embedding

LLAMA_MODEL_PATH设定llama模型名称、LLAMA_THREADS_NUM设定llama占用的CPU核心数

- 配置openai模型的参数

这里值得注意的是,JOIN_EXISTING_OBJECTIVE参数,当设置了初始任务INITIAL_TASK时,改值必须为true。

# Check if we know what we are doing

assert OBJECTIVE, "\033[91m\033[1m" + "OBJECTIVE environment variable is missing from .env" + "\033[0m\033[0m"

assert INITIAL_TASK, "\033[91m\033[1m" + "INITIAL_TASK environment variable is missing from .env" + "\033[0m\033[0m"

LLAMA_MODEL_PATH = os.getenv("LLAMA_MODEL_PATH", "models/llama-13B/ggml-model.bin")

if LLM_MODEL.startswith("llama"):

if can_import("llama_cpp"):

from llama_cpp import Llama

print(f"LLAMA : {LLAMA_MODEL_PATH}" + "\n")

assert os.path.exists(LLAMA_MODEL_PATH), "\033[91m\033[1m" + f"Model can't be found." + "\033[0m\033[0m"

CTX_MAX = 1024

LLAMA_THREADS_NUM = int(os.getenv("LLAMA_THREADS_NUM", 8))

print('Initialize model for evaluation')

llm = Llama(

model_path=LLAMA_MODEL_PATH,

n_ctx=CTX_MAX,

n_threads=LLAMA_THREADS_NUM,

n_batch=512,

use_mlock=False,

)

print('\nInitialize model for embedding')

llm_embed = Llama(

model_path=LLAMA_MODEL_PATH,

n_ctx=CTX_MAX,

n_threads=LLAMA_THREADS_NUM,

n_batch=512,

embedding=True,

use_mlock=False,

)

print(

"\033[91m\033[1m"

+ "\n*****USING LLAMA.CPP. POTENTIALLY SLOW.*****"

+ "\033[0m\033[0m"

)

else:

print(

"\033[91m\033[1m"

+ "\nLlama LLM requires package llama-cpp. Falling back to GPT-3.5-turbo."

+ "\033[0m\033[0m"

)

LLM_MODEL = "gpt-3.5-turbo"

if LLM_MODEL.startswith("gpt-4"):

print(

"\033[91m\033[1m"

+ "\n*****USING GPT-4. POTENTIALLY EXPENSIVE. MONITOR YOUR COSTS*****"

+ "\033[0m\033[0m"

)

if LLM_MODEL.startswith("human"):

print(

"\033[91m\033[1m"

+ "\n*****USING HUMAN INPUT*****"

+ "\033[0m\033[0m"

)

print("\033[94m\033[1m" + "\n*****OBJECTIVE*****\n" + "\033[0m\033[0m")

print(f"{OBJECTIVE}")

if not JOIN_EXISTING_OBJECTIVE:

print("\033[93m\033[1m" + "\nInitial task:" + "\033[0m\033[0m" + f" {INITIAL_TASK}")

else:

print("\033[93m\033[1m" + f"\nJoining to help the objective" + "\033[0m\033[0m")

# Configure OpenAI

openai.api_key = OPENAI_API_KEY

# Llama embedding function

class LlamaEmbeddingFunction(EmbeddingFunction):

def __init__(self):

return

def __call__(self, texts: Documents) -> Embeddings:

embeddings = []

for t in texts:

e = llm_embed.embed(t)

embeddings.append(e)

return embeddings

5.向量存储初始化代码

向量数据库这里除了使用chromadb外,还使用了weaviate和pinecone,也都是通过环境变量进行配置的,并且可以通过插件的形式进行加载。

这里值得注意的是,chroma用到的metadata,不管是在collection中添加任务名称等信息,而且在创建collection时,使用的metadata。

创建collection时,使用的hnsw:space数据,来自定义嵌入空间的距离方法。

目前可用的参数有:

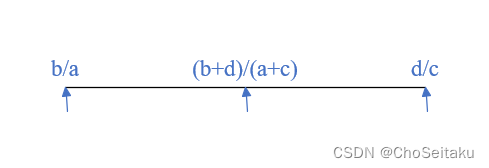

- l2(Squared L2) d = ∑ ( A i − B i ) 2 d = \sum\left(A_i-B_i\right)^2 d=∑(Ai−Bi)2

- ip(Inner product) d = 1.0 − ∑ ( A i × B i ) d = 1.0 - \sum\left(A_i \times B_i\right) d=1.0−∑(Ai×Bi)

- cosine(Cosine similarity) d = 1.0 − ∑ ( A i × B i ) ∑ ( A i 2 ) ⋅ ∑ ( B i 2 ) d = 1.0 - \frac{\sum\left(A_i \times B_i\right)}{\sqrt{\sum\left(A_i^2\right)} \cdot \sqrt{\sum\left(B_i^2\right)}} d=1.0−∑(Ai2)⋅∑(Bi2)∑(Ai×Bi)

babyAGI使用的cosine参数,即余弦相似度,它衡量的是两个向量在方向上的相似程度,而与它们的长度无关,优点是对向量的长度不敏感,因此可以有效地处理不同规模的数据集。同时,它对异常值的影响较小,且可以很好地处理高维空间中的数据。

Squared L2的优点是它的计算简单,而且当数据点分布在高维空间时,它可以有效地避免计算平方根的运算,从而提高计算效率。缺点是它对异常值比较敏感,并且随着维度的增加,不同维度的尺度可能会对结果产生较大影响。

Inner product(内积)内积常用于计算向量之间的相似度,内积的值越大,表示两个向量越相似。当内积为正时,表示两个向量的方向大致相同;当内积为负时,表示两个向量的方向大致相反。内积不直接提供距离信息,但可以通过其他方法(如相关系数)转换为相似度度量。

# Results storage using local ChromaDB

class DefaultResultsStorage:

def __init__(self):

logging.getLogger('chromadb').setLevel(logging.ERROR)

# Create Chroma collection

chroma_persist_dir = "chroma"

chroma_client = chromadb.PersistentClient(

settings=chromadb.config.Settings(

persist_directory=chroma_persist_dir,

)

)

metric = "cosine"

if LLM_MODEL.startswith("llama"):

embedding_function = LlamaEmbeddingFunction()

else:

embedding_function = OpenAIEmbeddingFunction(api_key=OPENAI_API_KEY)

self.collection = chroma_client.get_or_create_collection(

name=RESULTS_STORE_NAME,

metadata={"hnsw:space": metric},

embedding_function=embedding_function,

)

def add(self, task: Dict, result: str, result_id: str):

# Break the function if LLM_MODEL starts with "human" (case-insensitive)

if LLM_MODEL.startswith("human"):

return

# Continue with the rest of the function

embeddings = llm_embed.embed(result) if LLM_MODEL.startswith("llama") else None

if (

len(self.collection.get(ids=[result_id], include=[])["ids"]) > 0

): # Check if the result already exists

self.collection.update(

ids=result_id,

embeddings=embeddings,

documents=result,

metadatas={"task": task["task_name"], "result": result},

)

else:

self.collection.add(

ids=result_id,

embeddings=embeddings,

documents=result,

metadatas={"task": task["task_name"], "result": result},

)

def query(self, query: str, top_results_num: int) -> List[dict]:

count: int = self.collection.count()

if count == 0:

return []

results = self.collection.query(

query_texts=query,

n_results=min(top_results_num, count),

include=["metadatas"]

)

return [item["task"] for item in results["metadatas"][0]]

# Initialize results storage

def try_weaviate():

WEAVIATE_URL = os.getenv("WEAVIATE_URL", "")

WEAVIATE_USE_EMBEDDED = os.getenv("WEAVIATE_USE_EMBEDDED", "False").lower() == "true"

if (WEAVIATE_URL or WEAVIATE_USE_EMBEDDED) and can_import("extensions.weaviate_storage"):

WEAVIATE_API_KEY = os.getenv("WEAVIATE_API_KEY", "")

from extensions.weaviate_storage import WeaviateResultsStorage

print("\nUsing results storage: " + "\033[93m\033[1m" + "Weaviate" + "\033[0m\033[0m")

return WeaviateResultsStorage(OPENAI_API_KEY, WEAVIATE_URL, WEAVIATE_API_KEY, WEAVIATE_USE_EMBEDDED, LLM_MODEL, LLAMA_MODEL_PATH, RESULTS_STORE_NAME, OBJECTIVE)

return None

def try_pinecone():

PINECONE_API_KEY = os.getenv("PINECONE_API_KEY", "")

if PINECONE_API_KEY and can_import("extensions.pinecone_storage"):

PINECONE_ENVIRONMENT = os.getenv("PINECONE_ENVIRONMENT", "")

assert (

PINECONE_ENVIRONMENT

), "\033[91m\033[1m" + "PINECONE_ENVIRONMENT environment variable is missing from .env" + "\033[0m\033[0m"

from extensions.pinecone_storage import PineconeResultsStorage

print("\nUsing results storage: " + "\033[93m\033[1m" + "Pinecone" + "\033[0m\033[0m")

return PineconeResultsStorage(OPENAI_API_KEY, PINECONE_API_KEY, PINECONE_ENVIRONMENT, LLM_MODEL, LLAMA_MODEL_PATH, RESULTS_STORE_NAME, OBJECTIVE)

return None

def use_chroma():

print("\nUsing results storage: " + "\033[93m\033[1m" + "Chroma (Default)" + "\033[0m\033[0m")

return DefaultResultsStorage()

results_storage = try_weaviate() or try_pinecone() or use_chroma()

这里我们还是使用chromadb,其余的两个数据库均为线上服务,需要花钱。

6. 任务列表创建

这段代码主要是建立了任务清单的模型类,判断是否为local或distributed任务,这里主要是使用了python ray分布式多进程框架来处里。

这个后续会在babyAGI的扩展部分讲解。

# Task storage supporting only a single instance of BabyAGI

class SingleTaskListStorage:

def __init__(self):

self.tasks = deque([])

self.task_id_counter = 0

def append(self, task: Dict):

self.tasks.append(task)

def replace(self, tasks: List[Dict]):

self.tasks = deque(tasks)

def popleft(self):

return self.tasks.popleft()

def is_empty(self):

return False if self.tasks else True

def next_task_id(self):

self.task_id_counter += 1

return self.task_id_counter

def get_task_names(self):

return [t["task_name"] for t in self.tasks]

# Initialize tasks storage

tasks_storage = SingleTaskListStorage()

if COOPERATIVE_MODE in ['l', 'local']:

if can_import("extensions.ray_tasks"):

import sys

from pathlib import Path

sys.path.append(str(Path(__file__).resolve().parent))

from extensions.ray_tasks import CooperativeTaskListStorage

tasks_storage = CooperativeTaskListStorage(OBJECTIVE)

print("\nReplacing tasks storage: " + "\033[93m\033[1m" + "Ray" + "\033[0m\033[0m")

elif COOPERATIVE_MODE in ['d', 'distributed']:

pass

7.计算token以及封装OpenAI API

这一段是封装的openai的请求,这里面需要注意的是,与OpenAI交互时使用的System角色

这里有关于角色的几点说明

- system 指定模型回答问题的方式。经典例子:“你是一个程序员“

- user 等同于用户进行提问

- assistant 模型的响应(基于用户消息)

def limit_tokens_from_string(string: str, model: str, limit: int) -> str:

"""Limits the string to a number of tokens (estimated)."""

try:

encoding = tiktoken.encoding_for_model(model)

except:

encoding = tiktoken.encoding_for_model('gpt2') # Fallback for others.

encoded = encoding.encode(string)

return encoding.decode(encoded[:limit])

def openai_call(

prompt: str,

model: str = LLM_MODEL,

temperature: float = OPENAI_TEMPERATURE,

max_tokens: int = 100,

):

while True:

try:

if model.lower().startswith("llama"):

result = llm(prompt[:CTX_MAX],

stop=["### Human"],

echo=False,

temperature=0.2,

top_k=40,

top_p=0.95,

repeat_penalty=1.05,

max_tokens=200)

# print('\n*****RESULT JSON DUMP*****\n')

# print(json.dumps(result))

# print('\n')

return result['choices'][0]['text'].strip()

elif model.lower().startswith("human"):

return user_input_await(prompt)

elif not model.lower().startswith("gpt-"):

# Use completion API

response = openai.Completion.create(

engine=model,

prompt=prompt,

temperature=temperature,

max_tokens=max_tokens,

top_p=1,

frequency_penalty=0,

presence_penalty=0,

)

return response.choices[0].text.strip()

else:

# Use 4000 instead of the real limit (4097) to give a bit of wiggle room for the encoding of roles.

# TODO: different limits for different models.

trimmed_prompt = limit_tokens_from_string(prompt, model, 4000 - max_tokens)

# Use chat completion API

messages = [{"role": "system", "content": trimmed_prompt}]

response = openai.ChatCompletion.create(

model=model,

messages=messages,

temperature=temperature,

max_tokens=max_tokens,

n=1,

stop=None,

)

return response.choices[0].message.content.strip()

except openai.error.RateLimitError:

print(

" *** The OpenAI API rate limit has been exceeded. Waiting 10 seconds and trying again. ***"

)

time.sleep(10) # Wait 10 seconds and try again

except openai.error.Timeout:

print(

" *** OpenAI API timeout occurred. Waiting 10 seconds and trying again. ***"

)

time.sleep(10) # Wait 10 seconds and try again

except openai.error.APIError:

print(

" *** OpenAI API error occurred. Waiting 10 seconds and trying again. ***"

)

time.sleep(10) # Wait 10 seconds and try again

except openai.error.APIConnectionError:

print(

" *** OpenAI API connection error occurred. Check your network settings, proxy configuration, SSL certificates, or firewall rules. Waiting 10 seconds and trying again. ***"

)

time.sleep(10) # Wait 10 seconds and try again

except openai.error.InvalidRequestError:

print(

" *** OpenAI API invalid request. Check the documentation for the specific API method you are calling and make sure you are sending valid and complete parameters. Waiting 10 seconds and trying again. ***"

)

time.sleep(10) # Wait 10 seconds and try again

except openai.error.ServiceUnavailableError:

print(

" *** OpenAI API service unavailable. Waiting 10 seconds and trying again. ***"

)

time.sleep(10) # Wait 10 seconds and try again

else:

break

这就是babyagi的配置和前期准备的代码,第二篇文章我会给大家继续展示核心部分-agents编写,这里将展示如何使用prompt完成任务的创建、优先级排序以及执行任务,包括项目的运行部分。