Transformer的前世今生 day10(Transformer编码器

news2026/2/11 11:20:22

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/1551003.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

【JavaWeb】Day24.Web入门——SPringBootWeb入门

什么是SPring?

我们可以打开Spring的官网(Spring | Home),去看一下Spring的简介:Spring makes Java simple。Spring的官方提供很多开源的项目,我们可以点击上面的projects,看到spring家族旗下的项目,按照流…

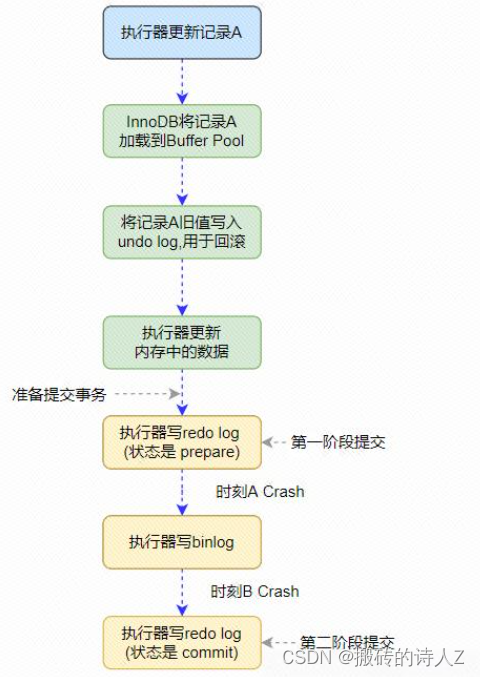

数据库是怎么做到事务回滚的呢?

数据库实现事务回滚的原理涉及到数据库管理系统(DBMS)如何维护事务的一致性和持久性。

基本原理: ACID属性:事务的原子性(Atomicity)、一致性(Consistency)、隔离性(Iso…

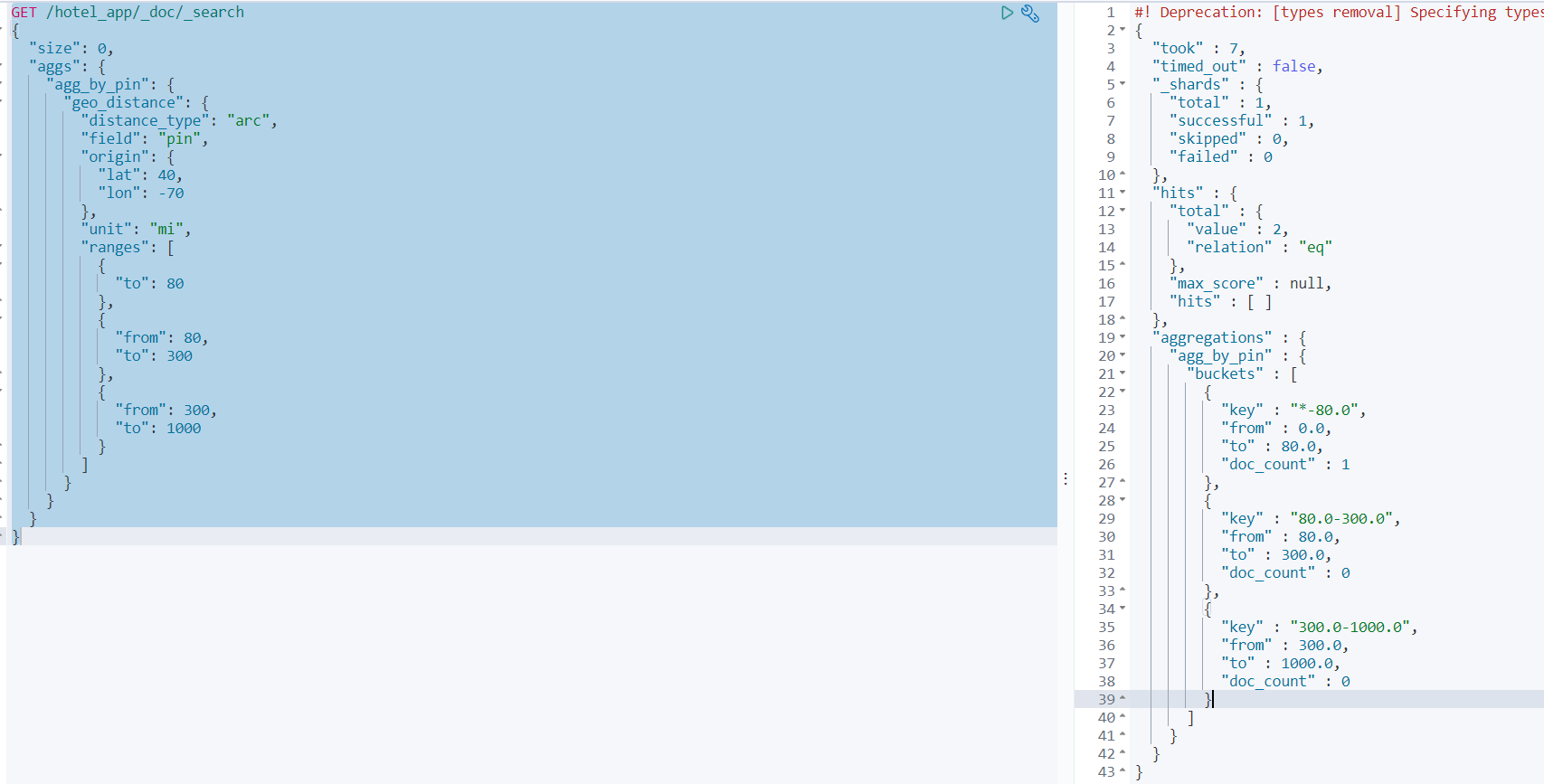

Elasticsearch从入门到精通-07ES底层原理学习

Elasticsearch从入门到精通-07ES底层原理和高级功能 👏作者简介:大家好,我是程序员行走的鱼 📖 本篇主要介绍和大家一块学习一下ES底层原理包括集群原理、路由原理、分配控制、分配原理、文档分析原理、文档并发安全原理以及一些高…

【热门话题】ECMAScript vs JavaScript:理解两者间的联系与区别

🌈个人主页: 鑫宝Code 🔥热门专栏: 闲话杂谈| 炫酷HTML | JavaScript基础 💫个人格言: "如无必要,勿增实体" 文章目录 ECMAScript vs JavaScript:理解两者间的联系与区别1. ECMAScript&am…

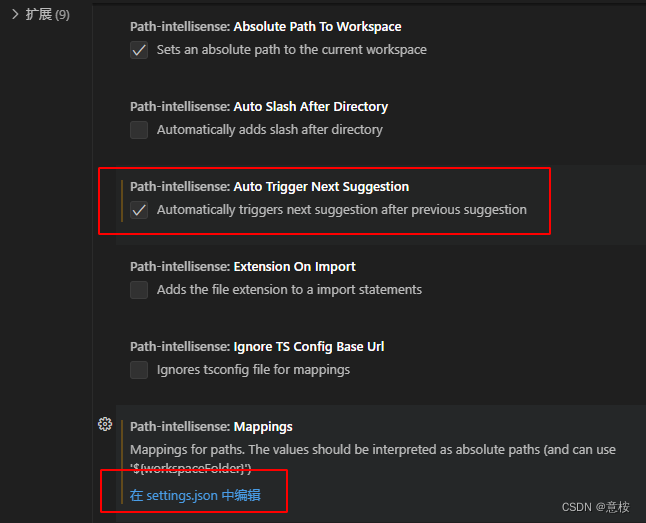

创建一个vue3 + ts + vite 项目

vite 官网: https://cn.vitejs.dev/guide/ 兼容性注意 Vite 需要 Node.js 版本 18,20。然而,有些模板需要依赖更高的 Node 版本才能正常运行,当你的包管理器发出警告时,请注意升级你的 Node 版本。 安装项目

1. 使用n…

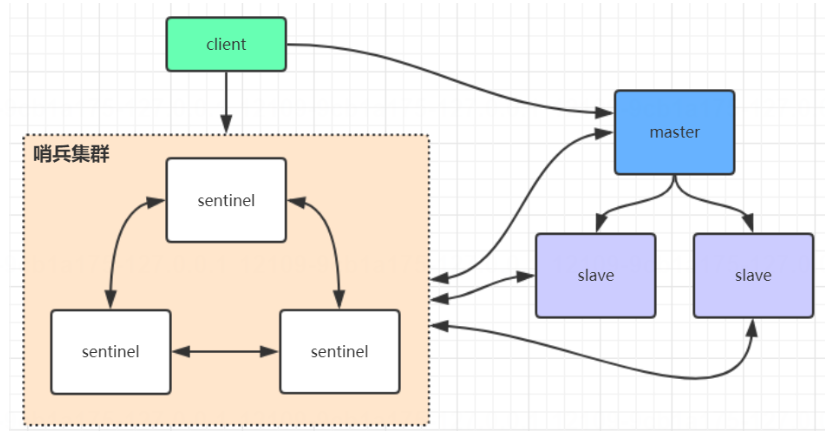

【Redis主从架构。主从工作原理psync、bgsave、部分数据复制、主从复制风暴解决方案】【Redis哨兵高可用架构。sentinel】

Redis主从架构 Redis主从工作原理数据部分复制 Redis哨兵高可用架构client连接哨兵规则主节点挂了,集群从新选择主节点,并且同步给sentinel 转自图灵课堂 redis主从架构搭建,配置从节点步骤:

1、复制一份redis.conf文件2、将相关…

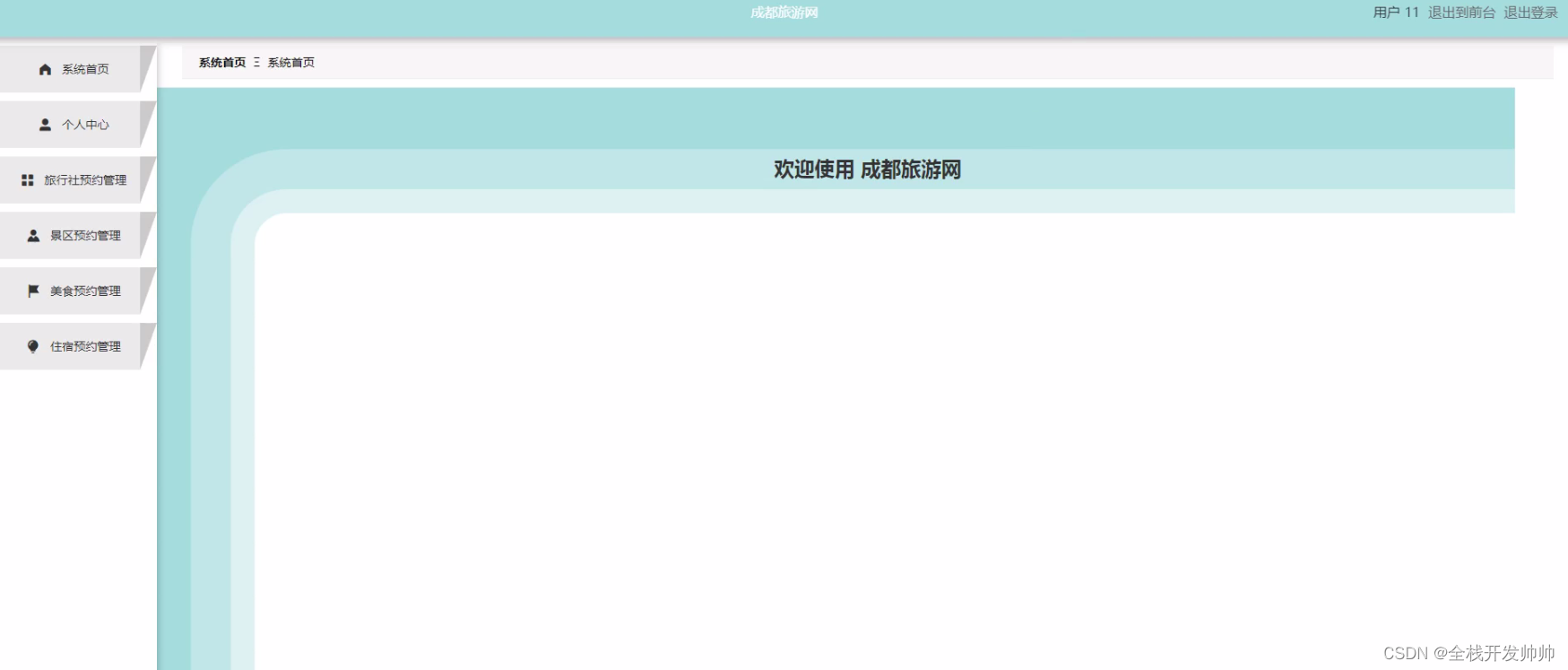

基于java+springboot+vue实现的成都旅游网系统(文末源码+Lw+ppt)23-358

摘 要

人类现已迈入二十一世纪,科学技术日新月异,经济、资讯等各方面都有了非常大的进步,尤其是资讯与网络技术的飞速发展,对政治、经济、军事、文化等各方面都有了极大的影响。

利用电脑网络的这些便利,发展一套成…

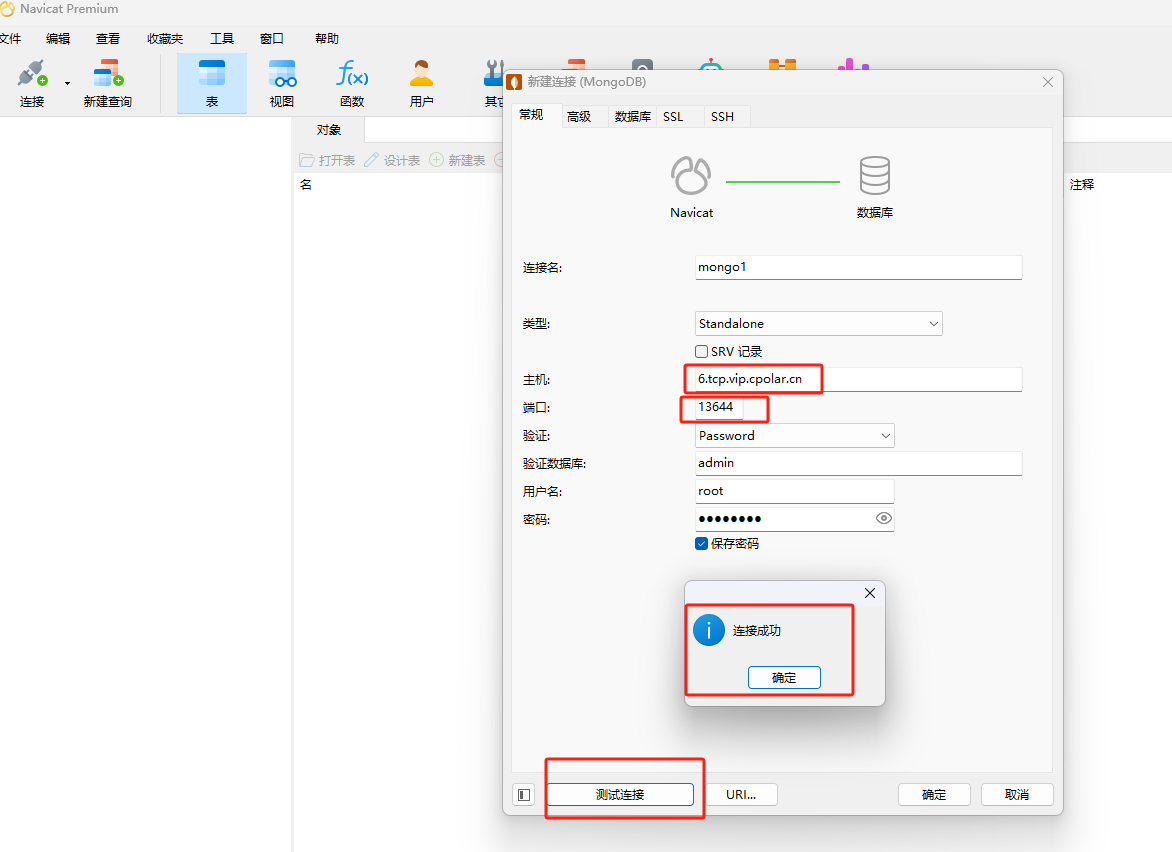

Linux系统使用Docker部署MongoDB数据库并实现无公网IP远程访问

文章目录 前言1. 安装Docker2. 使用Docker拉取MongoDB镜像3. 创建并启动MongoDB容器4. 本地连接测试5. 公网远程访问本地MongoDB容器5.1 内网穿透工具安装5.2 创建远程连接公网地址5.3 使用固定TCP地址远程访问 前言

本文主要介绍如何在Linux Ubuntu系统使用Docker快速部署Mon…

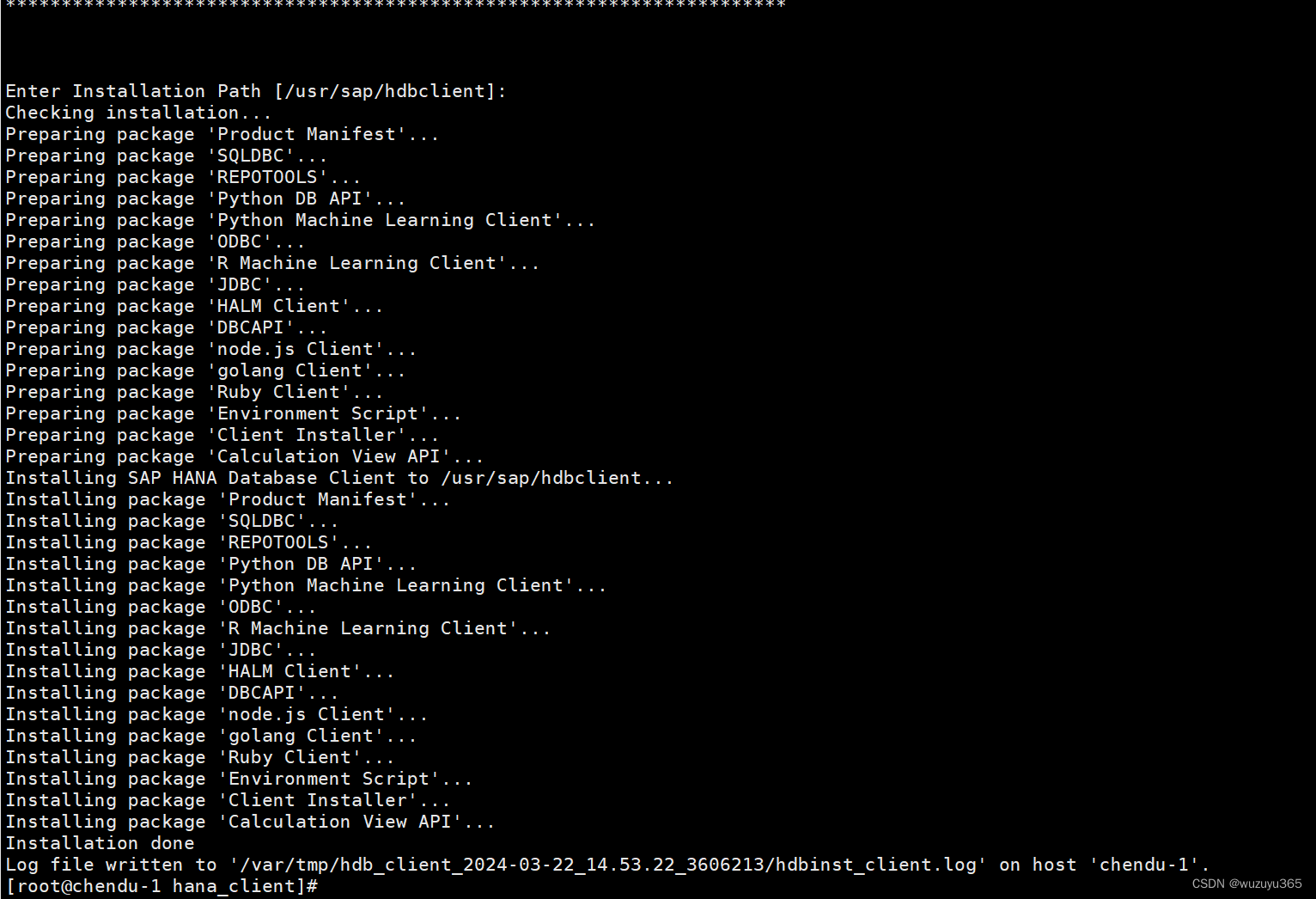

Linux Php 连接 SAP Hana数据库客户端

下载地址 : SAP Development Tools https://tools.hana.ondemand.com/#hanatools 进入hanaclient-2.19.21-linux-x64

无需编译,运行 ./hdbinst 提示没有权限,执行chmod x *

有个子目录里面的也是没有权限,进入那个子目录 执行chmod …

通过测量扭矩和转角法评估紧固件的连接质量——SunTorque智能扭矩系统

智能扭矩系统-智能拧紧系统-扭矩自动控制系统-SunTorque

扭矩转角法是一种用于测量材料力学性能和评估紧固件连接质量的重要方法。其原理基于材料在受到扭矩作用时产生的弹性变形和塑性变形,通过测量施加在紧固件上的扭矩和对应的转角关系,来推断材料的…

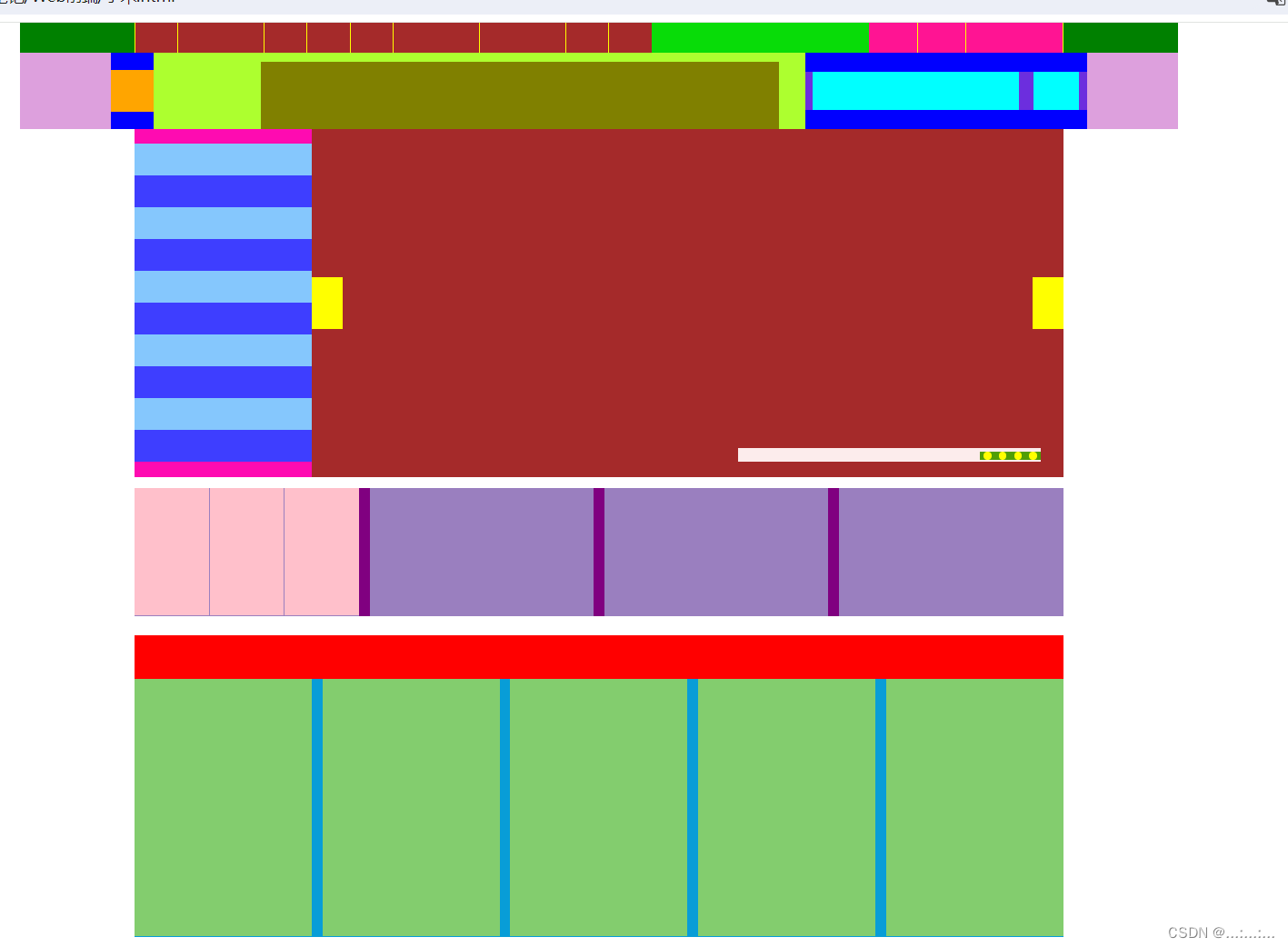

浅模仿小米商城布局(有微调)

CSS文件

*{margin: 0;padding: 0;box-sizing: border-box;

}div[class^"h"]{height: 40px;

}

div[class^"s"]{height: 100px;

}

.h1{width: 1528px;background-color: green;

}

.h11{background-color:rgb(8, 220, 8);

}

.h111{width: 683px;background-c…

PLC/FA 电机信号隔离控制模拟信号数据隔离采集变换分配器0-5V/0-10V/1-5V,0-10mA/0-20mA/4-20mA

主要特性:

>>精度等级:0.1级、0.2级。产品出厂前已检验校正,用户可以直接使用

>>辅助电源:5V/12V/15V/24VDC(范围10%)

>>国际标准一路信号输入:0-5V/0-10V/1-5V,0-10mA/0-20mA/4-20mA等

>>…

【详细讲解React 快速入门教程】

🔥博主:程序员不想YY啊🔥 💫CSDN优质创作者,CSDN实力新星,CSDN博客专家💫 🤗点赞🎈收藏⭐再看💫养成习惯 🌈希望本文对您有所裨益,如有…

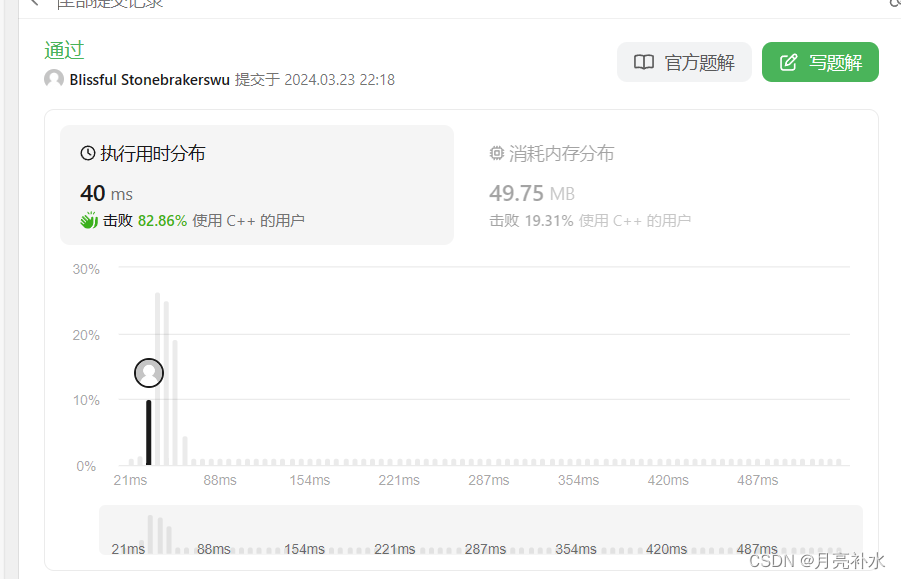

稀碎从零算法笔记Day26-LeetCode:跳跃游戏

断更多天,懒狗ex

题型:数组、模拟、类似双指针?

链接:55. 跳跃游戏 - 力扣(LeetCode)

来源:LeetCode 题目描述

给你一个非负整数数组 nums ,你最初位于数组的 第一个下标 。数组…

【算法刷题】链表笔试题解析(1)

一、链表分割

题目描述:

链接:链表分割 题目分析: 这题直接处理并不好做,我们可以构建前后两个链表,将小于x值的结点放在链表a内,将其它结点放在链表b内,这样将原链表遍历完后,原链…

FKSS型煤层注水封孔器向光而行

要保持自己喜欢的样子 不要随波逐流 也不要过度失落 温柔的人 会有一个好的结局 结构特点 封孔器是由注水喷头、固定螺母管芯、单向阀、膨胀胶管、扣压外套、扣压芯子、注水连接体组成。 水分注入煤体,能湿润和破碎煤体,释放部分瓦斯,降低煤…

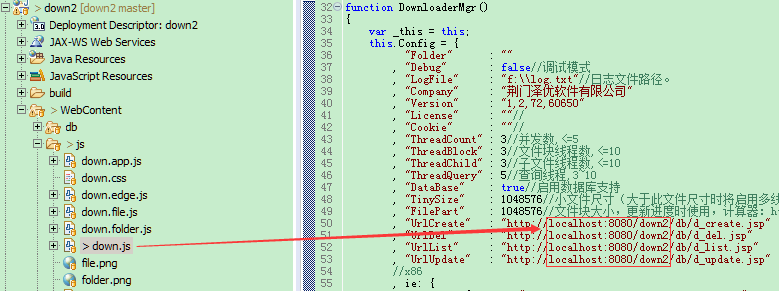

TreeMap集合 -java学习笔记

TreeMap

TreeMap (由键决定特点):按照键的大小默认升序排序、不重复、无索引特点:不重复、无索引、可排序(按照键的大小默认升序排序,只能对键排序)原理:TreeMap跟TreeSet集合的底层原理是一样的,都是基于红黑树实现的排序 TreeSetÿ…

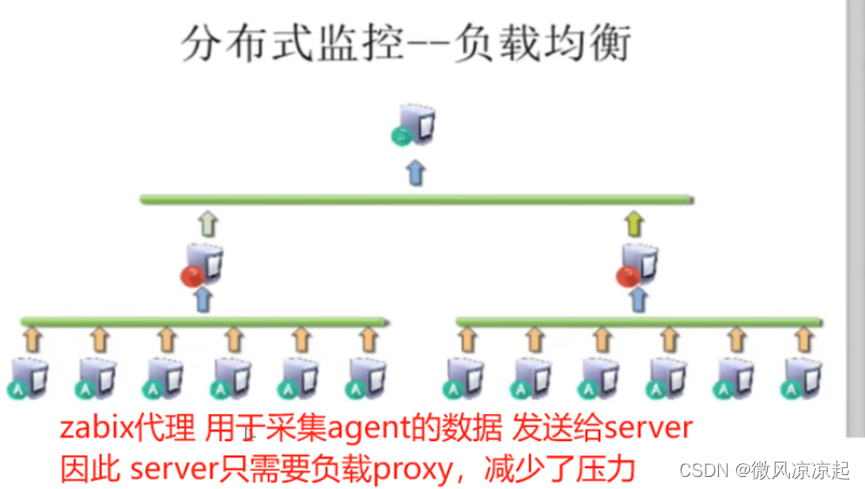

zabbix分布式部署

基于zabbix-proxy的分布式监控

1.1 分布式监控的作用 1)分担 server 的集中式压力;

2)解决多机房之间的网络延时问题。

1.2 数据流向 agent --> proxy --> server

1.3 构成组件 zabbix-server:整个监控体系中最核心的组…

Mudbox 2025新版中文---数字雕刻与纹理绘画新境界

Mudbox 2025是一款功能强大的3D建模软件,以其卓越的建模能力和高效的创作工具而备受瞩目。它支持纹理烘烤、三维层、多分辨率网格编辑等功能,为用户提供了直观且易于操作的用户界面。

Mudbox 2025新版中文下载 功能特色:

强大的建模与雕刻能…