目录

- 一. Stacking 思想

一. Stacking 思想

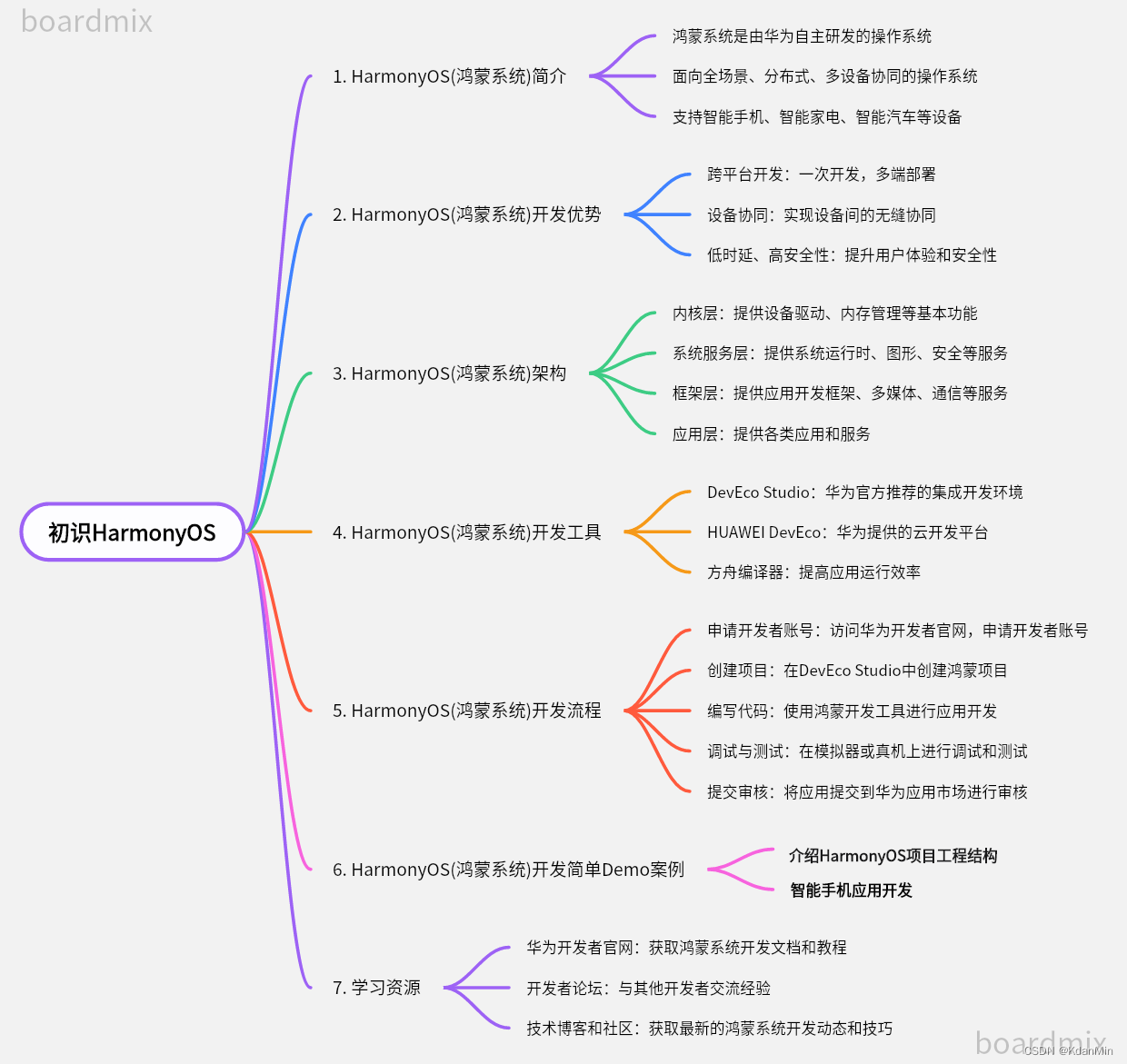

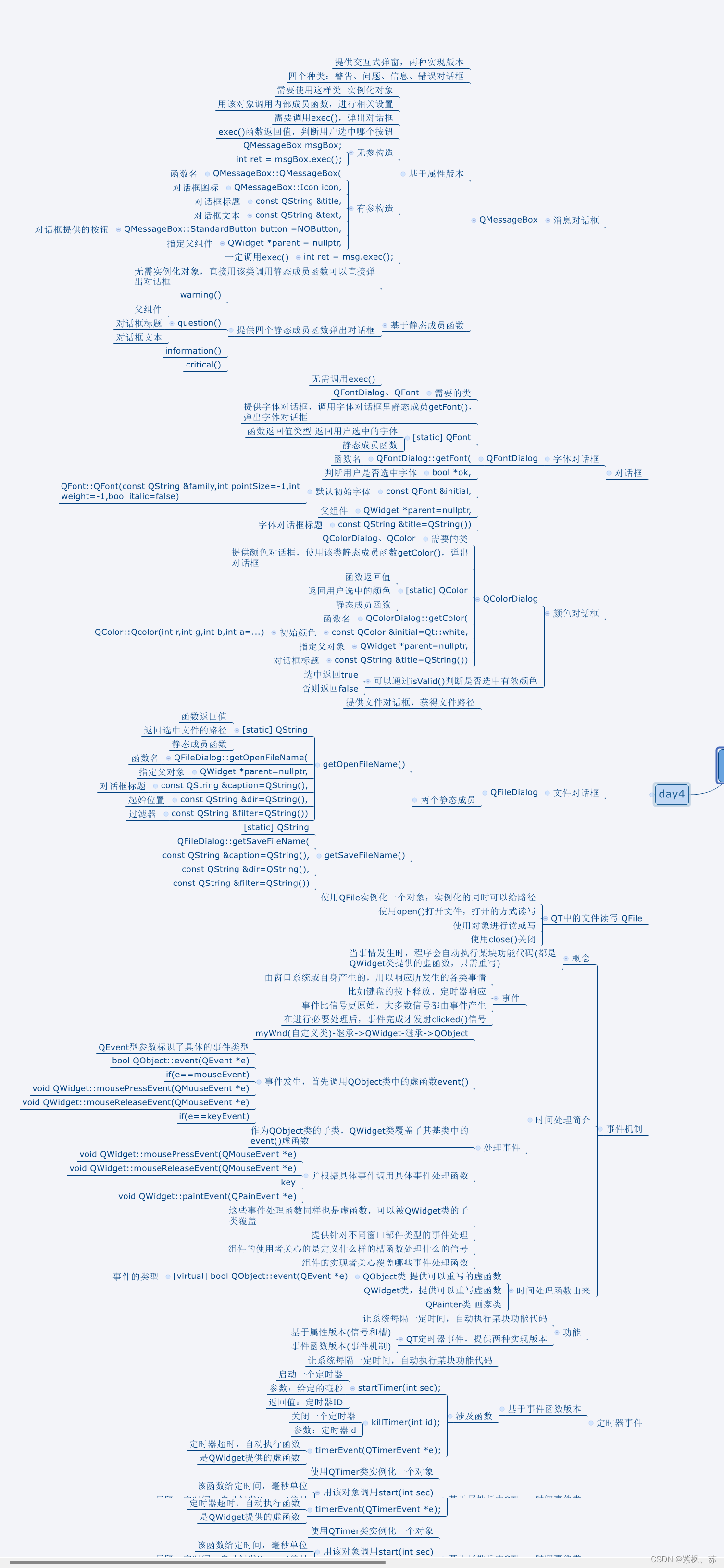

Stacking(或stacked generalization),是指训练一个模型用于组合(combine)其他各个模型

Stacking有两层

第一层是不同的基学习器(classifiers/regressors)

第二层是用于组合基学习器的元学习(meta_classifier/meta_regressor)

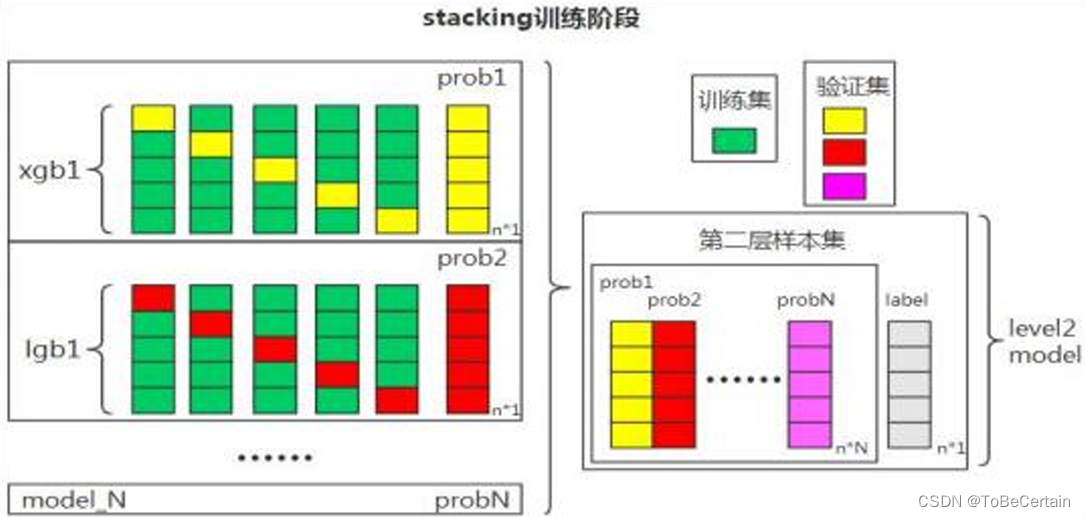

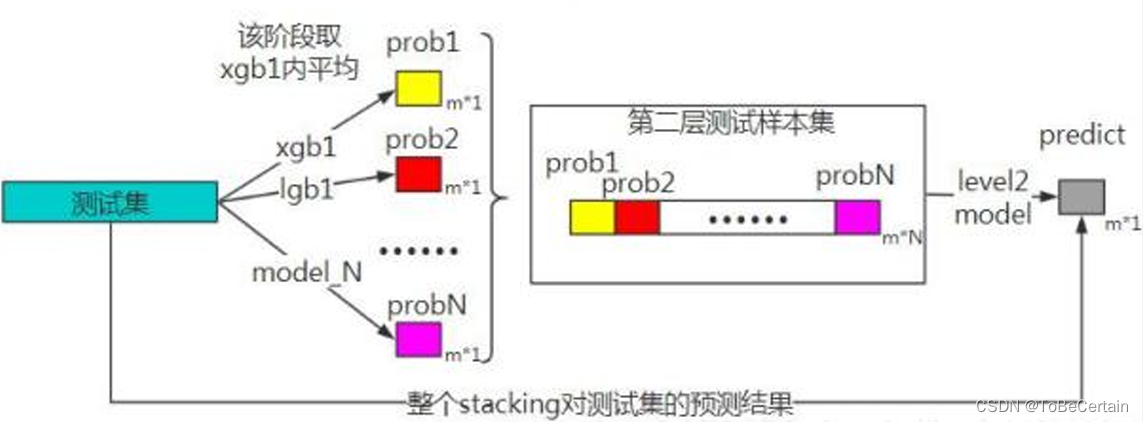

Stacking训练:

首先训练多个不同的模型,随后再以之前训练的各个模型的输出为输入来训练一个新模型,以得到一个最终的输出

理论上,Stacking可以表示前面提到的各种Ensemble方法

实际中,我们通常使用单层logistic回归(分类问题)或者 Ridge(回归问题)作为第二层模型

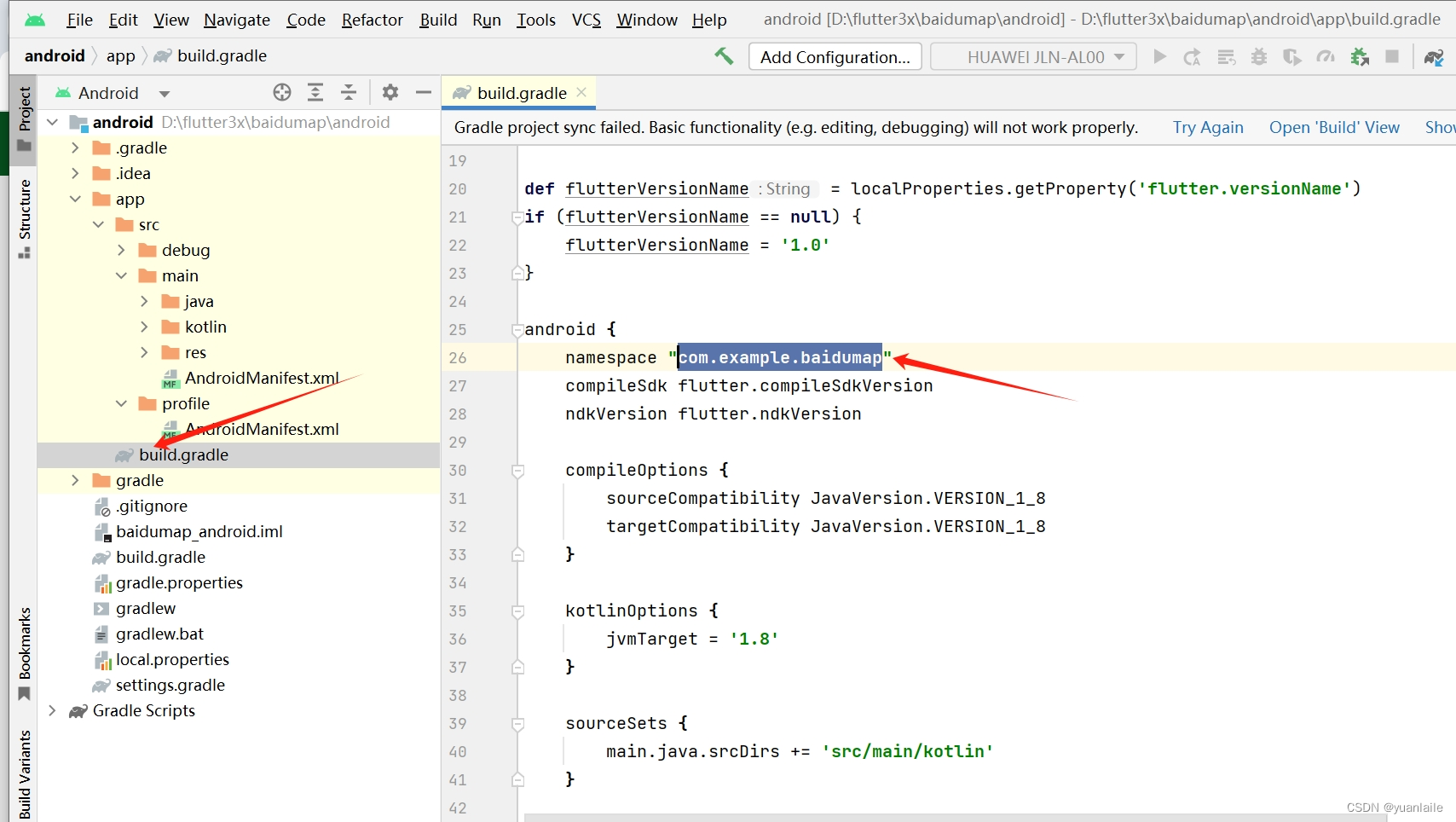

图片解释:

对数据集进行k折训练,其预测值为用来获取第二层模型的训练集当第一层训练数据为1w条时,每个基学习器相应得到1w条预测值

当基学习器有N个时,第二层样本的训练集shape为 (1w*N)

感谢阅读🌼

如果喜欢这篇文章,记得点赞👍和转发🔄哦!

有任何想法或问题,欢迎留言交流💬,我们下次见!

本文相关代码存放位置

【Stacking思想】

祝愉快🌟!