什么是Open WebUI

Open WebUI是一种可扩展、功能丰富、用户友好的大模型对话平台,旨在完全离线运行。它支持各种LLM运行程序,包括与Ollama和Openai兼容的API。

功能

- 直观的界面:我们的聊天界面灵感来自ChatGPT,确保了用户友好的体验。

- 响应式设计:在桌面和移动设备上享受无缝体验。

- 快速响应:享受快速响应的性能。

- 轻松安装:使用Docker或Kubernetes (kubectl, kustomize或helm)无缝安装,获得轻松的体验。

- 代码语法突出显示:使用我们的语法突出显示功能,享受增强的代码可读性。

- 完全Markdown和LaTeX支持:通过全面的Markdown和LaTeX功能提升您的LLM经验,以丰富交互。

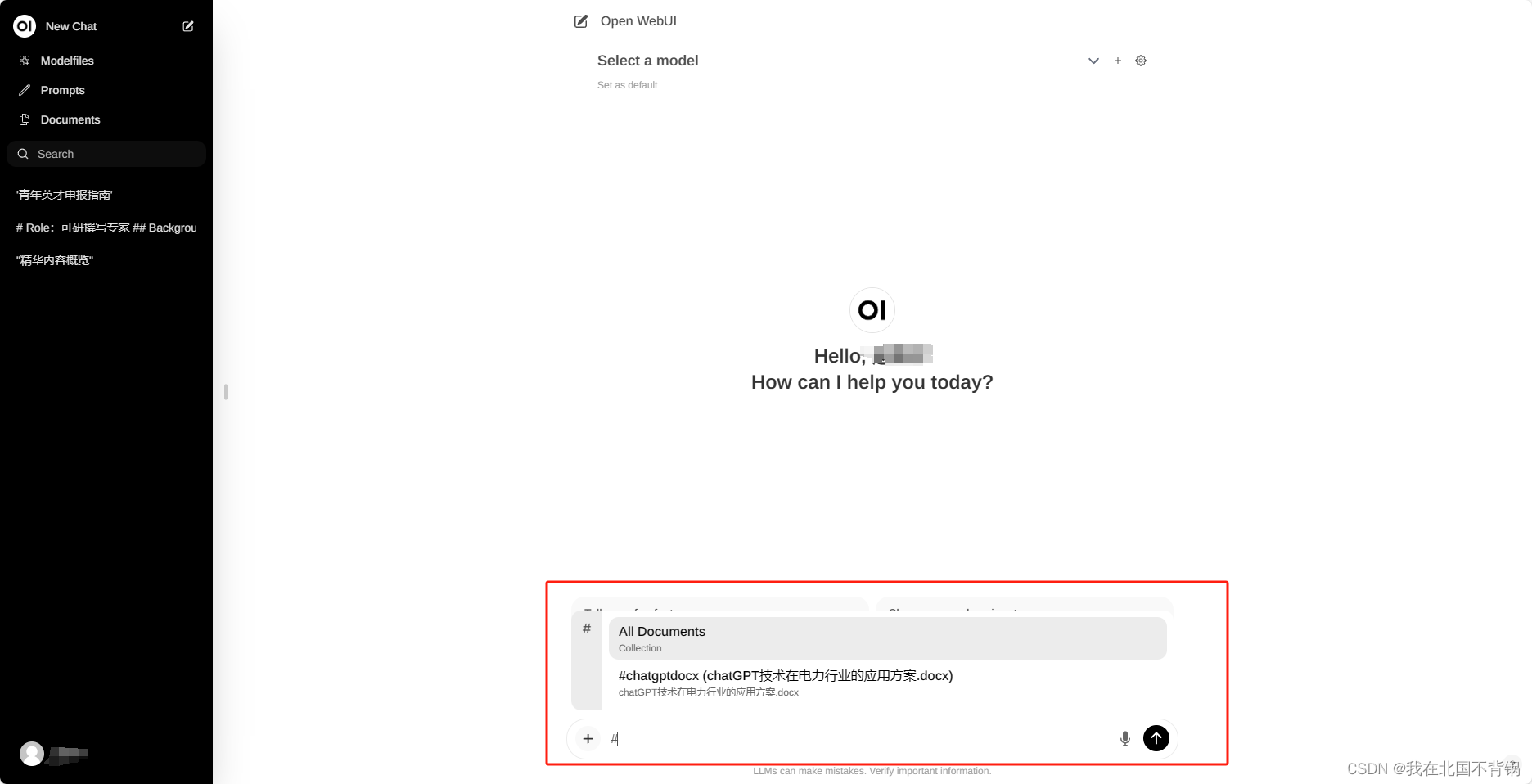

- 本地RAG集成:通过突破性的检索增强生成(RAG)支持,深入了解聊天交互的未来。此功能将文档交互无缝地集成到您的聊天体验中。您可以直接将文档加载到聊天中或将文件添加到文档库中,在提示符中使用 # 命令轻松访问它们。在alpha阶段,当我们积极改进和增强此功能以确保最佳性能和可靠性时,可能会偶尔出现问题。

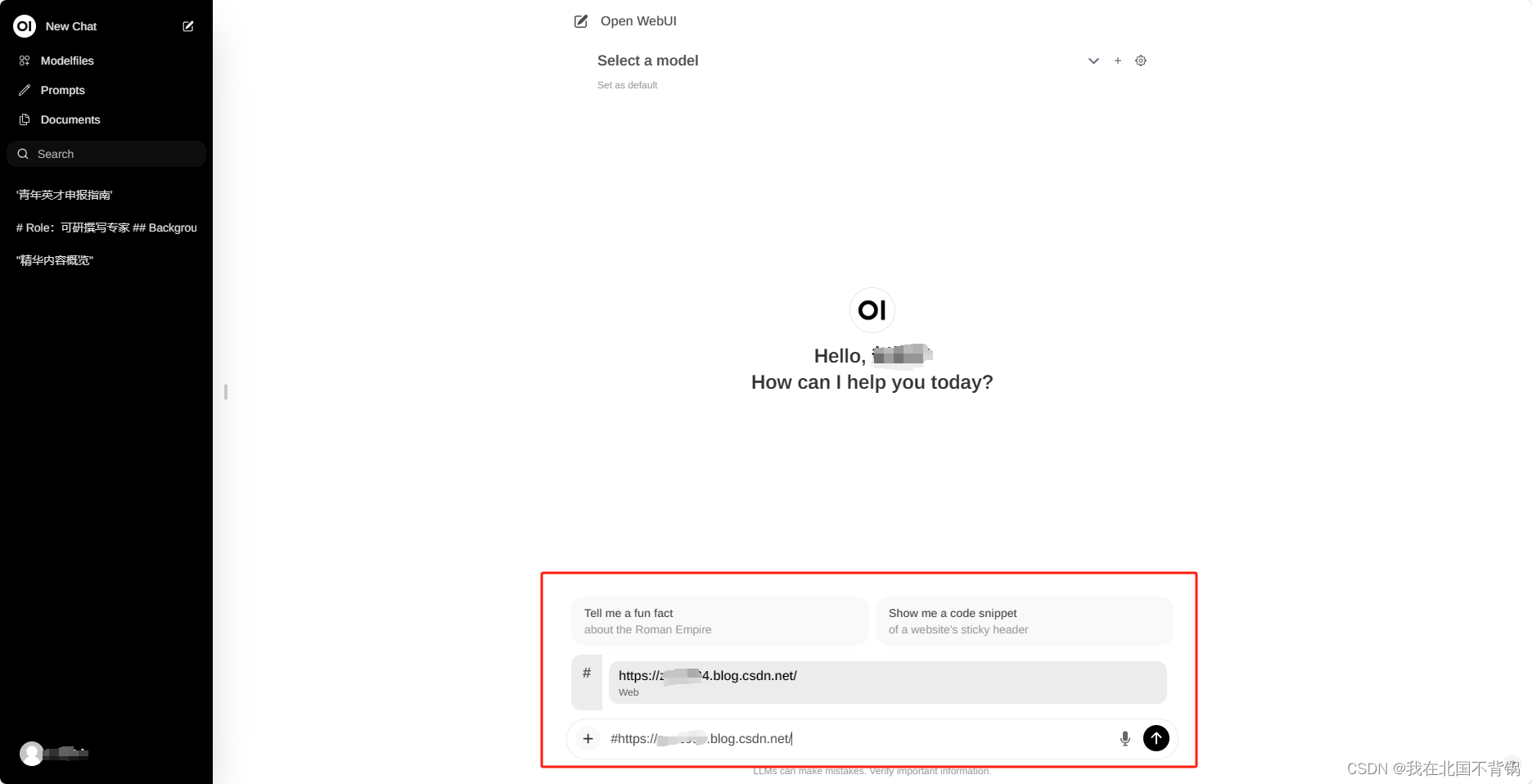

- 网页浏览功能:使用 # 命令后跟URL,无缝地将网站集成到您的聊天体验中。此功能允许您将web内容直接合并到您的对话中,增强交互的丰富性和深度。

- 提示预设支持:使用聊天输入中的 / 命令立即访问预设提示。轻松加载预定义的会话启动器,加快您的交互。通过Open web社区集成轻松导入提示。

- RLHF注释:通过对它们进行大拇指和大拇指的评级来授权您的消息,促进从人类反馈(RLHF)中进行强化学习的数据集的创建。利用您的消息来训练或微调模型,同时确保本地保存数据的机密性。

- 对话标签:毫不费力地分类和定位特定的聊天快速参考和简化的数据收集。

- 下载/删除模型:直接从web UI轻松下载或删除模型。

- GGUF文件模型创建:通过直接从web UI上传GGUF文件,轻松创建Ollama模型。简化的过程选项,从您的机器上传或下载GGUF文件从拥抱的脸。

- 多模型支持:在不同的聊天模型之间无缝切换,实现不同的交互。

- 多模态支持:无缝地与支持多模态交互的模型交互,包括图像(例如,LLava)。

- Modelfile Builder:通过web UI轻松创建Ollama模型文件。通过Open web Community集成,轻松创建和添加角色/代理、自定义聊天元素和导入模型文件。

- 协作聊天:通过无缝编排组对话来利用多个模型的集体智能。使用 @ 命令指定模型,在聊天界面中启用动态和多样化的对话。让自己沉浸在编织在聊天环境中的集体智慧中。

- OpenAI API集成:轻松集成OpenAI兼容API,用于与Ollama模型一起进行多功能对话。自定义API Base URL以链接LMStudio、Mistral、OpenRouter等。

- 多用户管理:通过我们直观的管理面板轻松监督和管理用户,简化用户管理流程。

安装

Open WebUI官方推荐采用Docker方式进行部署:

# 拉取镜像

docker pull ghcr.io/open-webui/open-webui:main

如果没有科学上网,很可能会拉不动,可以试试 docker 代理网站:https://dockerproxy.com/,按步骤依次执行以下命令:

# 如果拉不动的话加个代理

docker pull ghcr.dockerproxy.com/open-webui/open-webui:main

# 重命名镜像(如果是通过代理下载的)

docker tag ghcr.dockerproxy.com/open-webui/open-webui:main ghcr.io/open-webui/open-webui:main

# 删除代理镜像(如果是通过代理下载的)

docker rmi ghcr.dockerproxy.com/open-webui/open-webui:main

下载完成后,可以在映像中找到了。

使用 docker-compose 安装,将下面的内容保存为 docker-compose.yml 文件

version: '3'

services:

ollama-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: ollama-webui

restart: unless-stopped

ports:

- 11345:8080

environment:

- OLLAMA_API_BASE_URL=http://10.8.10.xxx:11434/api

- WEBUI_SECRET_KEY=123456

其中

OLLAMA_API_BASE_URL填写你的ollama的服务地址;

WEBUI_SECRET_KEY填写一个密码

# 将 docker-compose.yml 放入当前目录

# 一键启动

docker-compose up -d

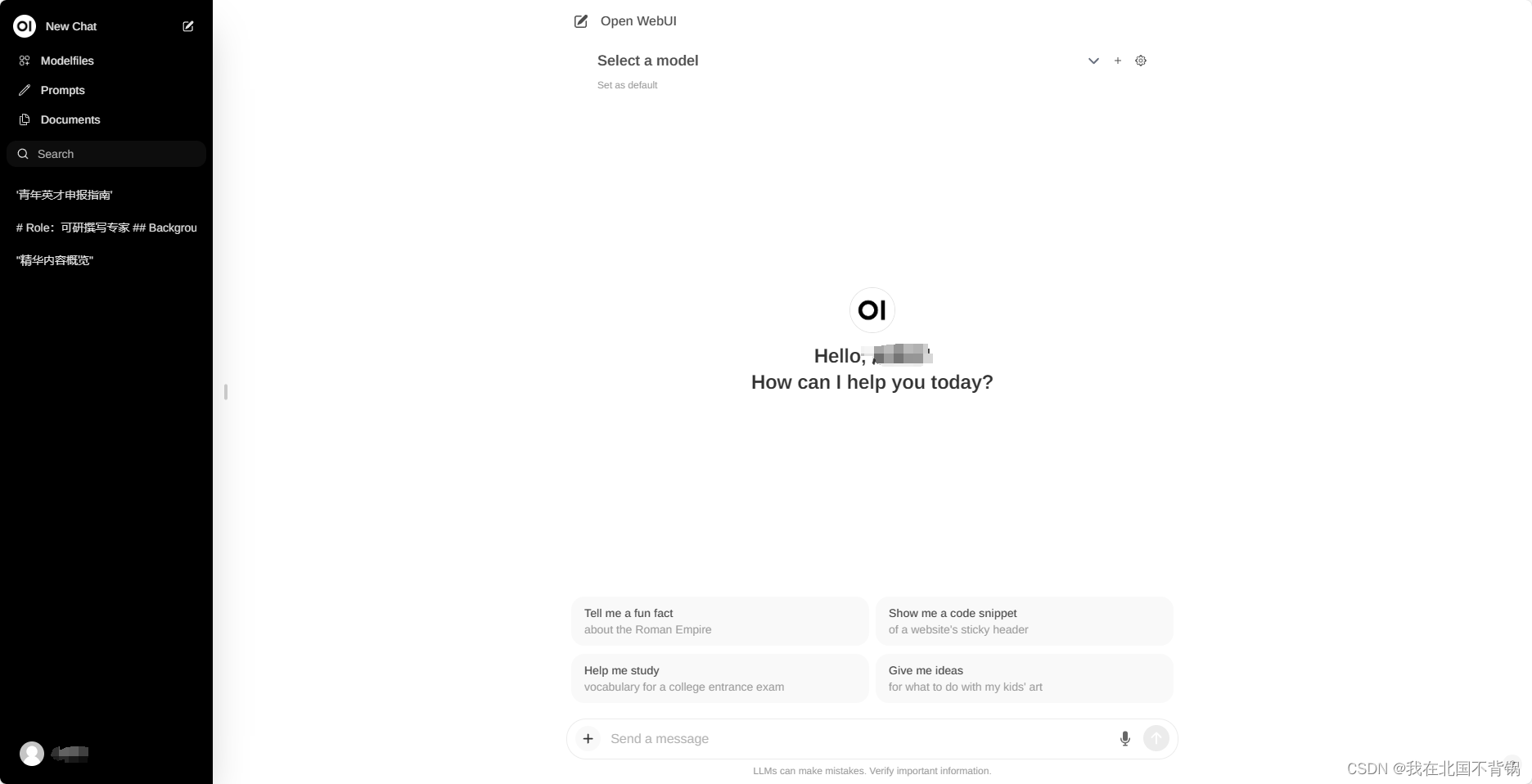

运行使用

容器运行后,在浏览器中输入 http://IP:11345 就能看到登录界面。

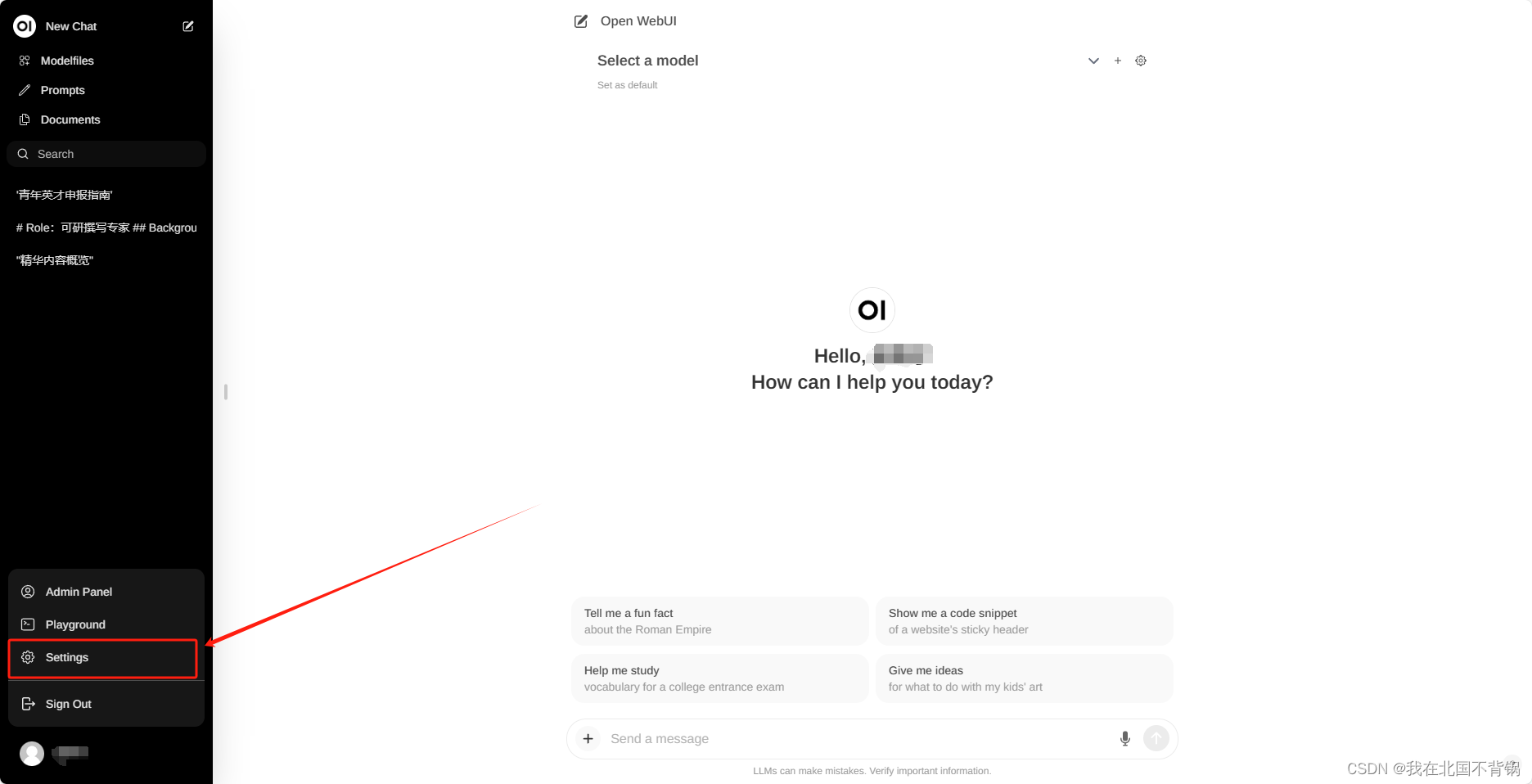

登录成功后,首先点击左下角的Setting,进行设置:

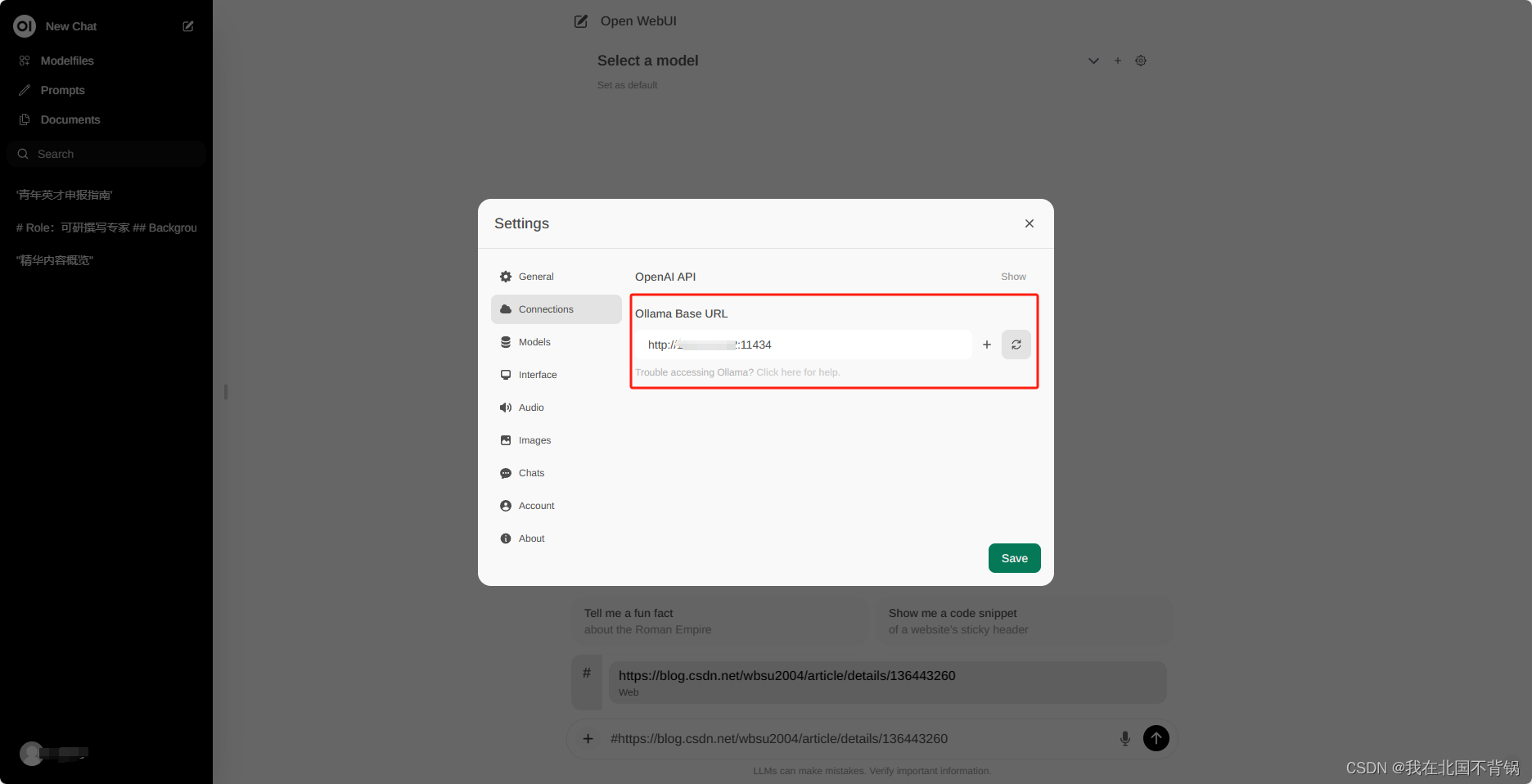

设置Ollama服务的地址:

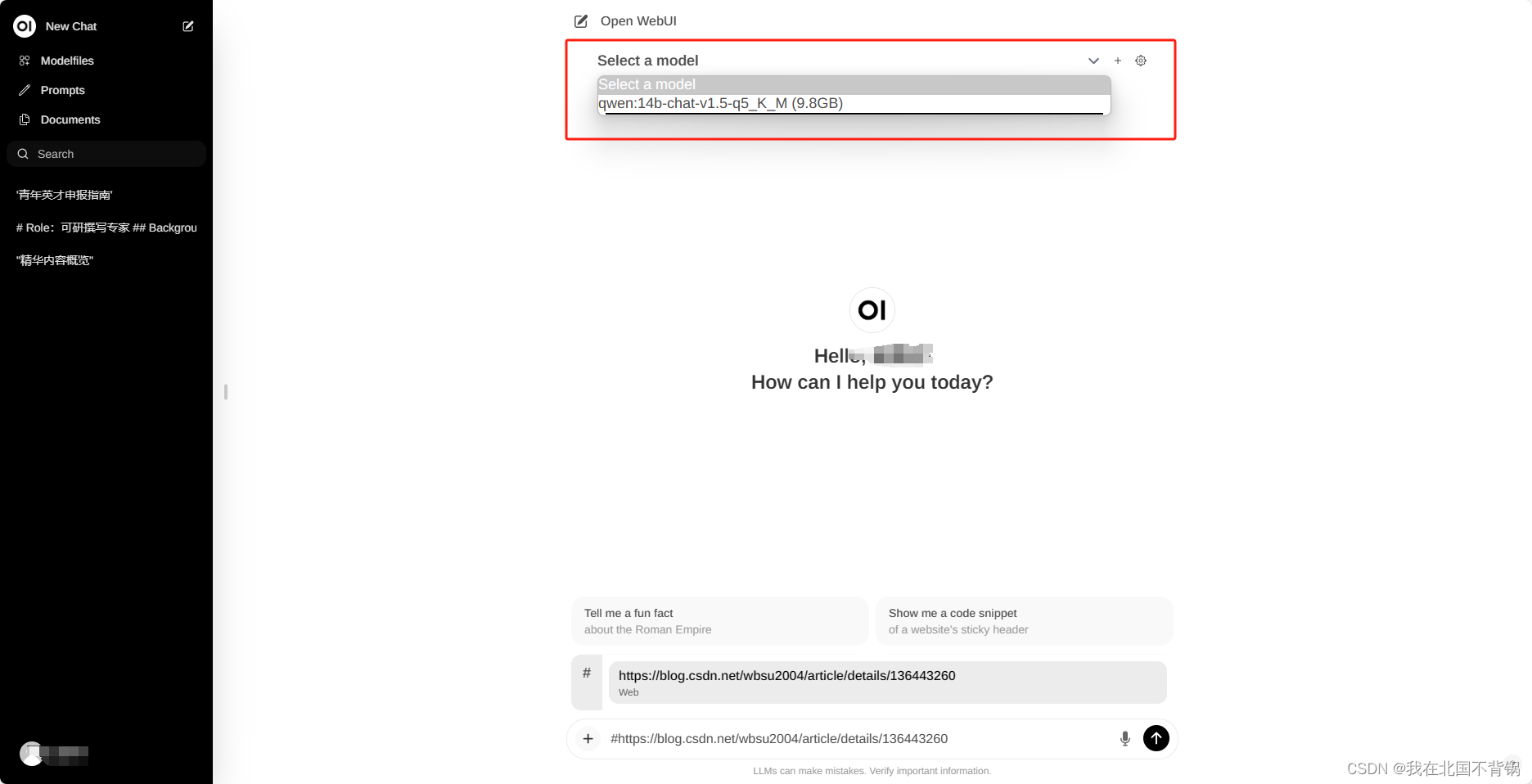

保存后,就可以选择我们ollama部署的模型正常进行问答了:

另外还有两个比较实用的功能:

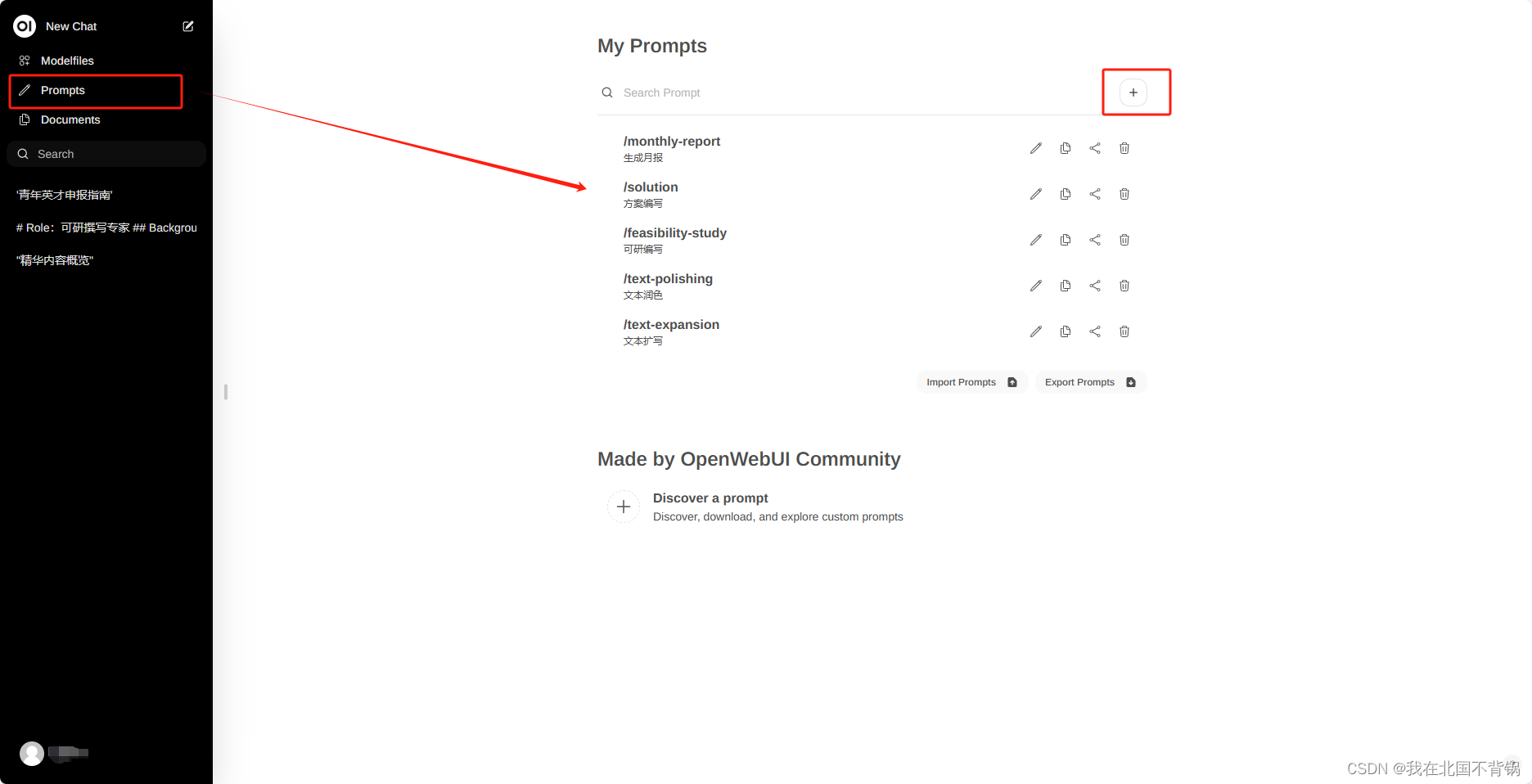

1、设置prompt提示词模板

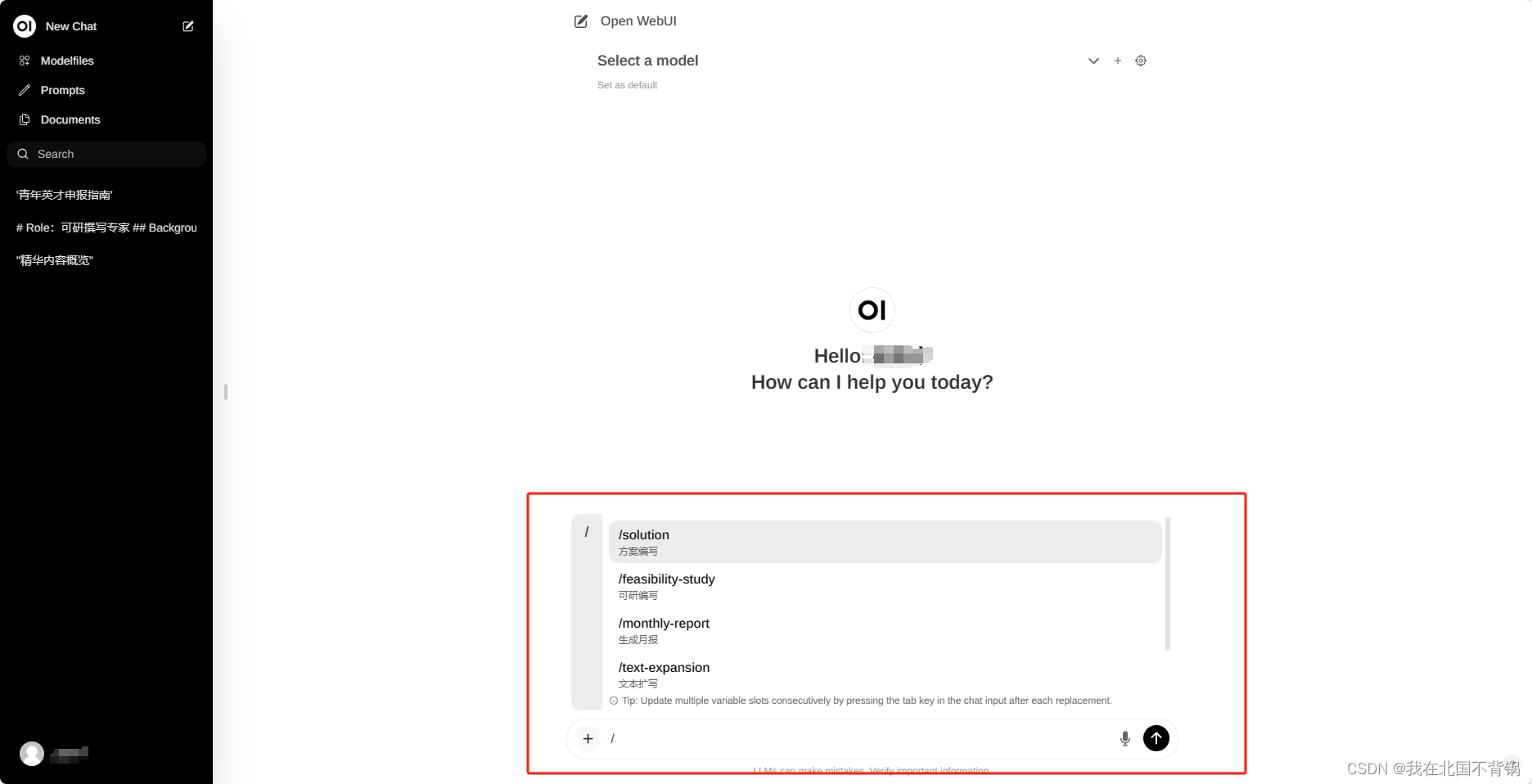

以上是我之前设置好的提示词模板,然后在问答的时候就可以通过“/”调用出设置好的prompt提示词了:

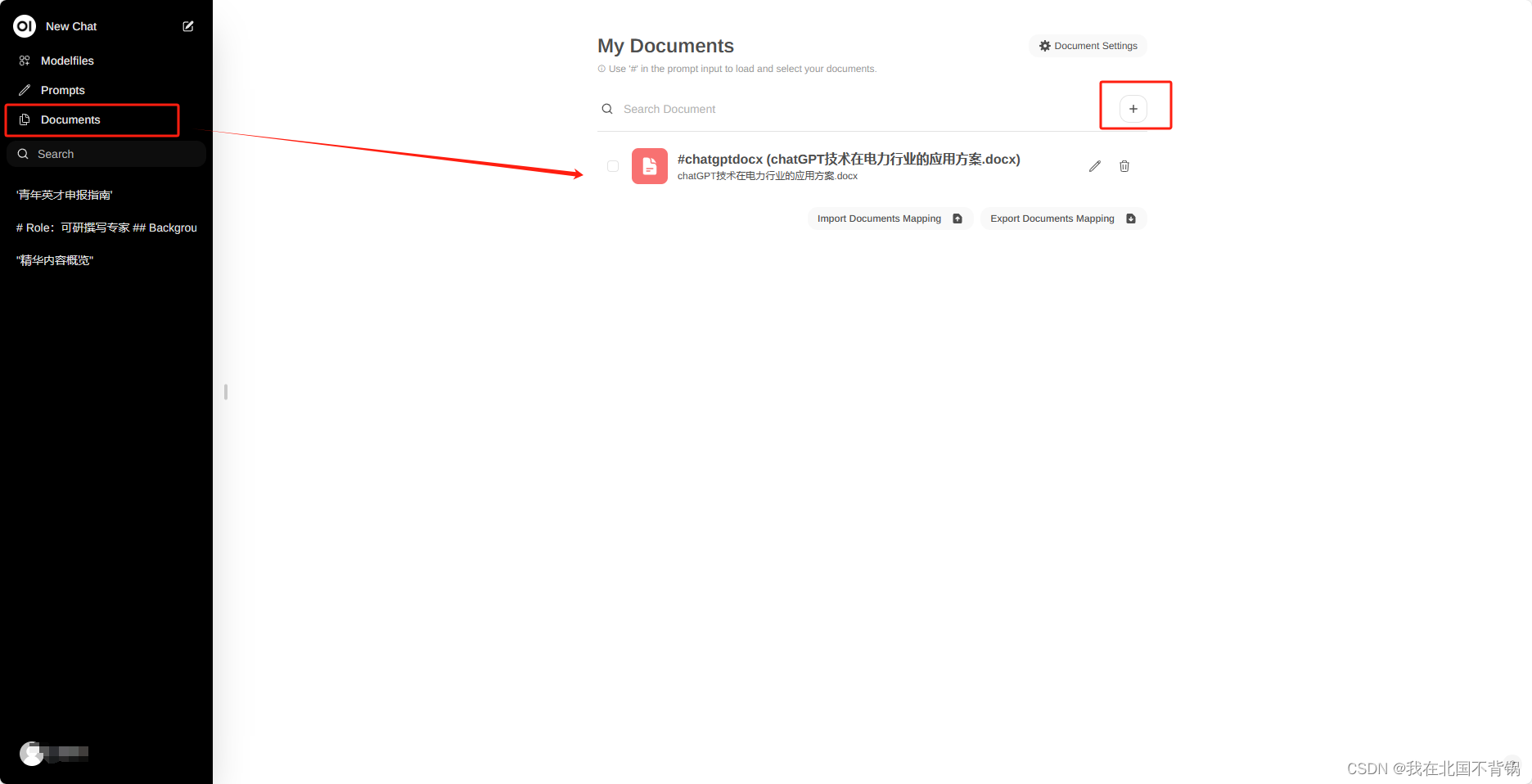

2、基于文档/网页的问答

可以在这块上传一下自己的文档:

在问答的过程中,可以通过“#”调用出上传的文档:

也可以引入一些网页,对网页内容进行问答:

其他更多内容可以参龙:

https://docs.openwebui.com/