前言

在当今信息时代,数据是无处不在且无比重要的资源。为了获取有效数据,网络爬虫成为了一项至关重要的技术。Scrapy作为Python中最强大的网络爬虫框架之一,提供了丰富的功能和灵活的操作,让数据采集变得高效而简单。本文将以爬取豆瓣网站数据为例,分享Scrapy的实际应用和技术探索。

Scrapy简介

Scrapy是一个基于Python的强大的网络爬虫框架,旨在简化数据提取的过程并提供高效的机制。凭借其可扩展性和灵活性,Scrapy被广泛应用于数据挖掘、信息收集和业务分析等领域。其核心组件包括Spider(爬虫)、Item(数据结构)、Selector(选择器)等,为开发者提供了丰富的工具来定制和执行数据爬取任务。

定制化Scrapy

在使用Scrapy进行数据采集时,项目配置是一项至关重要的工作。通过适当调整settings.py文件中的参数,我们可以定制化配置Scrapy爬虫,从而提升爬取效率、降低被网站封禁的风险,保持数据采集过程的高效稳定。本文将介绍如何进行Scrapy项目配置,并提供一些示例代码来说明各项配置参数的作用。

修改Settings.py文件

settings.py文件是Scrapy项目的配置文件,其中包含了各种可配置项,可以对爬虫进行个性化设置。以下是一些常见的配置参数及其作用:

1. User-Agent

User-Agent是HTTP请求头的一部分,用于标识发送请求的客户端。在爬取数据时,设置合适的User-Agent可以模拟不同浏览器访问,避免被网站识别为爬虫而进行封禁。

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

2. 请求延迟

设置请求延迟可以控制爬虫请求网页的时间间隔,避免对目标网站造成过大的负担,也可以规避被识别为恶意爬虫的风险。

DOWNLOAD_DELAY = 3 # 设置请求延迟为3秒

3. 代理IP(Proxy)

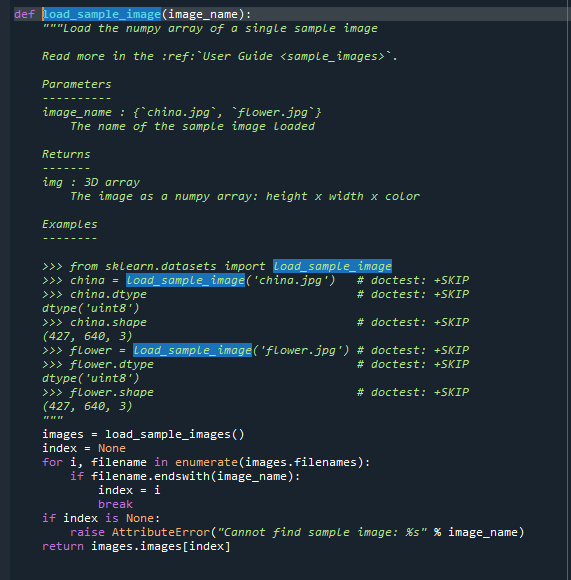

在一些情况下,为了应对网站的访问限制或提高爬取效率,使用代理IP是一个有效的选择。通过设置代理IP,可以隐藏真实IP地址,避免被频繁封禁。在Scrapy中,我们可以借助middlewares来实现代理IP的配置。

#! -*- encoding:utf-8 -*-

import base64

import sys

import random

PY3 = sys.version_info[0] >= 3

def base64ify(bytes_or_str):

if PY3 and isinstance(bytes_or_str, str):

input_bytes = bytes_or_str.encode('utf8')

else:

input_bytes = bytes_or_str

output_bytes = base64.urlsafe_b64encode(input_bytes)

if PY3:

return output_bytes.decode('ascii')

else:

return output_bytes

class ProxyMiddleware(object):

def process_request(self, request, spider):

# 代理服务器(产品官网 www.16yun.cn)

proxyHost = "t.16yun.cn"

proxyPort = "31111"

# 代理验证信息

proxyUser = "username"

proxyPass = "password"

# [版本>=2.6.2](https://docs.scrapy.org/en/latest/news.html?highlight=2.6.2#scrapy-2-6-2-2022-07-25)无需添加验证头,会自动在请求头中设置Proxy-Authorization

request.meta['proxy'] = "http://{0}:{1}@{2}:{3}".format(proxyUser,proxyPass,proxyHost,proxyPort)

# 版本<2.6.2 需要手动添加代理验证头

# request.meta['proxy'] = "http://{0}:{1}".format(proxyHost,proxyPort)

# request.headers['Proxy-Authorization'] = 'Basic ' + base64ify(proxyUser + ":" + proxyPass)

# 设置IP切换头(根据需求)

# tunnel = random.randint(1,10000)

# request.headers['Proxy-Tunnel'] = str(tunnel)

# 每次访问后关闭TCP链接,强制每次访问切换IP

request.headers['Connection'] = "Close"

4. 并发数

通过设置并发请求的数量,可以控制爬虫同时向服务器发起的请求数量,避免对服务器造成过大负荷。在某些情况下,适当调整并发数可以提高爬取速度。

CONCURRENT_REQUESTS = 16 # 设置并发请求数为16

结语

通过合适的项目配置,我们可以定制化Scrapy的行为,提高爬虫的效率,避免被封禁,确保数据采集的高效稳定。在实际应用中,根据具体的采集需求和目标网站的情况,不断优化调整参数,将是提高爬虫效率的关键之道