1.首先需要下载本仓库:

git clone https://github.com/THUDM/ChatGLM3![]()

2.查看显卡对应的torch 版本

官方文档说明: Start Locally | PyTorch

例如:

a. 先查看显卡的CUDA版本

nvcc --version

查看对应版本

Previous PyTorch Versions | PyTorch

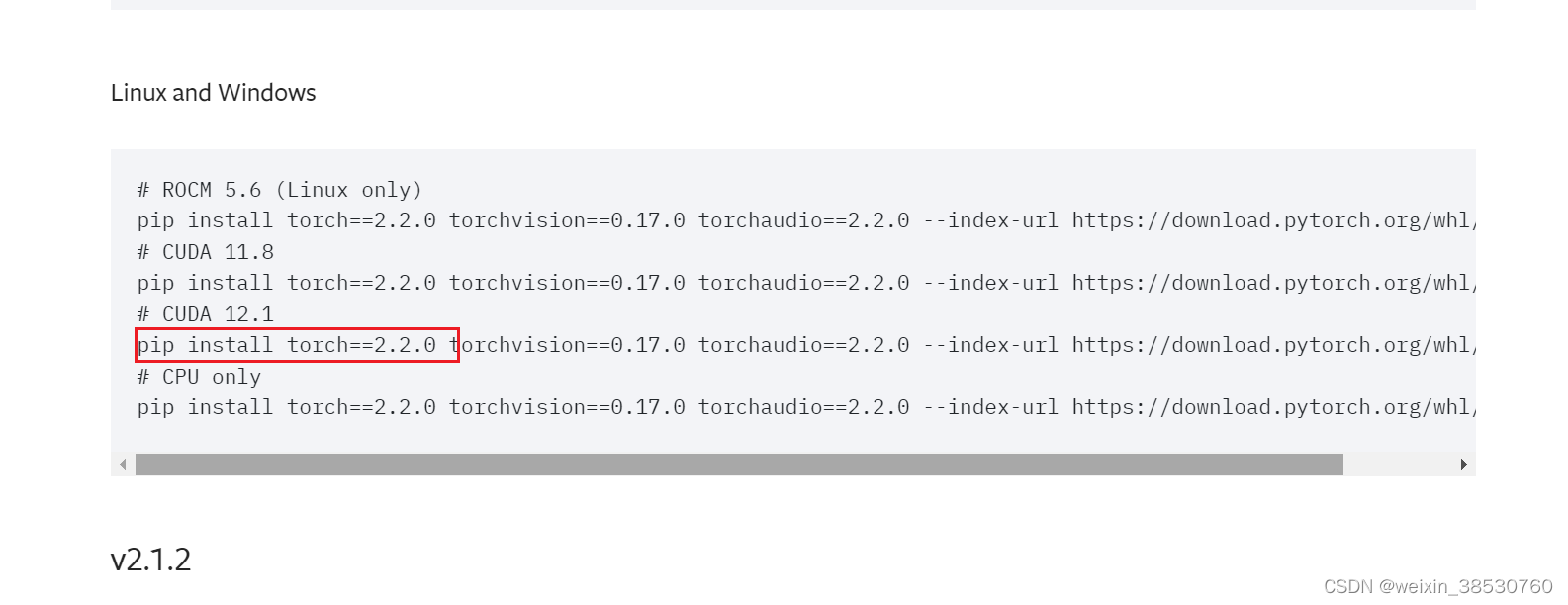

例如cuda 12.1 对应的torch 2.2.0

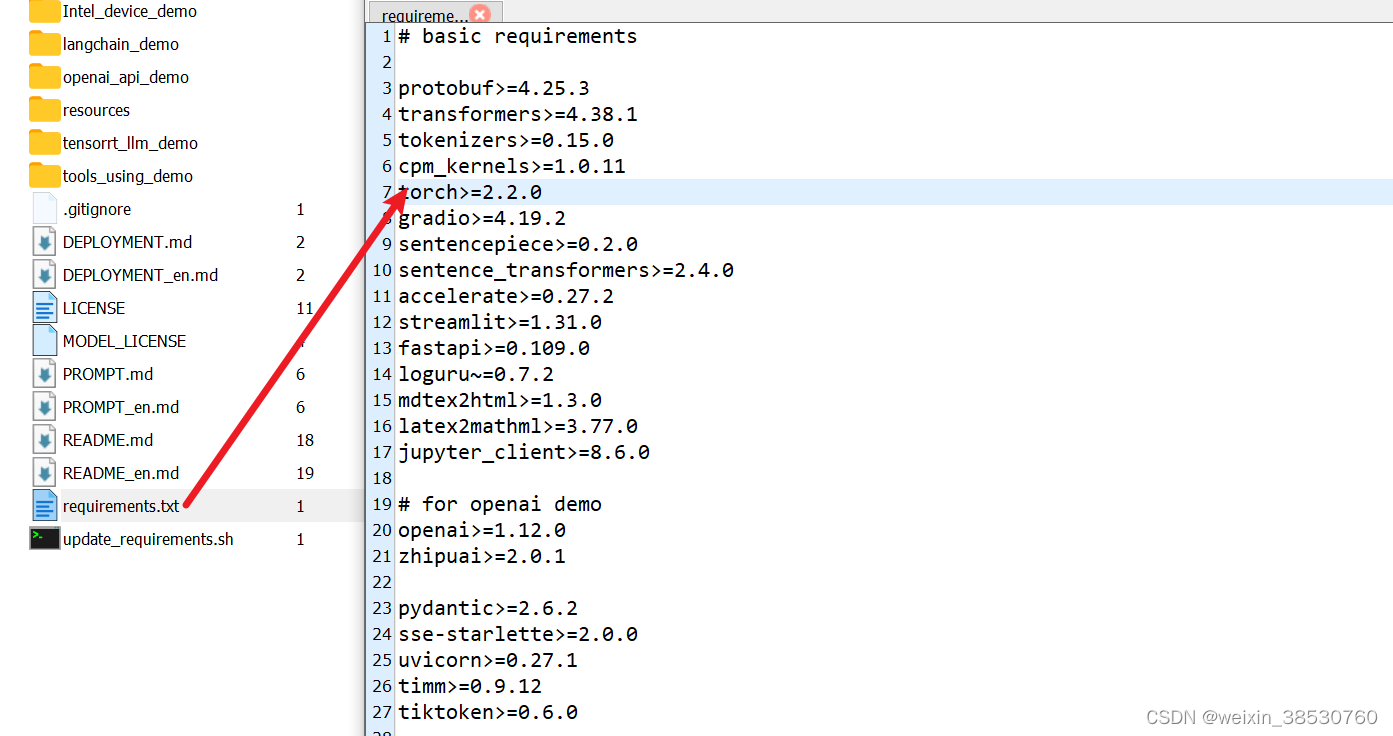

修改对应的torch版本

3.安装依赖

pip install -r requirements.txt4.下载模型到本地

推荐在魔塔社区下载,相对比较快

魔搭社区

下载方式

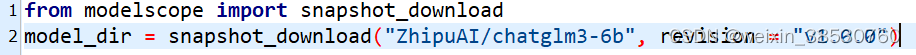

在当前目录创建一个demo.py 文件

from modelscope import snapshot_download

model_dir = snapshot_download("ZhipuAI/chatglm3-6b", revision = "v1.0.0")

如下所示

安装依赖modelscope

pip install modelscope 后

运行demo.py文件

等待下载,下载后一般在这目录下

/root/.cache/modelscope/hub/ZhipuAI/chatglm3-6b/

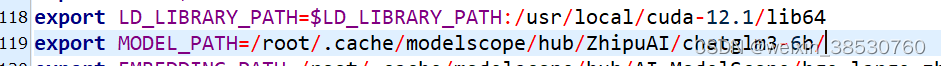

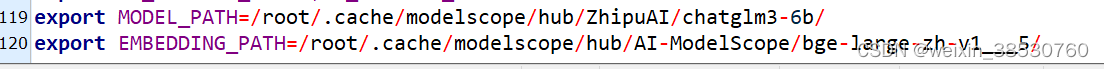

配置环境变量

在root目录下找到

.bashrc文件

在最后添加上MODEL_PATH,跟py代码中环境变量名保持一致

然后保存退出 重新加载一下该文件保证生效

source ~/.bashrc

然后进入项目地址 basic_demo 目录后运行web_demo_gradio.py

python web_demo_gradio.py

启动web_demo_gradio.py的话需要安装几个依赖

1、安装 peft

pip install peft

2、安装 gradio

pip install gradio

然后再启动

启动如果要内网映射到外网端口

在web_demo_gradio.py 代码最后

demo.launch(server_name="127.0.0.1", server_port=7870, inbrowser=True, share=False)

改成

demo.launch(server_name="0.0.0.0", server_port=7870, inbrowser=True, share=False)

如

启动后如图:

---如果要启动api_server.py

需要下载

BAAI/bge-large-zh-v1.5

下载方式和下载模型一致

在当前目录创建一个demo2.py 文件

from modelscope import snapshot_download

model_dir = snapshot_download("AI-ModelScope/bge-large-zh-v1.5", revision='master')

下载完成后,地址跟模型地址差不多

新增一个

EMBEDDING_PATH

环境变量

方法

在root目录下找到

.bashrc文件

在最后添加上MODEL_PATH,跟py代码中环境变量名保持一致

然后保存退出 重新加载一下该文件保证生效

source ~/.bashrc

重新进入api_server.py目录

启动api_server.py