表情视频数据集

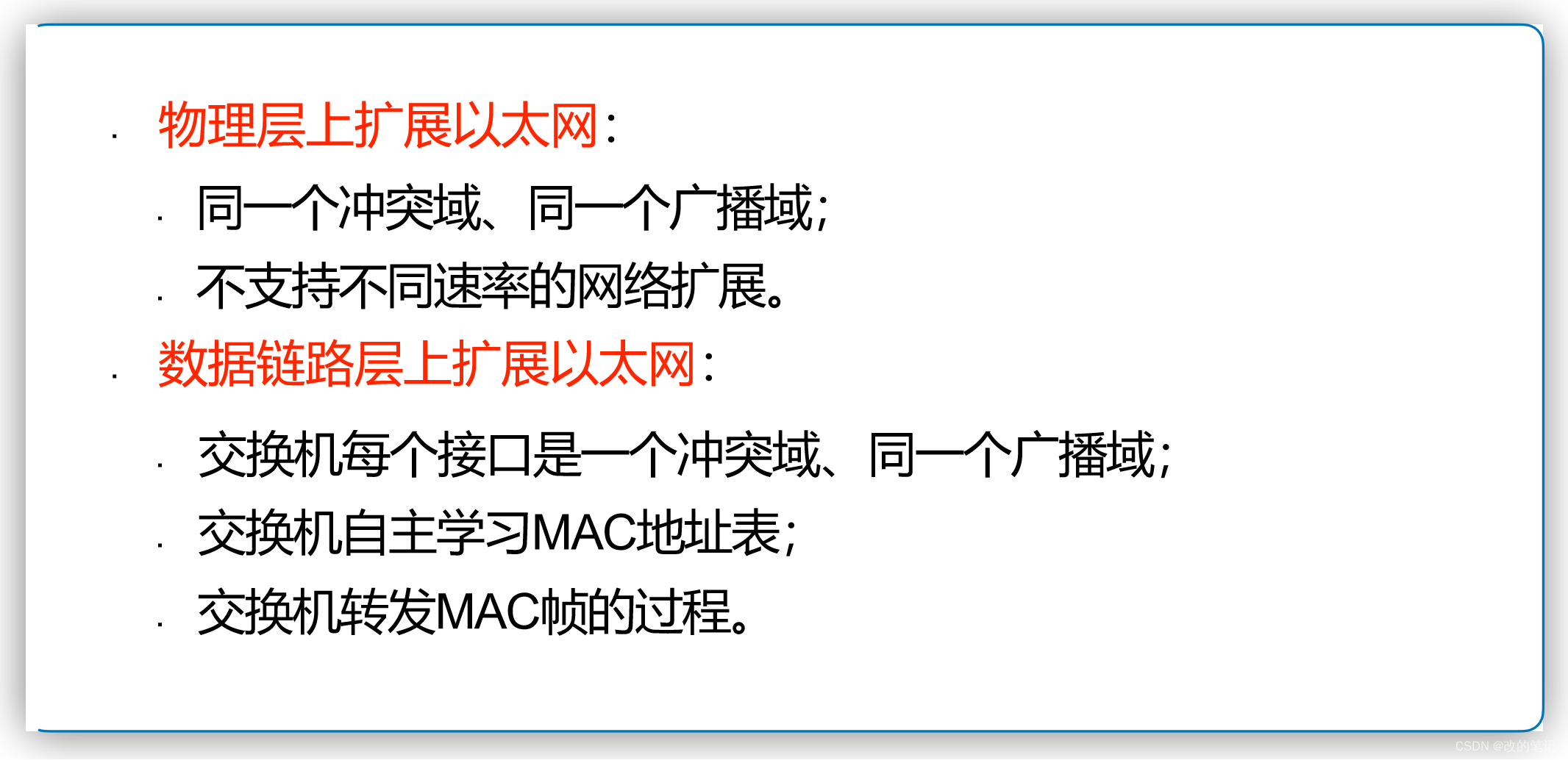

在许多的研究中,研究者通常会把人脸表情识别区分为静态的人脸表情识别(static facial emotion recognition)和动态的人脸表情识别(dynamic facial emotion recognition)。前者希望通过单张图片辨别人的表情从而达到识别人情绪的目的,而后者希望感知视频/图片序列中人们变化的表情来理解人的情绪。

在实际使用中,仅仅依赖于图片并不一定能准确反映人的情绪状态。在一些场景中,需要结合人表情的变化才能真正理解人的情绪,因此基于视频的人脸表情识别研究也显得尤为必要。(ps:视频中除了有图像信息外,往往还包含丰富的语音甚至是文字信息,因此也有许多研究是利用多模态的方法来识别视频中人的情绪。)

1.CREMA-D

官方github链接:https://github.com/CheyneyComputerScience/CREMA-D

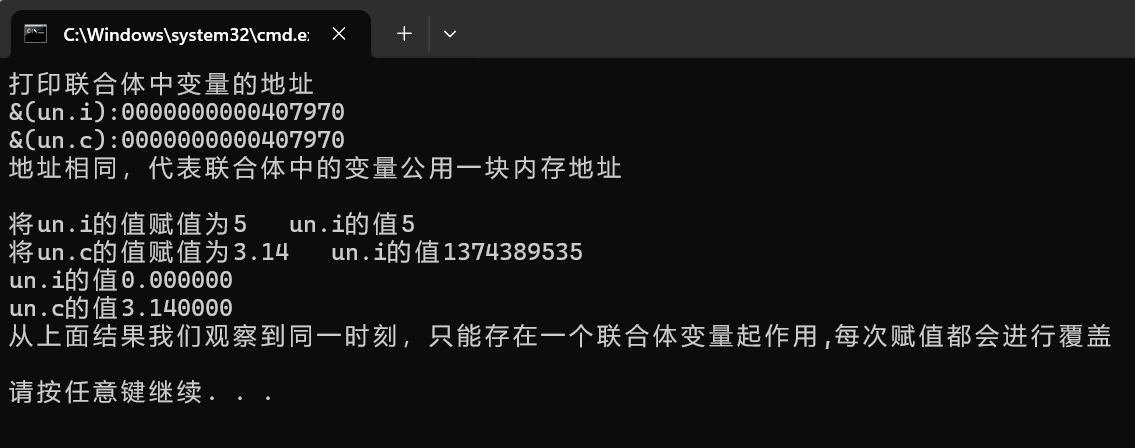

CREMA-D 是一个情感多模态演员数据集,包含来自 91 位演员的 7,442 个原始剪辑。这些片段来自 48 名年龄在 20 至 74 岁之间的男性演员和 43 名女性演员,他们来自不同的种族和民族(非裔美国人、亚洲人、高加索人、西班牙裔和未指明的人)。

演员们从12句话中选出。这些句子使用六种不同的情绪(愤怒、厌恶、恐惧、快乐、中性和悲伤)和四种不同的情绪水平(低、中、高和未指定)中的一种来呈现。

参与者根据组合的视听呈现、视频和音频对情绪和情绪水平进行评分。由于需要大量的评级,这项工作是众包的,共有 2443 名参与者每人对 90 个独特的剪辑、30 个音频、30 个视觉和 30 个视听进行了评分。95% 的剪辑有超过 7 个评分。

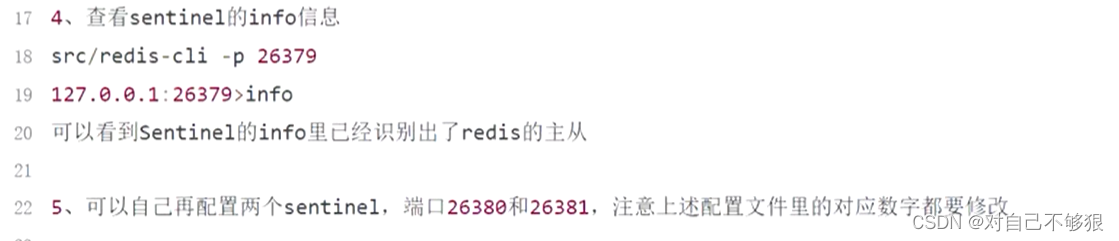

# 下载方法:安装 git 和 git-lfs

git lfs clone https://github