安装ollama

https://hub.docker.com/r/ollama/ollama

docker run -d -v ~/Documents/work/softs/docker/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

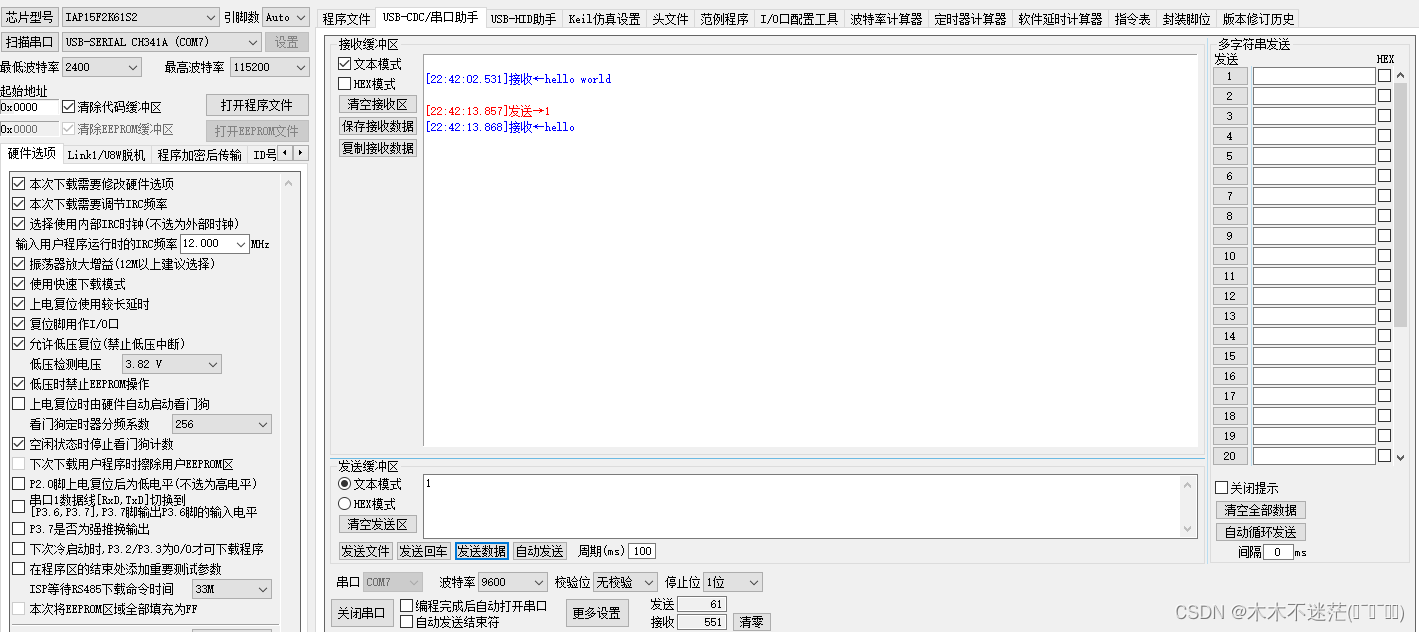

验证安装

# 进入容器

docker exec -it ollama bash

# 运行大模型

ollama run llama2

# 发送请求(会有很多输出,一直到结束)

curl http://localhost:11434/api/generate -d '{

"model": "llama2",

"prompt":"Why is the sky blue?"

}'

可以选择其支持的模型列表GitHub - ollama/ollama: Get up and running with Llama 2, Mistral, Gemma, and other large language models.

安装webui

GitHub - open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI)

# host.docker.internal == 127.0.0.1 主要是mac下docker 不支持127.0.0.1

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=http://host.docker.internal:11434 -v ~/Documents/work/softs/docker/open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main验证安装

访问http://127.0.0.1:3000,开始对话