出版商正在部署基于人工智能的工具来检测可疑图像,但生成式人工智能威胁着他们的努力。

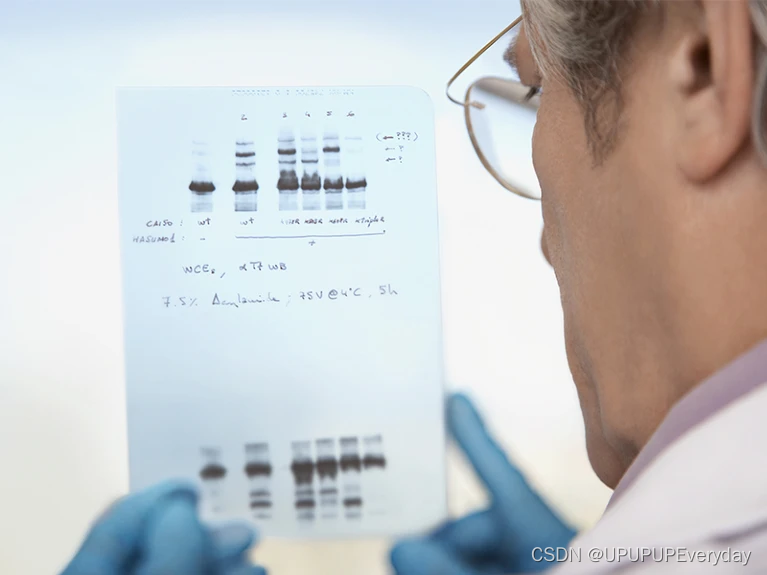

期刊正在努力检测用于分析蛋白质和DNA的凝胶的操纵图像。图片来源:Shutterstock

似乎每个月都会有一系列针对研究人员的新高调指控,这些研究人员的论文——其中一些是几年前的——包含可能操纵图像的迹象。

科学家侦探正在使用他们自己训练有素的眼睛,以及基于人工智能(AI)的商业软件,来发现图像复制和其他可能暗示记录保存不严或更糟的问题。他们在 PubPeer 等地方揭露了这些担忧,这是一个在线论坛,每天都有许多新帖子标记图像问题。

其中一些努力已经导致了行动。例如,上个月,位于马萨诸塞州波士顿的丹娜-法伯癌症研究所(DFCI)表示,它将要求期刊撤回或更正其工作人员撰写的大量论文。在一位观察人士对报纸上的图像表示担忧之后,披露了这一信息。该研究所表示,它正在继续调查这些问题。

这一事件只是众多事件之一。面对公众的监督,学术期刊越来越多地采用技巧和工具,包括基于人工智能的商业系统,在出版前而不是出版后发现有问题的图像。在这里,《自然》杂志回顾了这个问题以及出版商如何试图解决这个问题。

发现了哪些类型的图像问题?

有问题的图像做法包括在多个图表中使用相同的数据、复制照片或部分照片,以及删除或拼接图像。例如,此类问题可能表明有误导的意图,但也可能是由于无辜地试图改善人物的审美而造成的。尽管如此,专家说,即使是无辜的错误也可能损害科学的完整性。

这些问题有多普遍,它们是否在上升?

此类事件的确切数量尚不清楚。“撤稿观察”网站维护的数据库列出了超过51,000份记录在案的撤稿、更正或关切表达。其中,大约4%的人表示对图像的担忧。

量化这个问题的最大努力之一是由加利福尼亚州旧金山的科学图像侦探和顾问伊丽莎白·比克(Elisabeth Bik)和她的同事进行的1.他们检查了1995年至2014年间发表的20,000多篇论文中的图像。总体而言,他们发现近4%的论文包含有问题的数字。该研究还显示,从2003年左右开始,不适当的图像重复有所增加,这可能是因为数码摄影使改变照片变得更加容易,Bik说。

比克指出,现代报纸包含的图像也比几十年前的图像更多。“与十年前相比,每天发表的论文要多得多,科学家发表的压力越来越大,再加上所有这些,就会发现更多的问题。

图像问题报告率高也可能是由于“由于全球社会对诚信问题的认识提高而导致举报人数增加”,在加利福尼亚州旧金山的PLOS出版伦理团队工作的Renee Hoch说。

Dana-Farber 癌症研究所发生了什么?

今年1月,位于英国庞特普里德的生物学家和调查员肖尔托·戴维(Sholto David)在博客上发表了一篇关于DFCI科学家发表的50多篇生物学论文中可能的图像操纵的博客,DFCI隶属于马萨诸塞州剑桥市的哈佛大学。作者包括 DFCI 主席 Laurie Glimcher 和她的副手 William Hahn;DFCI发言人表示,他们没有与记者交谈。David的博客强调了近20年来论文中的重复或其他图像异常。该帖子最初由The Harvard Crimson报道。

DFCI已经在调查其中一些问题,正在寻求撤回几篇论文和更正许多其他论文。DFCI的研究诚信官员巴雷特·罗林斯(Barrett Rollins)表示,“尽快纠正科学记录很重要,也是具有强大研究诚信的机构的常见做法”。

“值得重申的是,论文中存在图像重复或差异并不是作者有欺骗意图的证据,”他补充道。

期刊正在采取哪些措施来提高图像完整性?

为了减少处理不当图像的发表,一些期刊,包括《细胞科学杂志》(Journal of Cell Science)、《PLOS 生物学》(PLOS Biology)和《PLOS ONE》,要求或要求作者提交原始图像,以及其图中裁剪或处理过的图像。

许多出版商还将基于人工智能的工具(包括 ImageTwin、ImaCheck 和 Proofig)纳入一致或现场出版前检查中。《科学》系列期刊在一月份宣布,它现在正在使用Proofig来筛选其所有投稿。《科学》系列期刊的主编霍尔顿·索普(Holden Thorp)说,Proofig已经发现了导致编辑决定不发表论文的事情。他说,作者通常很感激他们的错误被发现。

这些基于人工智能的系统会标记哪些类型的问题?

例如,所有这些系统都可以快速检测同一张纸中图像的重复,即使这些图像已被旋转、拉伸或裁剪或改变其颜色。

不同的系统有不同的优点。例如,Proofig 可以发现通过切出或拼接图像部分而创建的拼接。Bik说,ImageTwin的优势在于允许用户将图像与其他论文的大量数据集进行交叉检查。包括施普林格·自然(Springer Nature)在内的一些出版商正在开发自己的AI图像完整性软件。(《自然》杂志的新闻团队在编辑上独立于其出版商施普林格·自然(Springer Nature)。

人工智能工具标记的许多错误似乎是无辜的。在一项对 2021 年和 2022 年初提交给 9 家美国癌症研究协会期刊的 1,300 多篇论文的研究中,Proofig 将 15% 标记为可能存在图像重复,需要对作者进行跟进。作者的回答表明,在207个重复中,有28%是故意的,例如,作者使用相同的图像来说明多个观点。63%是无意的错误。

这些人工智能系统的运作情况如何?

用户报告说,基于人工智能的系统无疑可以更快、更容易地发现某些类型的图像问题。《临床研究杂志》(Journal of Clinical Investigation)在2021年至2022年期间试用了Proofig,发现它使具有潜在问题图像的手稿比例增加了两倍,从1%增加到3%2.

但他们不太擅长发现更复杂的操作,Bik说,或者人工智能生成的伪造。这些工具“对于检测错误和低级完整性漏洞很有用,但这只是更大问题的一个小方面”,EMBO Reports的主编Bernd Pulverer表示同意。“现有的工具充其量只是冰山一角,可能会急剧增长,目前的方法很快就会被淘汰。

出版前检查是否能解决图像问题?

专家团队、技术工具和提高警惕的结合似乎正在发挥作用——目前是这样。“我们已经应用了十多年的系统筛查,并且第一次看到检出率下降,”Pulverer说。

但随着图像处理变得越来越复杂,捕捉它将变得越来越困难,他说。“几年后,我们目前所有的图像完整性筛查仍然有助于过滤错误,但肯定不能用于检测欺诈,”Pulverer说。

从长远来看,如何最好地解决图像处理问题?

Bik说,最终,消除图像处理将涉及对科学研究方式的复杂改变,更加关注严谨性和可重复性,以及对不良行为的影响。她说:“有太多关于欺凌和要求很高的PI在实验室里花费的时间太少的故事,这只会创造一种可以作弊的文化。“这需要改变。”

自然 626, 697-698 (2024)

doi: https://doi.org/10.1038/d41586-024-00372-6