此为看完视频Humans vs. AI: who makes the best decisions?后的笔记。

对于不同的任务,AI和人类各有擅长。

在本视频中,作者具化到了一个欺诈检测系统。欺诈检测系统会生成潜在欺诈交易的警报,金融分析师会审查每个警报。但每天都会生成数千个警报,而且90% 是误报,借助人工智能系统确实可以减轻工作量。

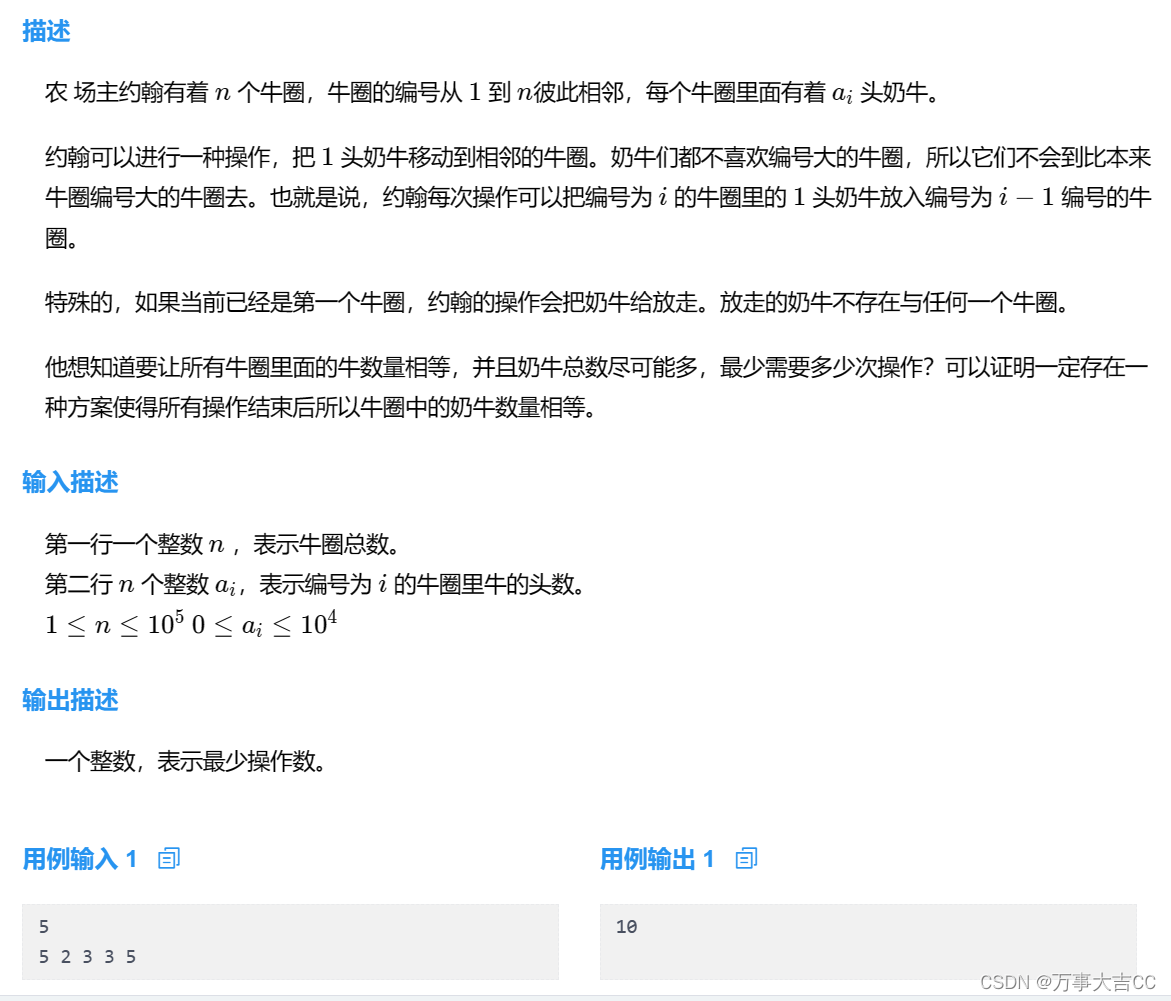

但哪些警报应该由人工智能处理,哪些警报应该由熟练的金融分析师处理?

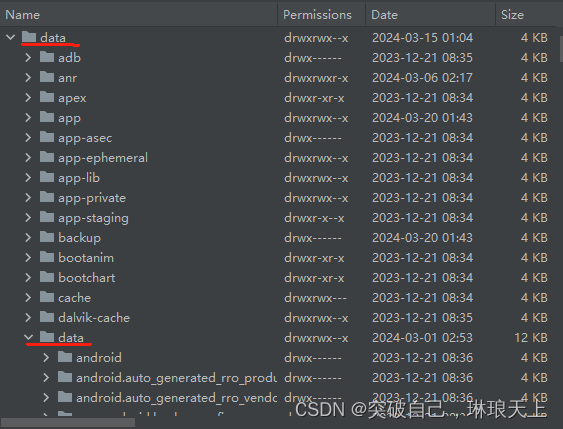

所以作者画了个坐标图。这个图回答一个问题:“这是真正的警报吗?”

Y 轴跟踪成功率(预测是否正确,可以通过后期跟踪确定)。

X 轴是置信度,叫自信度也行,😉 。因此,0%表示预测认为这绝对不是真正的警报,而是误报。100% 意味着预测确定它是真正的警报。

首先来看AI预测的性能曲线,就是最上面那个,紫红色的曲线。在两端,AI非常自信。即对于误报和真的警报,AI的预测成功率很高。而在中间的不置可否的区域,AI的表现则差强人意。也可以认为,AI非常适合这种明确是YES或NO的封闭式问题。

再看人类的那条白色曲线,中间部分的成功率则胜过AI,两头则不如。

以下是整理后的文字,以提高其条理性:

为什么会出现这种情况呢?

当人工智能对任务有信心时,其性能往往非常出色,能够击败那些可能会因缺乏一致性、专注力或注意力而出错的人类。人工智能在执行任务时通常不会分心。

然而,当人工智能面对不确定性时,特别是在处理复杂或统计上罕见的情况时,人类往往能够超越人工智能的预测能力。这是因为人类可以借助额外的信息和上下文,如查找资料或询问同事等方式,来做出更为准确的决策。与此不同的是,人工智能会固执地遵循其原始的决策逻辑和信息。

因此,当面临新的警报时,如果人工智能能够指定警报的高或低置信度,根据统计学的角度来看,如果警报是真实的,人工智能更可能正确地导出或误报,而不像给定的金融分析师那样容易受到干扰。

因此,当新警报出现时,如果人工智能指示了高或低的置信度,那么从统计学上来说,它可能会比特定的金融分析师预测更准。

但这不是非此即彼的零和游戏。我们还有一个选择:增强AI,即在AII辅助下人类决策。他的性能曲线(蓝紫色)介于AI和人类之间。对于那些不高不低的区域(也是面积最大的部分),增强AI的表现最好。

接下来,我们还需要考虑人类认知偏差这一问题。

我们并不总是擅长按照别人的吩咐去做。 事实证明,我们向人类决策者呈现AI算法信息的方式对该信息的使用效率具有重大影响。

有两种方式。强制显示和可选显示。

对于给定的决策案例,强制显示会同时显示AI的建议。因此分析师会看到人工智能的建议。 这可能会导致所谓的自动化偏见,即人类倾向于支持自动化决策系统的建议并忽略矛盾的信息。此时,人类以牺牲自己的判断为代价来接受人工智能的预测。

可选显示意味着AI建议仅在人类决策者提出请求时才会显示给他们。这克服了自动化偏差,人类并不会受到人工智能想法的极大影响。人类有时间自己仔细考虑,塑造自己的第一印象。

然后还有信任问题。当人工智能推荐附有准确率百分比(表明预测正确的可能性)时,无论百分比是多少,人类不太可能采纳人工智能的建议。因为,人类不喜欢公然告诉我们它们可能是错误(毕竟不是100%)的建议。

所以,作者的建议就是,采用人类和AI结合的增强AI来做决策。这样可以从主观决策转向可量化决策,从而最大限度地减少决策过程中的人类认知偏差。

如果我们知道该问谁,我们就可以改善决策结果。

以上就是视频的整个内容,我们看到评论中也有一些有趣的观点:

- 当决策对其他人(生命、正直、尊严等)产生严重影响时,“强制显示”和“可选显示”是一个基本考虑因素,您不能简单地责怪算法为您做出了糟糕或错误的决定 ,也不是开发模型的研究人员!!!

- 人类必须拥有最终决定权,即使该决定依赖于AI的最终决定。 这将取决于个人,根据具体情况或普遍条件。 人工智能不可能是万能的灵丹妙药,这种想法可能会产生不切实际的期望和失望,从而导致反对或另一个人工智能冬天。

- 所有那些必须通过人为交互做出决策的不确定情况都可以反馈给AI模型,以便将来在没有人的情况下做出更准确的决策吗?