前言

一说起大模型,都是需要GPU,能不能有一些方法实现本地也可以部署大模型,这也就是写这一篇的初衷了。

ollama

介绍

ollama主要简化了部署大模型的复杂度

github地址:ollama/ollama:启动并运行 Llama 2、Mistral、Gemma 和其他大型语言模型。 (github.com)![]() https://github.com/ollama/ollama

https://github.com/ollama/ollama

github上可以看ollama相关介绍,包括如何使用

下载

ollama一开始主要支持linux,docker也可以,目前有windows下的预览版可以下载

ollama官网 windows预览版下载![]() https://ollama.com/download/OllamaSetup.exe

https://ollama.com/download/OllamaSetup.exe

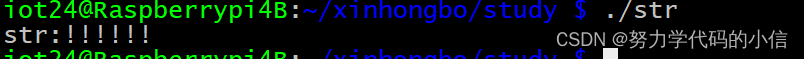

运行

安装完成即可通过cmd窗口使用ollama命令来运行大模型(注意第一次会先下载模型文件,我这里用的llama2的大小是4G多,还可以)

接下来就可以输入进行大模型对话了

不过命令行在实际应用中不方便,那么也可以通过ollama实现webapi调用方式

ollama serve--启用server模式

ollama run llama2(这里就是具体模型名称)

接下来即可通过postman、apipost等工具调用大模型了

注意这里地址是:localhost:11434/api/chat

存在问题

1)命令行下速度很快,但是webapi方式就很慢

还没搞懂咋回事,现在只是初步知道了怎么用。后面再试试其他模型,看看是不是模型的问题

vllm

介绍

vllm主要作用其实是可以提高推理性能,但是必须在linux下运行,而且必须有GPU

官网地址

vllm官网 Welcome to vLLM! — vLLM![]() https://docs.vllm.ai/en/latest/

https://docs.vllm.ai/en/latest/

下载模型

这里以下载千问7B为例,由于模型文件会比较大,因此安装git的lfs插件

git lfs install

git clone https://huggingface.co/Qwen/Qwen-7B-Chat

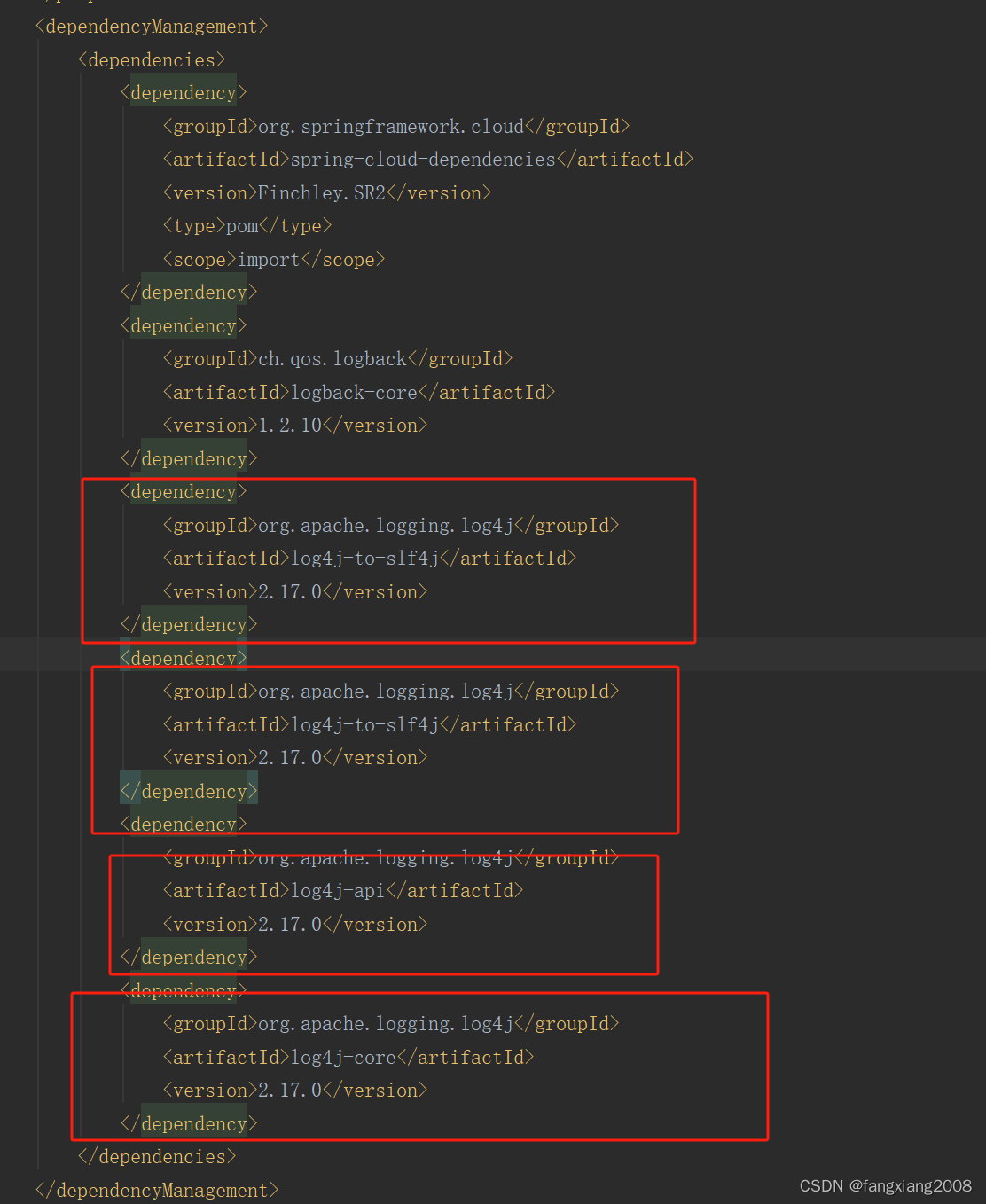

安装vllm

安装的话,为了避免python环境冲突问题,先通过conda创建一个新的虚拟环境

然后pip install vllm

也可以先从github下载,再去安装

vllm github地址![]() https://github.com/vllm-project/vllm

https://github.com/vllm-project/vllm

运行

python -m vllm.entrypoints.openai.api_server --model="Qwen/Qwen-7B-Chat" --trust-remote-code --port 1234

注意:--model参数这里,如果之前已经下载了模型文件,这里是参数值改为模型文件路径,否则设置为模型名,然后会自动下载

注意2:通过aipost工具调用大模型,model参数需要和如上cmd运行命令的--model参数一致,否则会提示找不到model,这个我觉得是比较不好的一点

存在问题

1)通过apipost工具调用webapi,回答完,还会继续输出其他内容

一样,没搞懂为啥

![[java基础揉碎]Object类详解](https://img-blog.csdnimg.cn/direct/ff94e2d601624394ae09db4a72f111b2.png)