2024年3月11日由华为诺亚方舟实验室、大连理工大学和香港大学的研究团队共同开发的PixArt-Σ是一款能够直接生成4K分辨率图像的扩散变换模(DiT)。PixArt-Σ相比其前作PixArt-α,在图像质量和文本提示对齐方面有了显著提升,展示了从“弱”到“强”的训练效率。

由于PixArt-Σ和PixArt-α有着很大的关联。所以在向大家介绍PixArt-Σ之前,先为大家介绍PixArt-α的相关工作。

文生图模型如DALLE2、Imagen和Stable Diffusion的发展,开启了逼真图像合成的新时代。这不仅对图片编辑、视频制作、3D素材创建等领域产生了深远影响,还为研究社区和企业提供了许多下游应用的机会。

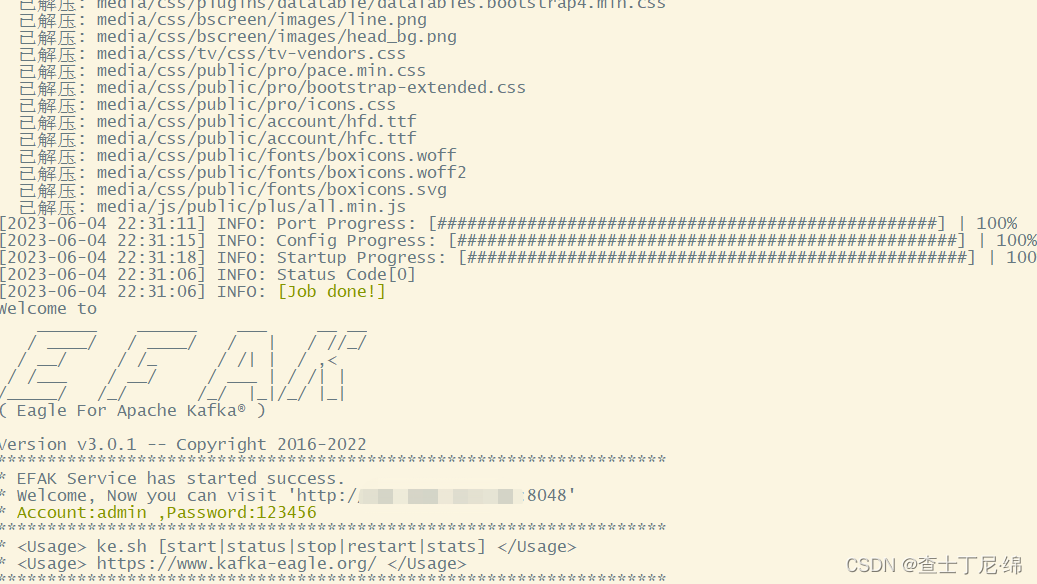

现在训练一个媲美 MJ 的文生图模型,26K 美元就能实现了。

来自华为诺亚方舟实验室等研究机构的研究者联合提出了开创性的文本到图像(T2I)模型 PixArt-α, PixArt-α主打的是低训练成本。采用Meta之前提出的DiT架构,模型参数只有0.6B,它的训练时长只有SD 1.5的10.8%,而且只使用了25M数据进行训练。

相关链接

-

项目主页:https://pixart-alpha.github.io/

-

项目地址:https://github.com/PixArt-alpha/PixArt-alpha

-

论文地址:https://arxiv.org/abs/2310.00426

在线Demo

-

Demo试用链接:https://github.com/PixArt-alpha/PixArt-alpha

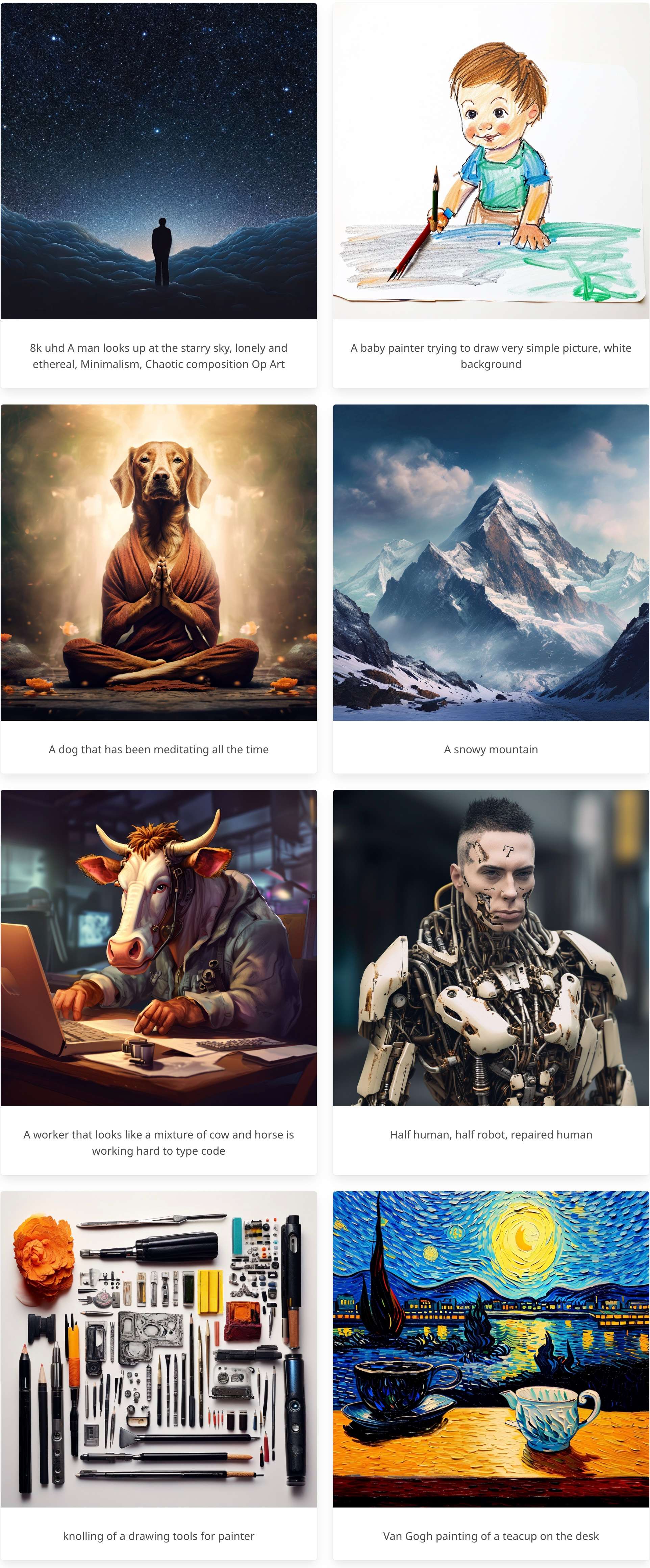

效果展示

论文阅读

摘要

PIXART-α是一种基于transformer的T2I扩散模型,其图像生成质量与最先进的图像生成器(例如Imagen, SDXL,甚至Midjourney)相媲美,达到了接近商业应用标准。

此外,它支持分辨率高达1024px的高分辨率图像合成,训练成本低。为了实现这一目标,提出了三个核心设计:

-

(1)训练策略分解:我们设计了三个不同的训练步骤,分别优化像素依赖性、文本-图像对齐和图像美学质量;

-

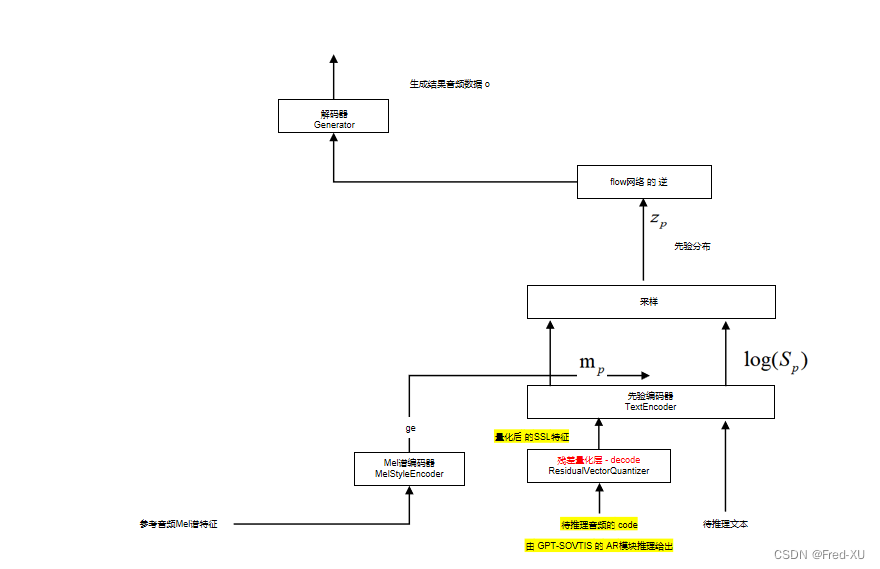

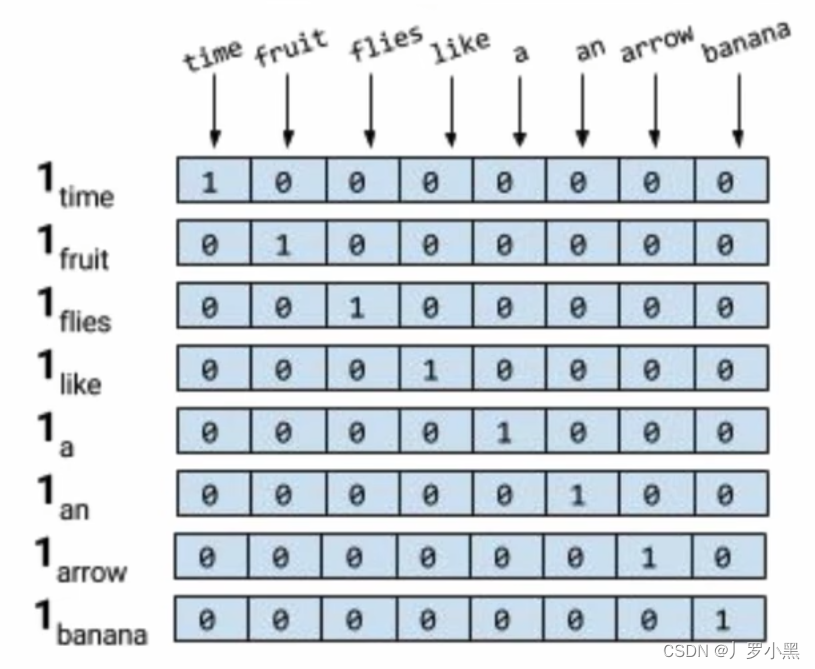

(2)高效T2I变压器:在扩散变压器(Diffusion Transformer, DiT)中加入交叉关注模块,注入文本条件,简化计算密集型类条件分支;

-

(3)高信息量数据:我们强调概念密度在文本-图像对中的重要性,并利用大型视觉语言模型自动标记密集的伪标题,以辅助文本-图像对齐学习。

因此,PIXART-α的训练速度明显超过了现有的大规模tti模型。此外,与更大的SOTA模型RAPHAEL相比,训练成本仅为1%。大量的实验表明,PIXART-α在图像质量、艺术性和语义控制方面表现优异。

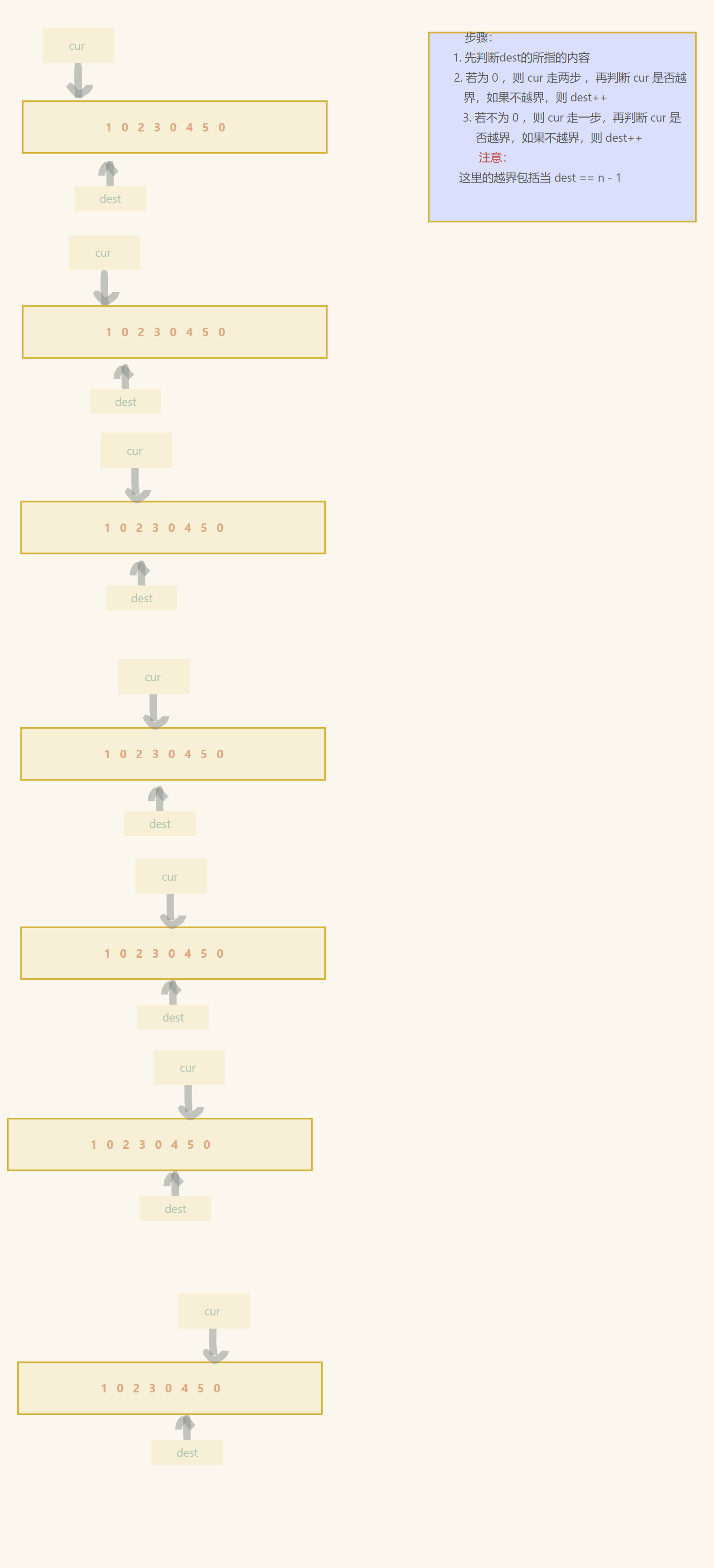

方法

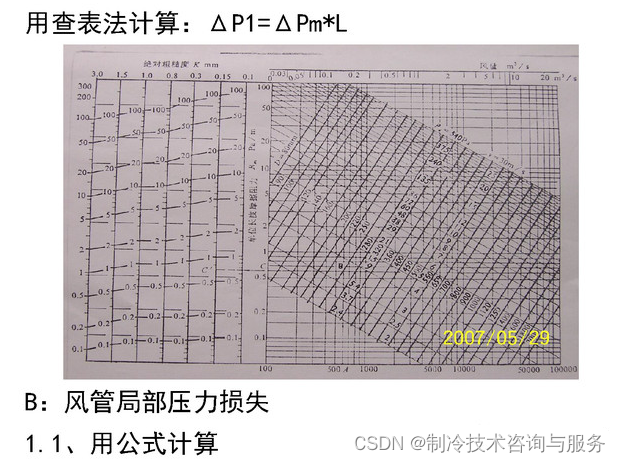

相比于T2I的CO2排放与训练花费,PIXART-α实现了26,000美元的极低训练成本。与RAPHAEL相比,碳排放量和训练成本分别仅为1.1%和0.85%。

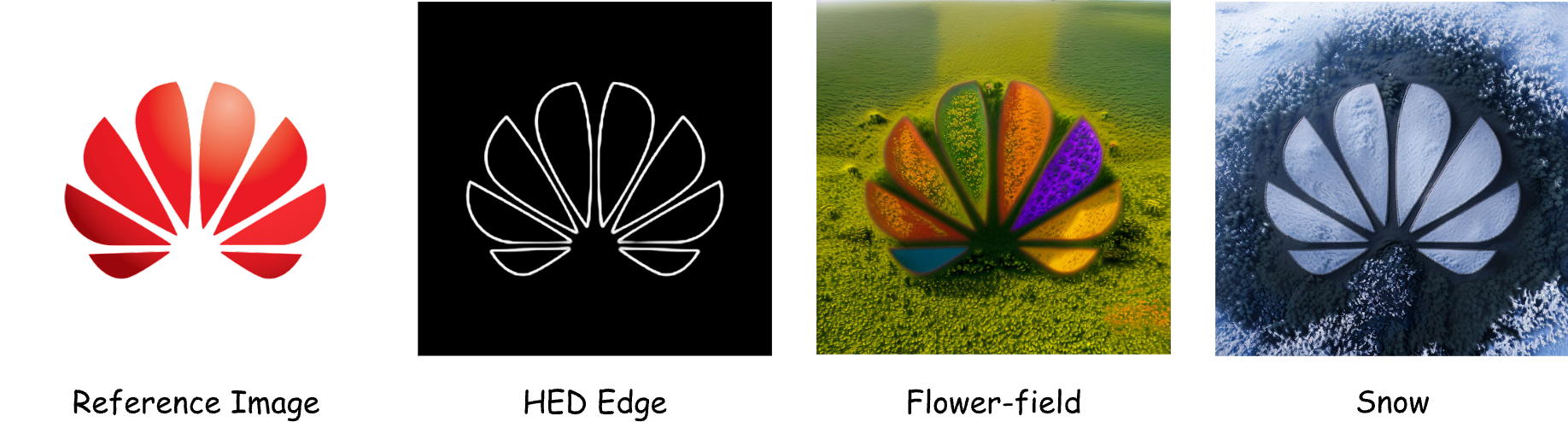

ControlNet

来自PIXART-α的ControlNet定制样本。使用参考图像生成相应的HED边缘图像,并将其作为PIXART-α ControlNet的控制信号。

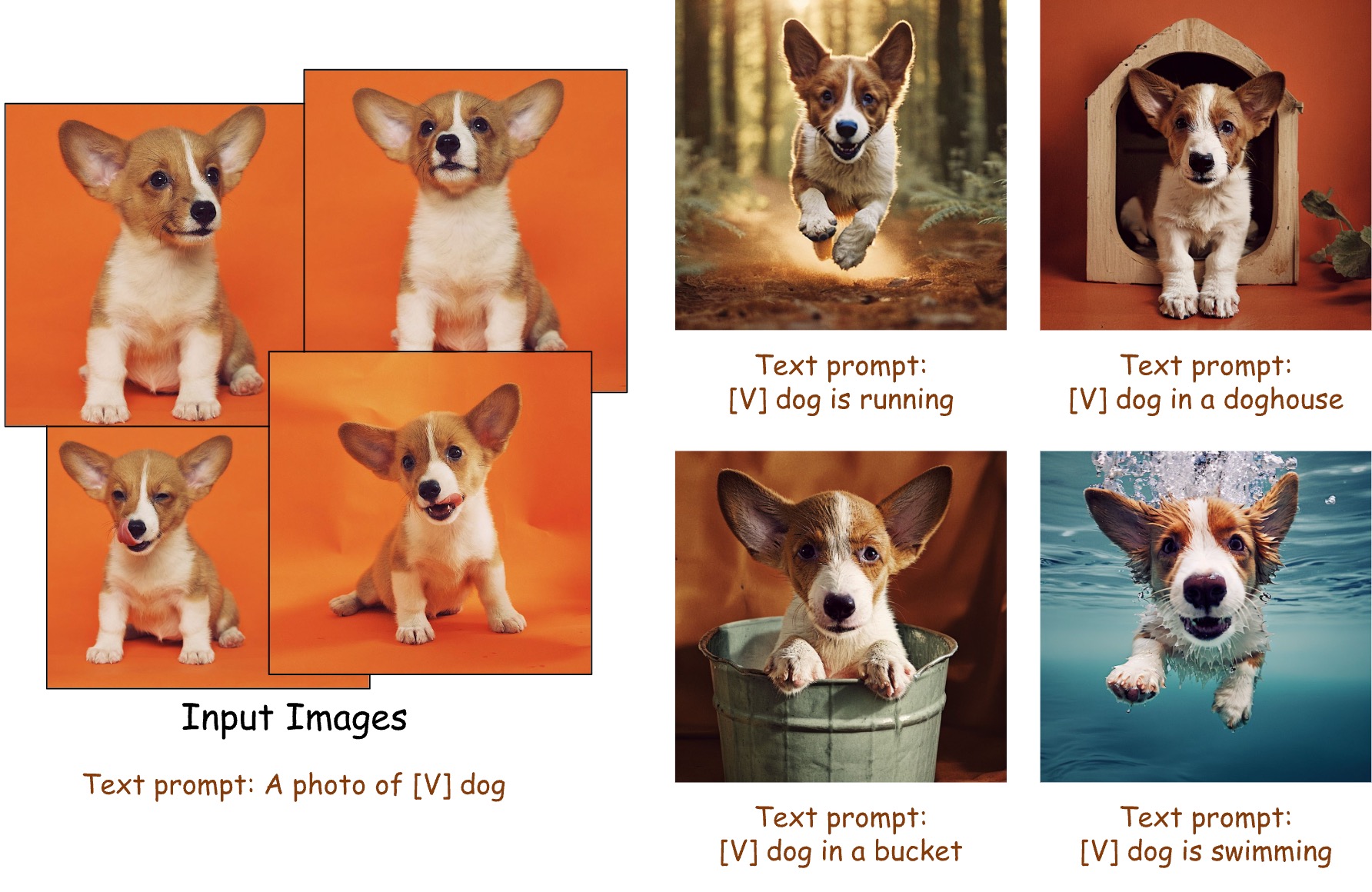

DreamBooth

PIXART-α可以与Dreambooth结合使用。在给定少量图像和文本提示的情况下,PIXART-α可以生成高保真图像,表现出与环境的自然交互,精确修改物体颜色。

更多效果

写在最后,PixArt-α的相关知识就为大家介绍到这里,后续会给大家带来华为最新的PixArt-Σ的相关文章介绍,敬请期待!也欢迎大家点击下方卡片,关注“AIGC Studio”!一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、Stable Diffusion、Sora等相关技术,欢迎一起交流学习💗~