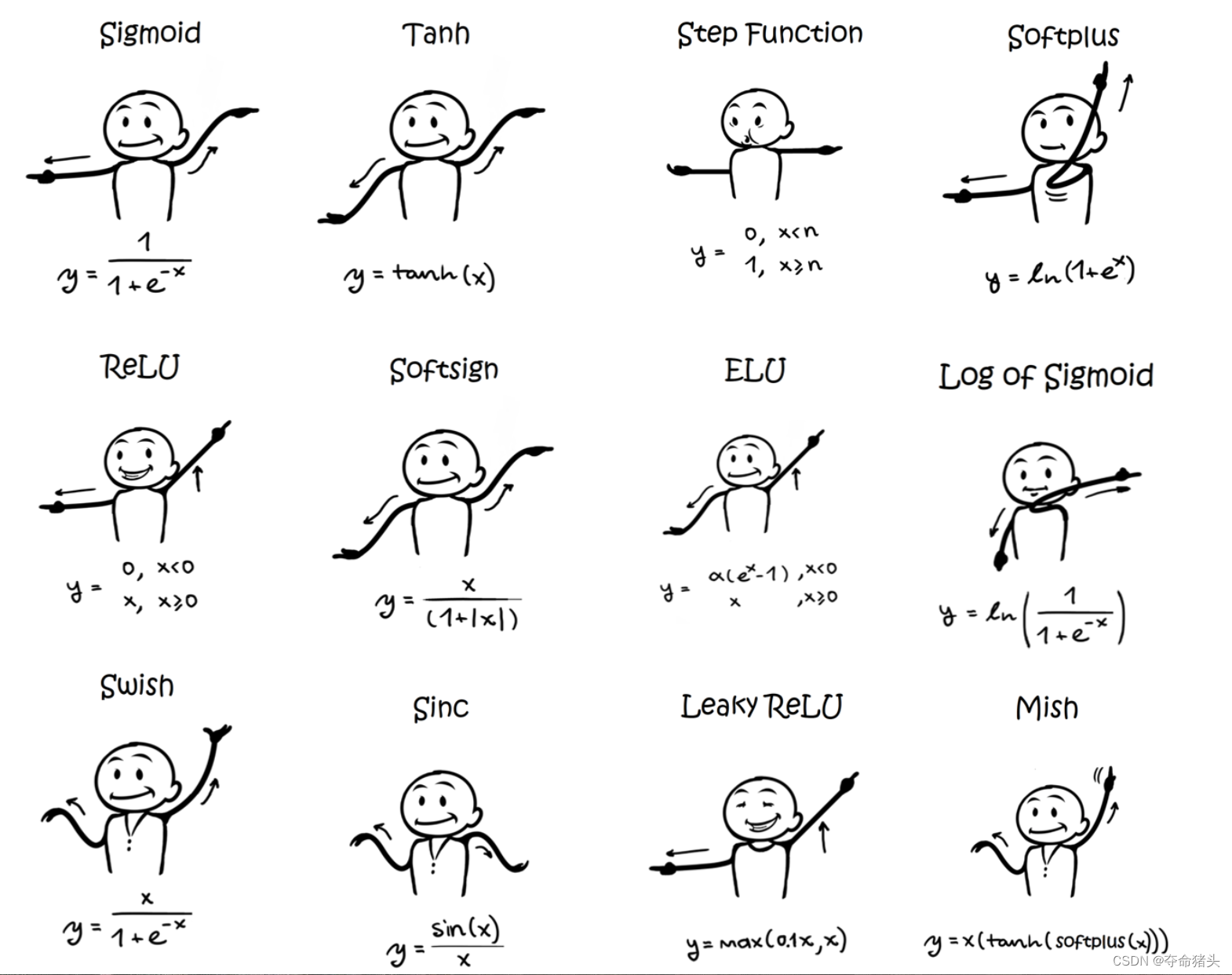

激活函数大汇总列表(持续更新中…)

欢迎来到我们深入探索神经网络核心组成部分——激活函数的系列博客。在人工智能的世界里,激活函数扮演着不可或缺的角色,它们决定着神经元的输出,并且影响着网络的学习能力与表现力。鉴于激活函数的重要性和多样性,我们将通过一系列博客详细介绍各类激活函数,持续更新中。

请点击每个激活函数旁边的“”链接,以获取有关每种激活函数的详细信息,包括其数学表达式、优缺点、实现代码以及在实际应用中的表现。

- Sigmoid -

- Tanh -

- ReLU -

- Leaky ReLU -

- PReLU -

- ELU -

- SELU -

- Swish -

- GELU -

- Softmax -

- Softplus -

限于笔者水平,对于本博客存在的纰漏和错误,欢迎大家留言指正,我将不断更新。