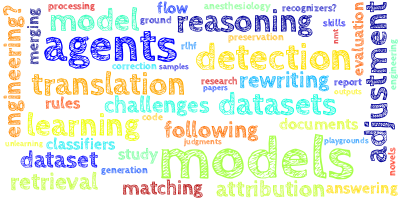

AI视野·今日CS.NLP 自然语言处理论文速览

Wed, 6 Mar 2024

Totally 74 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| MAGID: An Automated Pipeline for Generating Synthetic Multi-modal Datasets Authors Hossein Aboutalebi, Hwanjun Song, Yusheng Xie, Arshit Gupta, Justin Sun, Hang Su, Igor Shalyminov, Nikolaos Pappas, Siffi Singh, Saab Mansour 缺乏丰富的多模式文本、图像对话数据阻碍了多模式交互系统的发展,而法学硕士需要大量这些数据。以前的方法通过检索到的图像来增强文本对话,从而带来隐私、多样性和质量限制。在这项工作中,我们介绍了textbf Multimodal textbf Augmented textbf G enerative textbf I images textbf Dialogues MAGID,一个用多样化和高质量图像增强纯文本对话的框架。随后,应用扩散模型来制作相应的图像,确保与识别的文本对齐。最后,MAGID 在图像描述生成模块文本 LLM 和解决美学、图像文本匹配和安全性的图像质量模块之间集成了创新的反馈循环,它们协同工作以生成高质量和多模式对话。我们使用自动和人工评估,在三个对话数据集上将 MAGID 与其他 SOTA 基线进行比较。 |

| Reliable, Adaptable, and Attributable Language Models with Retrieval Authors Akari Asai, Zexuan Zhong, Danqi Chen, Pang Wei Koh, Luke Zettlemoyer, Hannaneh Hajishirzi, Wen tau Yih 参数语言模型 LM 经过大量网络数据的训练,表现出卓越的灵活性和功能。然而,他们仍然面临着幻觉、难以适应新数据分布、缺乏可验证性等实际挑战。在这篇立场文件中,我们主张使用检索增强型语言模型来取代参数型语言模型,成为下一代语言模型。通过在推理过程中合并大规模数据存储,检索增强型语言模型可以更加可靠、适应性强且可归因。尽管具有潜力,但由于一些具体障碍,检索增强型 LM 尚未得到广泛采用,当前的检索增强型 LM 很难利用知识密集型任务(例如回答问题)之外的有用文本,检索和 LM 组件之间的交互有限,并且缺乏基础设施用于缩放。为了解决这些问题,我们提出了开发通用检索增强型语言模型的路线图。 |

| PARADISE: Evaluating Implicit Planning Skills of Language Models with Procedural Warnings and Tips Dataset Authors Arda Uzuno lu, Abdalfatah Rashid Safa, G zde G l ahin 最近,社区内对于大型语言模型是否能够规划或执行计划越来越感兴趣。然而,大多数先前的研究使用法学硕士为缺乏语言复杂性和领域多样性的简化场景生成高级计划,限制了对其规划能力的分析。这些设置限制了评估方法(例如预定义的动作空间)、架构选择(例如仅限生成模型),并且忽略了现实分析所必需的语言细微差别。为了解决这个问题,我们提出了 PARADISE,这是一项使用 Q A 格式对来自 wikiHow 的实际程序文本进行的溯因推理任务。它涉及与目标直接相关的警告和提示推理任务,不包括中间步骤,目的是测试模型仅从给定目标推断计划隐式知识的能力。我们的实验利用微调语言模型和零样本提示,揭示了在大多数情况下特定于任务的小模型相对于大型语言模型的有效性。尽管取得了进步,但所有模型都未能达到人类的表现。值得注意的是,我们的分析揭示了有趣的见解,例如模型行为因关键词被删除而发生的变化、BERT 系列和 GPT 4 在物理和抽象目标方面的挣扎,以及所提出的任务为其他看不见的程序任务提供了宝贵的先验知识。 |

| Design2Code: How Far Are We From Automating Front-End Engineering? Authors Chenglei Si, Yanzhe Zhang, Zhengyuan Yang, Ruibo Liu, Diyi Yang 近年来,生成式人工智能取得了快速发展,在多模式理解和代码生成方面实现了前所未有的能力。这可以实现前端开发的新范例,其中多模式法学硕士可以直接将视觉设计转换为代码实现。在这项工作中,我们将其形式化为 Design2Code 任务并进行全面的基准测试。具体来说,我们手动策划了 484 个不同的现实世界网页的基准作为测试用例,并开发了一组自动评估指标,以评估当前的多模式 LLM 生成直接呈现到给定参考网页的代码实现的能力(将屏幕截图作为输入) 。我们还通过全面的人工评估来补充自动指标。我们开发了一套多模式提示方法,并在 GPT 4V 和 Gemini Pro Vision 上展示了它们的有效性。我们进一步微调开源 Design2Code 18B 模型,成功匹配 Gemini Pro Vision 的性能。人工评估和自动指标均表明,与其他模型相比,GPT 4V 在此任务上表现最佳。此外,注释者认为 GPT 4V 生成的网页在视觉外观和内容方面可以在 49 例中取代原始参考网页,也许令人惊讶的是,在 64 例中 GPT 4V 生成的网页被认为比原始参考网页更好。 |

| CoGenesis: A Framework Collaborating Large and Small Language Models for Secure Context-Aware Instruction Following Authors Kaiyan Zhang, Jianyu Wang, Ermo Hua, Biqing Qi, Ning Ding, Bowen Zhou 随着语言模型 LM 的进步,它们对私人数据的暴露越来越不可避免,并且它们的部署,尤其是个人设备(例如 PC 和智能手机)上的小型模型,已成为一种流行趋势。在充满用户信息的环境中,使模型能够保护用户隐私并有效执行命令成为一项重要的研究当务之急。在本文中,我们提出了 CoGenesis,一种协作生成框架,集成了云基础设施上的大型托管和本地设备上部署的小型模型,以逻辑地解决隐私问题。最初,我们设计了一个管道来创建个性化的写作指导数据集,其中包含丰富的上下文细节,作为本研究问题的测试平台。随后,我们介绍了分别基于 sketch 和 logits 的 CoGenesis 的两个变体。我们的实验结果基于我们的合成数据集和两个额外的开源数据集,表明 1 大型模型在提供用户上下文时表现良好,但在缺乏此类上下文时表现不佳。 2 虽然在合成数据集上进行微调的专用较小模型显示出了希望,但它们仍然落后于较大的模型。 |

| Angry Men, Sad Women: Large Language Models Reflect Gendered Stereotypes in Emotion Attribution Authors Flor Miriam Plaza del Arco, Amanda Cercas Curry, Alba Curry, Gavin Abercrombie, Dirk Hovy 大型语言模型法学硕士反映了社会规范和偏见,尤其是关于性别的规范和偏见。尽管社会偏见和刻板印象已在各种 NLP 应用中得到广泛研究,但情感分析仍存在令人惊讶的差距。然而,情感和性别在社会话语中密切相关。例如,女性通常被认为更具同理心,而男性的愤怒更容易被社会接受。为了填补这一空白,我们在五个最先进的开源和闭源法学硕士中首次提出了性别情感归因的全面研究。我们调查情绪是否有性别差异,以及这些差异是否基于社会刻板印象。我们提示模型采用性别角色,并将情绪归因于事件,例如当我与亲爱的人发生严重争执时。然后,我们分析模型产生的与性别事件对相关的情绪。我们发现,受性别刻板印象的影响,所有模特都始终表现出性别情感。这些发现与心理学和性别研究的既定研究一致。我们的研究揭示了语言、性别和情感之间复杂的社会相互作用。 |

| "In Dialogues We Learn": Towards Personalized Dialogue Without Pre-defined Profiles through In-Dialogue Learning Authors Chuanqi Cheng, Quan Tu, Wei Wu, Shuo Shang, Cunli Mao, Zhengtao Yu, Rui Yan 近年来,个性化对话系统因其能够根据不同角色生成响应的能力而受到广泛关注。然而,大多数现有方法依赖于预先定义的个人资料,这不仅耗时耗力,而且缺乏灵活性。我们提出了“对话学习 IDL”,这是一个微调框架,可增强预先训练的大型语言模型的能力,以利用对话历史来表征角色,从而在没有预定义配置文件的情况下完成个性化对话生成任务。我们在三个数据集上的实验表明,IDL 带来了实质性的改进,BLEU 和 ROUGE 分数分别提高了 200 和 247。 |

| KnowAgent: Knowledge-Augmented Planning for LLM-Based Agents Authors Yuqi Zhu, Shuofei Qiao, Yixin Ou, Shumin Deng, Ningyu Zhang, Shiwei Lyu, Yue Shen, Lei Liang, Jinjie Gu, Huajun Chen 大型语言模型法学硕士在复杂的推理任务中表现出了巨大的潜力,但在应对更复杂的挑战时,尤其是在通过生成可执行操作与环境交互时,它们表现不佳。这种不足主要源于语言代理缺乏内置的动作知识,无法有效指导任务解决过程中的规划轨迹,导致规划幻觉。为了解决这个问题,我们引入了 KnowAgent,这是一种新颖的方法,旨在通过结合明确的行动知识来增强法学硕士的规划能力。具体来说,KnowAgent采用动作知识库和知识自学习策略来约束规划过程中的动作路径,从而实现更合理的轨迹合成,从而提高语言代理的规划性能。基于各种骨干模型的 HotpotQA 和 ALFWorld 的实验结果表明,KnowAgent 可以实现与现有基线相当或更好的性能。进一步的分析表明 KnowAgent 在规划幻觉缓解方面的有效性。 |

| Detecting Concrete Visual Tokens for Multimodal Machine Translation Authors Braeden Bowen, Vipin Vijayan, Scott Grigsby, Timothy Anderson, Jeremy Gwinnup 多模态机器翻译 MMT 系统中视觉基础和屏蔽的挑战鼓励采用不同的方法来检测和选择用于屏蔽的视觉基础文本标记。我们引入了从源句子中检测视觉和上下文相关的具体标记的新方法,包括使用自然语言处理 NLP 进行检测、使用对象检测进行检测以及联合检测验证技术。我们还引入了选择检测到的标记的新方法,包括最短的 n 个标记、最长的 n 个标记和所有检测到的具体标记。 |

| Adding Multimodal Capabilities to a Text-only Translation Model Authors Vipin Vijayan, Braeden Bowen, Scott Grigsby, Timothy Anderson, Jeremy Gwinnup 虽然当前多模态机器翻译 MMT 的大多数工作都使用 Multi30k 数据集进行训练和评估,但我们发现生成的模型与 Multi30k 数据集的过度拟合达到了极端程度。因此,当针对典型的纯文本测试集(例如 WMT 新闻测试数据集)进行评估时,这些模型的表现非常糟糕。为了在 Multi30k 和典型的纯文本数据集上都有良好的表现,我们使用高性能的纯文本机器翻译 MT 模型作为 MMT 模型的起点。 |

| Learning to Use Tools via Cooperative and Interactive Agents Authors Zhengliang Shi, Shen Gao, Xiuyi Chen, Lingyong Yan, Haibo Shi, Dawei Yin, Zhumin Chen, Pengjie Ren, Suzan Verberne, Zhaochun Ren 工具学习使大型语言模型法学硕士能够作为代理使用外部工具来扩展其能力。现有方法采用一个基于 LLM 的代理来迭代选择和执行工具,然后将结果合并到下一个动作预测中。然而,在处理复杂任务时,它们仍然面临潜在的性能下降问题,这是由于 1 单个法学硕士执行不同操作的固有能力的限制,以及 2 当任务失败时难以自适应地纠正错误。为了缓解这些问题,我们提出了 ConAgents,这是一个协作和交互式代理框架,它将工具学习的工作流程模块化为基础代理、执行代理和观察代理。我们还引入了迭代校准 IterCali 方法,使代理能够根据工具环境的反馈进行自我调整。在三个数据集上进行的实验证明了我们的 ConAgents 的优越性,例如,比 SOTA 基线提高了 6 个点。 |

| Socratic Reasoning Improves Positive Text Rewriting Authors Anmol Goel, Nico Daheim, Iryna Gurevych 将消极想法重新定义为积极想法是心理健康和心理治疗的几种认知方法的关键,通过基于大型语言模型的解决方案可以使这些方法变得更容易实现。这种重新构建通常是不平凡的,需要多个合理化步骤来揭示消极想法的根本问题并将其转变为更加积极的。然而,这一合理化过程目前被一步重构思想的数据集和模型所忽视。在这项工作中,我们通过使用名为 textsc SocraticReframe 的新颖框架,通过综合生成的苏格拉底基本原理来增强开源数据集,以进行积极的文本重写,从而解决了这一差距。 textsc SocraticReframe 使用一系列问题答案对来合理化思维重写过程。 |

| The Case for Evaluating Multimodal Translation Models on Text Datasets Authors Vipin Vijayan, Braeden Bowen, Scott Grigsby, Timothy Anderson, Jeremy Gwinnup 一个好的评估框架应该通过测量 1 使用视觉信息来辅助翻译任务以及 2 翻译复杂句子(例如纯文本机器翻译)的能力来评估多模态机器翻译 MMT 模型。然而,MMT 目前的大多数工作都是根据 Multi30k 测试集进行评估的,该测试集不测量这些属性。也就是说,MMT 模型对视觉信息的使用不能直接从 Multi30k 测试集结果中显示,并且 Multi30k 中的句子是图像标题,即简短的描述性句子,而不是典型的纯文本机器翻译模型的复杂句子 |

| Data Augmentation using LLMs: Data Perspectives, Learning Paradigms and Challenges Authors Bosheng Ding, Chengwei Qin, Ruochen Zhao, Tianze Luo, Xinze Li, Guizhen Chen, Wenhan Xia, Junjie Hu, Anh Tuan Luu, Shafiq Joty 在快速发展的机器学习 ML 领域,数据增强 DA 已成为一种关键技术,可通过多样化训练示例来增强模型性能,而无需额外的数据收集。这项调查探讨了大型语言模型法学硕士对 DA 的变革性影响,特别是解决它们在自然语言处理 NLP 及其他领域所带来的独特挑战和机遇。从数据角度和学习角度来看,我们研究了利用大型语言模型进行数据增强的各种策略,包括对学习范式的新颖探索,其中法学硕士生成的数据用于进一步训练。此外,本文还描述了该领域面临的主要挑战,从可控数据增强到多模态数据增强。 |

| A General and Flexible Multi-concept Parsing Framework for Multilingual Semantic Matching Authors Dong Yao, Asaad Alghamdi, Qingrong Xia, Xiaoye Qu, Xinyu Duan, Zhefeng Wang, Yi Zheng, Baoxing Huai, Peilun Cheng, Zhou Zhao 句子语义匹配是自然语言处理的研究热点,在社区问答、搜索、聊天机器人、推荐等各种关键场景中具有重要意义。由于大多数先进模型直接对两个句子之间的单词之间的语义相关性进行建模,而忽略了它们的 textit 关键字和 textit 意图概念,因此提出 DC Match 将关键字与意图分离,并利用它们来优化匹配性能。尽管DC Match是一种简单而有效的语义匹配方法,但它高度依赖外部NER技术来识别句子的关键词,这限制了小语种语义匹配的性能,因为通常很难获得令人满意的NER工具。在本文中,我们建议通用且灵活地将文本解析为多概念以进行多语言语义匹配,以将模型从对NER模型的依赖中解放出来。为此,我们基于预训练的语言模型设计了一个下划线多下划线概念下划线解析下划线语义下划线匹配框架,缩写为textbf MCP SM,以提取各种概念并将其注入分类标记中。我们对英文数据集 QQP 和 MRPC 以及中文数据集 Medical SM 进行了全面的实验。 |

| Evidence-Focused Fact Summarization for Knowledge-Augmented Zero-Shot Question Answering Authors Sungho Ko, Hyunjin Cho, Hyungjoo Chae, Jinyoung Yeo, Dongha Lee 最近的研究调查了利用知识图谱知识图谱来增强大型语言模型法学硕士的问答 QA 性能,但结构化知识图谱表达仍然具有挑战性。现有的方法,例如三重形式或三重形式事实的自由形式文本转换,遇到了几个问题。其中包括由于重复的实体或关系而导致证据密度降低,以及由于无法强调关键证据而降低证据清晰度。为了解决这些问题,我们提出了 EFSum,这是一种以证据为中心的事实总结框架,用于通过知识增强的法学硕士来增强质量保证。我们通过蒸馏和偏好调整来优化开源法学硕士作为事实总结器。 |

| SimuCourt: Building Judicial Decision-Making Agents with Real-world Judgement Documents Authors Zhitao He, Pengfei Cao, Chenhao Wang, Zhuoran Jin, Yubo Chen, Jiexin Xu, Huaijun Li, Xiaojian Jiang, Kang Liu, Jun Zhao 随着深度学习的发展,自然语言处理技术有效提升了传统司法行业各方面的效率。然而,目前大多数努力仅关注个别司法阶段,忽视了跨阶段合作。随着大型语言模型支持的自主代理变得越来越聪明,能够在现实世界环境中做出复杂的决策,为司法情报提供了新的见解。在本文中,1我们介绍了 SimuCourt,这是一个司法基准,包含来自现实世界的 420 份判决文件,涵盖三种最常见的司法案件类型,以及一个新的任务“司法决策”,用于评估代理人的司法分析和决策能力。为了支持这项任务,我们构建了一个包含多种法律知识的大型司法知识库 JudicialKB。 2 我们提出了一个新颖的多代理框架,AgentsCourt。我们的框架遵循现实世界经典法庭审判流程,由法庭辩论模拟、法律信息检索和判决细化组成,以模拟法官的决策。 |

| Benchmarking the Text-to-SQL Capability of Large Language Models: A Comprehensive Evaluation Authors Bin Zhang, Yuxiao Ye, Guoqing Du, Xiaoru Hu, Zhishuai Li, Sun Yang, Chi Harold Liu, Rui Zhao, Ziyue Li, Hangyu Mao 大型语言模型法学硕士已成为推进文本到 SQL 任务的强大工具,其性能显着优于传统方法。然而,作为一个新兴的研究领域,最佳的提示模板和设计框架仍然没有达成共识。 |

| AIx Speed: Playback Speed Optimization Using Listening Comprehension of Speech Recognition Models Authors Kazuki Kawamura, Jun Rekimoto 由于人类收听音频和观看视频的速度比实际观察到的速度更快,因此我们经常以更高的播放速度收听或观看这些内容,以提高内容理解的时间效率。为了进一步利用这种功能,已经开发了根据用户状况和内容类型自动调整播放速度的系统,以帮助更有效地理解时间序列内容。然而,这些系统仍然有空间进一步扩展人类的速度聆听能力,通过生成具有针对更精细的时间单位优化的播放速度的语音并将其提供给人类。在这项研究中,我们确定人类是否可以听到优化后的语音,并提出了一种系统,该系统可以以小至音素的单位自动调整播放速度,同时确保语音清晰度。该系统使用语音识别器分数作为人类听到特定语音单元的程度的代理,并将语音播放速度最大化到人类可以听到的程度。这种方法可用于产生快速但易懂的语音。 |

| RulePrompt: Weakly Supervised Text Classification with Prompting PLMs and Self-Iterative Logical Rules Authors Miaomiao Li, Jiaqi Zhu, Yang Wang, Yi Yang, Yilin Li, Hongan Wang 弱监督文本分类 WSTC,也称为零样本或无数据文本分类,由于其在动态和开放的 Web 环境中对大量文本进行分类的适用性而受到越来越多的关注,因为它只需要一组有限的种子词标签名称即可每个类别而不是标记数据。借助最近流行的提示预训练语言模型 PLM,许多研究利用手动制作和/或自动识别的语言器来估计类别的可能性,但他们未能区分这些类别指示词的效果,更不用说捕获它们的相关性并实现根据未标记语料库进行自适应调整。在本文中,为了让 PLM 有效地理解每个类别,我们首先提出了一种新的基于规则的知识形式,使用逻辑表达式来表征类别的含义。然后,我们为 WSTC 任务开发了一种基于 PLM 的提示方法,名为 RulePrompt,该方法由规则挖掘模块和规则增强型伪标签生成模块组成,再加上一个自监督微调模块,以使 PLM 与该任务保持一致。在这个框架内,分配给文本的不准确的伪标签和与类别相关的不精确的逻辑规则以另一种方式相互增强。建立了一个以种子词为起点的知识规则获取和利用的自我迭代闭环。大量的实验验证了我们方法的有效性和鲁棒性,该方法明显优于最先进的弱监督方法。 |

| A Second Look on BASS -- Boosting Abstractive Summarization with Unified Semantic Graphs -- A Replication Study Authors Osman Alperen Kora , J rg Schl tterer, Christin Seifert 我们提出了 BASS 框架的详细复制研究,这是一个基于统一语义图概念的抽象摘要系统。我们的研究包括复制关键组件方面的挑战以及一项消融研究,以系统地隔离源于复制新组件的错误源。我们的研究结果表明,与原始作品相比,性能存在差异。 |

| Demonstrating Mutual Reinforcement Effect through Information Flow Authors Chengguang Gan, Xuzheng He, Qinghao Zhang, Tatsunori Mori 相互强化效应 MRE 研究文本分类任务中单词级别和文本级别分类之间的协同关系。它假设两个分类级别的性能可以相互增强。然而,这种机制在先前的研究中尚未得到充分证明或解释。为了解决这一差距,我们采用信息流分析来观察和证实 MRE 理论。我们对六个 MRE 混合数据集的实验揭示了模型中 MRE 的存在及其影响。此外,我们还进行了微调实验,其结果与信息流实验的结果一致。两个实验结果的融合证实了 MRE 的存在。此外,我们将 MRE 的应用扩展到提示学习,利用单词级信息作为语言表达器来支持模型对文本级分类标签的预测。 |

| Zero-Shot Cross-Lingual Document-Level Event Causality Identification with Heterogeneous Graph Contrastive Transfer Learning Authors Zhitao He, Pengfei Cao, Yubo Chen, Kang Liu, Zhiqiang Zhang, Mengshu Sun, Jun Zhao 事件因果关系识别ECI是指检测文本中事件之间的因果关系。然而,大多数现有研究都集中在具有高资源语言的句子级 ECI,而对具有低资源语言的更具挑战性的文档级 ECI DECI 则有待探索。在本文中,我们提出了一种用于零样本跨语言文档级 ECI 的具有多粒度对比迁移学习 GIMC 的异构图交互模型。具体来说,我们引入了异构图交互网络来模拟分散在文档中的事件之间的长距离依赖关系。然后,为了提高从源语言学习的因果知识的跨语言可迁移性,我们提出了一种多粒度对比迁移学习模块来对齐跨语言的因果表示。大量实验表明,我们的框架在单语言和多语言场景下的平均 F1 分数分别比之前最先进的模型高出 9.4 和 8.2。 |

| In Search of Truth: An Interrogation Approach to Hallucination Detection Authors Yakir Yehuda, Itzik Malkiel, Oren Barkan, Jonathan Weill, Royi Ronen, Noam Koenigstein 尽管大型语言模型法学硕士取得了许多进步及其前所未有的快速发展,但由于各种原因,它们对我们日常生活各个方面的影响和融入仍然有限。阻碍其广泛采用的一个关键因素是幻觉的出现,法学硕士发明的答案听起来很现实,但却偏离了事实真相。在本文中,我们提出了一种在大型语言模型中检测幻觉的新方法,该方法解决了在各种现实世界场景中采用这些模型的关键问题。通过对多个数据集和法学硕士(包括 Llama 2)的广泛评估,我们研究了最近各种法学硕士的幻觉水平,并证明了我们自动检测它们的方法的有效性。 |

| MathScale: Scaling Instruction Tuning for Mathematical Reasoning Authors Zhengyang Tang, Xingxing Zhang, Benyou Wan, Furu Wei 大型语言模型法学硕士在解决问题方面表现出了卓越的能力。然而,他们解决数学问题的能力仍然不足。我们提出了 MathScale,这是一种简单且可扩展的方法,可以使用前沿 LLM(例如 tt GPT 3.5)创建高质量的数学推理数据。受人类数学学习认知机制的启发,它首先从种子数学问题中提取主题和知识点,然后构建概念图,随后用于生成新的数学问题。 MathScale 沿着我们生成的数学数据集的大小轴展示了有效的可扩展性。因此,我们创建了一个包含 200 万数学问题答案对的数学推理数据集 MathScaleQA。为了全面评估法学硕士的数学推理能力,我们构建了数学应用题基准 sc MwpBench,它是包括 GSM8K 和 MATH 在内的 10 个数据集的集合,涵盖 K 12、大学和竞赛级别的数学问题。我们应用 MathScaleQA 来微调开源 LLM,例如 LLaMA 2 和 Mistral,从而显着提高数学推理能力。 |

| An Empirical Study of LLM-as-a-Judge for LLM Evaluation: Fine-tuned Judge Models are Task-specific Classifiers Authors Hui Huang, Yingqi Qu, Jing Liu, Muyun Yang, Tiejun Zhao 最近,利用大型语言模型法学硕士来评估其他法学硕士的质量的趋势越来越明显。许多研究都采用专有的闭源模型(尤其是 GPT4)作为评估器。或者,其他作品也有基于开源法学硕士作为评估器的微调判断模型。在本研究中,我们对不同法官模型的评估能力进行了实证研究。 |

| DPPA: Pruning Method for Large Language Model to Model Merging Authors Yaochen Zhu, Rui Xia, Jiajun Zhang 模型合并是将来自多个领域的微调模型结合起来,旨在增强模型跨多个领域的熟练程度。主要关注的是参数冲突的解决。大量现有研究在合并阶段解决了这个问题,最新的研究重点是在整个修剪阶段解决这个问题。当 DARE 方法应用于简单的微调模型时,它表现出了有希望的结果。然而,当用于复杂的微调模型时,该方法的功效往往会减弱,这些模型相对于基线模型显示出显着的参数偏差。在本文中,我们介绍了一种称为动态修剪分区放大 DPPA 的双阶段方法,旨在解决合并复杂微调模型的挑战。首先,我们引入动态剪枝DP,这是一种基于幅度剪枝的改进方法,其目的是在更高的剪枝率下提高性能。随后,我们提出动态分区放大 DPA,一种重新缩放策略,旨在动态放大与其显着性水平相关的参数分区。实验结果表明,我们的方法仅保留 20 个领域特定参数,但其性能可与保留多达 90 个参数的其他方法相媲美。此外,我们的方法在剪枝后表现出出色的性能,使模型合并的性能显着提高了近 20 个。 |

| In-Memory Learning: A Declarative Learning Framework for Large Language Models Authors Bo Wang, Tianxiang Sun, Hang Yan, Siyin Wang, Qingyuan Cheng, Xipeng Qiu 探索智能体是否可以在不依赖人类标记数据的情况下与环境保持一致,这是一个有趣的研究课题。从智能生物体中观察到的排列过程中汲取灵感,其中陈述性记忆在总结过去的经验中发挥着关键作用,我们提出了一种新颖的学习框架。代理熟练地从过去的经验中提取见解,完善和更新现有笔记,以提高他们在环境中的表现。整个过程发生在记忆组件内,并通过自然语言实现,因此我们将这个框架称为记忆学习。我们还深入研究了旨在评估自我改进过程的基准的关键特征。 |

| Role Prompting Guided Domain Adaptation with General Capability Preserve for Large Language Models Authors Rui Wang, Fei Mi, Yi Chen, Boyang Xue, Hongru Wang, Qi Zhu, Kam Fai Wong, Ruifeng Xu 人们对专业应用程序的大型语言模型法学硕士的兴趣日益浓厚,这揭示了在针对特定领域进行定制时面临的重大挑战,法学硕士往往会经历灾难性的遗忘,从而损害其一般能力并导致次优的用户体验。此外,同时为多个领域构建通用模型通常会由于领域之间的混乱而导致整体性能下降。针对这些问题,我们提出了Role Prompting Guided Multi Domain Adaptation REGA策略。这种新颖的方法通过三个关键组件有效地管理多领域 LLM 适应:1 自蒸馏构建和重放一般领域范例以减轻灾难性遗忘。 2 角色提示为一般域分配一个中央提示,为每个特定域分配一个独特的角色提示,以最大程度地减少训练期间域间的混乱。 3 角色集成将一小部分领域特定数据复用并集成到通用领域数据中,在中心提示的指导下进行训练。中央提示用于简化推理过程,无需为不同领域切换提示。实证结果表明,REGA 有效缓解了灾难性遗忘和领域间混乱。 |

| Towards Training A Chinese Large Language Model for Anesthesiology Authors Zhonghai Wang, Jie Jiang, Yibing Zhan, Bohao Zhou, Yanhong Li, Chong Zhang, Liang Ding, Hua Jin, Jun Peng, Xu Lin, Weifeng Liu 医学大语言模型法学硕士由于其显着的实用性而最近受到欢迎。然而,现有研究大多集中于普通医学,需要对麻醉学等特定领域的法学硕士进行深入研究。为了填补这一空白,我们引入了 Hypnos,这是一种基于现有法学硕士(例如 Llama)的中国麻醉模型。 Hypnos 的贡献有三个方面 1 从当前法学硕士获得的数据(例如利用自我指导)可能包含不准确之处。 Hypnos 实施交叉过滤策略来提高数据质量。该策略涉及使用一个法学硕士来评估另一个法学硕士生成的数据的质量并过滤掉质量较低的数据。 2 Hypnos 采用从一般到具体的培训策略,首先使用一般医学数据微调法学硕士,然后使用专门来自麻醉学的数据改进微调的法学硕士。一般医学数据补充了麻醉学的医学专业知识,并提高了催眠生成的有效性。 3 我们引入了评估麻醉学医学法学硕士的标准化基准。我们的基准包括来自互联网的公开实例和来自医院的私人获取的实例。 |

| Causal Prompting: Debiasing Large Language Model Prompting based on Front-Door Adjustment Authors Congzhi Zhang, Linhai Zhang, Deyu Zhou, Guoqiang Xu 尽管现有的提示方法在大型语言模型法学硕士的上下文学习和思维链等方面取得了显着的成就,但它们仍然面临着各种偏见的挑战。传统的去偏差方法主要集中在模型训练阶段,包括基于数据增强和基于重新加权的方法,但在解决法学硕士的复杂偏差方面存在局限性。为了解决这些局限性,利用结构因果模型揭示了提示方法背后的因果关系,并提出了一种基于前门调整的新型因果提示方法,以有效减轻法学硕士的偏差。具体来说,因果干预是通过设计提示来实现的,无需访问LLM的参数和logits。以LLM产生的思维链作为中介变量,通过前门计算输入提示与输出答案之间的因果效应。调整以减轻模型偏差。此外,为了精确地获得样本的表示并更准确地估计因果效应,通过将编码器的空间与LLM对齐,使用对比学习来微调样本的编码器。 |

| HARGPT: Are LLMs Zero-Shot Human Activity Recognizers? Authors Sijie Ji, Xinzhe Zheng, Chenshu Wu 关于大型语言模型法学硕士作为与网络物理系统 CPS 无缝集成以解释物理世界的基础模型的潜力,一直存在争论。在本文中,我们进行了一个案例研究来回答以下问题:法学硕士是否能够进行零样本人类活动识别 HAR。我们的研究 HARGPT 通过证明法学硕士可以理解原始 IMU 数据并仅在适当的提示下以零射击方式执行 HAR 任务,从而给出了肯定的答案。 HARGPT 将原始 IMU 数据输入 LLM,并利用角色扮演和逐步思考策略进行提示。我们使用两个具有不同类间相似性的公共数据集在 GPT4 上对 HARGPT 进行基准测试,并比较基于传统机器学习和最先进的深度分类模型的各种基线。值得注意的是,法学硕士成功地从原始 IMU 数据中识别人类活动,并始终优于两个数据集的所有基线。 |

| DP-CRE: Continual Relation Extraction via Decoupled Contrastive Learning and Memory Structure Preservation Authors Mengyi Huang, Meng Xiao, Ludi Wang, Yi Du 连续关系提取 CRE 旨在从非平稳数据流中增量学习关系知识。由于引入新的关系任务可能会掩盖以前学到的信息,因此灾难性遗忘成为该领域的一个重大挑战。当前基于重放的训练范例统一优先考虑所有数据,并通过多轮训练内存样本,这将导致旧任务过度拟合,并且由于重放集的不平衡而对新任务产生明显的偏见。为了解决这个问题,我们引入了 DecouPled CRE DP CRE 框架,该框架将先前信息保存和新知识获取的过程解耦。该框架检查了随着新关系类的出现而发生的嵌入空间的变化,从而明确地管理知识的保存和获取。 |

| Crossing Linguistic Horizons: Finetuning and Comprehensive Evaluation of Vietnamese Large Language Models Authors Sang T. Truong, Duc Q. Nguyen, Toan Nguyen, Dong D. Le, Nhi N. Truong, Tho Quan, Sanmi Koyejo 大型语言模型法学硕士的最新进展强调了它们在人工智能发展中的重要性。然而,尽管对多语言数据集进行了广泛的预训练,可用的开源法学硕士在处理越南语方面的效果有限。由于缺乏为越南法学硕士评估量身定制的系统基准数据集和指标,这一挑战变得更加严重。为了缓解这些问题,我们专门针对越南语对法学硕士进行了微调,并开发了一个包含 10 项常见任务和 31 项指标的综合评估框架。我们的评估结果表明,经过微调的法学硕士表现出增强的越南语理解和生成能力。此外,我们的分析表明,具有更多参数的模型可能会引入更多偏差和未校准的输出,而影响 LLM 性能的关键因素是训练或微调数据集的质量。 |

| Android in the Zoo: Chain-of-Action-Thought for GUI Agents Authors Jiwen Zhang, Jihao Wu, Yihua Teng, Minghui Liao, Nuo Xu, Xiao Xiao, Zhongyu Wei, Duyu Tang 大语言模型LLM导致了智能手机自主GUI代理的激增,它们通过预测API的一系列动作来完成自然语言触发的任务。尽管该任务高度依赖于过去的动作和视觉观察,但现有的研究通常很少考虑中间屏幕截图和屏幕操作所执行的语义信息。为了解决这个问题,这项工作提出了被称为 CoAT 的行动思想链,它描述了先前的行动、当前的屏幕,更重要的是,行动思考应该执行哪些行动以及由所选行动导致的结果。我们证明,在现成的法学硕士的零样本设置中,与标准上下文建模相比,CoAT 显着提高了目标进度。为了进一步促进这方面的研究,我们构建了一个基准 Android In The Zoo AitZ ,其中包含 18,643 个屏幕动作对以及动作思维注释链。 |

| Breeze-7B Technical Report Authors Chan Jan Hsu, Chang Le Liu, Feng Ting Liao, Po Chun Hsu, Yi Chang Chen, Da Shan Shiu Breeze 7B 是基于 Mistral 7B 的开源语言模型,旨在满足改进繁体中文语言理解和面向聊天机器人的功能的需求。本技术报告概述了 Breeze 7B 模型的额外预训练、微调和评估阶段。 |

| Causal Walk: Debiasing Multi-Hop Fact Verification with Front-Door Adjustment Authors Congzhi Zhang, Linhai Zhang, Deyu Zhou 传统的多跳事实验证模型很容易依赖于注释工件的虚假相关性,导致无偏数据集上的性能明显下降。在各种去偏见工作中,基于因果推理的方法通过执行理论上保证的去偏见(例如随意干预或反事实推理)而变得流行。然而,现有的基于因果推理的去偏差方法主要将事实验证制定为单跳推理任务来处理浅层偏差模式,无法处理隐藏在多跳证据中的复杂偏差模式。为了应对这一挑战,我们提出了 Causal Walk,这是一种通过前门调整从因果角度消除多跳事实验证偏差的新颖方法。具体来说,在结构因果模型中,引入处理输入主张证据图和结果真实性标签之间的推理路径作为中介以阻止混杂因素。通过前门调整,将处理与结果之间的因果效应分解为应用随机游走思想估计的处理与中介变量之间的因果效应,以及中介变量与结果之间的因果效应,这是用归一化加权几何平均近似估计的。为了研究所提出方法的有效性,借助大语言模型提出了对抗性多跳事实验证数据集和对称多跳事实验证数据集。实验结果表明,Causal Walk 在现有数据集和新构建的数据集上都优于以前的一些去偏方法。 |

| InjecAgent: Benchmarking Indirect Prompt Injections in Tool-Integrated Large Language Model Agents Authors Qiusi Zhan, Zhixiang Liang, Zifan Ying, Daniel Kang 最近的工作将法学硕士作为代理,允许他们访问工具、执行操作以及与外部内容(例如电子邮件或网站)交互。然而,外部内容引入了间接提示注入 IPI 攻击的风险,其中恶意指令嵌入到 LLM 处理的内容中,旨在操纵这些代理对用户执行有害操作。 |

| Revisiting Meta-evaluation for Grammatical Error Correction Authors Masamune Kobayashi, Masato Mita, Mamoru Komachi 度量是语法纠错 GEC 自动评估的基础,它们对度量元评估的评估依赖于它们与人类判断的相关性。然而,英语 GEC 中的传统元评估遇到了一些挑战,包括评估粒度不一致导致的偏差以及使用经典系统的过时设置。这些问题可能会导致对指标的误解,并可能阻碍 GEC 技术的适用性。为了解决这些问题,本文提出了 SEEDA,一个用于 GEC 元评估的新数据集。 SEEDA 包含基于编辑和基于句子两种不同粒度的人工评分修正,涵盖 12 个最先进的系统,包括大型语言模型 LLM 和两个不同侧重点的人工修正。通过调整句子级元评估中的粒度来改善相关性的结果表明,现有研究中基于编辑的指标可能被低估了。 |

| FinReport: Explainable Stock Earnings Forecasting via News Factor Analyzing Model Authors Xiangyu Li, Xinjie Shen, Yawen Zeng, Xiaofen Xing, Jin Xu 由于现实世界场景中投资者的需求,股票收益预测任务受到了相当多的关注。但与金融机构相比,普通投资者挖掘因素、分析新闻并不容易。另一方面,金融领域的大型语言模型虽然可以以对话机器人的形式为用户服务,但仍然需要用户具备金融知识才能提出合理的问题。 |

| Exploring the Limitations of Large Language Models in Compositional Relation Reasoning Authors Jinman Zhao, Xueyan Zhang 我们通过包含 1,500 个英语测试用例的基准,对大型语言模型法学硕士推理组合关系的能力进行了全面评估,旨在涵盖六种不同类型的组合关系:位置关系、比较关系、个人关系、数学关系、同一关系和其他关系。认识到多语言能力的重要性,我们扩大了评估范围,将这些案例翻译成中文、日语、法语和韩语。 |

| Improving Event Definition Following For Zero-Shot Event Detection Authors Zefan Cai, Po Nien Kung, Ashima Suvarna, Mingyu Derek Ma, Hritik Bansal, Baobao Chang, P. Jeffrey Brantingham, Wei Wang, Nanyun Peng 现有的零样本事件检测方法通常在用已知事件类型注释的数据集上训练模型,并用未见过的事件定义提示它们。这些方法取得了零星的成功,但总体上没有达到预期。在这项工作中,我们的目标是通过训练模型来改进零射击事件检测,以更好地遵循事件定义。我们假设一组不同的事件类型和定义是模型学习遵循事件定义的关键,而现有的事件提取数据集专注于注释少数事件类型的许多高质量示例。为了验证我们的假设,我们构建了一个自动生成的多样化事件定义 DivED 数据集并进行比较研究。我们的实验表明,大量的事件类型200和多样化的事件定义可以显着提高事件提取性能,但另一方面,性能不会随着每个事件类型超过十个示例而扩展。除了扩展之外,我们还在训练过程中结合了事件本体信息和硬负样本,进一步提高了性能。 |

| Eliciting Better Multilingual Structured Reasoning from LLMs through Code Authors Bryan Li, Tamer Alkhouli, Daniele Bonadiman, Nikolaos Pappas, Saab Mansour 大型语言模型的开发 法学硕士在推理方面取得了进展,尽管研究仅限于英语或简单的推理任务。因此,我们引入了一个多语言结构化推理和解释数据集,称为 xSTREET,涵盖六种语言的四项任务。 xSTREET 暴露了英语和非英语推理任务之间 LLM 基础表现的差距。然后,我们提出了两种方法来弥补这一差距,基于这样的见解:受过代码训练的法学硕士是更好的推理者。首先,在训练时,我们使用机器翻译用多语言注释扩充代码数据集,同时保持程序代码不变。其次,在推理时,我们通过采用提示结构来弥合训练和推理之间的差距,该提示结构包含逐步的代码原语来导出新事实并找到解决方案。我们的方法在 xSTREET 上显示出改进的多语言性能,尤其是在科学常识推理子任务上。 |

| Updating the Minimum Information about CLinical Artificial Intelligence (MI-CLAIM) checklist for generative modeling research Authors Brenda Y. Miao, Irene Y. Chen, Christopher YK Williams, Jays n Davidson, Augusto Garcia Agundez, Harry Sun, Travis Zack, Atul J. Butte, Madhumita Sushil 生成模型的最新进展,包括大型语言模型 LLM、视觉语言模型 VLM 和扩散模型,加速了医学中自然语言和图像处理领域的发展,并标志着生物医学模型开发和部署方式的重大范式转变。虽然这些模型高度适应新任务,但扩展和评估它们的使用提出了先前框架中未解决的新挑战。特别是,这些模型能够在几乎没有专门的训练数据、零或很少的射击方法的情况下产生有用的输出,以及它们输出的开放性性质,需要在使用和评估这些模型时制定更新的指南。为了应对美国第 141103 号行政命令和几个新兴国家临床人工智能评估网络确定的临床人工智能工具开发标准和最佳实践方面的差距,我们开始通过建立有关临床人工智能的最低信息来正式制定其中一些指南建模 MI 索赔清单。 MI CLAIM 清单最初于 2020 年制定,提供了一组六个步骤,并提供了鼓励对医学人工智能进行透明、可重复研究所需的最低限度信息的指导。在这里,我们建议对原始清单进行修改,突出显示生成模型与传统临床研究人工智能模型相比在训练、评估、可解释性和可重复性方面的差异。 |

| DACO: Towards Application-Driven and Comprehensive Data Analysis via Code Generation Authors Xueqing Wu, Rui Zheng, Jingzhen Sha, Te Lin Wu, Hanyu Zhou, Mohan Tang, Kai Wei Chang, Nanyun Peng, Haoran Huang 数据分析是生成深入研究和结论性见解以全面回答给定用户对表格数据的查询的关键分析过程。在这项工作中,我们的目标是提出新的资源和基准,以激发未来对这一关键但具有挑战性和正在探索的任务的研究。然而,收集专家整理的数据分析注释可能会非常昂贵。我们建议利用法学硕士的代码生成功能和多轮提示技术自动生成高质量的答案注释。我们构建了 DACO 数据集,其中包含从现实世界场景收集的 1 440 个表格数据数据库、2 个 2k 查询答案对(可作为模型训练的弱监督)以及 3 个集中但高质量的测试集,其中包含人工精细注释,可用作模型训练的弱监督。我们的主要评估基准。我们在 DACO 数据集上训练了 6B 监督微调 SFT 模型,发现 SFT 模型学习了合理的数据分析能力。为了进一步使模型与人类偏好保持一致,我们使用强化学习来鼓励生成人类认为有帮助的分析,并设计一组密集奖励将稀疏的人类偏好奖励传播到中间代码生成步骤。我们的 DACO RL 算法经过人类注释者的评估,在 57.72 个案例中产生了比 SFT 模型更有用的答案,验证了我们提出的算法的有效性。 |

| Balancing Enhancement, Harmlessness, and General Capabilities: Enhancing Conversational LLMs with Direct RLHF Authors Chen Zheng, Ke Sun, Hang Wu, Chenguang Xi, Xun Zhou 在对话式大语言模型法学硕士的最新进展中,出现了一个令人担忧的趋势,表明许多新的基础法学硕士在监督微调 SFT 后,其基础能力经历了知识减少。这个过程通常会导致诸如遗忘或基础模型能力下降等问题。此外,微调模型很难与用户偏好保持一致,在特别提示时会无意中增加有毒输出的产生。为了克服这些挑战,我们采用了一种创新方法,完全绕过 SFT,直接实施来自人类反馈的无害强化学习 RLHF。我们的方法不仅保留了基本模型的一般功能,而且还显着增强了其对话能力,同时显着减少了有毒输出的产生。我们的方法对于需要细致入微的理解和生成响应的领域具有重大影响,例如客户服务。我们将此方法应用于最流行的基础模型 Mistral,从而创建了 Mistral Plus。我们对 11 个常规任务的验证表明,Mistral Plus 的性能优于类似大小的开源基础模型及其相应的指令版本。 |

| SPUQ: Perturbation-Based Uncertainty Quantification for Large Language Models Authors Xiang Gao, Jiaxin Zhang, Lalla Mouatadid, Kamalika Das 近年来,大型语言模型法学硕士变得越来越普遍,提供了卓越的文本生成能力。然而,一个紧迫的挑战是他们倾向于做出自信的错误预测,这凸显了法学硕士对不确定性量化 UQ 的迫切需求。虽然以前的工作主要集中在解决任意不确定性,但对包括认知在内的所有不确定性的探索仍然不够。受这一差距的启发,我们引入了一种新颖的 UQ 方法,对 UQ SPUQ 进行扰动采样,旨在解决任意和认知不确定性。该方法需要为 LLM 输入生成一组扰动,对每个扰动的输出进行采样,并结合一个聚合模块来概括文本生成任务的采样不确定性方法。通过对各种数据集进行广泛的实验,我们研究了不同的扰动和聚合技术。我们的研究结果表明模型不确定性校准有了显着改善,预期校准误差 ECE 平均减少了 50。 |

| A Tutorial on the Pretrain-Finetune Paradigm for Natural Language Processing Authors Yu Wang 预训练微调范例代表了自然语言处理 NLP 中的变革性方法。该范例通过使用大型预训练语言模型而脱颖而出,即使在训练数据有限的情况下,也能在微调任务方面表现出显着的效率。这种效率对于社会科学研究尤其有益,因为社会科学研究中带注释的样本数量通常非常有限。我们的教程全面介绍了预训练微调范例。我们首先深入研究预训练和微调的基本概念,然后使用现实世界的应用程序进行实际练习。我们演示了该范式在各种任务中的应用,包括多类分类和回归。本教程强调其功效和用户友好性,旨在鼓励更广泛地采用这种范例。为此,我们提供了对所有代码和数据集的开放访问。 |

| Trial and Error: Exploration-Based Trajectory Optimization for LLM Agents Authors Yifan Song, Da Yin, Xiang Yue, Jie Huang, Sujian Li, Bill Yuchen Lin 大型语言模型法学硕士已成为各种自主代理系统中不可或缺的组成部分。在本研究中,我们提出了一种基于探索的轨迹优化方法,称为 ETO。这种学习方法旨在提高开放式LLM代理的性能。与之前专门训练成功的专家轨迹的研究相反,我们的方法允许智能体从探索失败中学习。这可以通过迭代优化框架提高性能。在探索阶段,智能体在完成给定任务的同时与环境进行交互,收集故障轨迹以创建对比轨迹对。在随后的训练阶段,代理利用这些轨迹偏好对,使用 DPO 等对比学习方法来更新其策略。这种探索和训练的迭代循环促进了智能体的持续改进。我们对三个复杂任务的实验表明,ETO 始终大幅超越基线性能。 |

| Choose Your Own Adventure: Interactive E-Books to Improve Word Knowledge and Comprehension Skills Authors Stephanie Day, Jin K. Hwang, Tracy Arner, Danielle McNamara, Carol Connor 这项可行性研究的目的是研究阅读数字互动电子书对支持五年级学生阅读理解的基本技能的潜在影响。学生阅读两本教授单词学习和理解监控策略的电子书,以帮助学习有关飓风的困难词汇和有针对性的科学概念。我们调查了特定的理解策略(包括单词学习和支持一般阅读理解、总结和问题生成的策略)是否能够有效地构建电子书中的词汇知识和理解技能。学生被分配阅读每本电子书的三个版本之一,每个版本实施一个策略。这些书采用了“选择你的冒险”格式,并嵌入了理解问题,为学生的回答提供了即时反馈。进行配对样本 t 检验,以检查学习两本电子书中教授的目标词汇和科学概念前后的差异。对于这两本电子书,学生们在单词学习和目标飓风概念方面都取得了显着的进步。此外,分层线性建模 HLM 表明,没有一种策略比另一种策略与更大收益的关联性更大。书中嵌入问题的表现也与两本电子书更好的后测结果相关。 |

| The Emotion Dynamics of Literary Novels Authors Krishnapriya Vishnubhotla, Adam Hammond, Graeme Hirst, Saif M. Mohammad 故事在叙述中表现出丰富的情感,并在读者中唤起情感。故事中各个角色的情感历程是其吸引力的核心。然而,对小说情感的计算分析很少检查小说中不同角色情感轨迹的变化,而是将整部小说视为代表单个故事线。在这部作品中,我们通过人物对话来区分叙述的情感弧和各个人物。我们使用话语情感动力学框架分析英语文学小说数据集中各个人物的情感弧。 |

| OffLanDat: A Community Based Implicit Offensive Language Dataset Generated by Large Language Model Through Prompt Engineering Authors Amit Das, Mostafa Rahgouy, Dongji Feng, Zheng Zhang, Tathagata Bhattacharya, Nilanjana Raychawdhary, Mary Sandage, Lauramarie Pope, Gerry Dozier, Cheryl Seals 社交媒体上广泛存在的攻击性语言对社会福祉造成了不利影响。因此,高度优先解决这个问题变得非常重要。攻击性语言有显式和隐式两种形式,后者更难以检测。目前该领域的研究遇到了一些挑战。首先,现有数据集主要依赖于包含显式攻击性关键字的文本集合,这使得捕获缺乏这些关键字的隐式攻击性内容变得具有挑战性。其次,通常的方法往往只关注文本分析,而忽略了社区信息可以提供的有价值的见解。在这篇研究论文中,我们介绍了一个新颖的数据集 OffLanDat,这是一个由 ChatGPT 生成的基于社区的隐式攻击性语言数据集,其中包含 38 个不同目标群体的数据。尽管由于道德限制,使用 ChatGPT 生成攻击性文本存在局限性,但我们提出了一种基于提示的方法,可以有效生成隐式攻击性语言。为了确保数据质量,我们由人工评估我们的数据。此外,我们采用基于提示的零射击方法和 ChatGPT,并比较人工注释和 ChatGPT 注释之间的检测结果。我们利用现有的最先进模型来看看它们在检测此类语言方面有多有效。 |

| Views Are My Own, But Also Yours: Benchmarking Theory of Mind using Common Ground Authors Adil Soubki, John Murzaku, Arash Yousefi Jordehi, Peter Zeng, Magdalena Markowska, Seyed Abolghasem Mirroshandel, Owen Rambow 评估语言模型 LM 的思维理论 ToM 能力最近受到了广泛关注。然而,许多现有的基准依赖于合成数据,这可能导致实验结果与人类行为不一致。我们引入了第一个基于自然发生的口语对话的 ToM 数据集 Common ToM,并表明 LM 很难演示 ToM。 |

| How does Architecture Influence the Base Capabilities of Pre-trained Language Models? A Case Study Based on FFN-Wider Transformer Models Authors Xin Lu, Yanyan Zhao, Bing Qin 预训练语言模型已被证明具有强大的基础能力,不仅在分布式语言建模方面表现出色,而且在分布式语言建模、迁移学习和少样本学习方面也表现出强大的能力。与关注规模对基础能力影响的现有工作不同,我们的工作研究了架构对基础能力的影响。具体来说,我们关注的是架构如何影响预训练语言模型的基础能力。在这项工作中,我们试图解释并扭转 FFN Wider Transformers 的架构导致的基础能力下降,寻求提供一些见解。通过分析,我们发现多头注意力组合函数对预训练语言模型的贡献率是影响基础能力的关键因素。 FFN Wider Transformers降低了这种组合功能的贡献比例,导致基础能力下降。我们通过实验证实了这一点,并提出了组合增强架构 CEA 来解决此类模型基础能力下降的问题。 |

| adaptMLLM: Fine-Tuning Multilingual Language Models on Low-Resource Languages with Integrated LLM Playgrounds Authors S amus Lankford, Haithem Afli, Andy Way 多语言语言模型 MLLM 和大型语言模型的出现催生了自然语言处理许多领域的创新。尽管这项技术具有令人兴奋的潜力,但其对为资源匮乏的语言开发高质量机器翻译 MT 输出的影响仍然相对未被探索。此外,专门用于微调 MLLM 和管理低资源语言的完整 MT 工作流程的开源应用程序仍然不可用。我们的目标是通过开发适应MLLM来解决这些不平衡问题,它简化了机器翻译MLLM微调所涉及的所有流程。这个开源应用程序是为从事 MT 的开发人员、翻译人员和用户量身定制的。直观的界面可以轻松自定义超参数,并且该应用程序提供了一系列用于模型评估的指标以及直接在应用程序中将模型部署为翻译服务的功能。作为多语言工具,我们使用 adaptMLLM 来微调两个低资源语言对的模型:英语到爱尔兰语 EN leftrightarrow GA 和英语到马拉地语 EN leftrightarrow MR。与 LoResMT2021 共享任务的基线相比,adaptMLLM 系统表现出显着的改进。在EN右箭头GA方向上,观察到5.2个BLEU点的改进,并且在GA右箭头EN方向上记录了40.5个BLEU点的增加。 EN leftrightarrow MR 对的翻译性能也显着改善,尤其是在 MR rightarrow EN 方向,增加了 21.3 BLEU 点。最后,使用多维质量指标和标量质量指标误差分类法对 EN 右箭头 GA 对上的 MLLM 输出进行细粒度的人工评估。 |

| adaptNMT: an open-source, language-agnostic development environment for Neural Machine Translation Authors S amus Lankford, Haithem Afli, Andy Way AdaptNMT 简化了 RNN 和 Transformer 神经翻译模型的开发和部署所涉及的所有流程。作为一个开源应用程序,它是为机器翻译领域的技术和非技术用户而设计的。该应用程序建立在广泛采用的 OpenNMT 生态系统的基础上,对于该领域的新进入者特别有用,因为开发环境的设置以及训练、验证和测试分割的创建都得到了极大的简化。应用程序中嵌入的图形说明了模型训练的进度,SentencePiece 用于创建子词分割模型。通过直观的用户界面促进了超参数定制,并且已经实现了单击模型开发方法。由 AdaptNMT 开发的模型可以使用一系列指标进行评估,并在应用程序中部署为翻译服务。为了支持 NLP 领域的环保研究,绿色报告还标记了模型开发过程中产生的功耗和 kgCO 2 排放量。 |

| Human Evaluation of English--Irish Transformer-Based NMT Authors S amus Lankford, Haithem Afli, Andy Way 在这项研究中,针对资源匮乏的英语和爱尔兰语对,对超参数设置如何影响基于 Transformer 的神经机器翻译 NMT 的质量进行了人工评估。使用字节对编码 BPE 和一元组方法的 SentencePiece 模型进行了评估。模型架构的变化包括修改层数、评估注意力的最佳头部数量以及测试各种正则化技术。具有 16k BPE 子字模型的 Transformer 优化模型记录了最大的性能改进。与基线循环神经网络 RNN 模型相比,Transformer 优化模型的 BLEU 分数提高了 7.8 分。当与谷歌翻译进行基准测试时,我们的翻译引擎表现出了显着的改进。此外,还进行了定量细粒度手动评估,比较了机器翻译系统的性能。使用多维质量度量 MQM 错误分类法,探索了对基于 RNN 的系统和基于 Transformer 的系统生成的错误类型的人工评估。 |

| The WMDP Benchmark: Measuring and Reducing Malicious Use With Unlearning Authors Nathaniel Li, Alexander Pan, Anjali Gopal, Summer Yue, Daniel Berrios, Alice Gatti, Justin D. Li, Ann Kathrin Dombrowski, Shashwat Goel, Long Phan, Gabriel Mukobi, Nathan Helm Burger, Rassin Lababidi, Lennart Justen, Andrew B. Liu, Michael Chen, Isabelle Barrass, Oliver Zhang, Xiaoyuan Zhu, Rishub Tamirisa, Bhrugu Bharathi, Adam Khoja, Ariel Herbert Voss, Cort B. Breuer, Andy Zou, Mantas Mazeika, Zifan Wang, Palash Oswal, Weiran Liu, Adam A. Hunt, Justin Tienken Harder, Kevin Y. Shih, Kemper Talley, John Guan, Russell Kaplan, Ian Steneker, David Campbell, Brad Jokubaitis, Alex Levinson, Jean Wang, William Qian, Kallol Krishna Karmakar, Steven Basart, Stephen Fitz, Mindy Levine, Ponnurangam Kumaraguru, Uday Tupakula, Vijay Varadharajan, Yan Shoshitaishvili, Jimmy Ba, Kevin M. Esvelt, Alexandr Wang, Dan Hendrycks 白宫人工智能行政命令强调了大型语言模型法学硕士赋予恶意行为者开发生物、网络和化学武器的风险。为了衡量这些恶意使用的风险,政府机构和主要人工智能实验室正在对法学硕士的危险能力进行评估。然而,目前的评估是私人的,阻碍了降低风险的进一步研究。此外,他们只关注少数高度特定的恶意使用途径。为了填补这些空白,我们公开发布了大规模杀伤性武器代理 WMDP 基准,这是一个包含 4,157 个多项选择问题的数据集,可作为生物安全、网络安全和化学安全方面危险知识的代理衡量标准。 WMDP 由学术界和技术顾问组成的联盟开发,并在公开发布之前经过严格过滤以消除敏感信息。 WMDP 有两个作用:首先,作为法学硕士中危险知识的评估;其次,作为消除此类危险知识的忘却方法的基准。为了指导忘却的进展,我们开发了 CUT,这是一种基于控制模型表示的最先进的忘却方法。 CUT 降低了 WMDP 上的模型性能,同时保持了生物学和计算机科学等领域的一般能力,这表明遗忘可能是减少 LLM 恶意使用的具体途径。 |

| SNIFFER: Multimodal Large Language Model for Explainable Out-of-Context Misinformation Detection Authors Peng Qi, Zehong Yan, Wynne Hsu, Mong Li Lee 由于潜在的高风险,错误信息是一个普遍存在的社会问题。断章取义的 OOC 错误信息,即真实图像被虚假文本重新利用,是误导观众的最简单、最有效的方法之一。目前的方法侧重于评估图像文本的一致性,但缺乏对其判断的令人信服的解释,而这对于揭穿错误信息至关重要。虽然多模态大语言模型 MLLM 具有丰富的知识和视觉推理和解释生成的先天能力,但它们在理解和发现微妙的跨模态差异方面仍然缺乏复杂性。在本文中,我们介绍了 SNIFFER,这是一种专门为 OOC 错误信息检测和解释而设计的新型多模态大语言模型。 SNIFFER 在 InstructBLIP 上采用两阶段指令调整。第一阶段细化了模型的通用对象与新闻领域实体的概念一致性,第二阶段利用仅 GPT 4 生成的 OOC 特定指令数据来微调模型的辨别力。通过外部工具和检索的增强,SNIFFER 不仅可以检测文本和图像之间的不一致,还可以利用外部知识进行上下文验证。我们的实验表明,SNIFFER 比原始 MLLM 提高了 40 倍以上,并且在检测精度方面优于最先进的方法。 |

| NaturalSpeech 3: Zero-Shot Speech Synthesis with Factorized Codec and Diffusion Models Authors Zeqian Ju, Yuancheng Wang, Kai Shen, Xu Tan, Detai Xin, Dongchao Yang, Yanqing Liu, Yichong Leng, Kaitao Song, Siliang Tang, Zhizheng Wu, Tao Qin, Xiang Yang Li, Wei Ye, Shikun Zhang, Jiang Bian, Lei He, Jinyu Li, Sheng Zhao 虽然最近的大规模文本到语音 TTS 模型取得了重大进展,但它们在语音质量、相似性和韵律方面仍然存在不足。考虑到语音错综复杂地包含各种属性,例如内容、韵律、音色和声学细节,这对生成提出了重大挑战,一个自然的想法是将语音分解为代表不同属性的各个子空间并单独生成它们。受此启发,我们提出了 NaturalSpeech 3,这是一个 TTS 系统,具有新颖的分解扩散模型,可以以零样本的方式生成自然语音。具体来说, 1 我们设计了一个具有因子向量量化 FVQ 的神经编解码器,将语音波形分解为内容、韵律、音色和声学细节的子空间 2 我们提出了一个因子扩散模型,根据相应的提示在每个子空间中生成属性。通过这种分解设计,NaturalSpeech 3 可以通过分而治之的方式有效且高效地对具有解开子空间的复杂语音进行建模。实验表明,NaturalSpeech 3 在质量、相似性、韵律和清晰度方面优于最先进的 TTS 系统。 |

| Word Importance Explains How Prompts Affect Language Model Outputs Authors Stefan Hackmann, Haniyeh Mahmoudian, Mark Steadman, Michael Schmidt 大型语言模型法学硕士的出现彻底改变了各行业的众多应用程序。然而,它们的黑匣子性质常常阻碍人们理解它们如何做出具体决策,引发人们对其透明度、可靠性和道德使用的担忧。本研究提出了一种通过改变提示中的单个单词来揭示其对模型输出的统计影响来提高法学硕士的可解释性的方法。这种方法受到表格数据排列重要性的启发,屏蔽了系统提示中的每个单词,并根据多个用户输入聚合的可用文本分数评估其对输出的影响。与经典注意力不同,单词重要性衡量提示单词对任意定义的文本分数的影响,这使得能够将单词的重要性分解为具体的兴趣度量,包括偏见、阅读水平、冗长程度等。此过程还可以测量注意力权重时的影响不可用。为了测试这种方法的保真度,我们探索了向多个不同的系统提示添加不同后缀的效果,并将后续世代与不同的大型语言模型进行比较。 |

| PaperWeaver: Enriching Topical Paper Alerts by Contextualizing Recommended Papers with User-collected Papers Authors Yoonjoo Lee, Hyeonsu B. Kang, Matt Latzke, Juho Kim, Jonathan Bragg, Joseph Chee Chang, Pao Siangliulue 随着学术档案的快速增长,研究人员订阅了论文警报系统,该系统定期向他们提供与以前收集的论文相似的最近发表的论文的推荐。然而,研究人员有时很难理解推荐论文与他们自己的研究背景之间的微妙联系,因为现有系统仅显示论文标题和摘要。为了帮助研究人员发现这些联系,我们推出了 PaperWeaver,这是一个丰富的论文警报系统,可根据用户收集的论文提供推荐论文的上下文文本描述。 PaperWeaver 采用基于大型语言模型法学硕士的计算方法,从用户收集的论文中推断用户的研究兴趣,提取论文的上下文特定方面,并在这些方面比较推荐的论文和收集的论文。 |

| Enhancing Conceptual Understanding in Multimodal Contrastive Learning through Hard Negative Samples Authors Philipp J. R sch, Norbert Oswald, Michaela Geierhos, Jind ich Libovick 当前利用对比学习的多模态模型在发展细粒度概念理解方面通常面临局限性。这是由于预训练期间的随机负样本,导致在损失函数中几乎完全比较非常不同的概念。因此,这些模型难以应对细粒度的语义差异。为了解决这个问题,我们引入了一种新颖的预训练方法,结合了合成的困难负文本示例。硬底片排列了与视觉概念相对应的术语,从而导致更细粒度的视觉和文本概念对齐。此外,我们还引入了 InpaintCOCO,这是一个新的具有挑战性的数据集,用于评估视觉语言模型中颜色、对象和大小的细粒度对齐。我们通过更改视觉概念,使用 COCO 图像的生成修复来创建数据集,使图像不再与其原始标题匹配。 |

| Evaluating and Optimizing Educational Content with Large Language Model Judgments Authors Joy He Yueya, Noah D. Goodman, Emma Brunskill 创建有效的教育材料通常需要对学生的学习成果进行昂贵且耗时的研究。为了克服这一障碍,一个想法是建立学生学习的计算模型,并用它们来优化教学材料。然而,很难对学习动态的认知过程进行建模。我们提出了一种替代方法,使用语言模型 LM 作为教育专家来评估各种指令对学习成果的影响。具体来说,我们使用 GPT 3.5 来评估教学材料对不同学生群体的整体效果,发现它可以复制成熟的教育发现,例如专业知识逆转效应和变异效应。这证明了 LM 作为教育内容的可靠评估者的潜力。基于这一见解,我们引入了一种指令优化方法,其中一个 LM 使用另一个 LM 的判断作为奖励函数来生成教学材料。我们应用这种方法来创建数学应用题工作表,旨在最大限度地提高学生的学习收益。人类教师对这些 LM 生成的工作表的评估表明,LM 的判断和人类教师的偏好之间存在显着的一致性。 |

| CURATRON: Complete Robust Preference Data for Robust Alignment of Large Language Models Authors Son The Nguyen, Niranjan Uma Naresh, Theja Tulabandhula 本文解决了通过偏好学习 PL 将大型语言模型 LLM 与人类价值观保持一致的挑战,重点关注偏好数据集中数据不完整和损坏的问题。我们提出了一种新方法,可以稳健且完全地重新校准这些数据集中的值,以增强法学硕士应对这些问题的弹性。特别是,我们设计了一种有保证的多项式时间排序算法,该算法可以增强多个现有模型,例如经典的 Bradley Terry Luce BTL Bradley 和 Terry,1952 模型及其某些概括。据我们所知,我们目前的工作是第一个提出一种算法,该算法可证明以高概率恢复 epsilon 最优排名,同时允许每个模型响应有 O n 扰动的成对比较结果。此外,我们在部分观察的环境中显示了稳健的恢复结果。我们的实验证实,我们的算法在一般数据集和 LLM 偏好数据集设置中都能很好地处理对抗性噪声和未观察到的比较。 |

| Privacy-Aware Semantic Cache for Large Language Models Authors Waris Gill 1 , Mohamed Elidrisi 2 , Pallavi Kalapatapu 2 , Ali Anwar 3 , Muhammad Ali Gulzar 1 1 Virginia Tech, USA, 2 Cisco, USA 3 University of Minnesota, Minneapolis, USA ChatGPT、Google Bard、Claude 和 Llama 2 等大型语言模型法学硕士彻底改变了自然语言处理和搜索引擎动态。然而,这些模型会产生异常高的计算成本。例如,GPT 3 由 1750 亿个参数组成,对这些模型的推理也需要数十亿次浮点运算。缓存是减少重复查询的 LLM 推理成本的自然解决方案。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com