使用langchain搭建自己的本地知识库系统(新)

前些时候字节上了自己的扣子,用来构建我们自己的 agent [AI 实战:手把手教你使用「扣子/coze」来搭建个人blog知识库 受到启发,想在本地或者自己的服务器上面搭建一个知识库,所以就有了本文。

什么是 RAG

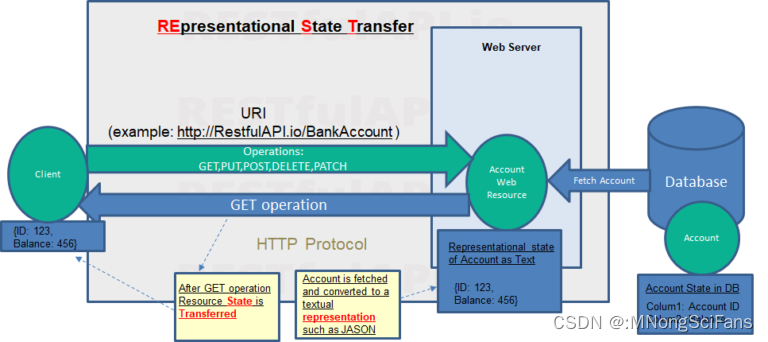

RAG 是retrieval-augmented-generation的缩写,翻译为中文的意思就检索增强,以基于最新,最准确的数据建立LLM 的语料知识库。

LLM 现存的痛点

我们知道 LLM 的知识库是通过现有的网络公开的数据作为数据源来训练的,现在公开的很多模型他们基于的训练数据会比我们现在网络上公开的数据早很多,那自然就会产生一种问题,网络上最新的数据和知识 LLM 是不知道。还有一种情况就是很多企业他们对自己的数据的安全做的很好,也就是私有化数据(这些数据是有价值的,也是企业的立足之本)。这些数据网络上肯定是不存在,那自然 LLM 也是不知道的。

我们在提问LLM 对于一些不知道的知识时候,LLM 很多时候是不知道如何回答问题的。甚至会对我们的问题进行胡诌随机回答,也就是瞎说。

如何解决

那如何让 LLM 知道这些最新/私有的数据的知识呢❓

那就是 RAG。通过将模型建立在外部知识来源的基础上来补充回答。从而提高 LLM 生成回答的质量。

在基于 LLM实现的问答系统中使用 RAG 有三方面的好处:

- 确保

LLM可以回答最新,最准确的内容。并且用户可以访问模型内容的来源,确保可以检查其声明的准确性并最终可信。 - 通过将

LLM建立在一组外部的、可验证的事实数据之上,该模型将信息提取到其参数中的机会更少。这减少了LLM泄露敏感数据或“幻觉”不正确或误导性信息的机会。 RAG还减少了用户根据新数据不断训练模型并随着数据的变化更新训练参数的需要。通过这种方式企业可以减低相关财务成本。

现在支撑所有基础模型的是一种称为 transformer 的 AI 架构。它将大量原始数据转换为其基本结构的压缩表示形式。从这种原始表示开始,基础模型可以适应各种任务,并对标记的、特定于领域的知识进行一些额外的微调。

但是,仅靠微调很少能为模型提供在不断变化的环境中回答高度具体问题所需的全部知识,并且微调的时间周期还比较长。所以当时的 Facebook提出了 RAG,让 LLM 能够访问训练数据之外的信息。RAG 允许 LLM 建立在专门的知识体系之上,以更准确的方式回答问题。

简单介绍

LangChain 是一个用于开发由语言模型驱动的应用程序的框架。它使应用程序能够:

- 具有上下文感知 能力:将语言模型与上下文源(提示说明、少量镜头示例、基于其响应的内容等)联系起来。

- 原因:依靠语言模型进行推理(关于如何根据提供的上下文回答,采取什么行动等)

更多的介绍可以去官网:Introduction | 🦜️🔗 Langchain

安装 langchain 相关依赖包

- pip install langchain

- pip install langchain-community

- pip install langchain-core

- pip install langchain-experimental

- pip install langchain-experimental

- pip install “langserve[all]”

- pip install langchain-cli

- pip install langsmith

实现知识库

OpenAI 相关配置

如果你是不使用的 OpenAI 那么,你需要参考官网的关于 model I/O的部分去实例化你对应的 LLM model

本文中的LLM 使用的是 AZURE_OPENAI 的服务。

py

复制代码

import os

os.environ["AZURE_OPENAI_ENDPOINT"] = ""

os.environ["AZURE_OPENAI_API_KEY"] = ""

embedding model 账户配置

根据自己的实际 LLM情况去配置相关的参数

py

复制代码

import os

os.environ["AZURE_OPENAI_ENDPOINT"] = ""

os.environ["AZURE_OPENAI_API_KEY"] = ""

os.environ["OPENAI_API_VERSION"] = "2023-05-15"

os.environ["OPENAI_API_TYPE"] = "azure"

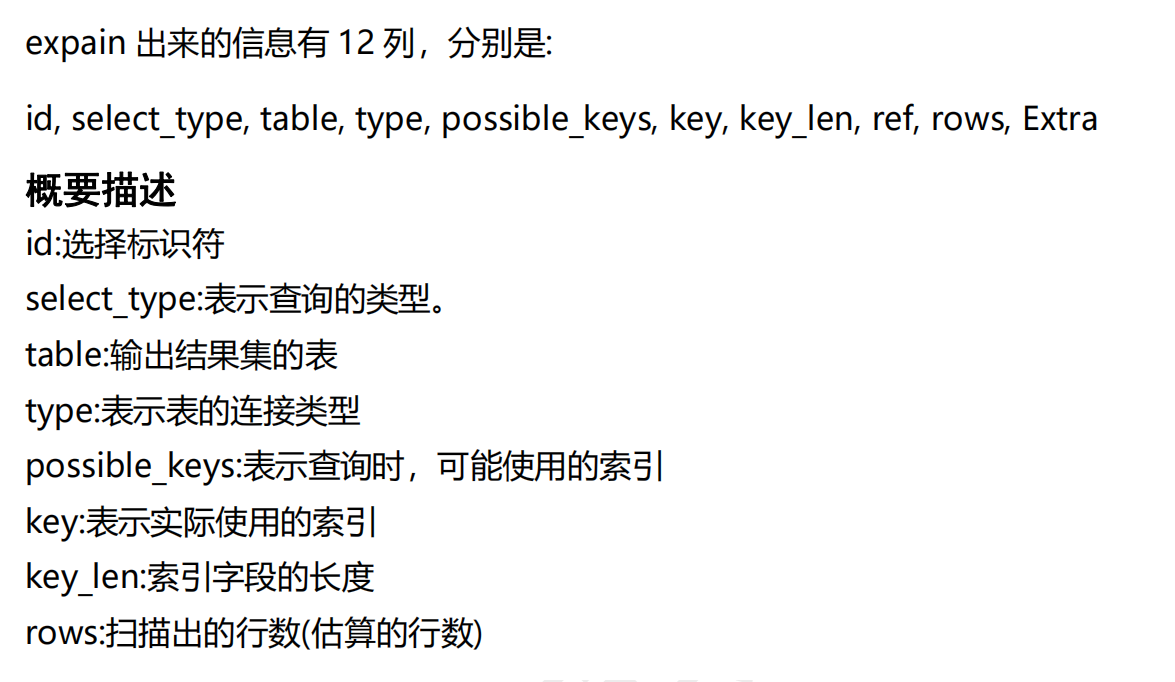

RAG 增强检索的流程图

代码执行流程

- 加载 langchain 相关包

- 加载 url 网页的文档并生成

langchain Documentraw_documents - 将

raw_documents拆分为适合embedding model能够处理大小的chunk小文档。 - 使用

embedding modelAPI 将小的chunk向量化,并保存向量数据库 - 构建

`RAGprompt提示,并使用变量{context}``{question}`, 并限定回答问题所使用的文本 - 使用

LCEL表达式构建RAGchain - 在 app/server.py 中添加

add_routes(app, rag_chroma_chain, path="/dify")代码 - 执行代码

langchain serve启动服务

代码实现

导入 langchain 的 百度千帆 embedding model

python

复制代码

from langchain_community.embeddings import QianfanEmbeddingsEndpoint

我这里使用的百度千帆的

embedding model具体你要使用什那个产品的embedding model在对应的地方修改为自己的即可。

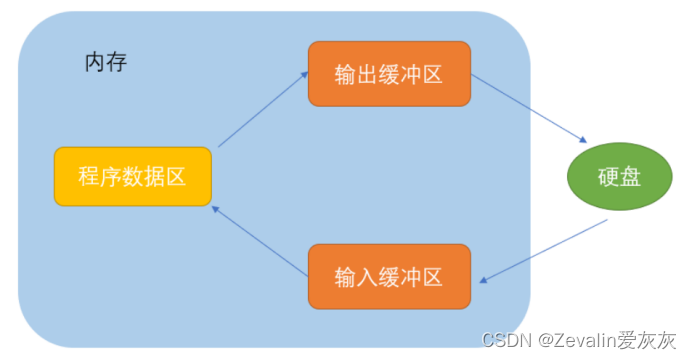

embedding model 的作用有两点

- 将我们拆分后的

documents做向量化,然后并保存到对应的向量数据库中。 - 用户在查找相关问题的时候,先从向量数据库中查找出相似的文档

也就是提供了存储和查询的功能。

定义 embedding model的初始化

py

复制代码

import os

def embedQianfan():

os.environ["QIANFAN_AK"] = "" # 这里需要修改为自己的实际值

os.environ["QIANFAN_SK"] = "" # 这里需要修改为自己的实际值

embed = QianfanEmbeddingsEndpoint()

return embed

定义 OpenAI 实现

根据自己的账户情况去配置相关参数

javascript

复制代码

def openai`LLM `() -> AzureChatOpenAI:

# 设置环境变量

os.environ["AZURE_OPENAI_ENDPOINT"] = ""

os.environ["AZURE_OPENAI_API_KEY"] = ""

# os.environ["OPENAI_API_VERSION"] = "2023-05-15"

# os.environ["OPENAI_API_TYPE"] = "gpt-35-turbo"

from langchain_openai import AzureChatOpenAI

`LLM ` = AzureChatOpenAI(

azure_deployment="gpt-4",

openai_api_version="2023-05-15"

)

return `LLM `

OpenAI

如果你用的是 OpenAI 官方的服务,那么使用就更加的简单了

scss

复制代码

os.environ["OPENAI_API_KEY"] = getpass.getpass()

`LLM ` = ChatOpenAI(model_name="gpt-3.5-turbo", temperature=0)

整体代码实现详解

py

复制代码

# 导入 langchain 相关的依赖包

# 导入向量数据库(向量存储、查询)

from langchain_community.vectorstores import Chroma

# 导入 langchain 输出函数(格式化输出)

from langchain_core.output_parsers import StrOutputParser

# 导入 langchain Prompt 模板, prompt 管理

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.pydantic_v1 import BaseModel

# 导入 langchain 的 LCEL 解释器包

from langchain_core.runnables import RunnableParallel, RunnablePassthrough

# 导入langchain 文本拆分器

from langchain.text_splitter import RecursiveCharacterTextSplitter

# 导入 langchain 的文件加载器 (WebBaseLoader的功能是拉取网页数据,解析为 langchain Document 结构)

from langchain_community.document_loaders import WebBaseLoader

# 加载网页 https://docs.dify.ai/v/zh-hans/getting-started/readme 的数据

raw_documents = WebBaseLoader("https://docs.dify.ai/v/zh-hans/getting-started/readme").load()

# raw_documents = WebBaseLoader("https://docs.dify.ai/v/zh-hans/guides/knowledge-base").load()

# 将网页数据拆分为 chunk 的大小

text_splitter = RecursiveCharacterTextSplitter(chunk_size=500, chunk_overlap=50)

all_splits = text_splitter.split_documents(raw_documents)

# 将文本编码为向量,并保存为向量

vectorstore = Chroma.from_documents(

documents=all_splits,

collection_name="`RAG`-chroma",

embedding=embedQianfan(),

)

retriever = vectorstore.as_retriever()

# 构建 `RAG` prompt

template = """Answer the question with chinese and based only on the following context:

{context}

Question: {question}

"""

prompt = ChatPromptTemplate.from_template(template)

# 初始化`LLM `

# model = ChatOpenAI()

model = openai`LLM `()

# 使用 LCEL 表达式构建 `RAG` chain

chain = (

RunnableParallel({"context": retriever, "question": RunnablePassthrough()})

| prompt

| model

| StrOutputParser()

)

# Add typing for input

class Question(BaseModel):

__root__: str

chain = chain.with_types(input_type=Question)

#

print(chain.invoke("dify 是什么"))

print(chain.invoke("dify 能干什么?请用列表形式回答"))

print(chain.invoke("dify 可以导入哪些数据?"))

print(china.invoke("dify如何导入 nation 数据?"))

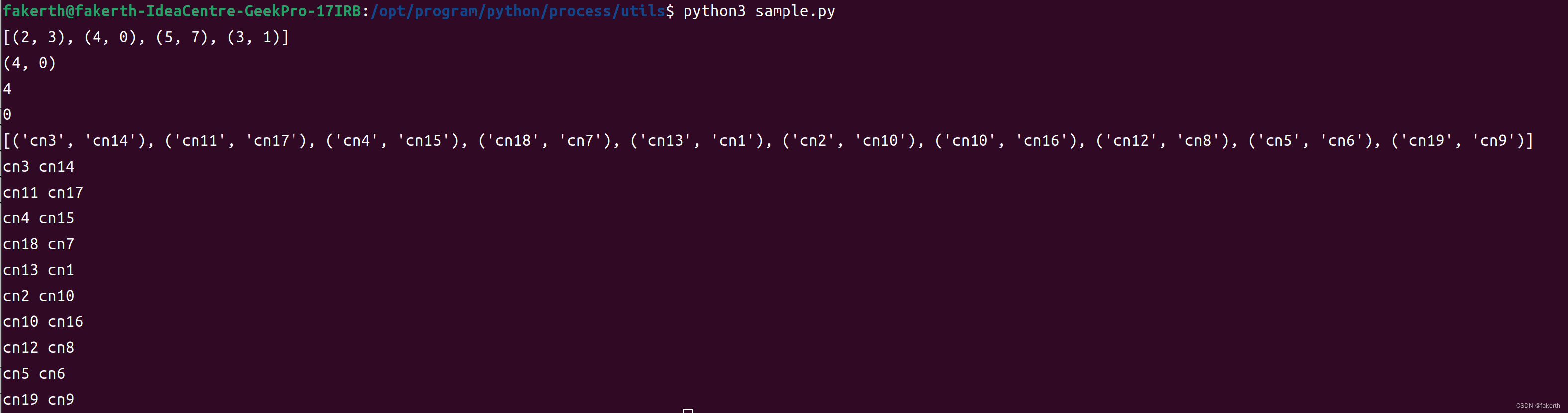

启动项目

如果你使用的是 langchain serve 构建的,那么你可以按下面的启动命令启动服务。服务你只是一个单文件,那么执行 python 你的文件你的文件

复制代码

langchain serve

less

复制代码

langchain serve

<INFO: Will watch for changes in these directories: ['/Users/oo7/Developer/langchain/chat`LLM `']

INFO: Uvicorn running on http://127.0.0.1:8000 (Press CTRL+C to quit)

INFO: Started reloader process [87768] using WatchFiles

[INFO] [02-28 16:30:15] openapi_requestor.py:316 [t:140704718436288]: requesting `LLM ` api endpoint: /embeddings/embedding-v1

[INFO] [02-28 16:30:15] oauth.py:207 [t:140704718436288]: trying to refresh access_token for ak `r5KIlr***`

[INFO] [02-28 16:30:15] oauth.py:220 [t:140704718436288]: sucessfully refresh access_token

INFO: Started server process [87777]

INFO: Waiting for application startup.

__ ___ .__ __. _______ _______. _______ .______ ____ ____ _______

| | / \ | \ | | / _____| / || ____|| _ \ \ \ / / | ____|

| | / ^ \ | | | | | __ | (----`| |__ | |_) | \ / / | |__

| | / /_\ \ | . ` | | | |_ | \ \ | __| | / \ / | __|

| `----./ _____ \ | |\ | | |__| | .----) | | |____ | |\ ----. \ / | |____

|_______/__/ __\ |__| __| ______| |_______/ |_______|| _| `._____| __/ |_______|

LANGSERVE: Playground for chain "/pirate-speak/" is live at:

LANGSERVE: │

LANGSERVE: └──> /pirate-speak/playground/

LANGSERVE:

LANGSERVE: Playground for chain "/dify/" is live at:

LANGSERVE: │

LANGSERVE: └──> /dify/playground/

LANGSERVE:

LANGSERVE: See all available routes at /docs/

启动成功后访问地址: http://127.0.0.1:8000/dify/playground/

提问示例

- dify 是什么?

- dify 能干什么?请用列表形式回答

切换文档后继续提问,观察输出

- dify 可以导入哪些数据?

注意点:

1、文件拆分

ini

复制代码

text_splitter = RecursiveCharacterTextSplitter(chunk_size=500, chunk_overlap=50)

文本拆分一定需要注意 embedding model 窗口所能处理的 token 数量。 如果超出则会出问题。

总结:

本文主要是介绍了如何使用 langchain 构建一个自己的知识库系统

- 介绍了知识库构建的

RAG相关的知识 - LLM 不能做什么,如何将最新的数据于 llm 相结合来提示 llm 的能力

langchain的基本介绍,他是一个用于开发由语言模型驱动的应用程序的框架- 向量数据库的作用:存储向量化后的文本然后提供查找语义相关的内容

- 构建知识库的步骤和相关代码的介绍

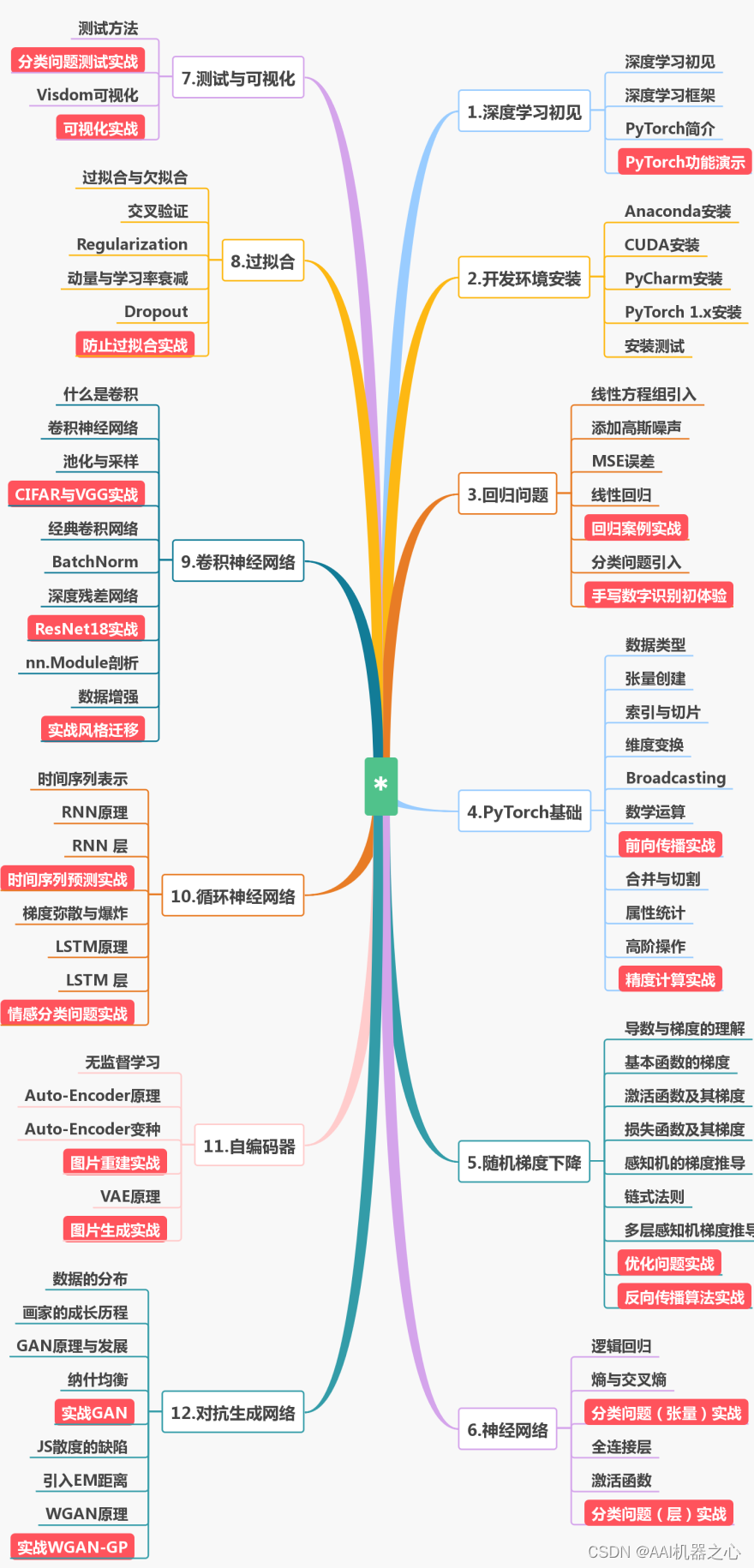

最后

为了帮助大家更好的学习人工智能,这里给大家准备了一份人工智能入门/进阶学习资料,里面的内容都是适合学习的笔记和资料,不懂编程也能听懂、看懂,所有资料朋友们如果有需要全套人工智能入门+进阶学习资源包,可以在评论区或扫.码领取哦)~

在线教程

- 麻省理工学院人工智能视频教程 – 麻省理工人工智能课程

- 人工智能入门 – 人工智能基础学习。Peter Norvig举办的课程

- EdX 人工智能 – 此课程讲授人工智能计算机系统设计的基本概念和技术。

- 人工智能中的计划 – 计划是人工智能系统的基础部分之一。在这个课程中,你将会学习到让机器人执行一系列动作所需要的基本算法。

- 机器人人工智能 – 这个课程将会教授你实现人工智能的基本方法,包括:概率推算,计划和搜索,本地化,跟踪和控制,全部都是围绕有关机器人设计。

- 机器学习 – 有指导和无指导情况下的基本机器学习算法

- 机器学习中的神经网络 – 智能神经网络上的算法和实践经验

- 斯坦福统计学习

😝有需要的小伙伴,可以点击下方链接免费领取或者V扫描下方二维码免费领取🆓

人工智能书籍

- OpenCV(中文版).(布拉德斯基等)

- OpenCV+3计算机视觉++Python语言实现+第二版

- OpenCV3编程入门 毛星云编著

- 数字图像处理_第三版

- 人工智能:一种现代的方法

- 深度学习面试宝典

- 深度学习之PyTorch物体检测实战

- 吴恩达DeepLearning.ai中文版笔记

- 计算机视觉中的多视图几何

- PyTorch-官方推荐教程-英文版

- 《神经网络与深度学习》(邱锡鹏-20191121)

- …

😝有需要的小伙伴,可以点击下方链接免费领取或者V扫描下方二维码免费领取🆓

第一阶段:零基础入门(3-6个月)

新手应首先通过少而精的学习,看到全景图,建立大局观。 通过完成小实验,建立信心,才能避免“从入门到放弃”的尴尬。因此,第一阶段只推荐4本最必要的书(而且这些书到了第二、三阶段也能继续用),入门以后,在后续学习中再“哪里不会补哪里”即可。

第二阶段:基础进阶(3-6个月)

熟读《机器学习算法的数学解析与Python实现》并动手实践后,你已经对机器学习有了基本的了解,不再是小白了。这时可以开始触类旁通,学习热门技术,加强实践水平。在深入学习的同时,也可以探索自己感兴趣的方向,为求职面试打好基础。

第三阶段:工作应用

这一阶段你已经不再需要引导,只需要一些推荐书目。如果你从入门时就确认了未来的工作方向,可以在第二阶段就提前阅读相关入门书籍(对应“商业落地五大方向”中的前两本),然后再“哪里不会补哪里”。

😝有需要的小伙伴,可以点击下方链接免费领取或者V扫描下方二维码免费领取🆓