这是我的第232篇原创文章。

一、引言

长短期记忆网络(LSTM)结合注意力机制是一种常用的深度学习模型结构,用于处理序列数据。LSTM是一种循环神经网络(RNN)的变体,专门设计用来解决长序列数据的梯度消失和梯度爆炸问题。而注意力机制则可以帮助模型在处理序列数据时更加关注重要的部分,提高模型的性能和泛化能力。

在将LSTM与注意力机制结合时,通常的做法是在LSTM的输出上引入注意力权重,以便模型可以根据不同时间步的重要性来聚焦不同部分的输入序列。这有助于模型更有效地学习序列数据的长期依赖关系。

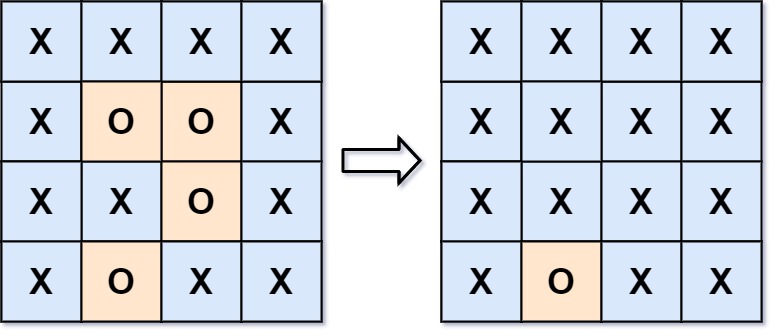

具体来说,结合LSTM和注意力机制的模型结构如下:

-

LSTM层:用于处理序列数据,捕捉序列中的长期依赖关系。

-

注意力机制:在LSTM输出的基础上计算注意力权重,以确定每个时间步的重要性。

-

加权求和:根据注意力权重对LSTM输出进行加权求和,得到加权后的表示。

-

输出层:将加权后的表示送入输出层进行最终的预测或分类。

通过引入注意力机制,模型可以动态地学习不同时间步的重要性,从而提高模型的表现。这种结合可以在处理各种序列数据任务(如自然语言处理、时间序列预测等)时发挥重要作用。

二、实现过程

2.1 读取数据集

# 读取数据集

data = pd.read_csv('data.csv')

# 将日期列转换为日期时间类型

data['Month'] = pd.to_datetime(data['Month'])

# 将日期列设置为索引

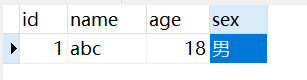

data.set_index('Month', inplace=True)data:

2.2 划分数据集

# 拆分数据集为训练集和测试集

train_size = int(len(data) * 0.8)

train_data = data[:train_size]

test_data = data[train_size:]

# 绘制训练集和测试集的折线图

plt.figure(figsize=(10, 6))

plt.plot(train_data, label='Training Data')

plt.plot(test_data, label='Testing Data')

plt.xlabel('Year')

plt.ylabel('Passenger Count')

plt.title('International Airline Passengers - Training and Testing Data')

plt.legend()

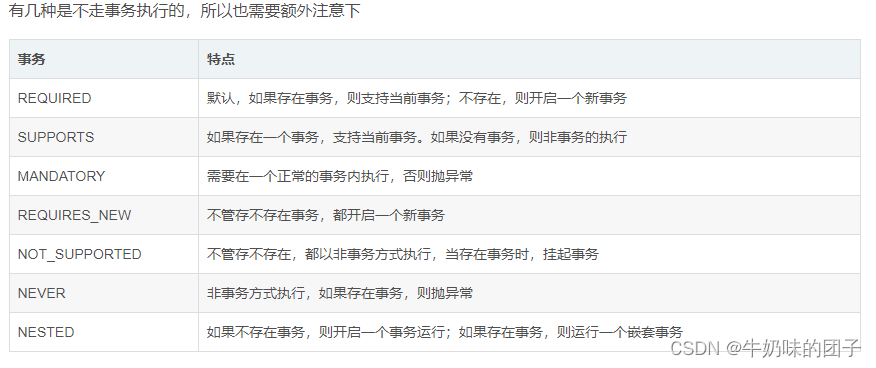

plt.show()共144条数据,8:2划分:训练集115,测试集29。

训练集和测试集:

2.3 归一化

# 将数据归一化到 0~1 范围

scaler = MinMaxScaler()

train_data_scaler = scaler.fit_transform(train_data.values.reshape(-1, 1))

test_data_scaler = scaler.transform(test_data.values.reshape(-1, 1))2.4 构造数据集

# 定义滑动窗口函数

def create_dataset(data, look_back=1):

pass

np.random.seed(7)

# 定义滑动窗口大小

look_back = 2

# 创建滑动窗口数据集

X_train, Y_train = create_dataset(train_data_scaler, look_back)

X_test, Y_test = create_dataset(test_data_scaler, look_back)

# 将数据集转换为 LSTM 模型所需的形状(样本数,时间步长,特征数)

X_train = np.reshape(X_train, (X_train.shape[0], X_train.shape[1],1))

X_test = np.reshape(X_test, (X_test.shape[0], X_test.shape[1], 1))2.5 建立模拟合模型进行预测

# 构建 LSTM 模型

model = Sequential()

model.add(LSTM(4, input_shape=(look_back,1))) # 与上面的重构格式对应,要改都改,才能跑通代码

Attention(name='attention_weight')

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

model.fit(X_train, Y_train, epochs=100, batch_size=1, verbose=2)

# 使用 LSTM 模型进行预测

train_predictions = model.predict(X_train)

test_predictions = model.predict(X_test)

# 反归一化预测结果

train_predictions = scaler.inverse_transform(train_predictions)

test_predictions = scaler.inverse_transform(test_predictions)test_predictions:

2.6 预测效果展示

# 绘制测试集预测结果的折线图

plt.figure(figsize=(10, 6))

plt.plot(test_data, label='Actual')

plt.plot(list(test_data.index)[-len(test_predictions):], test_predictions, label='Predicted')

plt.xlabel('Month')

plt.ylabel('Passengers')

plt.title('Actual vs Predicted')

plt.legend()

plt.show()测试集真实值与预测值:

# 绘制原始数据、训练集预测结果和测试集预测结果的折线图

plt.figure(figsize=(10, 6))

plt.plot(data, label='Actual')

plt.plot(list(train_data.index)[look_back:train_size], train_predictions, label='Training Predictions')

plt.plot(list(test_data.index)[-(len(test_data)-look_back):], test_predictions, label='Testing Predictions')

plt.xlabel('Year')

plt.ylabel('Passenger Count')

plt.title('International Airline Passengers - Actual vs Predicted')

plt.legend()

plt.show()原始数据、训练集预测结果和测试集预测结果:

作者简介:

读研期间发表6篇SCI数据挖掘相关论文,现在某研究院从事数据算法相关科研工作,结合自身科研实践经历不定期分享关于Python、机器学习、深度学习、人工智能系列基础知识与应用案例。致力于只做原创,以最简单的方式理解和学习,关注我一起交流成长。需要数据集和源码的小伙伴可以关注底部公众号添加作者微信。